沫沫金 - ADT初始环境搭建问题清单

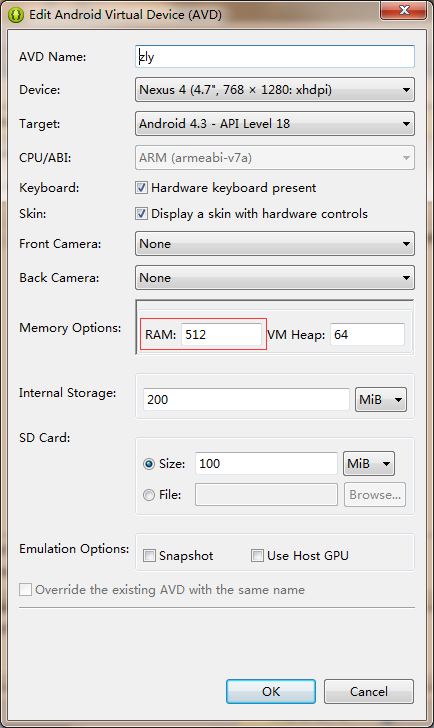

Eclipse ADT版jdk指定 1 2 3 4 5 //1、打开eclipse.ini //2、复制下面代码 -vm ./jdk6. 32 /jre/bin/client/jvm.dll //3、放到-vmargs之前(必须!) Android虚拟机创建经典问题 1、Failed to allocate memory: 1455 这个调整RAM值就可以(不要和发烧友一样整好几个G) 2、启动Android虚拟机失败:start Android panic could not... 需要配置ANDROID_SDK_HOME并加入Path中指定到sdk的绝对目录的tools目录 以上,谢谢。 跑起来了,最终效果收尾 本文转自 沫沫金 51CTO博客,原文链接:http://blog.51cto.com/zl0828/1732568,如需转载请自行联系原作者