【阿里云新品发布·周刊】第12期:DataV数据可视化·专业版全新上线,轻松搭建专业水准的可视化应用!

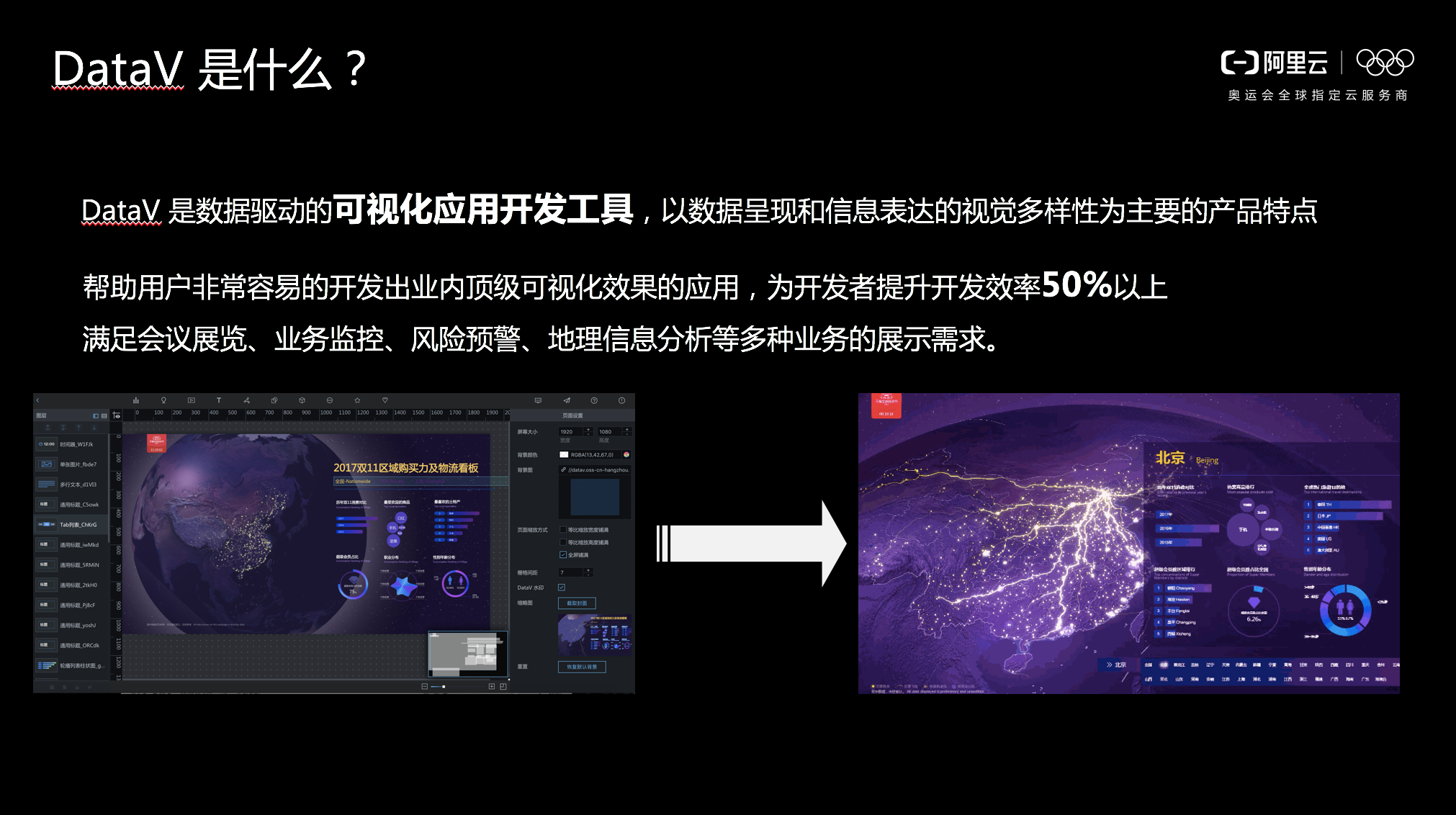

点击订阅新品发布会! 新产品、新版本、新技术、新功能、价格调整,评论在下方,下期更新!关注更多内容,了解更多 最新发布 DataV专业版 重磅发布会 2019年6月5日15时,阿里云DataV专业版全新上线,搭载节点式编程功能,可实现更灵活的数据与页面交互配置。此外,该版本还加入了子账号独立工作空间管理、高级数据交互组件包、组件自定义开发等功能,适合高灵活性、高定制化场景的数据可视化应用制作。 查看产品产品文档 阿里云容器服务ACK 升级亮相 2019年5月30日,阿里云容器服务ACK升级发布,全力保护全球百万级容器的运行安全,国内唯一进入Gartner竞争格局的公有云容器平台。依托超高性能的企业级容器运行平台,实现面向应用的异构资源统一管理。值得一提,其Terway网络插件相比社区方案性能优化20%。 查看产品产品文档 产品动态 新产品