树莓派上的 K8S 集群挂了,怎么办?

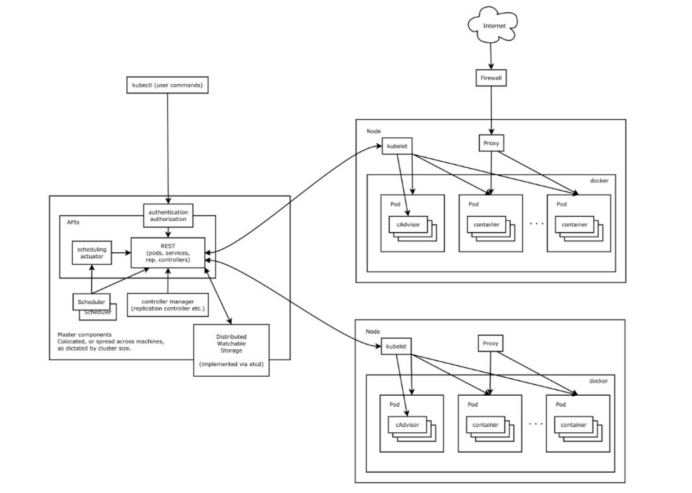

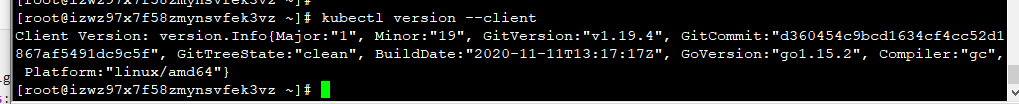

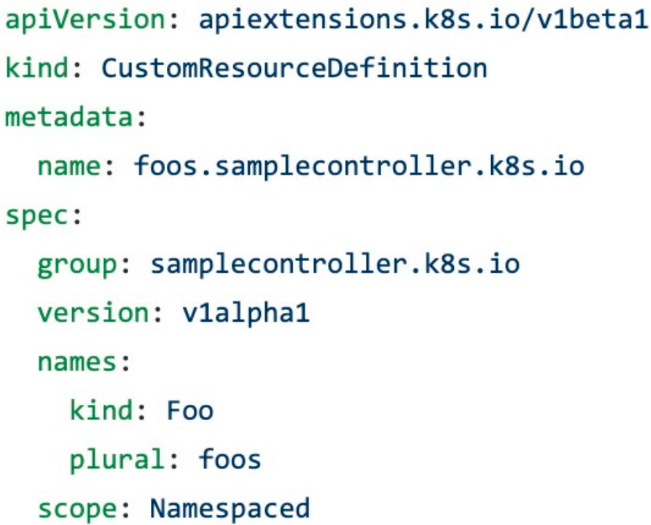

作者 |Lukasz Raczylo 编译|云原生计算编辑部 昨晚在我的树莓派上进行更新的时候,所有节点突然停止检测网络接口,并且无法恢复!!! 那时我有两个选择,但都很费时: 方法1:提早起床,并按照我自己之前的文章手动重建,也许还会发现一些改进的余地。我已经亲身试验了很多次:这种方法很容易出错,主要是输入错误或跳过一个或两个步骤,然后在接下来的半个小时试图找出到底发生了什么事,再抹去一切并从头开始一遍又一遍。 方法2:及早醒悟并从头开始编码,这样可以让我的最终解决方案实现执行一次并永久使用,使整个集群的重建和生产尽可能容易地进行复制。当然,这将意味着更多的停机时间。但是,它的好处将是长期的,这使我不必担心集群本身,并最终将其视为一个稳定的解决方案,可以向其迁移整个本地基础架构。 自动化传奇开始 在开始任何工作之前,我都非常专注于基础知识,并提出了在整个过程中遵循的一些原则。这样创建的环境各部分之间的代码之间逻辑上有很多分隔,因此亲爱的读者,您可以更容易地更改代码或注释掉整个文件以禁用此处或此处的少量功能。 原则1:在树莓派上设置 Kubernetes 集群可以分为三个部分:设置存储卡,在系统级别上进行节点配置,最后扩展 Kubernetes 资源。 原则2:在我的旧版 Intel NUC 上运行着一个NFS服务,该服务已连接到 DROBO 存储。很适合将它用作所有节点的永久共享存储。 原则3:树莓派的集群在我的家庭网络中的 VLAN 中运行,因此保护它不是我的优先事项,所有服务以及节点都应易于访问,而无需处理 credentials。 要重现结果(或使其发挥作用),您将需要: Mac:当我有空安装Linux VM时,我可能会在脚本中添加平台监测部分 Ansible:我使用的版本为2.10.6 Terraform:用0.13.4编写,也适用于0.14.8 Make:任意版本应该均可使用 树莓派集群:步骤1 树莓派使用存储卡作为其硬盘驱动器。这可能不是最佳选择,并且绝对不会给您最大的读写操作速度,但对于业余爱好项目而言,应该足够了。 步骤1需要注意什么? 格式化存储卡 将存储卡分为两个分区-1GB +其余存储卡 将Alpine Linux镜像复制到存储卡上 创建系统覆盖 系统覆盖负责设置 Promisc 模式下的 eth0(对于MetalLB来说是必需的),并配置 SSH 免密登陆。 重要提示:检查001-prepare-card.sh的来源,请确保刚才插入的存储卡实际上是/dev/disk5,否则可能会丢失数据。 结果:准备6张存储卡大约需要一分钟。 树莓派集群:步骤2 这一步才是真正有趣的开始。我猜你已经把存储卡插入到你的树莓派,连接了所有的电缆(网络和电源),并允许它们启动?你现在需要获取你的设备的 IP 地址——你可以通过连接屏幕到每一个设备并执行ifconfig eth0或者登录到你的路由器并检查来实现。用合适的值调整pi-hosts.txt。 [masters]pi0ansible_host=192.168.50.132#Pi0 [workers]pi1 ansible_host=192.168.50.135 # Pi1pi3 ansible_host=192.168.50.60 # Pi3pi4 ansible_host=192.168.50.36 # Pi4pi2 ansible_host=192.168.50.85 # Pi2pi5 ansible_host=192.168.50.230 # Pi5 重要提示:今后很少有事情需要pi0主机名。 将以下内容添加到~/.ssh/config,强制将所有pi *主机作为根连接。 Host pi? User root Hostname %h.local 因为我们已经准备好了微机,所以我们需要为 Ansible 运行做好准备。使用001-prepare- anable .sh脚本可以轻松完成此操作,该脚本将将 ssh 到 pi-hosts 文件中指定的每个服务器,为NTP配置 chrony 并安装 Python 解释器。 重要提示:您可能需要检查rpi.yaml文件并根据需要调整vars部分。 成功执行此步骤后,您可以执行ansible-playbook rpi.yaml -f 10来运行Ansible,该运行将按以下顺序进行: 常见操作: 安装必要的软件包 分区并格式化 RPI 存储卡 将“更大”的分区设置为系统磁盘 添加所有 fstab 条目 提交更改 重新启动树莓派以从“permanent”分区启动 KUBEMASTER: 使用 kubeadm 设置主节点 将令牌存储在本地(在static/token_file中) root在树莓派上设置可以访问 kubectl 的用户 将 Kubernetes 配置保存在本地(在static/kubectl.conf中) KUBEWORKER: 将 token 复制到 worker 节点 它使 worker 通过 token 文件加入您的主服务器 将kubectl.conf复制到 workers 的root用户 基本操作: 从 Master 上移除污点,使其参与工作负载 在节点上安装py3-pip,PyYaml和helm 如果您还在阅读(恭喜您),您刚刚完成了基本的Kubernetes集群。我相信,这就像执行几个脚本然后等待它们完成一样简单,而且肯定比手动方法更好。 重要提示:您可以任意多次运行它。一旦完成,你的存储卡就不会重新格式化。 结果:安装6节点的基本 Kubernetes 集群大概需要花费几分钟,具体的时间取决于你的网络链接状态。 树莓派集群:步骤3 成功执行前两个步骤后,您应该已经准备好将树莓派的集群用于第一个部署。只需很少的基本设置步骤即可使其按需运行,但是请猜测一下……它们也被自动设置,并由 Terraform 来负责。 首先让我们看一下配置: # Variables used for barebone kubernetes setupnetwork_subnet = "192.168.50" net_hosts = { adguard = "240" adguard_catchall = "249" traefik = "234" torrent_rpc = "245"} nfs_storage = { general = "/media/nfs" torrent = "/mnt/drobo-storage/docker-volumes/torrent" adguard = "/mnt/drobo-storage/docker-volumes/adguard"} # ENV variable: TRAEFIK_API_KEY sets traefik_api_key# ENV variable: GH_USER, GH_PAT for authentication with private containers 您可以看到我正在192.168.50.0/24网络中运行集群,但是默认情况下,MetalLB 将使用地址200-250作为网络地址池的“end”。当我有了我的家庭 torrent 服务器和来自Adguard 的 DNS 时,我希望它们具有特定的地址,连同 Traefik 平衡器为仪表板提供“东西”。 重要提示: nfs_*_path值应与您在步骤2中更新的设置兼容。 确保您的 Kubernetes 配置文件~/.kube/config更新了static/kubernetes.conf的访问细节,我正在使用home-k8s作为上下文名称。 Terraforming有什么作用? 网络 安装 flannel和host-gw的配置补丁; 安装metalLB并将网络设置为var.network_subnet200–250; Traefik 安装 Traefik 代理,并通过 metalLB 负载平衡器将其公开到您的家庭网络。Traefik 仪表板本身可以通过以下方式访问traefik.local 在树莓派集群上运行的 Traefik 仪表板 Adguard 使用 NFS 安装具有持久卷声明的 Adguard DNS 服务; 通过 traefik 公开仪表板,并通过家庭网络中的专用IP公开服务本身,如下所示:adguard.local 在树莓派集群上运行的 Adguard Home Prometheus 在所有节点上安装和部署 Prometheus 监控堆栈和 grafana。更新 Prometheus DaemonSet,从而消除了进行卷挂载的必要性。它也通过 traefik 将 grafana 曝光为grafana.local。默认的 grafana 用户/密码组合为admin:admin。Grafana 附带一个预装的插件 devopsprodigi - kubegrafi -app,我认为这是用于集群监控的最佳插件。 在树莓派集群上运行的 Grafana 仪表板 Kubernetes Dashboard 安装 KubernetesDashboard并通过 traefik 将其公开k8s.local 在树莓派集群上运行的 Kubernetes 仪表板 1.Torrent 使用 Flood Web 界面安装和部署torrent服务器(rTorrent)。通过公开仪表板torrent.local。它使用大量的挂载来存储数据和配置。有一个将复制设置为1的理由:-rTorrent的lock file有问题,并且由于它使用共享目录,因此如果检测到lock file件,它就不会启动。(在我的私有配置中)rTorrent被设置为监听端口23340。 2.备份 由于树莓派运行在存储卡上,由于经常读写操作,存储卡可能会磨损,所以我决定在NFS中添加etcd的定期备份。它们每天运行一次,在t erraform 应用的配置下——每个备份“重量”约为32兆字节。 为了使操作更简单,我创建了 Makefile,该文件应该可以帮助您进行设置。您可能需要设置以下环境变量。 TRAEFIK_API_KEY // Traefik API keyGH_USER // Github userGH_PAT // Github Personal Access Token 重要提示:Github 证书现在还没有使用,但我计划很快添加身份验证,以便从 GHCR 提取私有镜像。 ADDITIONAL_ARGS=-var 'traefik_api_key=$(TRAEFIK_API_KEY)' -var "github_user=$(GH_USER)" -var "github_pat=$(GH_TOKEN)" apply: cd infrastructure; terraform apply $(ADDITIONAL_ARGS) -auto-approve -var-file ../variables.tfvars plan: cd infrastructure; terraform plan $(ADDITIONAL_ARGS) -var-file ../variables.tfvars destroy: cd infrastructure; terraform destroy $(ADDITIONAL_ARGS) -var-file ../variables.tfvars destroy-target: cd infrastructure; terraform destroy $(ADDITIONAL_ARGS) -var-file ../variables.tfvars -target $(TARGET) refresh: cd infrastructure; terraform refresh $(ADDITIONAL_ARGS) -var-file ../variables.tfvars init: cd infrastructure; rm -fr .terraform; terraform init import: cd infrastructure; terraform import $(ADDITIONAL_ARGS) -var-file ../variables.tfvars $(ARGS) lint:terraformfmt-recursiveinfrastructure/ 总结 所有代码可在 GitHub 上的 lukaszraczylo / rpi-home-cluster-setup 中使用,任何人均可免费使用和修改)。我还发布了具有支持 ARM64 处理器的多体系结构的定制构建的 docker 映像(rTorrent和Flood)。 自动化可以节省时间,节省精力,而且绝对可以完成工作。我经常清除整个集群,并使用前面提到的存储库从头开始构建,以确保它按预期工作。我将保持这篇文章和存储库的最新功能和特性。 原文链接: https://itnext.io/i-broke-my-kubernetes-cluster-running-on-raspberry-pi-355234a24d 重磅!云原生计算交流群成立 扫码添加小助手即可申请加入,一定要备注:名字-公司/学校-地区,根据格式备注,才能通过且邀请进群。 了解更多微服务、云原生技术的相关信息,请关注我们的微信公众号【云原生计算】!