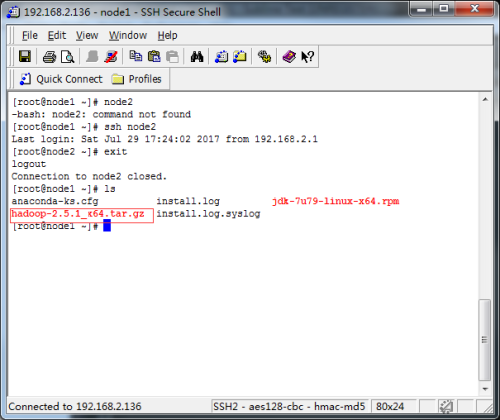

1.下载hadoop-2.5.1,存放根目录

![1下载hadoop.png wKiom1l7-iyz1l5uAAC509UbXYc726.png-wh_50]()

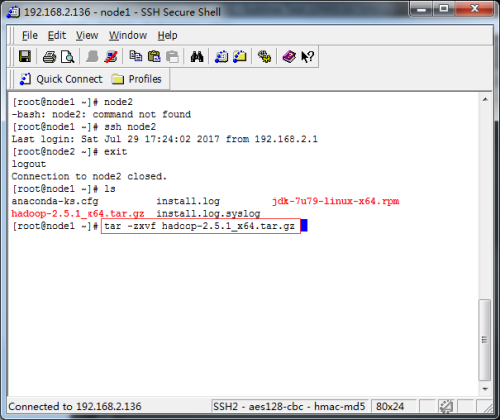

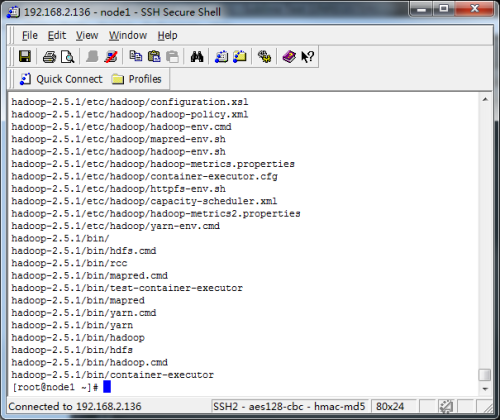

2.通过tar -zxvf 包名 来进行解压

![2解压.png wKioL1l7-mWQdpNjAAC-Smou0mQ258.png-wh_50]()

![3解压完成.png wKioL1l7-r2DQw6EAAD4q7BQWm4258.png-wh_50]()

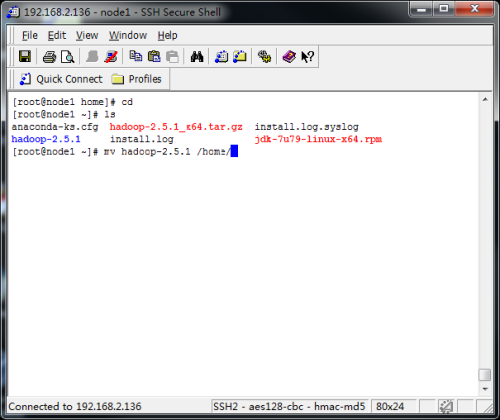

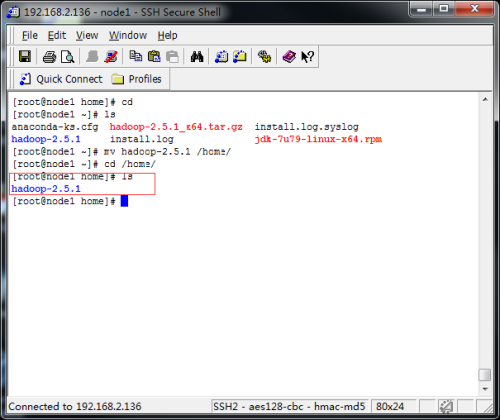

3.通过mv命令将解压后的hadoop包移动到/home下

![4移动文件到home下.png wKiom1l7-tPBq1s1AACwJTx8Xcg227.png-wh_50]()

![5进入home目录.png wKiom1l7-yqT2wXmAAC-AT8Iro8889.png-wh_50]()

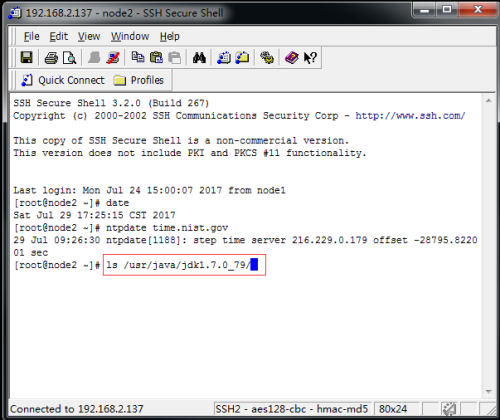

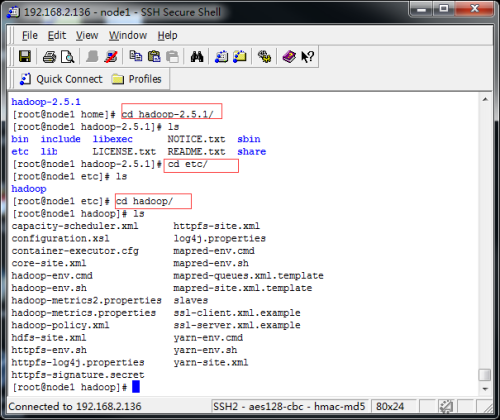

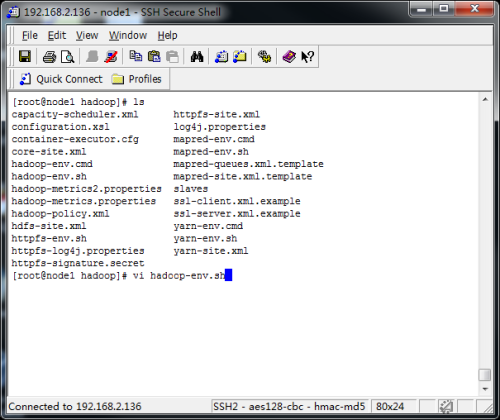

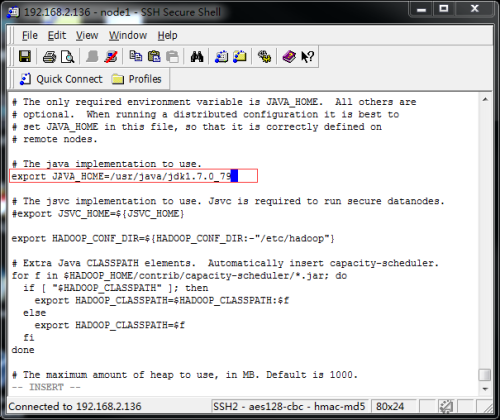

4.修改hadoop-en.sh配置文件,添加jdk的安装目录,操作如下图所示

![jdk安装目录.png wKioL1l7-zyihSZaAACwkvsPdiQ533.png-wh_50]()

![进入etc下的hadoop中.png wKioL1l7-_WQQbjfAAEDYlQCnpY252.png-wh_50]()

![修改配置文件hadoop-env.png wKiom1l7_Bvh6VWjAADetbWCJ3M132.png-wh_50]()

![配置jdk安装目录.png wKiom1l7_I3ANkSjAADxPh5J8ts843.png-wh_50]()

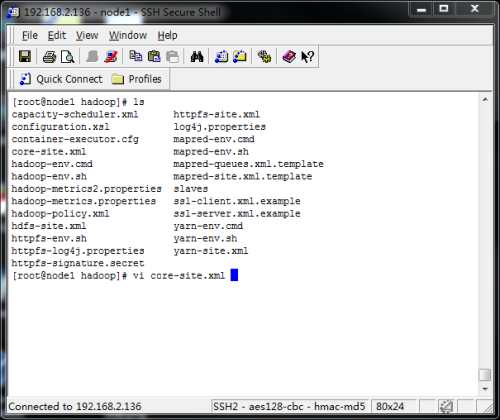

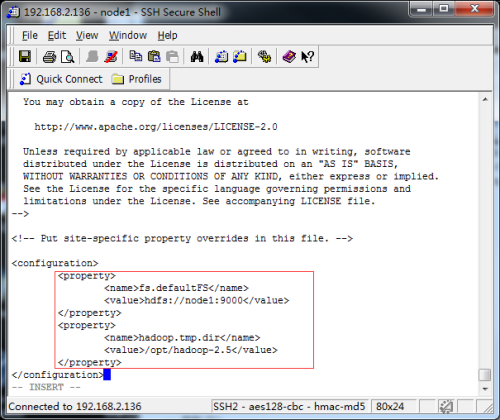

5.修改core-site.xml配置文件,添加namenode的配置信息

![配置core-site.png wKioL1l7_NHS9s7vAADbOXrb7v4692.png-wh_50]()

![配置namenode.png wKiom1l7_RnB6CMXAAEAopbZB50681.png-wh_50]()

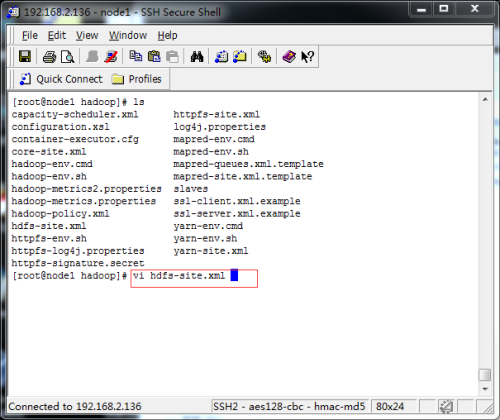

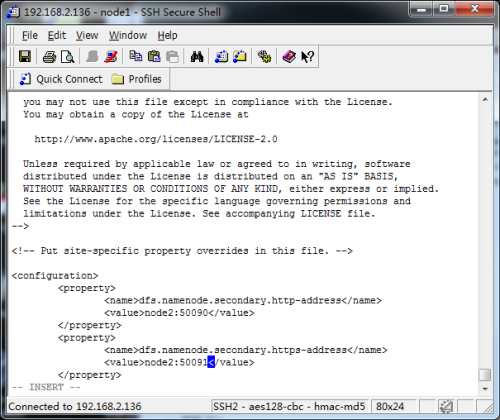

6.修改hdfs-site.xml配置文件,添加secondarynamenode的配置信息

![配置secondnamenode.png wKioL1l7_Xmy1bJ2AADsrDokgFc223.png-wh_50]()

![配置secondname.png wKiom1l7_bPw4qIcAAEEaoCXx_c214.png-wh_50]()

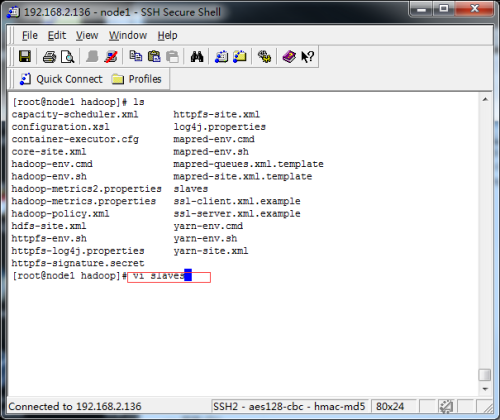

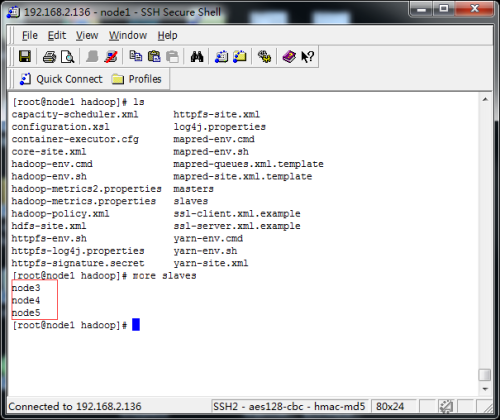

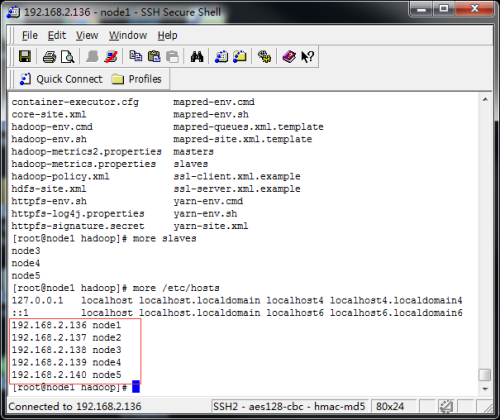

7.修改slaves配置文件,添加datanode节点的配置信息

![配置datanode.png wKiom1l7_f_yiZUNAADvqaRNOQU409.png-wh_50]()

![配置datanode的节点.png wKioL1l7_o_Tbcu3AAD6Sh84QrI460.png-wh_50]()

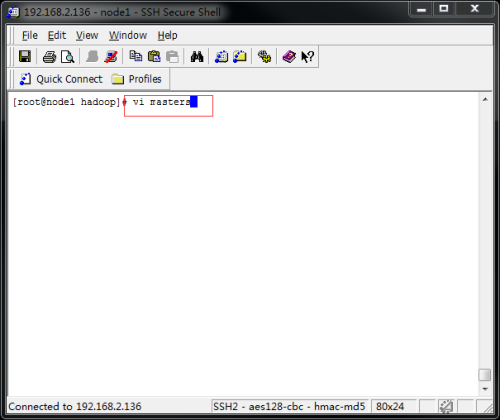

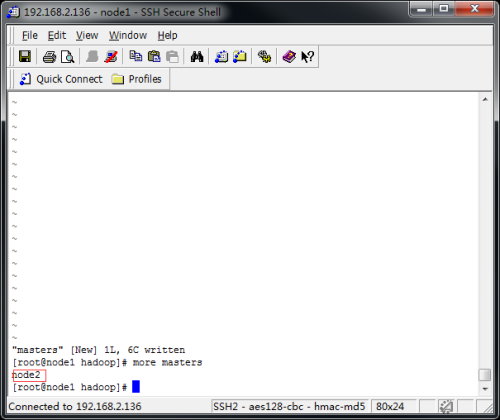

8.配置masters的secondarynode的主机名

![配置secondnamenode主机名.png wKiom1l7_suQiZ4kAAByTv_j9_U138.png-wh_50]()

![配置secondnamenode主机名的内容.png wKiom1l7_vHh3yIbAACNm0SnJ8M941.png-wh_50]()

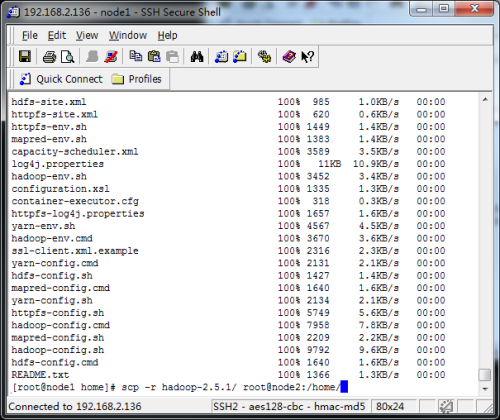

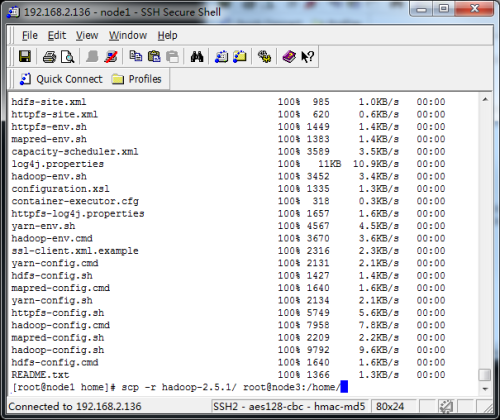

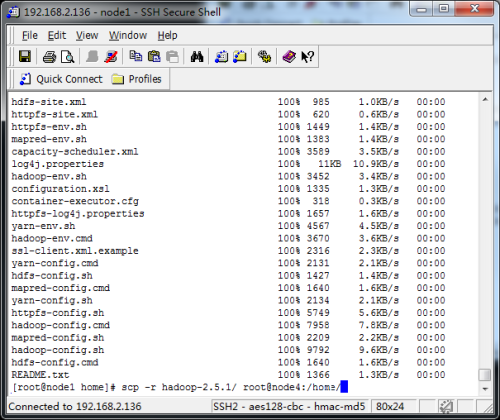

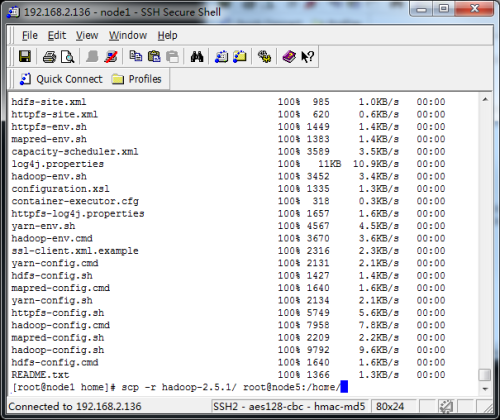

9.将node1上的安装目录hadoop复制到其他的节点

![复制安装文件到node2.png wKiom1l7_zmRxLBwAAEcso-4z-E964.png-wh_50]()

![复制安装文件到node3.png wKioL1l7_3-RxCVpAAEcxvewygQ786.png-wh_50]()

![复制安装文件到node4.png wKiom1l7_5fgrRjuAAEdWl1-7N0382.png-wh_50]()

![复制安装文件到node5.png wKioL1l7_6-i6EeVAAEczqV9R0o924.png-wh_50]()

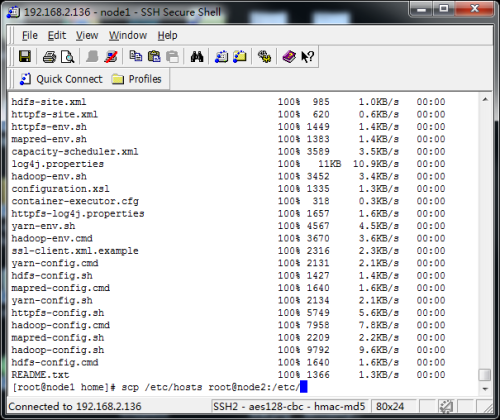

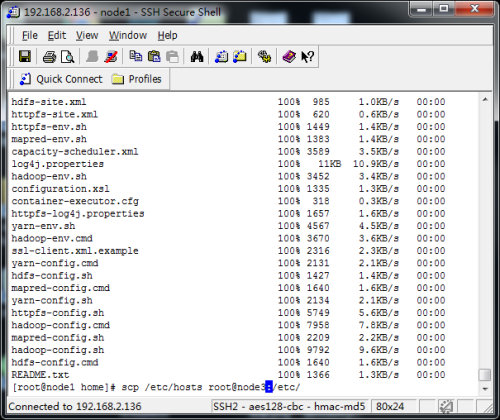

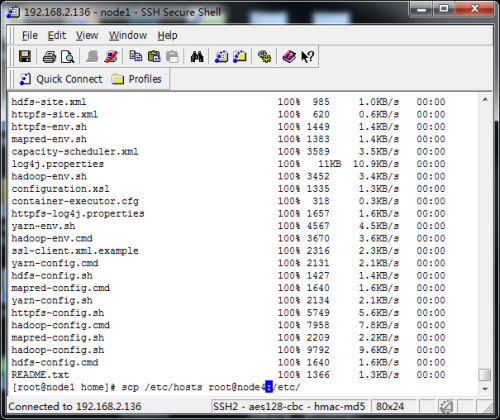

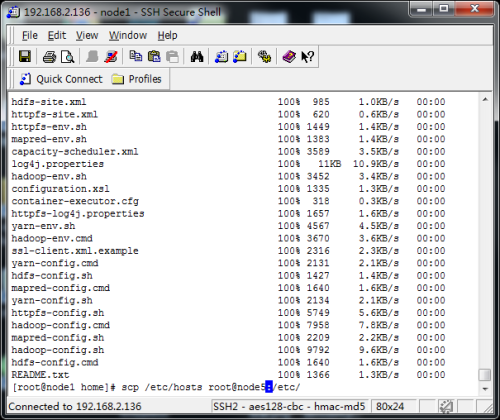

10.将node1上的hosts文件复制到其他节点hosts文件所在目录/etc/hosts

![QQ截图20170729113942.png wKiom1l8A46COszMAAD-SakCOEY966.png-wh_50]()

![复制hosts文件到node2.png wKiom1l7_-nQcMl6AAE0VzgI2Z0509.png-wh_50]()

![复制hosts文件到node3.png wKiom1l7__eBWOQ_AAE0ZMBJUnE055.png-wh_50]()

![复制hosts文件到node4.png wKioL1l8AAzw38NPAAE0bIxPyZc751.png-wh_50]()

![复制hosts文件到node5.png wKioL1l8ABaytx3wAAE0Zcgs_g8610.png-wh_50]()

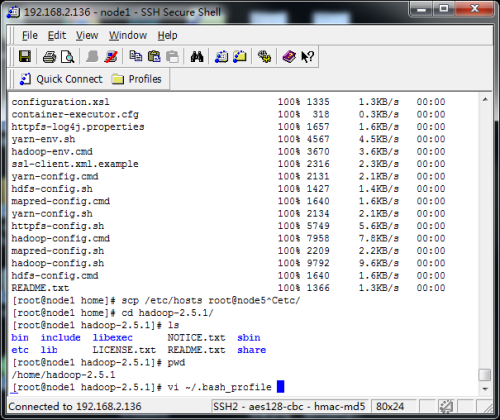

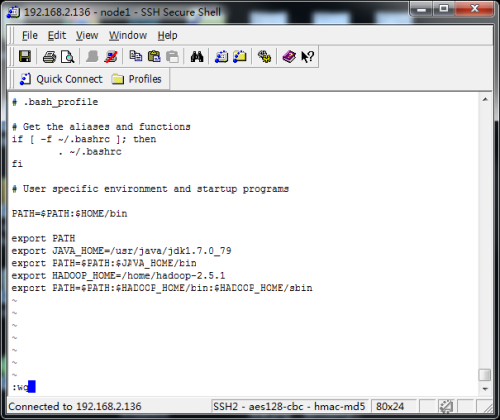

11.将hadoop的安装目录添加到系统环境变量

![配置hadoop的环境变量.png wKiom1l8AEXg8rumAAExQVPLPyM085.png-wh_50]()

![配置hadoop的环境变量-可执行.png wKiom1l8AHCxWyJEAADhrBbx98U941.png-wh_50]()

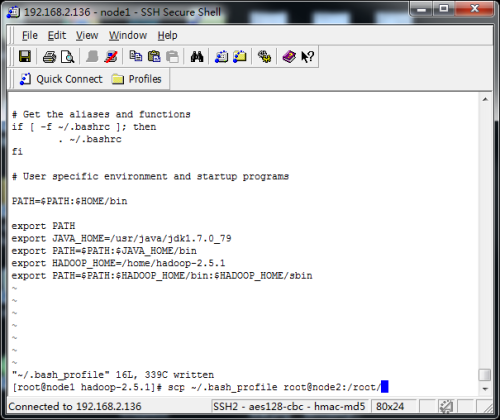

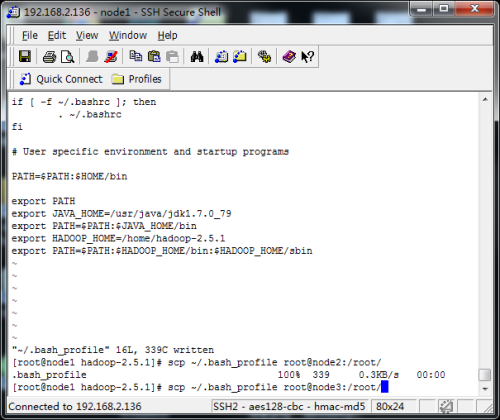

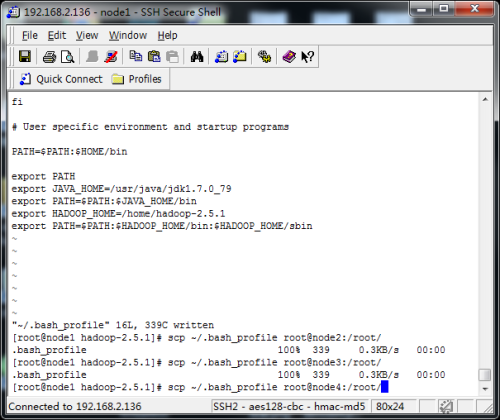

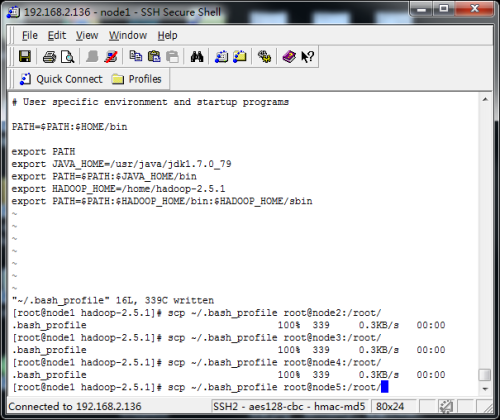

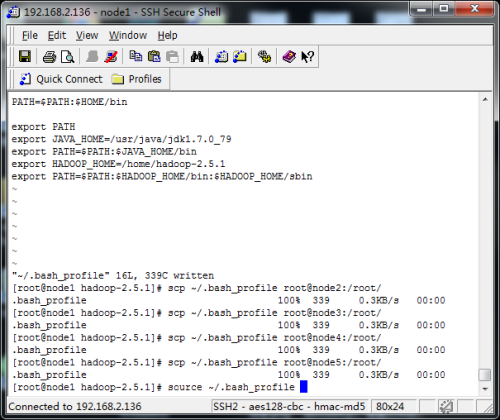

12.将环境变量文件.bash_profile复制到其他节点

![复制环境变量配置文件到node2.png wKioL1l8AKGQF4ivAADp_2IiU-s233.png-wh_50]()

![复制环境变量配置文件到node3.png wKioL1l8AKLj1LX1AADyPe37jZg096.png-wh_50]()

![复制环境变量配置文件到node4.png wKiom1l8AKPA6BW6AAD3zEiTlMg569.png-wh_50]()

![复制环境变量配置文件到node5.png wKioL1l8ANuwgu19AAEFGWT8gIE618.png-wh_50]()

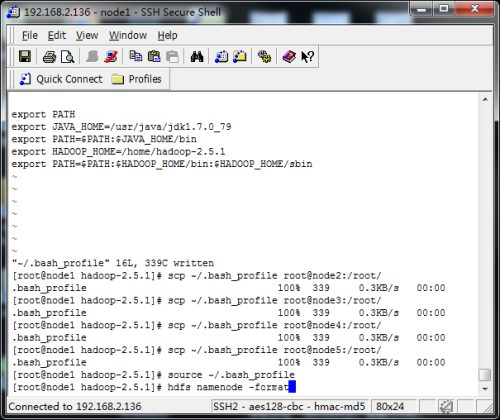

13.在node1上重新加载bash_profile

![重新加载环境变量配置文件.png wKioL1l8ATqj6sPFAAELdrQjH-E153.png-wh_50]()

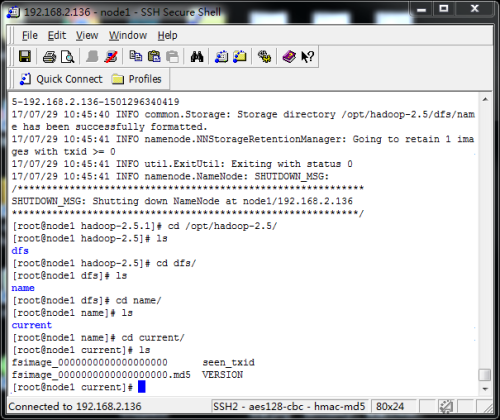

14.通过hdfs namenode -format格式化namenode节点(node1是namenode节点)

![格式化namenode.png wKiom1l8AXKAkWInAAENIQBMU5E896.png-wh_50]()

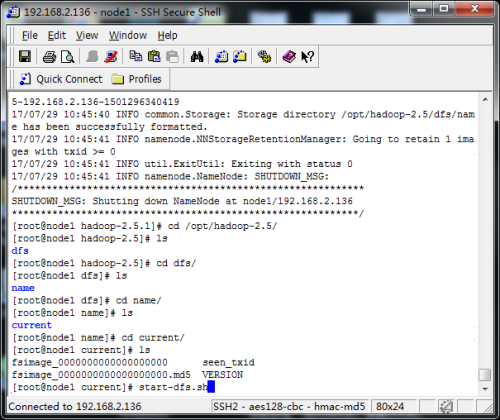

![格式化后生成的文件如目录所示.png wKiom1l8AauD03rYAAEXVgiHpGc274.png-wh_50]()

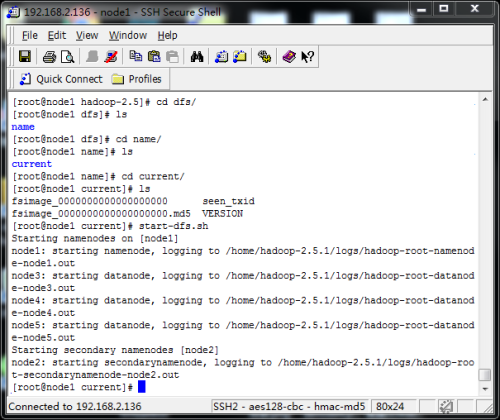

15.通过start-dfs.sh命令启动hadoop

![启动namenode.png wKioL1l8AduzbOXdAAEZ-omBr4c528.png-wh_50]()

![启动namenode的图示.png wKiom1l8AfXiCL1sAAEPD1B0Ba4518.png-wh_50]()

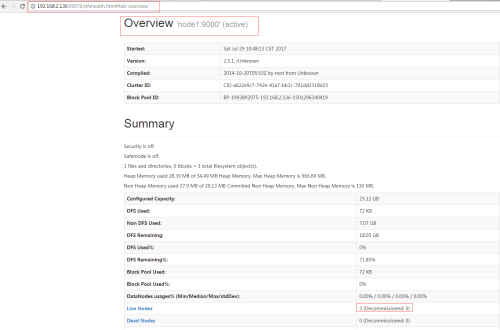

16.通过http://192.168.2.136:50070/访问namenode的监控页面(192.168.2.136是node1)

![查看监控页面.png wKiom1l8AhnimrLfAAEqq0jl1us232.png-wh_50]()

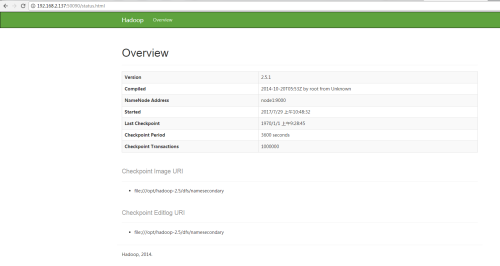

17.通过http://192.168.2.137:50090访问secondarynamenode的监控页面(192.168.2.137是node2)

![secondnamenode监控页面.png wKioL1l8Aq2w99STAACnbc3A1aU085.png-wh_50]()

18.说明

安装前

检查jdk版本是否与hadoop匹配

检查节点时间是否一致,时间相差不要超过30秒

免密码登录是否设置

到此hadoop的简单安装与配置完成

笔者在这里使用的是虚拟机来安装这些环境

node1 安装namenode节点

node2 安装secondarynamenode节点

node3 安装datanode节点

node4 安装datanode节点

node5 安装datanode节点

本文转自 素颜猪 51CTO博客,原文链接:http://blog.51cto.com/suyanzhu/1951910