写代码时,你是否也曾在大海捞针,在海量代码库中苦苦寻找一个函数或解决方案?

在 RAG-for-Code 时代,一个强大的代码 Embedding 模型就是你的“智能导航仪”。但问题是,专为自然语言设计的 Embedding 模型,在理解结构严谨、逻辑性强的代码时,常常会“水土不服”。传统的池化策略,要么是平均池化,无法充分发挥大模型潜力,要么直接使用 EOS 表征,会因信息瓶颈而丢失关键细节。a

现在,代码检索领域迎来了新的王者!

蚂蚁集团与上海交通大学继 F2LLM 后再度联手,重磅推出 C2LLM (Contrastive Code Large Language Models) 系列模型。我们通过基于注意力的创新池化机制,精准解决了代码表征的痛点,一举登顶权威代码榜单 MTEB-Code。

最重要的是,C2LLM 作为 CodeFuse Embedding 开源家族的第四位成员,将继续秉承开放精神,将模型权重、技术报告、使用方式全套回馈社区,希望能为代码大模型的研发提供一个更强的基线!

![]()

✨ C2LLM 核心亮点一览

-

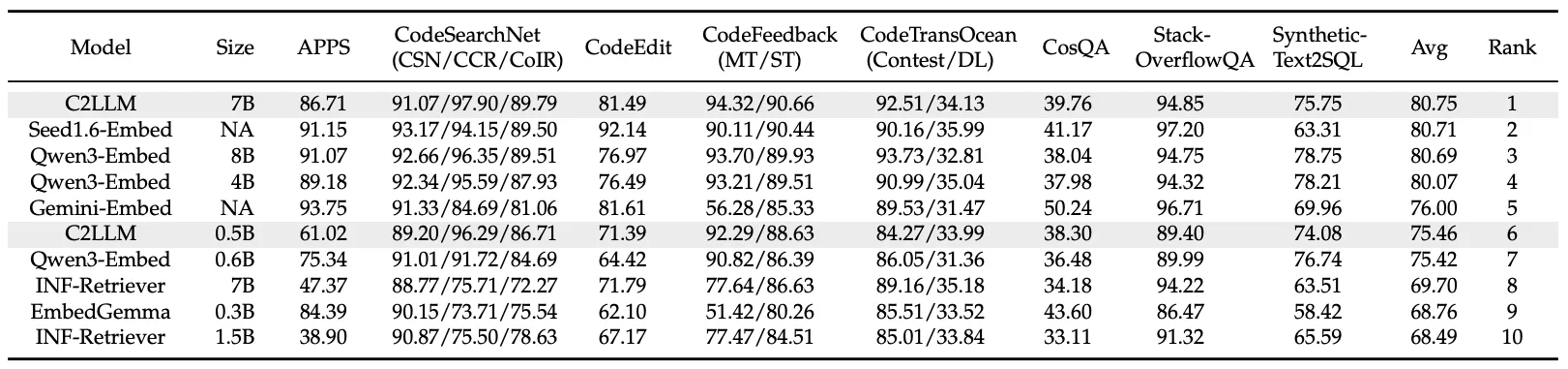

**🏆 登顶榜首:**C2LLM-7B 在权威的 MTEB-Code 代码榜单上力压群雄,总分排名第一,超越包括闭源模型在内的一众强手

-

**👑 小模型之王:**C2LLM-0.5B 在 1B 以下尺寸模型中勇夺桂冠,性能甚至超越了许多 7B 参数量的模型,是轻量化部署的绝佳选择

-

**💡 独创架构:**创新性地将注意力池化(PMA)引入代码 Embedding,让模型学会“抓重点”,告别信息瓶颈

-

**💯 完全开源:**模型权重、训练细节以及使用方式全部开放,方便社区复现与二次开发

话不多说,直接上数据,感受 C2LLM 在 MTEB-Code 榜单上的王者表现:

![]()

💡 C2LLM 的独家秘方:会“抓重点”的注意力池化

如此卓越的性能背后,是我们在模型架构上的大胆创新。

我们发现,对于代码这种长序列、结构化的数据,传统的池化方法存在天然缺陷:

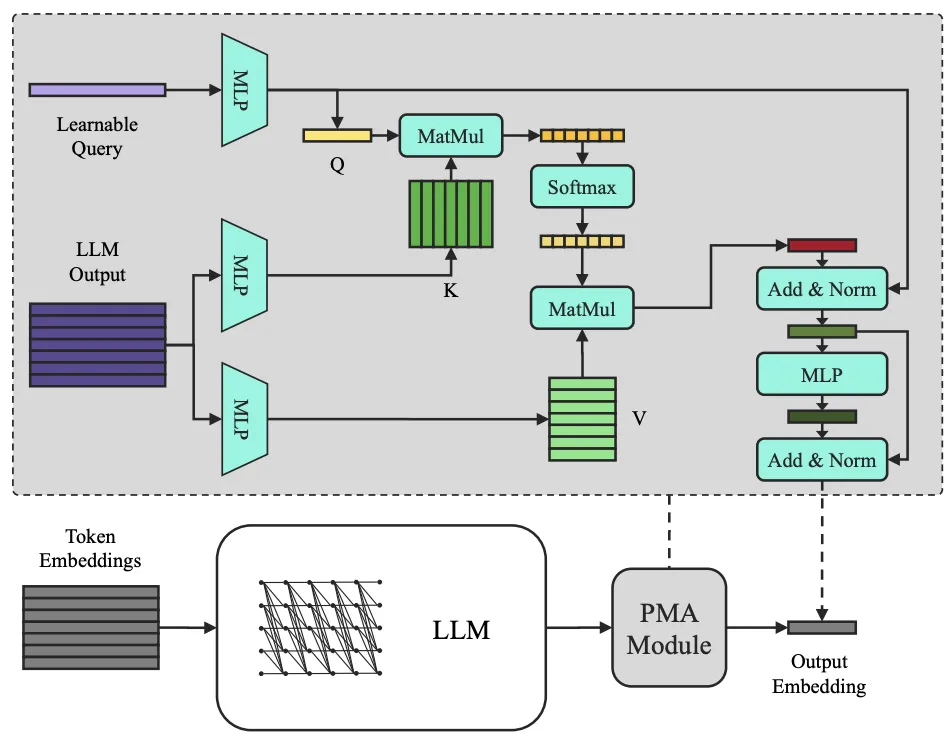

为了解决这个难题,我们为 C2LLM 引入了一个轻量而强大的模块——**注意力池化 (PMA, Pooling by Multihead Attention) **。

![]()

你可以把 PMA 想象成给模型配上了一位聪明的“项目经理”。这位经理(一个可学习的查询向量)会审阅所有员工(代码 Token)的工作报告,然后根据当前的项目目标(检索任务),智能地为不同部分分配权重,提炼出最核心的信息,最终形成一份高度浓缩、直击要点的最终报告(也就是代码 Embedding)。

这种设计的优势显而易见:

-

**精准聚合:**模型能自主学习哪些代码部分(如函数定义、核心算法)对于理解代码意图最关键。

-

**保留潜力:**完美兼容 Qwen2.5-Coder 等先进代码大模型的因果注意力结构,充分释放其预训练能力。

-

**灵活高效:**在几乎不增加计算开销的同时,还能灵活控制输出的 Embedding 维度,对向量数据库非常友好。

📊 实力霸榜!MTEB-Code 成绩见真章

是骡子是马,拉出来遛遛!在被广泛认可的 MTEB-Code 榜单上,C2LLM 家族用实力证明了一切。该榜单包含 12 项不同的代码检索任务,全面考察模型的综合能力。

这一成绩充分证明,通过先进的架构设计,我们可以在不依赖海量私有数据的情况下,实现代码表征能力的巨大飞跃。

🚀 立即体验 C2LLM!

我们相信,开放是推动技术进步的最佳燃料。C2LLM 的所有成果现已开放,欢迎大家使用、研究和反馈!

期待 C2LLM 能成为你下一个 AI for Code 项目的得力干将,也欢迎社区在此基础上构建更强大的模型!

🌟 彩蛋预告:更全、更强的 CodeFuse Embedding 模型即将亮相

开源不息,进化不止。感谢社区一直以来对 CodeFuse 的支持与厚爱!

我们在此也提前向大家透露一个好消息:性能更强悍、语言支持更丰富的新版 C2LLM 和 F2LLM 已经在加急研发中!我们致力于打造全能的 Embedding 模型,让 AI 能理解每一种自然语言和编程语言,让每一位开发者都能在海量代码中“精准导航”。代码智能的未来,邀您一同见证,敬请关注!

关于我们

我们是蚂蚁集团智能平台工程的全模态代码算法团队。C2LLM 是我们继 D2LLM、E2LLM、F2LLM 之后,在 CodeFuse Embedding 开源模型系列的又一力作。

团队成立3年以来,在 ACL、EMNLP、ICLR、NeurIPS、ICML 等顶级会议发表论文20余篇,两次获得蚂蚁技术最高奖 T-Star,1次蚂蚁集团最高奖 SuperMA,CodeFuse 项目连续两年蝉联学术开源先锋项目。团队常年招聘研究型实习生,有志于 NLP、大模型、多模态、图神经网络的同学欢迎联系 hyu.hugo@antgroup.com,期待科研路上与你同行!

如果您想更快地获取到最新信息,欢迎加入我们的微信群。

![]()

企业用户如有需求,加入群聊时还可私聊“CodeFuse服务助手”联系解决方案专家~