智元具身研究中心提出 SOP(Scalable Online Post-training)——一套面向真实世界部署的在线后训练系统。这是业界首次在物理世界的 VLA 后训练中,系统性地融合在线学习、分布式架构与多任务通才性,使机器人集群能够在真实环境中持续进化,让个体经验在群体中高效复用,从而将“规模”转化为“智能”。

根据介绍,SOP 的核心目标,是让机器人在真实世界中实现分布式、持续的在线学习。项目团队将 VLA 后训练从“离线、单机、顺序”重构为“在线、集群、并行”,形成一个低延迟的闭环系统:多机器人并行执行 → 云端集中在线更新 → 模型参数即时回流

SOP 采用 Actor–Learner 异步架构:

- Actor(机器人侧)并行经验采集 多台部署了同一policy模型的机器人(actors)在不同地点同时执行多样任务,持续采集成功、失败以及人类接管产生的交互数据。每台机器人的经验数据被汇总传输至云端 Experience Buffer中。

- Learner(云端)在线学习 所有交互轨迹实时上传至云端 learner,形成由在线数据与离线专家示教数据组成的数据池。系统通过动态重采样策略,根据不同任务的性能表现,自适应调整在线/离线数据比例,以更高效地利用真实世界经验。

- 即时参数同步 更新后的模型参数在分钟级别内同步回所有机器人,实现集群一致进化,维持在线训练的稳定性。

SOP本身是一套通用的框架,可以即插即用的使用任意后训练算法,让VLA从在线经验数据中获益。项目团队选取 HG-DAgger(交互式模仿学习) 与 RECAP(离线强化学习) 作为代表性算法,将其接入 SOP 框架以进化为分布式在线训练。

关键优势

- 高效状态空间探索 分布式多机器人并行探索,显著提升状态–动作覆盖率,避免单机在线学习的局限。

- 缓解分布偏移 所有机器人始终基于低延迟的最新策略进行推理采集,提升在线训练的稳定性与一致性。

- 在提升性能的同时保留泛化能力 传统的单机在线训练往往会使模型退化为只擅长单一任务的“专家”, SOP 通过空间上的并行而非时间上的串行,在提升任务性能的同时保留 VLA 的通用能力,避免退化为单任务专家。

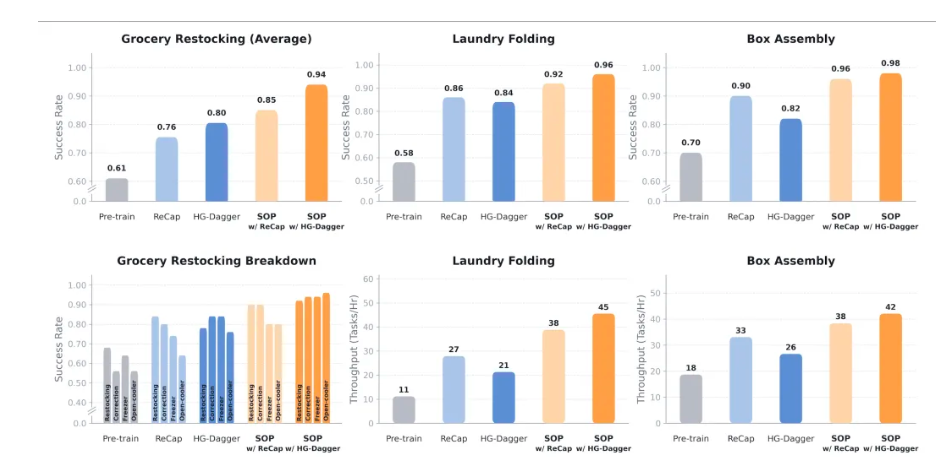

实验结果表明,在各类测试场景下,结合SOP的后训练方法均得到了显著的性能提升。相比预训练模型,结合SOP的HG-Dagger方法在物品繁杂的商超场景中实现了33% 的综合性能提升。对于灵巧操作任务(叠衣服和纸盒装配),SOP 的引入不仅提升了任务的成功率,结合在线经验学习到的错误恢复能力还能明显提升策略操作的吞吐量。

结合SOP的HG-Dagger方法让叠衣服的相比HG-Dagger吞吐量跃升114%。SOP让多任务通才的性能普遍提升至近乎完美,不同任务的成功率均提升至94%以上,纸盒装配更是达到98%的成功率。

![]()

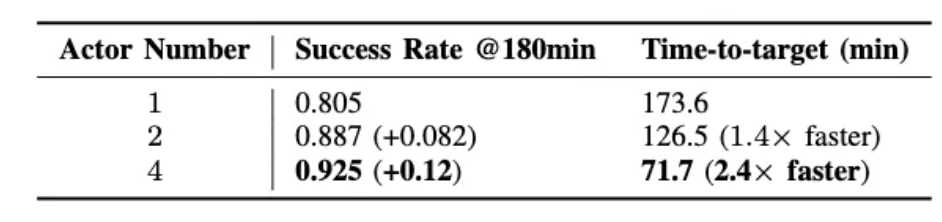

在相同的总训练时间下,更多数量的机器人带来了更高的性能表现。在总训练时间为3小时的限制下,四机进行学习的最终成功率达到了92.5%,比单机高出12%。多机采集可以有效阻止模型过拟合到单机的特定特征上。同时,SOP 还将硬件的扩展转化为了学习时长的大幅缩短,四机器人集群相比单机能够将模型达到目标性能的训练速度增至2.4倍。

![]()

最后还探究了 SOP 和预训练数据之间的关系。把总量为160小时的多任务预训练数据分为了三组:20小时,80小时和160小时,分别训练一组初始模型后再进行 SOP。发现,预训练的规模决定了基座模型和后训练提升的轨迹。SOP 能为所有初始模型带来稳定的提升,且最终性能与VLA预训练质量正相关。

同时,对比80小时和160小时实验效果,也可以明显注意到,在解决特定失败情况时,在轨策略经验带来了非常显著的边际效果。SOP 在三小时的在轨经验下就获得了约30%的性能提升,而80小时额外人类专家数据只带来了4%的提升。这说明在预训练出现边际效应递减的情况下,SOP 能够高效突破VLA性能瓶颈。

![]()