接上篇后续配置

一.配置环境

redhat6.5

server1 172.25.29(50).1 hadoop master nfs

server2 172.25.29(50).2 zookeeper nfs

server3 172.25.29(50).3 zookeeper nfs

server4 172.25.29(50).4 zookeeper nfs

server5 172.25.29(50).5 高可用备机 nfs

使用 nfs 共享同步配置文件,之前配置好java运行环境

二.Hadoop name node节点高可用配置

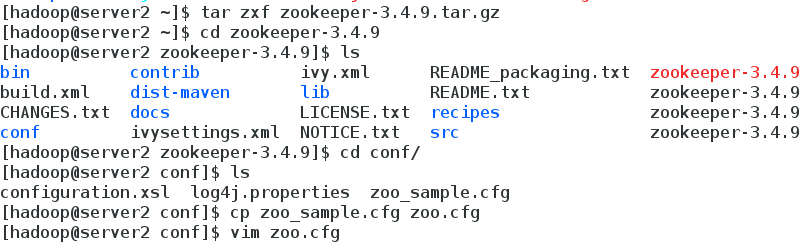

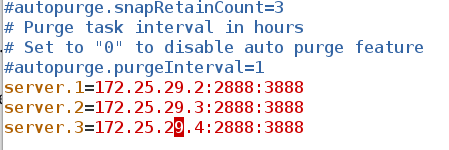

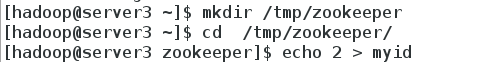

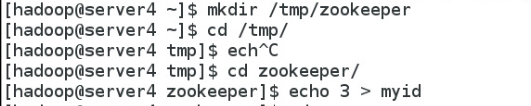

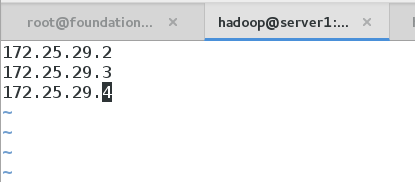

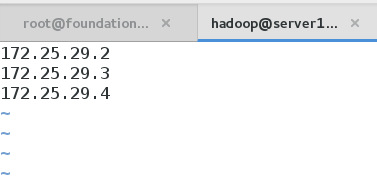

1.配置Zookeeper 集群,至少三台

![Screenshot from 2017-10-24 17-24-54.png bfd778b0aeede0e7acfac6b4eaceef25.png]()

![Screenshot from 2017-10-24 16-45-26.png 46c4348a9db23221393e176c9a12ec10.png]()

![Screenshot from 2017-10-24 17-25-03.png c77529a698ff806b4deed4e15e6121ef.png]()

![Screenshot from 2017-10-24 16-47-36.png bf71f7a909c77128ecb7bd7aa1fdc474.png]()

![Screenshot from 2017-10-25 20-15-47.png 72d62cdc46cd74a34e6bf0449df2211a.png]()

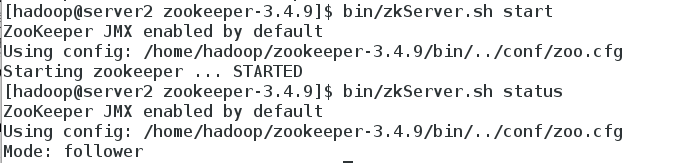

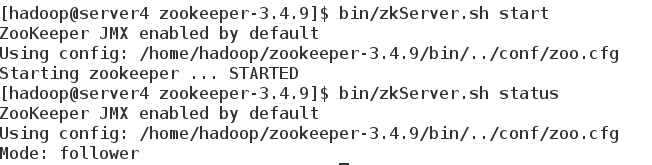

2.在各节点启动zookeeper发现服务

![Screenshot from 2017-10-25 09-22-11.png cfc141804e8a9eec4e1e36839b6b82bf.png]()

![Screenshot from 2017-10-25 09-22-21.png b3da95e88976e4ee1919774407409f10.png]()

![Screenshot from 2017-10-25 09-22-30.png 9ac479a1da9a0fa1ecbc68e631a41f63.png]()

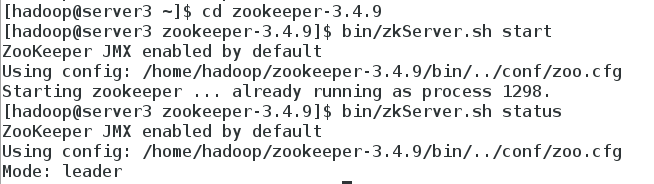

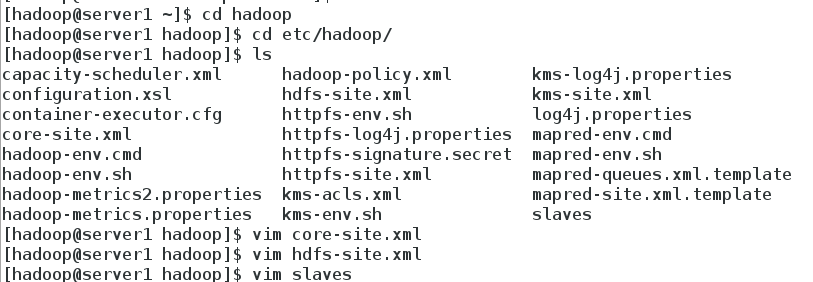

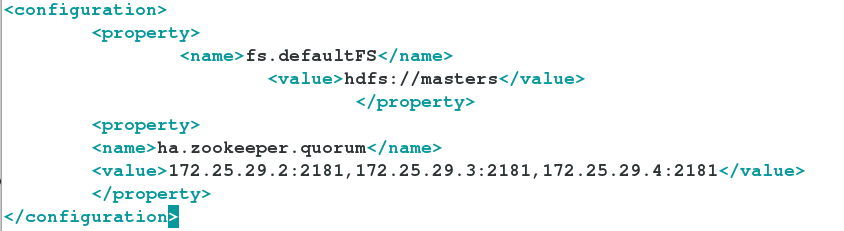

3.Hadoop 配置

![Screenshot from 2017-10-25 09-25-46.png 2452288ac13d45b780a4e066ee47df13.png]()

![Screenshot from 2017-10-25 20-21-46.png 1579809a82ae1d5800b46b78e2c9a9b8.png]()

编辑 hdfs-site.xml 文件:

<configuration>

<!-- 指定 hdfs 的 nameservices 为 masters,和 core-site.xml 文件中的设置保持一

致 -->

<property>

<name>dfs.nameservices</name>

<value>masters</value>

</property>

<!-- masters 下面有两个 namenode 节点,分别是 h1 和 h2 (名称可自定义)

-->

<property>

<name>dfs.ha.namenodes.masters</name>

<value>h1,h2</value>

</property>

<!-- 指定 h1 节点的 rpc 通信地址 -->

<property>

<name>dfs.namenode.rpc-address.masters.h1</name>

<value>172.25.29.1:9000</value>

</property>

<!-- 指定 h1 节点的 http 通信地址 -->

<property>

<name>dfs.namenode.http-address.masters.h1</name>

<value>172.25.29.1:50070</value>

</property>

<!-- 指定 h2 节点的 rpc 通信地址 -->

<property>

<name>dfs.namenode.rpc-address.masters.h2</name>

<value>172.25.29.5:9000</value>

</property>

<!-- 指定 h2 节点的 http 通信地址 -->

<property>

<name>dfs.namenode.http-address.masters.h2</name>

<value>172.25.29.5:50070</value>

</property>

<!-- 指定 NameNode 元数据在 JournalNode 上的存放位置 -->

<property>

<name>dfs.namenode.shared.edits.dir</name>

<value>qjournal://172.25.29.2:8485;172.25.29.3:8485;172.25.29.4:8485/masters</value>

</property>

<!-- 指定 JournalNode 在本地磁盘存放数据的位置 -->

<property>

<name>dfs.journalnode.edits.dir</name>

<value>/tmp/journaldata</value></property>

<!-- 开启 NameNode 失败自动切换 -->

<property>

<name>dfs.ha.automatic-failover.enabled</name>

<value>true</value>

</property>

<!-- 配置失败自动切换实现方式 -->

<property>

<name>dfs.client.failover.proxy.provider.masters</name>

<value>org.apache.hadoop.hdfs.server.namenode.ha.ConfiguredFailoverProxyProvid

er</value>

</property>

<!-- 配置隔离机制方法,每个机制占用一行-->

<property>

<name>dfs.ha.fencing.methods</name>

<value>

sshfence

shell(/bin/true)

</value>

</property>

<!-- 使用 sshfence 隔离机制时需要 ssh 免密码 -->

<property>

<name>dfs.ha.fencing.ssh.private-key-files</name>

<value>/home/hadoop/.ssh/id_rsa</value>

</property>

<!-- 配置 sshfence 隔离机制超时时间 -->

<property>

<name>dfs.ha.fencing.ssh.connect-timeout</name>

<value>30000</value>

</property>

</configuration>

![Screenshot from 2017-10-25 09-25-35.png a72b68aef37003aa4874428e9b3eb6b5.png]()

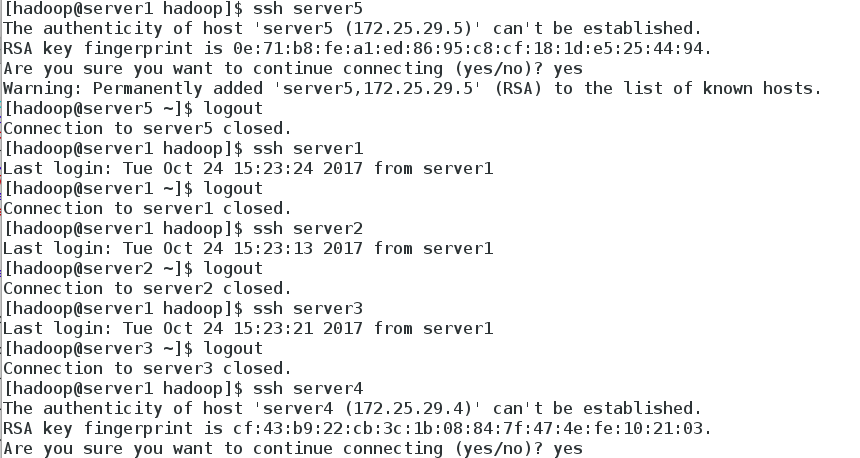

4.主机之间设置免密

![Screenshot from 2017-10-25 09-26-30.png ff26e66f218d2c68de047d80f4c5a236.png]()

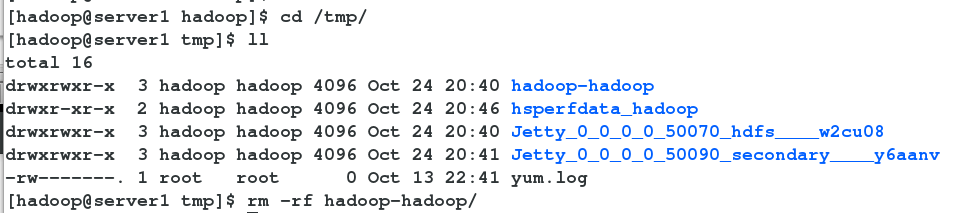

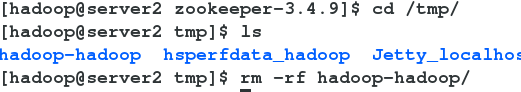

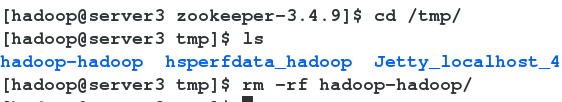

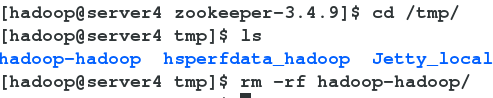

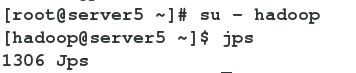

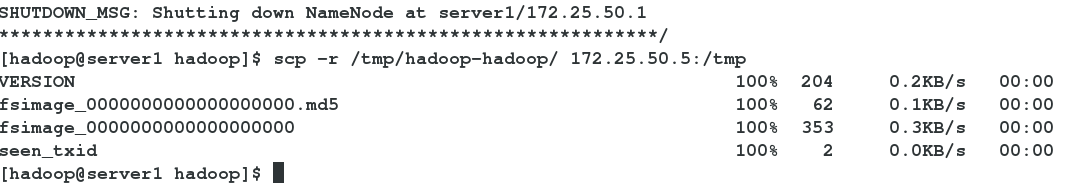

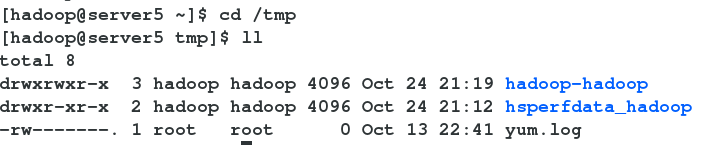

5.格式化之前删除tmp下的数据,以免影响后面的操作

![Screenshot from 2017-10-24 21-11-01.png a2b5a14d83d804c5c82072dec0bac800.png]()

![Screenshot from 2017-10-24 21-11-35.png ae40504ebe602db5ba727249d4a61feb.png]()

![Screenshot from 2017-10-24 21-11-48.png f70ed1b84e6fd245fd23854af9063b90.png]()

![Screenshot from 2017-10-24 21-12-04.png 4a5fe2410717ee26fc90815ef2bd09a4.png]()

![Screenshot from 2017-10-24 21-12-50.png e7686e0e900d3d9ee6a2670bd000a1e1.png]()

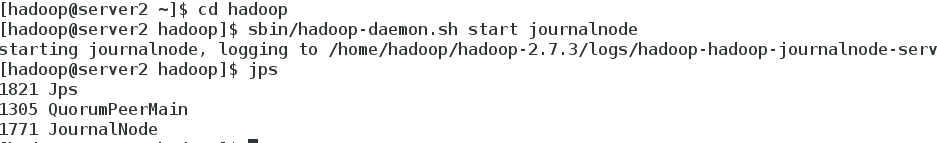

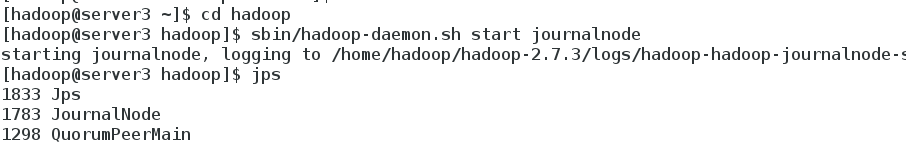

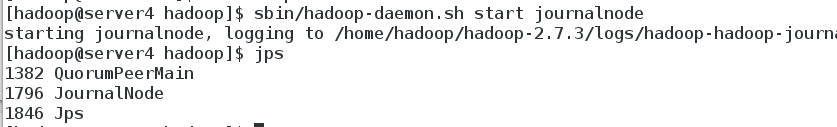

6.在三个 DN 上依次启动 journalnode(第一次启动 hdfs 必须先启动 journalnode)

![Screenshot from 2017-10-25 10-09-58.png 0bf5054623ffb151abd469db4f925279.png]()

![Screenshot from 2017-10-25 10-10-03.png 5c4c1f9f0d63f0af4cac38a5bf7624e0.png]()

![Screenshot from 2017-10-25 10-10-07.png 9cc7651972050083c36101374fc13778.png]()

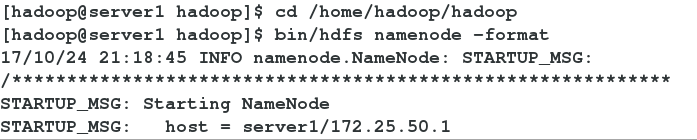

7.格式化 HDFS 集群

![Screenshot from 2017-10-24 21-18-59.png d907732941bdda933b450d5a25ab6bbb.png]()

![Screenshot from 2017-10-24 21-19-47.png 365d7c2ac26439ae9458a5718e92d1cd.png]()

![Screenshot from 2017-10-24 21-20-47.png 358ae043cb2c01b5808837901b30b2a9.png]()

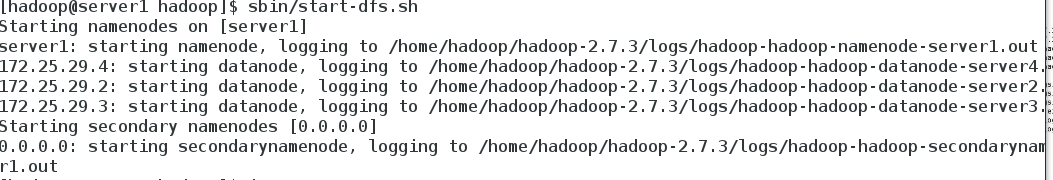

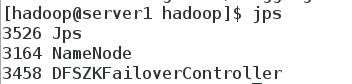

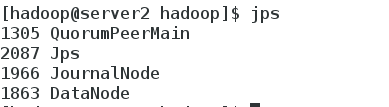

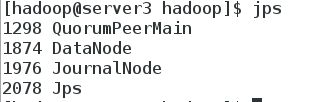

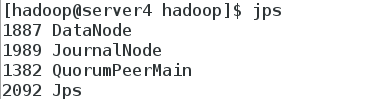

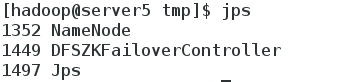

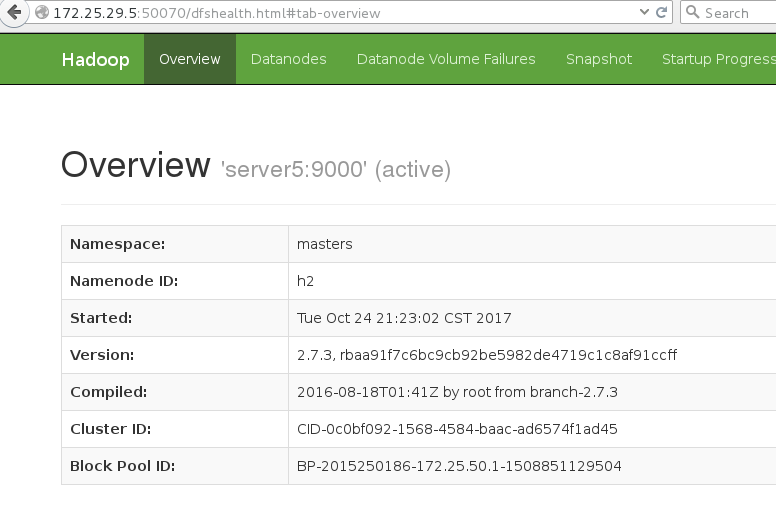

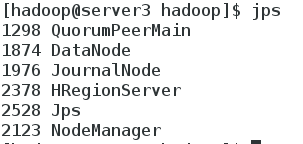

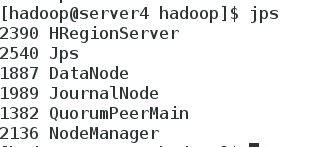

8.启动 hdfs 集群

![Screenshot from 2017-10-25 20-32-30.png 3f5c2c98853128d3a13baddf5299a1f6.png]()

![Screenshot from 2017-10-25 10-22-52.png ab540e37db0ce53b29b77bfa8b69ccd1.png]()

![Screenshot from 2017-10-25 10-22-56.png 556e530b836ecd124b62ade558f569a5.png]()

![Screenshot from 2017-10-25 10-23-05.png c9fb3cb2a81357f1f4df8bfcc008eb41.png]()

![Screenshot from 2017-10-25 10-23-12.png 17f2afbd900f89049f1eea3d498f8e05.png]()

![Screenshot from 2017-10-25 10-23-17.png e5fdc5f1b882bf52f7928f5f8220adfa.png]()

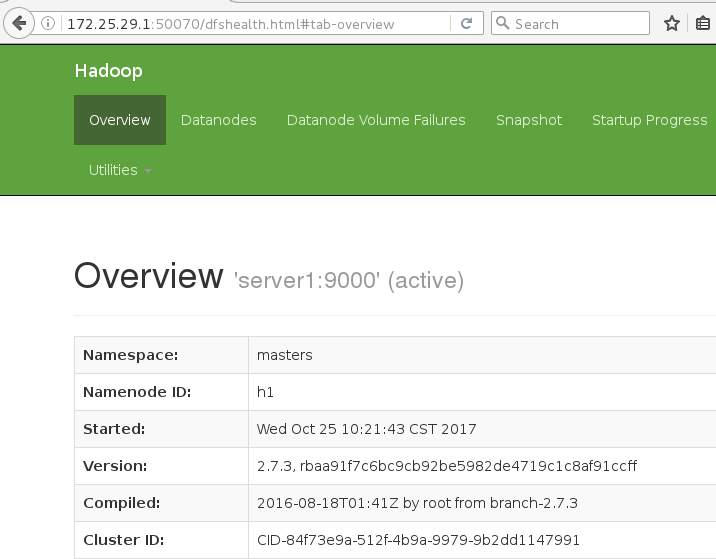

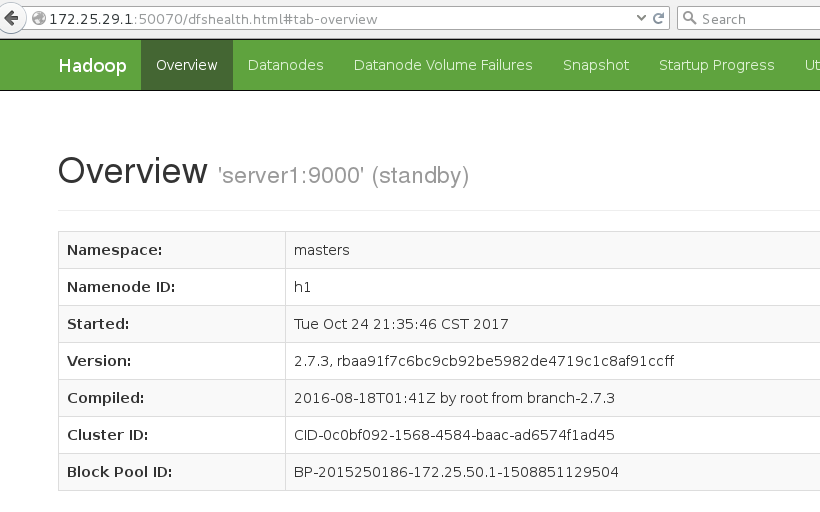

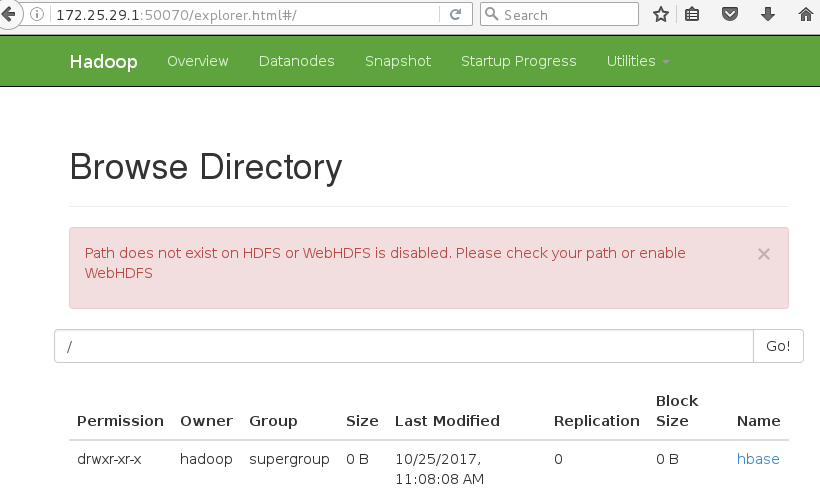

9.web登陆172.25.29.1:50070

![Screenshot from 2017-10-25 10-24-40.png 38168cdfad3c60a27ece8ead23af7181.png]()

![Screenshot from 2017-10-25 10-24-48.png c9583dc017b164afcdd82fb4cea5e0cf.png]()

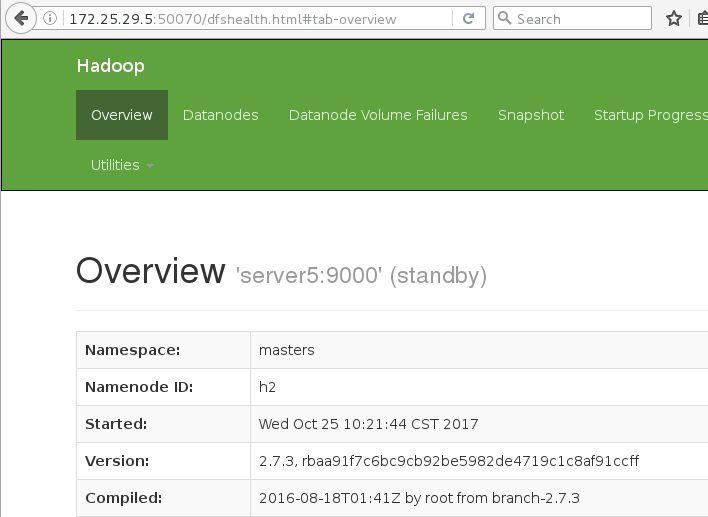

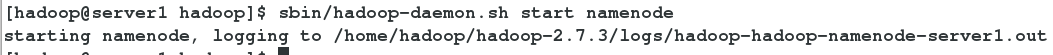

测试:关闭server1的name node进程,master切换到5上

server1 kill -9 3184

server1宕掉,server5接管

![Screenshot from 2017-10-24 21-35-51.png a44e087d6073f5a077e9315d69527124.png]()

![1.png 79c5b781ddc7f2f2eeebba9fa3cd8b6a.png]()

![1.png c0c71806bf46321c7039103d5fca09ce.png]()

![2.png cfbe400423b411f55a235c2717752b87.png]()

三.Hadoop yarn 的高可用

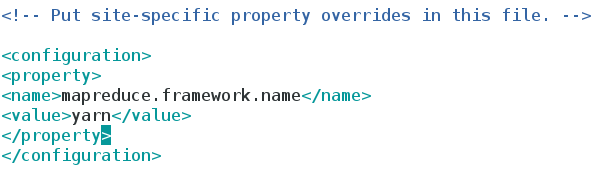

1.在hadoop/etc/hadoop下编辑 mapred-site.xml 文件

![Screenshot from 2017-10-25 09-58-05.png e3fcba2bb7ff33365cda369e28dd772a.png]()

2.在hadoop/etc/hadoop下编辑 yarn-site.xml 文件

<configuration>

<!-- 配置可以在 nodemanager 上运行 mapreduce 程序 -->

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<!-- 激活 RM 高可用 -->

<property>

<name>yarn.resourcemanager.ha.enabled</name>

<value>true</value>

</property><!-- 指定 RM 的集群 id -->

<property>

<name>yarn.resourcemanager.cluster-id</name>

<value>RM_CLUSTER</value>

</property>

<!-- 定义 RM 的节点-->

<property>

<name>yarn.resourcemanager.ha.rm-ids</name>

<value>rm1,rm2</value>

</property>

<!-- 指定 RM1 的地址 -->

<property>

<name>yarn.resourcemanager.hostname.rm1</name>

<value>172.25.29.1</value>

</property>

<!-- 指定 RM2 的地址 -->

<property>

<name>yarn.resourcemanager.hostname.rm2</name>

<value>172.25.29.5</value>

</property>

<!-- 激活 RM 自动恢复 -->

<property>

<name>yarn.resourcemanager.recovery.enabled</name>

<value>true</value>

</property>

<!-- 配置 RM 状态信息存储方式,有 MemStore 和 ZKStore-->

<property>

<name>yarn.resourcemanager.store.class</name>

<value>org.apache.hadoop.yarn.server.resourcemanager.recovery.ZKRMStateStore</

value>

</property>

<!-- 配置为 zookeeper 存储时,指定 zookeeper 集群的地址 -->

<property>

<name>yarn.resourcemanager.zk-address</name>

<value>172.25.29.2:2181,172.25.29.3:2181,172.25.29.4:2181</value>

</property>

</configuration>

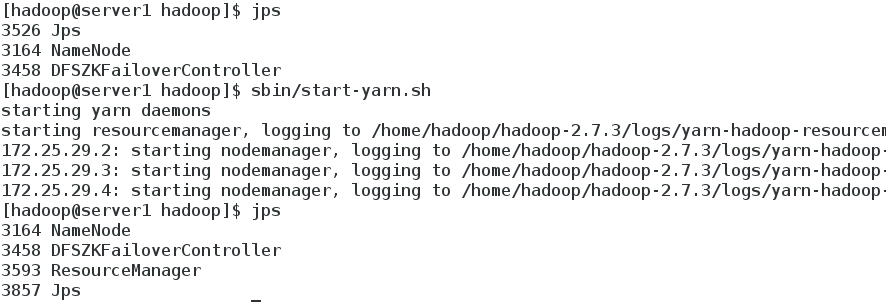

3.启动 yarn 服务

![Screenshot from 2017-10-25 10-33-47.png 4b5283c4a21c340afe9aa6e1d87edea8.png]()

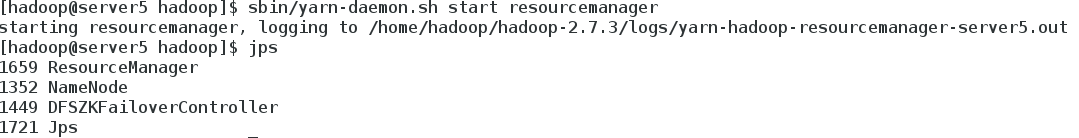

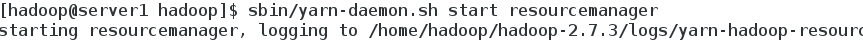

server5 RM2 上需要手动启动

![Screenshot from 2017-10-25 10-34-10.png 3a3579fed1d3c2cc4eaa6f9354b5b7d4.png]()

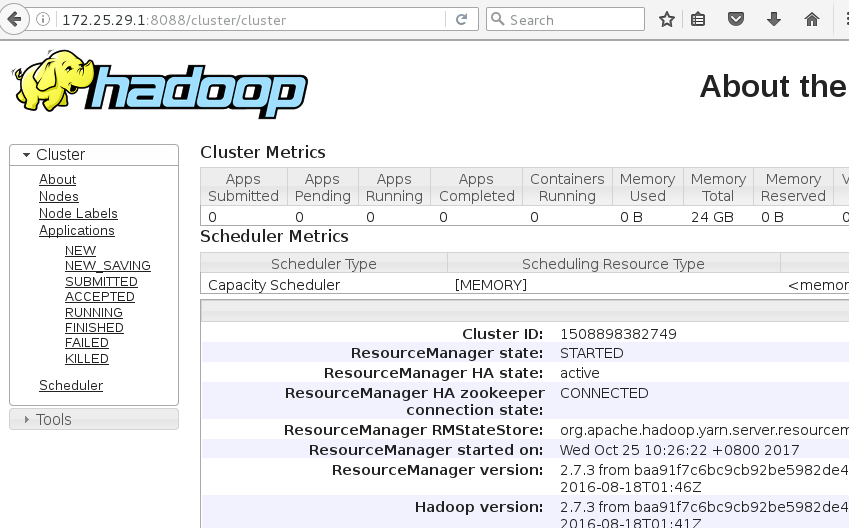

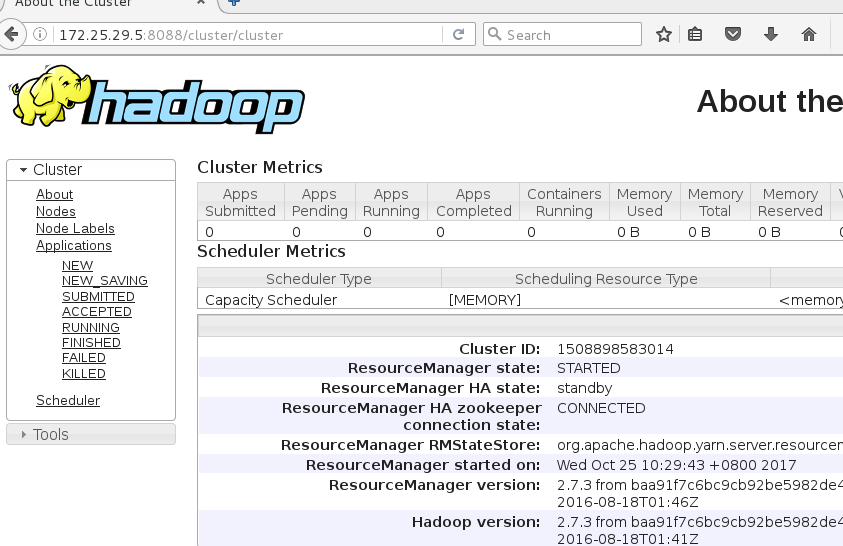

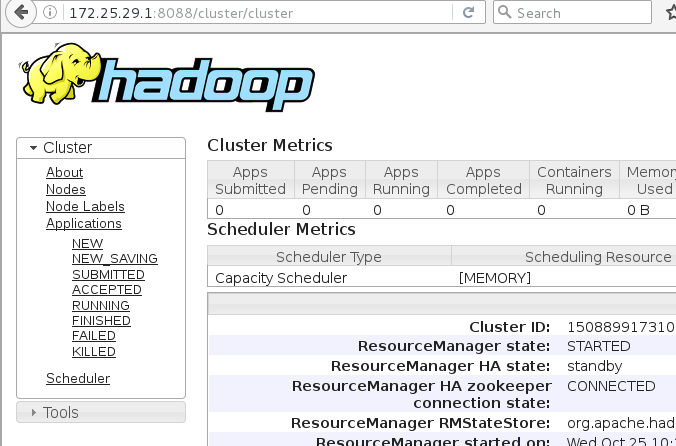

4.测试

![Screenshot from 2017-10-25 10-32-08.png 0d0b408d2d275aacae3b741a23c38080.png]()

![Screenshot from 2017-10-25 10-32-21.png 341f33b4563b5bc8c4b1865f54a77b65.png]()

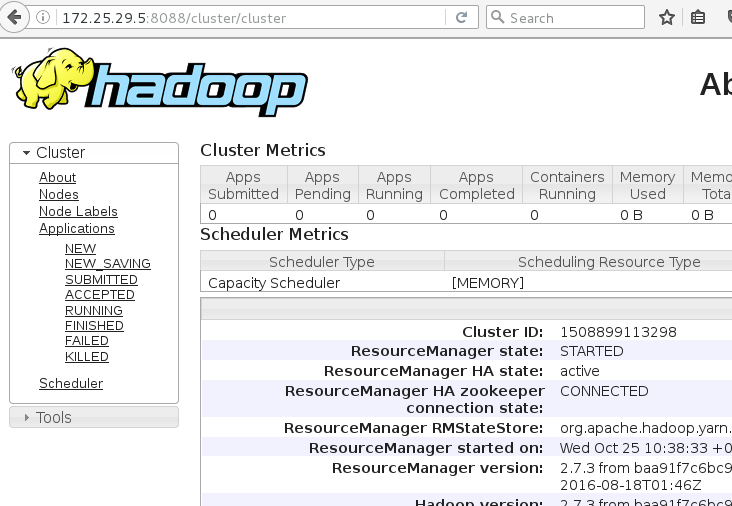

在server1上 kill -9 3593 进程,master切换到server5上

![Screenshot from 2017-10-25 10-46-13.png d75f7ac4a2713e0f94d83cd7d518a4a5.png]()

![Screenshot from 2017-10-25 10-38-42.png 17bb3790a2a0cab6186356312bc93d38.png]()

![Screenshot from 2017-10-25 10-40-12.png 5cdb85c845e5a2c6c06d5ee69dedbdbf.png]()

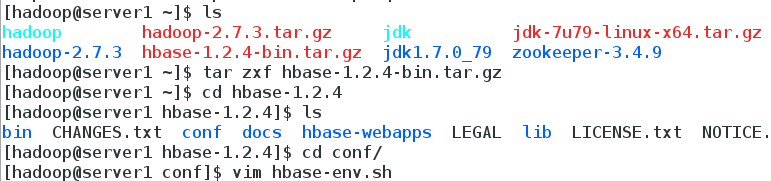

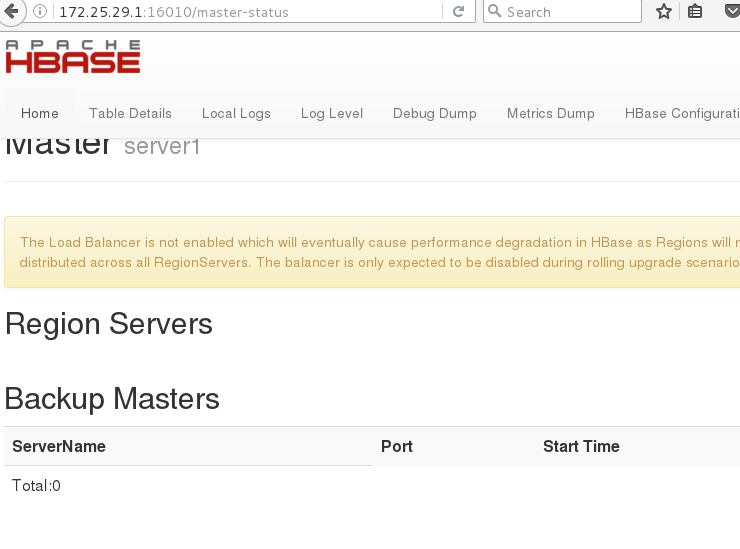

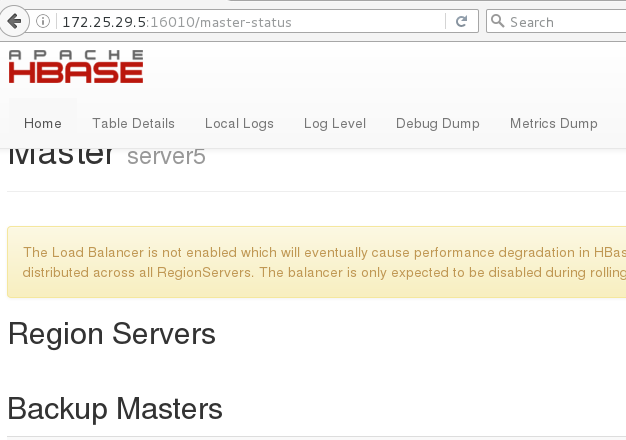

四.Hbase 分布式部署

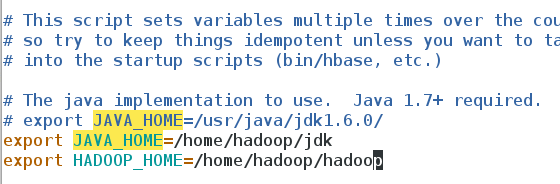

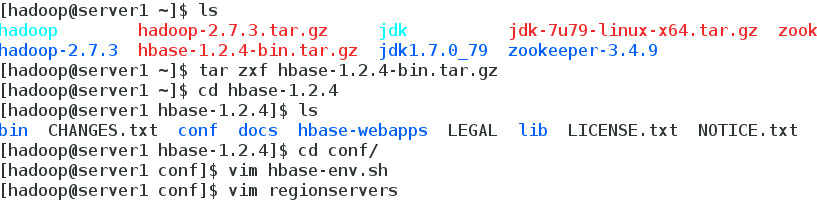

1.hbase 配置

![Screenshot from 2017-10-25 11-04-18.png 101eaa329968ad6565dac8a46cad4a59.png]()

指定 java 目录

指定 hadoop 目录,否则 hbase无法识别 hdfs 集群配置

![Screenshot from 2017-10-25 11-04-10.png c2f95bc1d2b192e97e296b8e1e3cb55d.png]()

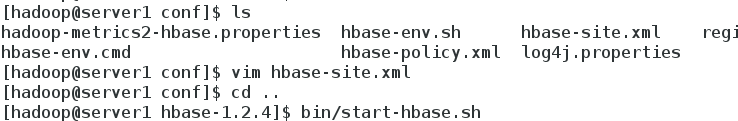

2.vim hbase-site.xml

<configuration>

<!-- 指定 region server 的共享目录,用来持久化 HBase。这里指定的 HDFS 地址

是要跟 core-site.xml 里面的 fs.defaultFS 的 HDFS 的 IP 地址或者域名、端口必须一致。 -->

<property>

<name>hbase.rootdir</name>

<value>hdfs://masters/hbase</value>

</property>

<!-- 启用 hbase 分布式模式 -->

<property>

<name>hbase.cluster.distributed</name>

<value>true</value>

</property>

<!-- Zookeeper 集群的地址列表,用逗号分割。默认是 localhost,是给伪分布式用

的。要修改才能在完全分布式的情况下使用。 -->

<property>

<name>hbase.zookeeper.quorum</name>

<value>172.25.29.2,172.25.29.3,172.25.29启动 hbase.4</value>

</property>

<!-- 指定数据拷贝 2 份,hdfs 默认是 3 份。 -->

<property>

<name>dfs.replication</name>

<value>2</value>

</property>

<!-- 指定 hbase 的 master -->

<property><name>hbase.master</name>

<value>h1</value>

</property>

</configuration>

![Screenshot from 2017-10-25 11-07-09.png d0866759381e9dd3880a2064b1a6210b.png]()

![Screenshot from 2017-10-25 11-04-58.png ec923be5b2ded3edf30d84d25b57c14c.png]()

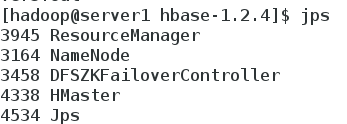

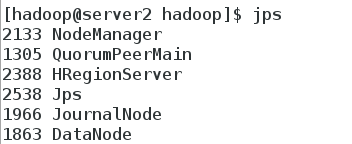

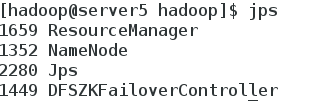

3.启动 hbase

![Screenshot from 2017-10-25 11-07-52.png 3068c367a4b46c25c4b58afd40050a92.png]()

![Screenshot from 2017-10-25 11-08-13.png 544b37f637b8e8b7cfd79e0a69a8aef6.png]()

![Screenshot from 2017-10-25 11-08-21.png 2a0af1b1d7f389a846e0f1cb66d9556e.png]()

![Screenshot from 2017-10-25 11-08-30.png 429587b88023e1a2c9a966f02a652852.png]()

![Screenshot from 2017-10-25 11-08-39.png b4442e59e7da681ea0052f3900085d4e.png]()

![Screenshot from 2017-10-25 11-08-48.png 7471a64e73c8fdc93b13fb2ace8c0ad0.png]()

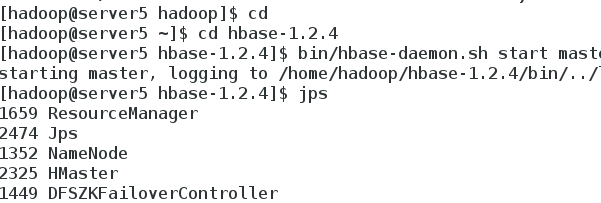

4.备节点手动运行

![Screenshot from 2017-10-25 11-09-38.png 12e267b239cbf7f911457e3b91e6d758.png]()

5.查看配置结果

![Screenshot from 2017-10-25 11-11-11.png 76c5f1d04b5ba50951b9af3206fc540d.png]()

![Screenshot from 2017-10-25 11-13-23.png d63f3b4c53e56207fc2cc225a49607e4.png]()

![Screenshot from 2017-10-25 11-17-12.png 2b516bfca6a486ed398bef8a74b5bdcb.png]()

本文转自一百个小排 51CTO博客,原文链接:http://blog.51cto.com/anfishr/1975957,如需转载请自行联系原作者