RWKV7-G1a 2.9B 推理模型开源发布,继续推进纯 RNN 模型的思考能力

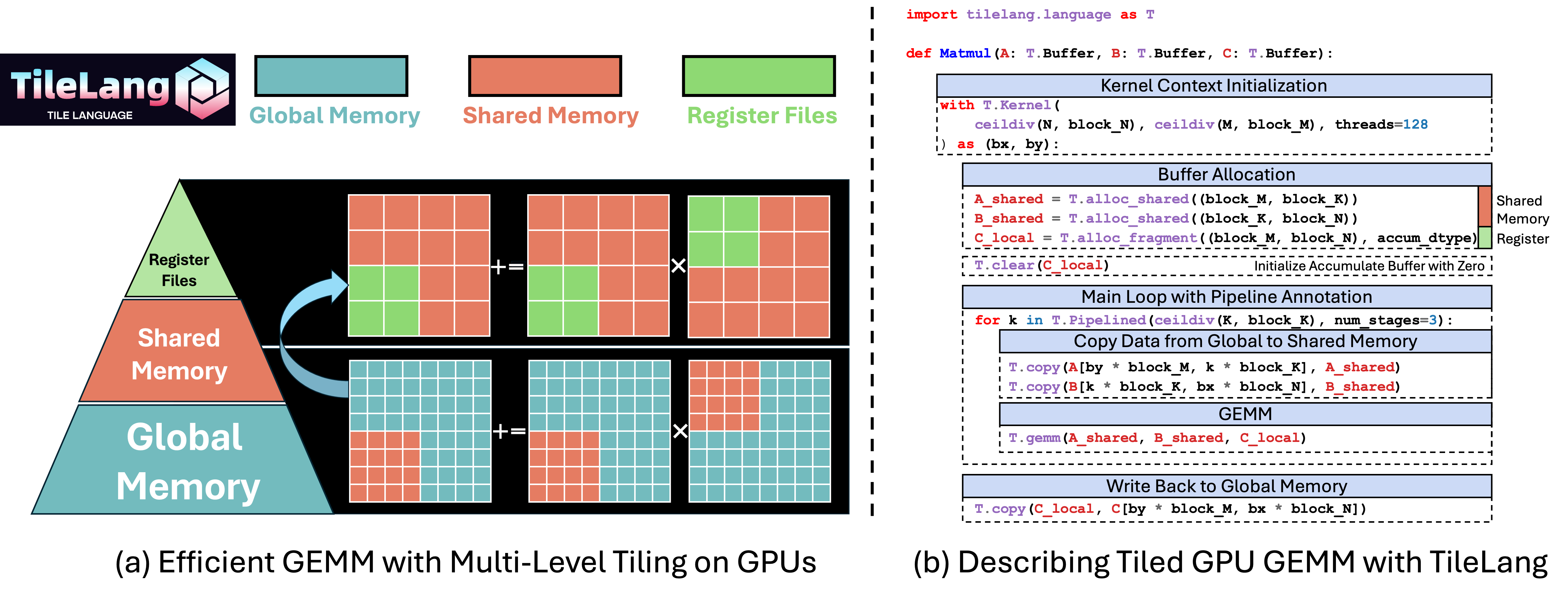

2025 年 9 月 24 日,RWKV7-G1a 2.9B 推理模型开源发布,继续推进纯 RNN 模型的思考能力。 RWKV7-G1a 2.9B 从 RWKV7-G1 2.9B 继续训练 1T tokens 高质量数据,显著提升各方面能力。 模型客观指标评测 英语和多语言能力 RWKV7-G1a 2.9B 的基础英语和多语言能力均强于同规模的开源模型: 作为纯预训练的基底模型,无“刷榜”,RWKV7-G1a 2.9B 的 MMLU 提升到 61.1%,MMLU Pro 提升到 31.5%(RWKV7-G1 2.9B 的 MMLU 为 58.0%,MMLU Pro 为 25.8%)。 无法作弊的评测 Uncheatable Eval 是"无法作弊的评测",它使用最新的论文/新闻/代码/小说等实时数据,测试压缩率(“压缩即智能”),评估基底语言模型的真实语言建模能力和泛化能力。 RWKV7-G1a 2.9B 的 Uncheatable Eval 继续提升,领先所有 3B 参数量开源模型。 模型实战 多语言能力 翻译问题推荐使用保守的解码参数,此处为:temp=0.2,topp=0.2,p...