【创造者说】 Created in the name of FOSS.

![]()

前段时间,上云和下云的争议如火如荼,公有云的价格、安全和透明度备受拷问,私有云的服务、维护成本又深受质疑。就在双方互掐不分上下的时候,一个新项目引起了我们的注意——Sealos,一个云操作系统,在公有云和私有云之间,他选择了第三条路——把公有云私有云抽象到一起。

Sealos 的作者方海涛,曾在讯飞担任容器平台负责人,后来在阿里云负责云原生集成平台,主导了 sealer 项目并捐献给 CNCF 社区。他觉得自己“骨子里就是个创业者”,早在2016年就开始了第一次创业,可惜没成。Sealos 每年翻倍的发展速度,让他看到了新的希望。拿到奇绩创坛的投资后,他火速拉上自己的老朋友和同事,出来成立了环界云计算公司。产品 Sealos 自从2023年6月份上线以来,仅半年时间注册用户已经突破8万,月收入超过30w。

方海涛认为,现在的公有云和私有云虽然吵得凶,但其实各有各的问题,也各有各的适用场景,脱离场景谈优势毫无意义。他认为,公有云和私有云并无本质区别,都是连接计算资源,可以做个像安卓一样好用的云操作系统,谁要用云就装一个就行。而现在,这个想法实现了。

01 创业的齿轮重新转动

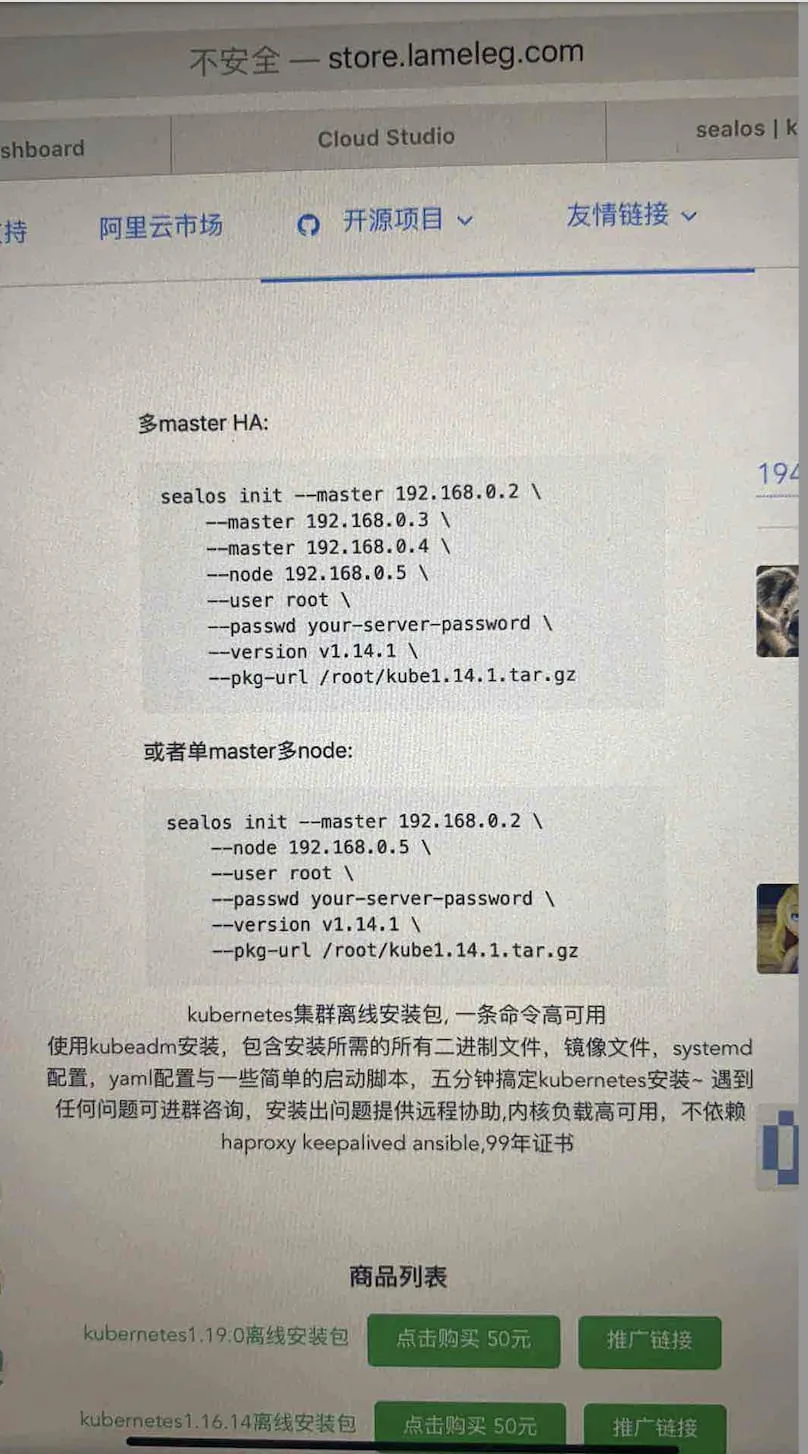

第一次创业失败后,方海涛回归了单纯的程序员身份。一天晚上,为了解决 K8s 早期版本的安装和高可用等问题,方海涛把自己写的一个安装脚本放在了阿里云市场上,命名为“ kubeinit ”,15块钱一份。没想到的是,还真有人买。看着进账,方海涛很兴奋,仿佛看到了未来的商业帝国。可是,这第一个版本问题太多了,程序也十分复杂,方海涛不得不花了一整天时间为这位客户提供售后服务,电影院里还在帮用户解决问题。

![]()

不过,这个好开头,让方海涛重拾了一点创业的信心。随着销量暴增,方海涛也借此换了一部新手机 iPhone 8。但不幸的是,问题也越来越多了,方海涛都抽不出时间进行售后维护。于是,他重写了一个基于 Ansible 的 v2 版本,但 Ansible 也只是使用起来方便许多,并没有解决根本的安装复杂度问题,很多用户安装失败,尤其是在离线环境中更容易出错,需要把 Ansible 放到 Docker 中。

为了解决这个问题,方海涛思考了很长时间,最后在 kube-proxy 源码上找到了灵感。借用负载均衡器的实现方式,去掉很重的组件,使整个脚本变得简单,于是第三个版本 Golang 解决了以往的问题,在安装方面做到简单极致,一条命令解决一切——这就是后来的 Sealos。

大概是众人都苦于 K8s 安装久矣,Sealos 口碑打开之后,在 Github 的趋势榜上连续霸榜了一周,可见需求之旺盛。这样出色的表现,也吸引了陆奇团队的注意。2022年3月,Sealos 获得了陆奇团队200万的天使投资。方海涛的创业之路,也重新开启了。

02 独树一帜的设计

“上云是未来”虽已达成共识,但上的是公有云还是私有云,却存在分歧。尤其是在今年的公有云故障事件之后,私有云的声音也响亮了起来。毕竟,公有云干的本就是租赁的活儿,不少软件还是开源的,却还卖这么贵,难免让用户心生“割韭菜”的怀疑。而私有云,建设成本又太高,无论是采购还是自建,花销都少不了:采购起步上千万,自建少说30人。这也是当下用户纠结的原因。有评论说得好:云就是一座围城,外面的人想进去,里面的人想出来。

不过面对这种 A or B 的难题,Sealos 却选择了第三条路:把公有云和私有云抽象到一起,集公有云的弹性、敏捷和私有云的安全可控于一身,同时再把价格给打下去。

还有这种好事?

怎么做到的?

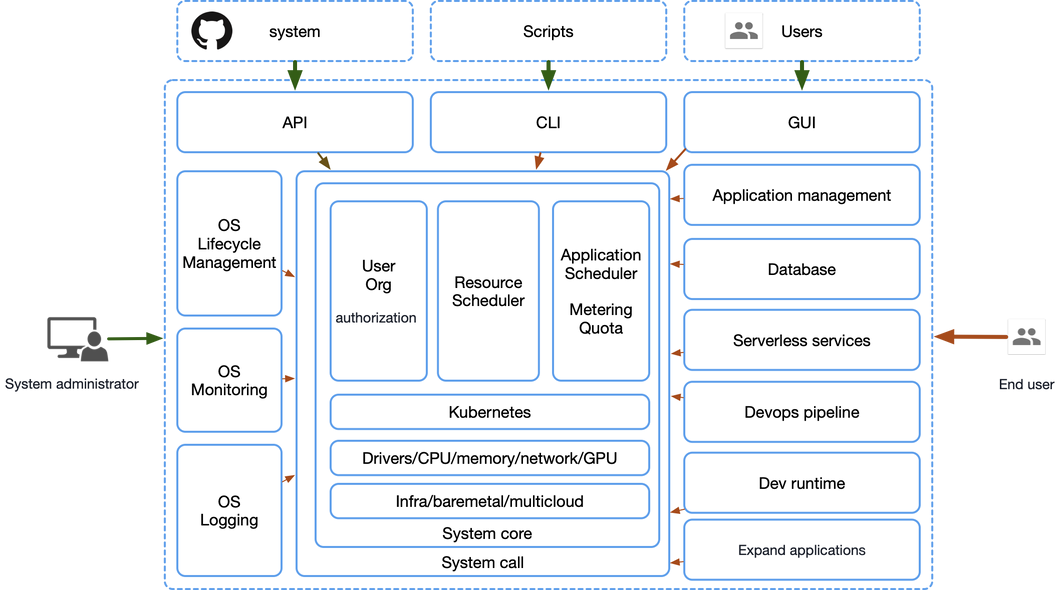

Sealos 将 Kubernetes 作为 “云内核”,基于这个云内核做一个可以运行在多台服务器上的云操作系统发行版,系统之上 “一切皆应用”。最终可以把整个数据中心所有服务器变成一台 “逻辑计算机”,让用云变得像用 PC 一样简单:

![]()

云的架构也从传统的 IaaS、PaaS、SaaS 三层架构,转向以 Kubernetes 为云内核的新架构:

![]()

最终,Sealos 和 Kubernetes 之间的关系,就像 Red Hat 和 Linux 内核之间的关系,只不过与单机操作系统的区别是,Sealos 是装在整个数据中心的,Sealos 上跑的也不是 QQ 微信这些单机应用,而是开发者需要用到的各种分布式应用。有了 Sealos,整个数据中心就不再是一台一台孤立的服务器,而是一个整体,变成一台超级逻辑计算机。这个时候再去用云,就像是在用一台服务器一样简单。

哪家企业需要用云,就直接装一个云操作系统就搞定了。

在方海涛看来,云计算的本质在于将计算资源(包括硬件、软件和网络等)通过互联网等方式提供给用户使用,连接单个数据中心的算力资源只给自己用就是私有云,通过公网让大家都能用就是公有云。至于功能上,公有云能做到的理论上私有云都能做到,并无本质区别。未来,公有云和私有云也许会走到一起,变成同一个东西。

在 Sealos 的设计中,也处处秉承了这样的理念。公有云与私有云是同一套代码,同一个抽象,只是配置与安装的应用不同,运行在企业自己机房就是私有云,对公网提供服务就是公有云。

两边的用户一手抓了。

这样的设计还使得 Sealos 简洁又简单,避免了传统用云的“屎山”体验。

而在高度抽象的架构下,一切具体能力都通过应用去扩展。用户需要啥就装啥,不要就卸掉,自由灵活,云操作系统也不会随着软件功能的增加而增加复杂度。这样,不管懂不懂 Kubernetes 都能愉快地使用 Sealos 了,云原生专家可以打开终端敲各种原生命令,DBA 也可以直接使用数据库应用,极其灵活。

“用户需要关心 Kubernetes 吗?其实不需要。我们只要想办法把用户最终需要的应用直接交付给用户就行了,就像你去用 Linux 的时候你很少关心 Kernel 一样,云也是一样的道理,开发者需要用到的能力才是最重要的,未来没有多少人需要再去关心这个内核了。”方海涛说。

03 学习 Linux,成为 Linux

在 Sealos 的成长过程中,不难发现,很多产品思路都学习了 Linux。在采访过程中,方海涛也对 Linux 极为推崇。他认为,Linux 简单易用,运行稳定,几乎不用投入太高成本,也基本不需要定制化开发。而 Openstack 专业人士三天都不一定能装起来,还得改一堆代码才能用,实在是太复杂了,不应该成为私有云的代表。Linux 才是学习的榜样。

“Linux 在哪里用都是同一个 Linux,云也应该这样。否则一味地堆积很多乱七八糟的东西进来,变成一个大杂烩,那 Sealos 只会变成又一个失败的 PaaS 平台。”方海涛说。

Sealos 目前只有一套开源代码,哪个版本都一样,没有分支。而它能得到众多开发者的欢迎,也是因为它像 Linux 一样低成本、易用和标准化。

“其实云都是大差不差的,Sealos 能解决的问题,其他的云基本上也能解决。但 Sealos 现在这么受欢迎,就在于它的易用性。”方海涛介绍,“同样的事情,如果放在 Sealos,K8s 集群已经有了,只需点一下按钮 CBT 就能起来。但是如果基于虚拟机去搭的话,你可能需要搞后端的数据库,再去搭建负载均衡,去搞备份恢复等等,才能把整套东西搞起来。成本差异就在这。”

在运维方面,Sealos 也很稳定。“在我们的理念中,不应该有运维这种角色的存在,整个系统是自运维的,就像 PC 操作系统运行起来很少发生问题的。”

而且 Sealos 最小只有300M,企业装了 Sealos 便能在各种环境中拥有完全属于自己的云。

“另外,Sealos 有标准化的应用市场。很多人需要的其实只是上层的应用,我们把这些应用封装好,直接给到他们去用就行了。一些云厂商可能也有类似的 Marketplace,可是这些 Marketplace 缺乏标准,软件的生产者跟消费者之间协作就很麻烦。我们以云操作系统的思维,在做这个事情的时候,我们会 follow 云原生生态的事实标准,让软件的生产者和消费者连接起来,相互协作,达成良性循环。”

这种以操作系统的思维来做云最终也会改变生产关系,让云的生态可以像安卓生态一样,不再是单一厂商来提供云应用,而是形成多对多的网状协作关系。

04 神奇的项目:开源、商业不分家

截至目前,Sealos 在 Github 上已经拥有了12000+的 star。良好的群众基础,也给 Sealos 打开了一条丝滑的商业化道路。

跟别的开源项目不同,Sealos 并没有走“先开源,后收费”的路子,而是从诞生起,就开始收费了。最早期时是卖安装包,代码开源但是安装包收费,如果用户自己根据源码去构建安装包可能需要一周时间,而花50-168元就可以立马下载,所以卖了很多,装机量超过150万次。

出来创业之后,Sealos 也开始了正式的商业化。目前主要的商业模式有两大块:公有云和私有云。但有意思的是,不管是标准版还是商业版,不管是公有云还是私有云,Sealos 都只有一套代码。开源和商业化不分家。那 Sealos 是怎么盈利的呢?

公有云很简单,打开浏览器,注册登录充值就可以用,按量计费。但真正的盈利点是:云服务。

“很多做开源项目的公司都会有这样的困惑:开源做得太好,用户就不付钱了?为了解决这个问题,很多公司就会做两个版本,一个是开源版,功能少一点;一个是商业版,放一些很强的功能。我就非常不喜欢这样的做法。因为维护两个版本是很累的事,每次都需要考虑哪些东西合并企业版,哪些东西不合并,时间一久两个版本就直接分叉了,后面直接索性开源版不投入了,这种方式很别扭,不高级。

我喜欢把所有的好东西都开源出去,让开源和商业化尽可能形成合力。那怎么规避'开源做得足够好之后,用户不愿意掏钱'这个问题?很简单——云服务。”方海涛说。

即便 Sealos 的开源做得非常完美,用户搭建的时候还是需要掏钱买虚拟机。既然这样,不如直接把这个钱充值给 Sealos。“本质上是成本转移,但是这种模式对三方都好。”对用户来说:

-

使用上更简单可以打开浏览器直接用,省去自己搭建。

-

专门的团队维护肯定比自己维护专业。

-

用户一多每个用户成本会下降,花钱更少。

-

持续升级更新。

因此,公有云的用户,有非常大的可能性会使用云服务。用户在 Sealos 上花的钱多了,但需要支出的总成本很可能还降低了。Sealos 也获得了更多的资金去做新功能,扩大规模效应。

另一个商业模式就是私有云。有些用户买了服务器放在自己机房,这时候 Sealos 就延续了一开始的商业模式,但不是收安装包的下载费用,而是在 Sealos 内部实现了计量系统,按量计费,账户余额用完了就得充值了。

这种方式实现了公有云和私有云计费方式的完全统一,顺便一起解决了企业内部人员配额问题。针对大小不同的客户都有合理的价格,不会出现小客用不起,大客不敢用的情况。

至于这样收费会不会让用户反感?

“我还是觉得提供价值合理收费天经地义,原则也是尽可能找到让客户与项目整体利益最大化的点,收费贵了伤害了用户利益,收费便宜了我们没法快速前进,要平衡好这中间的利益关系,是个矛盾统一体。现在这种商业模式,能够让开源和商业化形成合力,我们也能放心大胆地投入,把开源做好,而不会有担心用户不付费的顾虑。”方海涛说。

05 像开源模式的商业团队

Sealos 不仅产品有趣,背后的团队也很有意思。

如今的环界云只有21个人,其中20个人都是写代码的,包括方海涛自己。即使是运营,也是技术出身。除了在商务方面分工明确一点,其余时候,环界云更像一个开源社区,每个人都在为这个开源项目贡献代码,只是负责的模块不同。这种去中心化的开源协作方式一直顺利运行至今,其中一个很重要的原因是:环界云不太依赖销售,大部分的客户都是自己主动找上门的,因此整个团队得以单纯地搞技术,少了很多传统企业的条条框框。

当然,这种“人在家中坐,钱从天上来”的舒坦,离不开开源本身给项目带来的流量。Sealos 在社区里的好口碑和高知名度,已经成为了环界云最大的获客点。目前的数据显示,高达90%的收入都是来自于社区里这些主动找来的客户。因为他们是主动来寻求解决方案的,因此这也意味着他们对产品的接受度和成交率都相对较高。

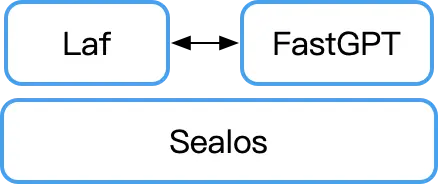

目前,除了 Sealos 之外,环界云还孵化出了两个爆款开源项目:Laf 和 FastGPT。Laf 是个函数计算平台,可以在线直接写代码,至今已有6000的 star。FastGPT 是个基于 LLM 大模型的 AI 知识库问答平台,把企业内部的私有化数据跟大模型结合,能变成企业内部的智能问答系统,目前已有8000+的 star。

![]()

Laf 和 FastGPT 为 Sealos 提供了丰富的应用,FastGPT 和 Laf 之间相互提供了 AI 自动编码能力和插件开发能力,Sealos 则为 Laf 提供扩展、使 FastGPT 得以运行。三个产品相互补充,紧密协同,已形成了一个完整的生态系统。

三个产品上线半年,环界云计算已累计8.4万的注册用户,且拥有10%的付费率和超过70%的续费率。更难能可贵的是,Sealos 和 Laf 已成功支撑了多款百万注册用户级别的应用,其运行成本仅为传统云服务的 1/20。

Laf 的作者王福根和 FastGPT 的作者余金隆,都是方海涛的创业合伙人。我们发现,环界云招募团队成员和社区贡献者的方式没什么区别,都是按照招募合伙人的方式招的。

Sealos 的一位开发主力+长期贡献者,原是 Sealos 的用户。当时方海涛做了一个“分享有奖”的活动推广 Sealos,他给社区挣了100块,方海涛却奖励他1500,他觉得这个社区好生奇怪,于是就留了下来。方海涛则认为,一个开源项目背后没有商业化支撑,会走得很慢。而且,开源的贡献者也理应得到回报。于是,为了吸引开源社区,方海涛专门写了一个激励系统,来回馈社区的项目贡献者:当需求被合并完了之后,钱就会自动打到贡献者的支付宝账户里面。这一传统也保留到了现在。

“那个时候在项目挣到的钱几乎都回馈到社区了。要么给开发者了,要么买服务器提供更好的体验了。”方海涛说,“但我觉得这是挺好玩的一件事情,这个模式形成了一种良性循环,这样项目就会滚滚向前,其实非常好。”

![]()

环界云计算团队

06 小项目准备挑战大考验

目前,Sealos 社区用户10万+,不乏各种大企业。

![]()

上线两个月时间注册用户就已破万,云服务共计运行7000+应用。

应用的类型也很多,GPT 相关的、大模型、游戏、企业官网和业务系统等等,不一而足。

但 Sealos 的宏图不止于此,它的目标是进化为一款无所不在的云操作系统,为人们提供如同使用个人电脑般简易的云服务体验。

方海涛透露,接下来,Sealos 会有两个进化方向:

一个是产品的稳定性。因为云本质上是一个信任问题。如果产品不稳定,那用户一定不会深度使用,可能就浅尝辄止一下,或者把一些不重要的东西如博客论坛等等往里放。Sealos 刚上线的时候,都是开发者在用,顶多充个十块二十块的。但经过时间的积累,市场上认可了 Sealos 的稳定性之后,慢慢地有企业进来使用,充值数额也上去了。所以说,产品的稳定性才是核心。

但是,想把稳定性建设得足够好,其实是有一定挑战的,尤其是达到了一定规模之后。“我举个例子,现在市面上几乎所有的云原生网关都不能满足我们的需求,几乎都被我们打爆了。这个时候就需要我们去建设网关,把鲁棒性搞得更强。或者挑一个上下游的开源社区,帮他们做优化,一起变得更好。”方海涛说。

第二个要做的就是生态建设。“现在已经有不少的应用支持容器和 Kubernetes 了,那首先要做的就是把它们上架到我们的应用市场,拓展应用的宽度跟深度,再把 deploy on Sealos 反馈到社区。这种跟上下游开源项目之间的合作,大家都挺欢迎的。因为一方面 Sealos 有庞大的用户流量,可以给这个开源项目导流。另一方面,这个开源项目也可以为 Sealos 导流,所以是个完全互利互惠的事情。”

路漫漫其修远兮,这个小项目未来会如何,让我们拭目以待吧。

【创造者说】

OSCHINA 全新开源创企访谈栏目【创造者说】。

开源社区需要创造者,他可以是个人,也可以是由个人组成的公司。开源软件发展 20 余年,来自公司的开源贡献者已经成为中坚力量,更是有一批公司围绕开源软件而创办。本栏目将聚焦开源创企和他们的创始人,探讨当下的开源现状,分享开源商业故事,为开源社区添砖加瓦。

往期回顾:

一个技术人 “误入歧途”,做了个向量数据库新物种