UTT是Aliexpress的营销消息运营平台,运营希望促销活动时APP消息推送的QPS达到34W。

UTT刚接入APP消息推送时,QPS只能达到5W,离运营的要求有很大的距离。

通过改造,QPS达到了50W,其中最主要的改造是对Hbase的rowkey的改造。

首先介绍一下UTT大致工作流程:

1、运营人员在UTT的小二控制台配置运营任务(job),在任务中设置商品选择参数、目标人群参数和消息发送渠道;

2、UTT调用算法平台计算出要发送的消息,数据生成在阿里云飞天系统的云梯表中;

3、UTT把云梯表中的数据导入到hbase,并生成N个可以并发执行的发送任务(segment),segment的信息存储在mysql表中;

4、UTT按计划发送时间捞取segment,把存储在Hbase中的segment对应的消息读取出来调用阿里巴巴移动消息推送网关发送出去。

步骤1、2、3是提前执行的,我们要优化的是步骤4。

改造中,我们主要做了如下几件事:

1、修改了Hbase的rowkey规则和数据读取方式;

2、优化了记录发送进度的逻辑;

3、优化了消息发送到阿里巴巴移动消息推送网关的流程。

其中最主要的是对Hbase的rowkey的修改。

改造前的rowkey设计:

rowkey=segmentSalt+”_"+dataIndexInSegment+”_”+segmentId+”_”+jobTime+”_”+jobId

说明如下:

job:job对应运营在后台页面配置的任务,一个job可能多次运行,用jobId+jobTime可以唯一标识一个job的一次发送任务。

segment:一个job的一次发送任务拆分为多个segment,每个segment对应10万条消息。多个segment的消息可以并行发送。

segmentSalt:4位的随机字母,每个segment有一个salt,用于把数据均匀分散到Hbase的不同region中;

dataIndexInSegment:每条消息在segment中的序号,从0到99999;

改造前UTT按计划发送时间捞出要发送的segment后,从按0到99999的顺序从Hbase中读取消息,然后发送出去。为了提高效率使用了hbase的批量get方法。

这个设计存在一个很大的问题,同一个segment里的相邻消息的rowkey不是连续的,之间可能隔的非常远。

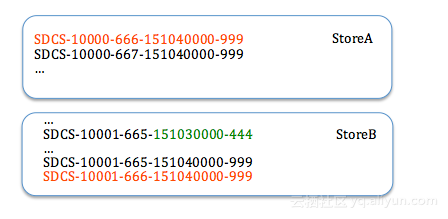

如下图所示,10000号消息rowkey和10000![989374447c7ce6789b3d46615d3dd320 989374447c7ce6789b3d46615d3dd320]()

1号消息rowkey之间可能隔了很多rowkey。

这会带来啥问题?这就需要了解Hbase的存储机制。

Hbase的存储是以storeFile为单位,以LSM树(Log-structured merge tree)方式存储。

此结构优化写性能,牺牲读性能。写数据的时候先按rowkey计算出region和store,顺序写入到store的memeStoreFile中,memoStoreFile达到指定大小后flush到磁盘的storeFile中。因此同一个store里,多个storeFile的rowkey的范围是会有重叠的。

按rowkey读取数据时,计算该rowkey可能存储的storeFile,把这些storeFile全部读取到内存中,最后把多个storeFile里查询到的结果合并后输出。

为了提高读性能,Hbase会在后台把多个storeFile进行merge,形成rowkey范围互不重叠的storeFile。

另外Hbase采用按列值KV方式存储数据,也就是说每个列的值都是独立存储的。每个列值KV对里的key包括了rowkey和列名,key里的大部分数据是重复的,storeFile采用压缩算法减小空间。

改造前同一个segment里的消息的rowkey很分散,读取一个segment的消息时要从磁盘上装载大量的storeFile,消耗大量的cpu进行解压缩,这也会导致storeFile 的cache命中率不高。并且读出来的大部分storeFile是没有包含所需数据的。

分析UTT的场景,多个segment是并发读写的,每个segment有segmentSalt,保证了读写均匀分布到Hbase的不同region。如果读取一个segment的消息时能从尽量少的storeFile读取数据,就能够减少磁盘IO,减少解压缩及数据查找的CPU,还能提高storeFile cache的命中率。

改造后的rowkey设计:

rowkey=segmentSalt+”_”+jobTime+”_”+jobId+”_”+segmentId+”_”+dataIndexInSegment(前补零到定长5位)

这样多个segment并发读写均匀分散到不同region,同一个segment的消息顺序写到相同的storeFile中,读取的时候不再使用get方法而是使用scan方法。最后qps提升了一个数量级。

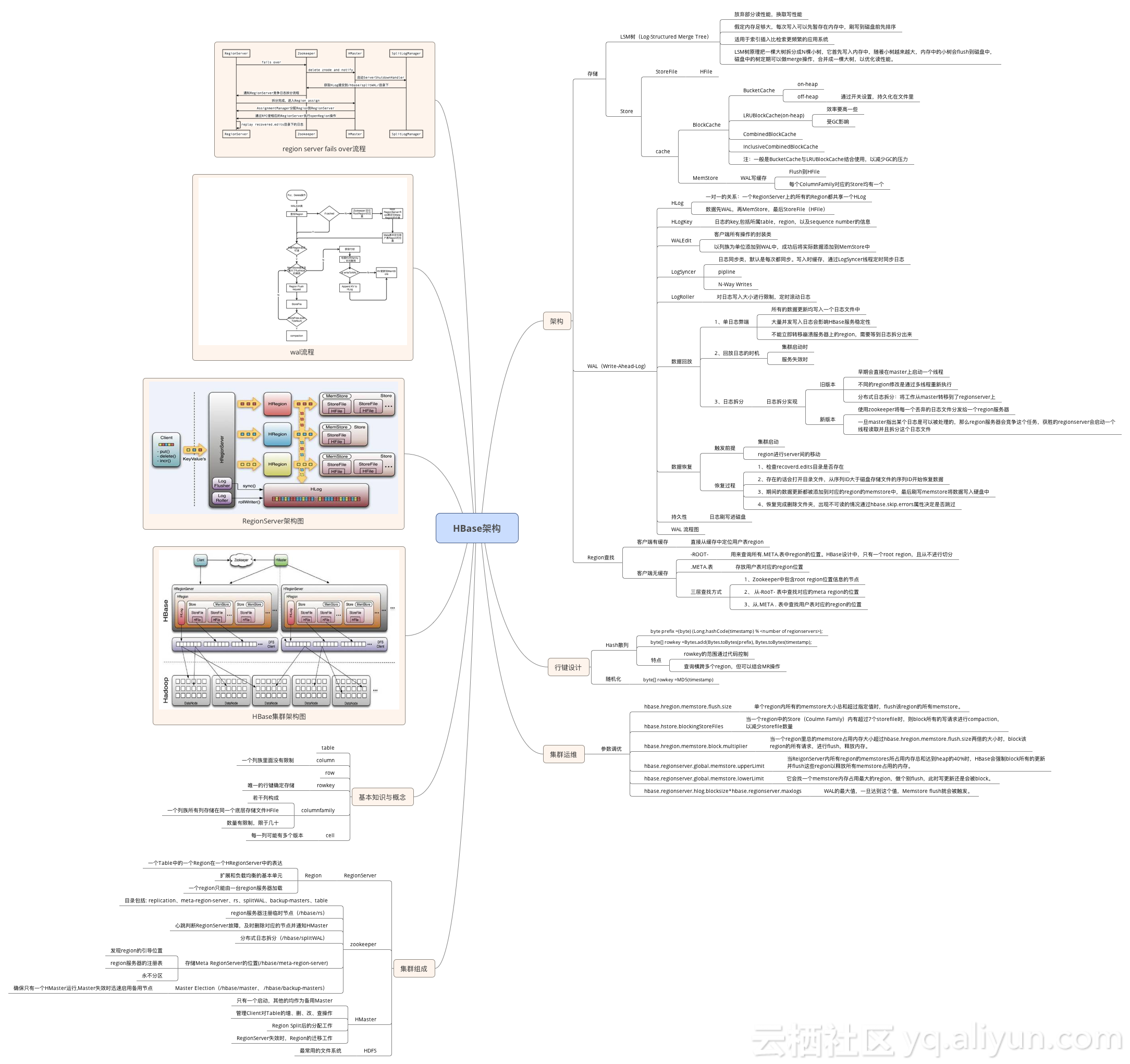

附一个hbase的知识脑图,不知道作者是谁,挺好的。

![a0a55482bb8c93edfedc2eb59c678424 a0a55482bb8c93edfedc2eb59c678424]()