《Spark大数据分析:核心概念、技术及实践》一3.5 API

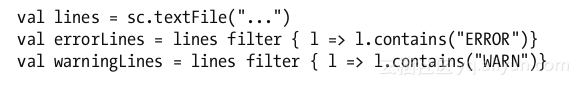

本节书摘来自华章出版社《Spark大数据分析:核心概念、技术及实践》一书中的第3章,第3.5节,作者[美] 穆罕默德·古勒(MohammedGuller),更多章节内容可以访问云栖社区“华章计算机”公众号查看。 3.5 API 应用可以通过使用Spark提供的库获得Spark集群计算的能力。这些库都是用Scala编写的。但是Spark提供了各种语言的API。在本书编写之际,Spark API提供了如下语言的支持:Scala、Java、Python和R。可以使用上面的任何语言来开发Spark应用。也有其他语言(比如Clojure)的非官方支持。 Spark API主要由两个抽象部件SparkContext和弹性分布式数据集(RDD)构成。应用程序通过这两个部件和Spark进行交互。应用程序可以连接到Spark集群并使用相关资源。接下来