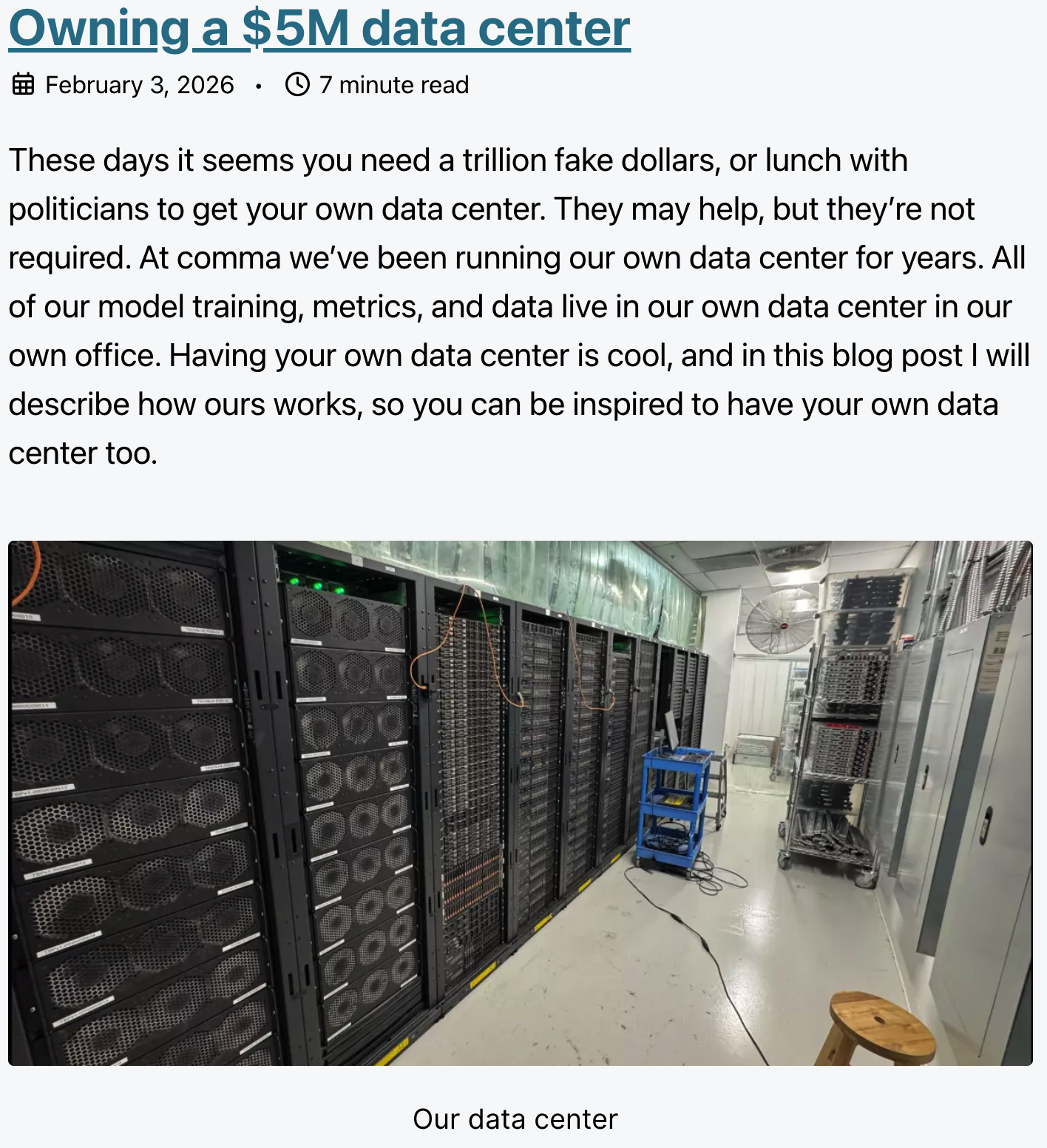

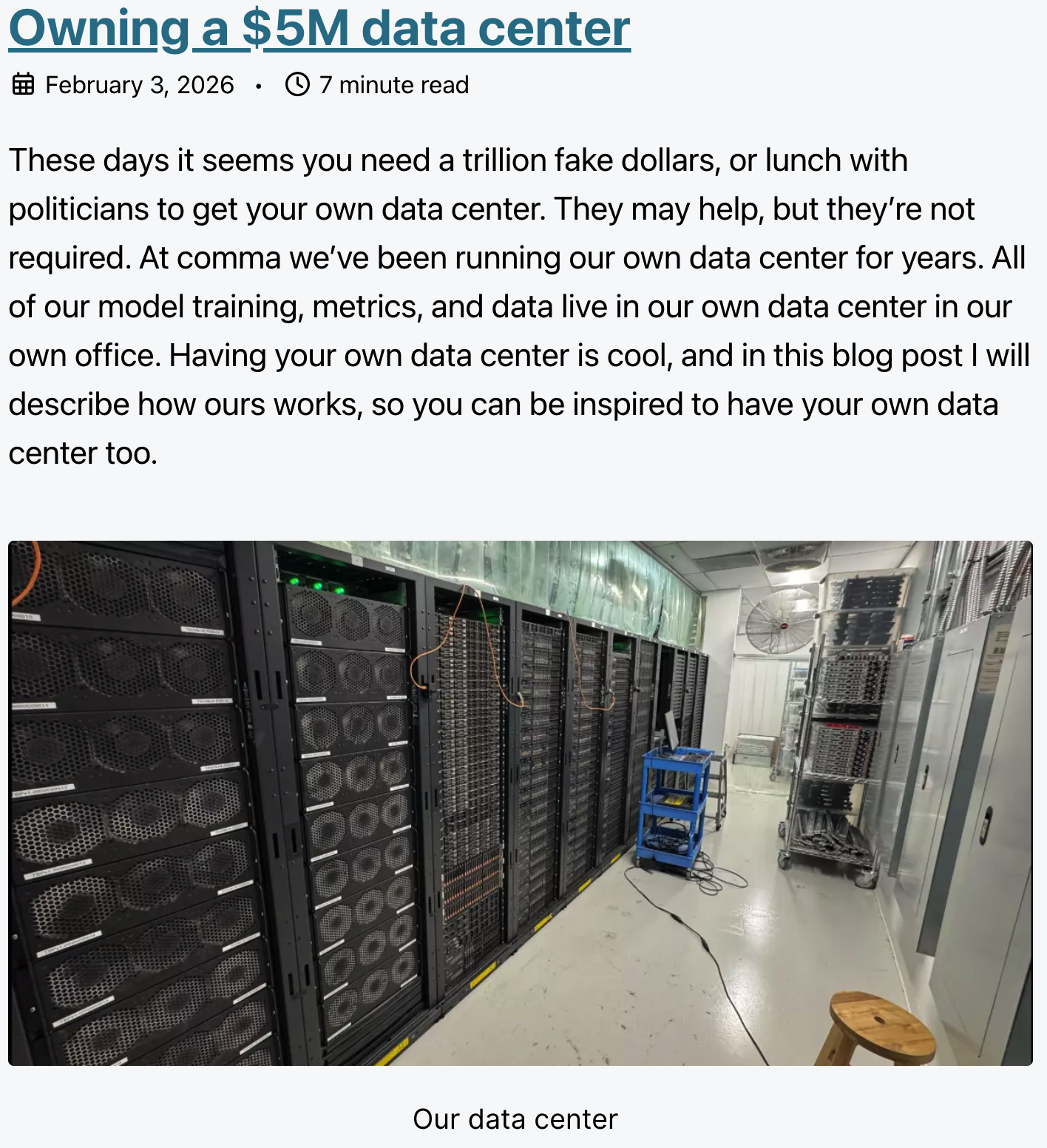

以开源自动驾驶技术 openpilot 闻名的美国AI 创企 comma.ai 近日发布技术博客透露,公司在自家办公室内部运营了一个自建的数据中心,用于支持其 AI 模型训练、指标分析与数据存储工作。

公司 CTO Harald Schäfer 表示,依赖公有云会把关键计算资源和数据流程托付给第三方供应商,这不仅会带来高额账单,还可能在转移或停止使用时遇到困难。而自有数据中心能促使工程团队直接面向电力消耗、计算效率和硬件性能等根本问题,而不是通过“增加预算”来解决问题。

comma.ai 数据中心的关键技术规格包括:

- 总投资规模约 500 万美元(如果在云端执行同等工作,估计成本会超过 2500 万美元)。

- 最大功率需求约 450 kW 电力,2025 年电费支出逾 54 万美元。

- 使用 San Diego 外部环境冷空气进行自然冷却,取代大量耗电的传统空调系统。

这种“自然通风”冷却策略在能耗控制上显著低于传统 CRAC(计算机房空调)方案,但对环境湿度和温度控制提出更高工程要求。

comma.ai 估算,如果将等量的计算工作放在公有云上,成本可能远高于自建运行。

comma.ai 数据中心的核心计算与存储设施如下:

- 75 台自制 TinyBox Pro 机器,总计约 600 张 GPU,同时用于训练与一般计算任务。

- 使用 Dell 服务器阵列构成约 4 PB SSD 存储,支持高速数据读写(存储阵列可达 20 Gbps)。

- 网络采用 3 个 100 Gbps 核心交换机与 Infiniband 互联,用于训练集群。

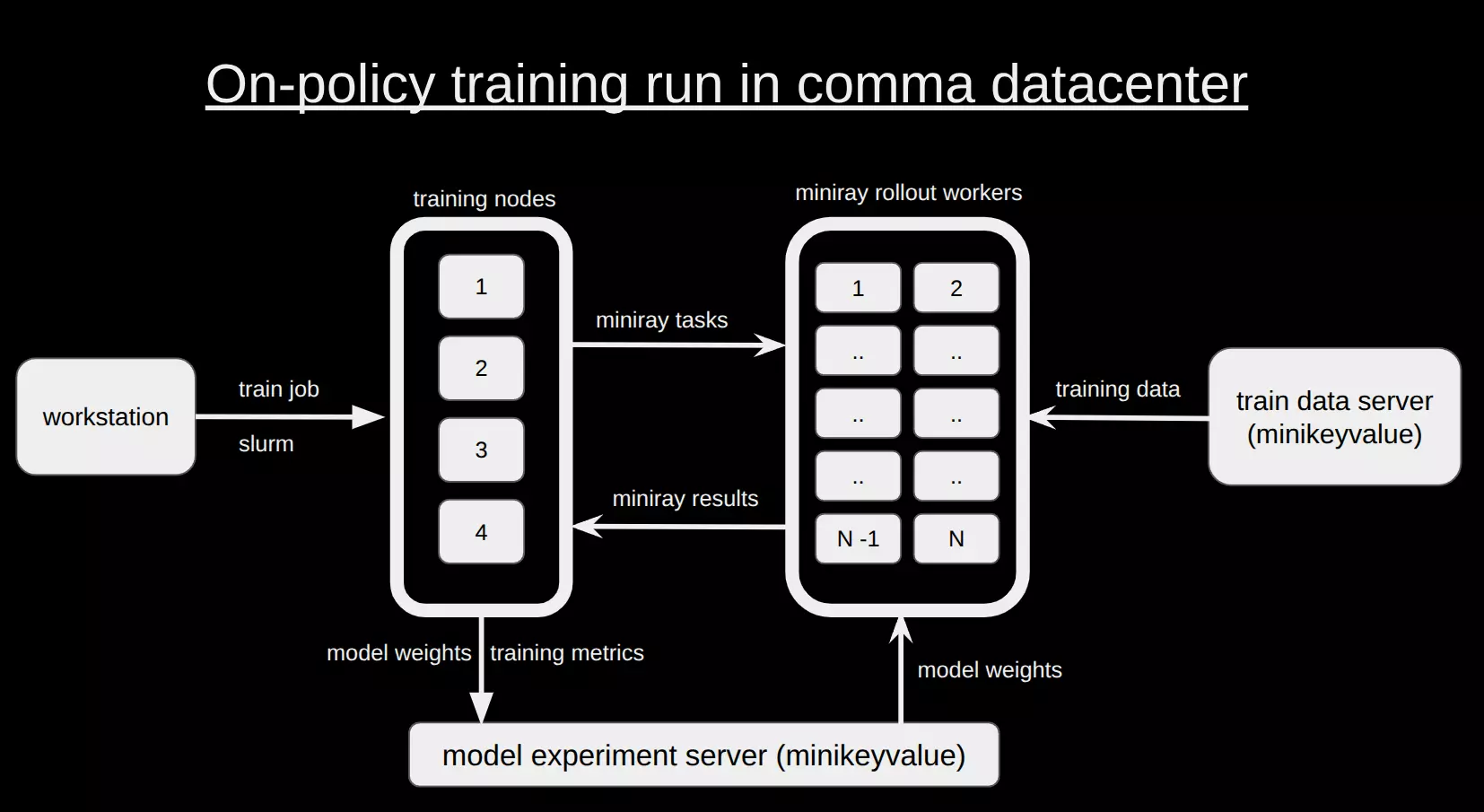

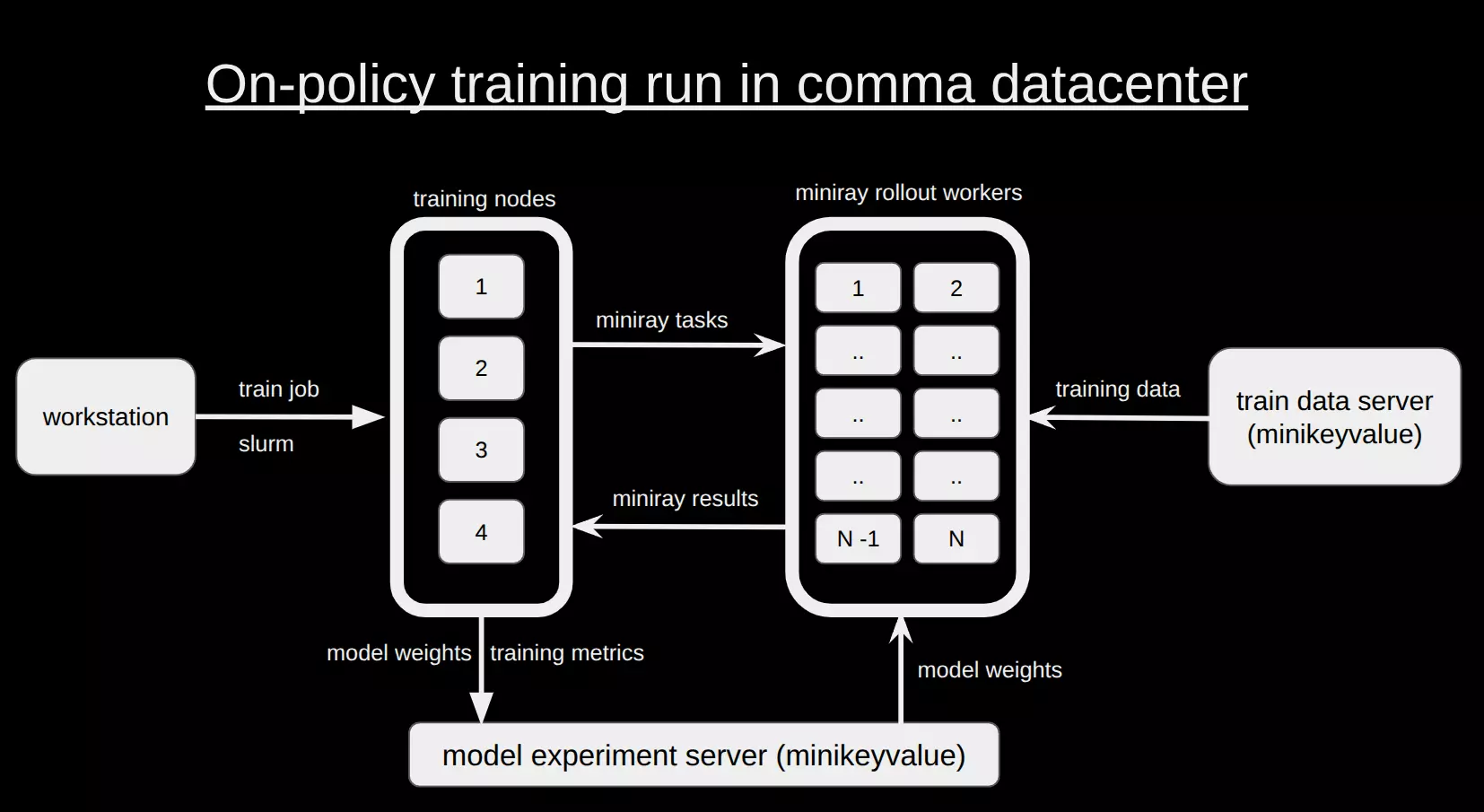

这种架构强调数据吞吐性能与训练规模,而不是纯粹的冗余容错性。为了高效利用这套硬件资源,comma.ai 构建了完整的软件生态,包含支持从训练、推理到开发调优的全流程基础设施。

- Slurm:调度分布式训练与其他任务。

- Minikeyvalue(mkv):自家分布式存储系统,支持每秒近 1 TB 数据读写,可直接在原始训练数据上操作。

- Miniray:轻量级任务调度器,可将任意 Python 负载分发到空闲节点,高效利用集群资源。

- 自研实验追踪系统:类似 WandB / TensorBoard,可实时追踪模型训练指标与元数据。

在 AI 训练成本持续攀升的当下,Comma.ai 公司给出了一个清晰的反问:

如果算力已经成为公司的核心生产资料,为什么要把它完全交给别人?

这条路并不适合所有公司,但它确实为自动驾驶和高强度 AI 研发,提供了一种值得认真对待的参考答案。对于一个依赖海量数据与模型迭代的自动驾驶公司来说,这是一项战略性投资。