蚂蚁集团旗下具身智能公司灵波科技正式开源高精度空间感知模型 LingBot-Depth。

据介绍,LingBot-Depth 是一种面向真实场景的深度补全模型,依托奥比中光 Gemini 330 系列双目 3D 相机进行 RGB-Depth 数据采集与效果验证,并基于深度引擎芯片直出的深度数据进行训练与优化,旨在将不完整且受噪声干扰的深度传感器数据转化为高质量、具备真实尺度的三维测量结果,提升环境深度感知与三维空间理解能力,为机器人、自动驾驶汽车等智能终端赋予更精准、更可靠的三维视觉。

LingBot-Depth 核心亮点

- 精准且稳定的相机深度感知

- 卓越的 3D 和 4D 环境感知能力

- 灵巧抓取操作适用于透明与反光物体

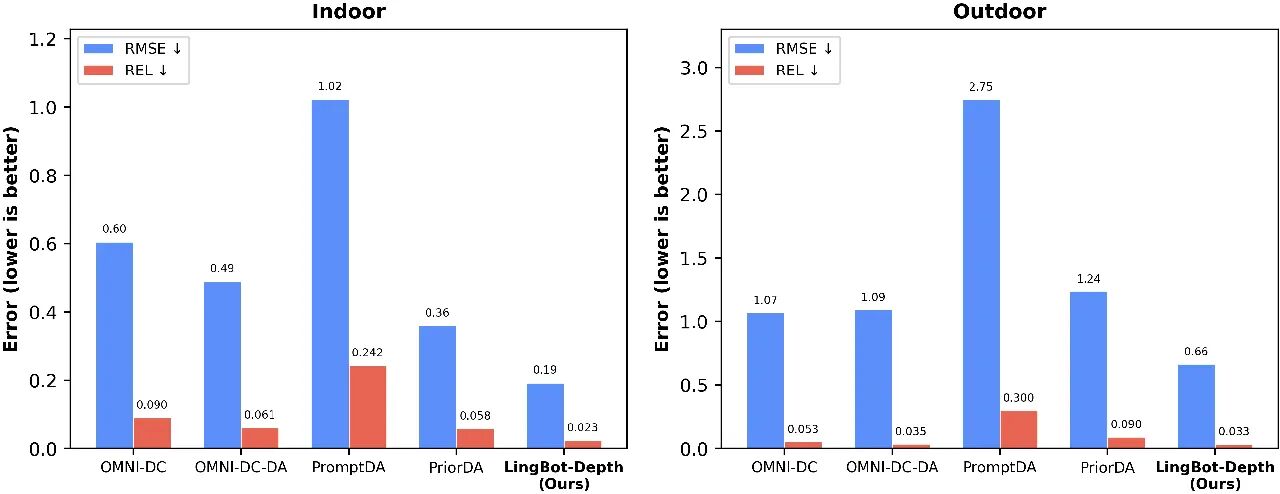

实验结果表明,该模型在深度精度与像素覆盖率两项核心指标上均超越业界顶级工业级深度相机。在 NYUv2、ETH3D 等多个基准测试中,LingBot-Depth 在深度补全、单目深度估计及双目匹配任务上均达到当前最优水平,并在无需显式时序建模的情况下保持视频级时间一致性。

LingBot-Depth 模型也已通过奥比中光深度视觉实验室的专业认证,在精度、稳定性及复杂场景适应性方面均达到行业领先水平。

![]()

在最具挑战的稀疏深度补全任务中,LingBot-Depth 性能整体优于现有多种主流模型。(图中数值越低代表性能越好。)下游任务验证进一步表明,模型能够在 RGB 与深度两种模态之间学习到对齐的潜在空间表征,从而实现对透明及反光物体的稳定机器人抓取。

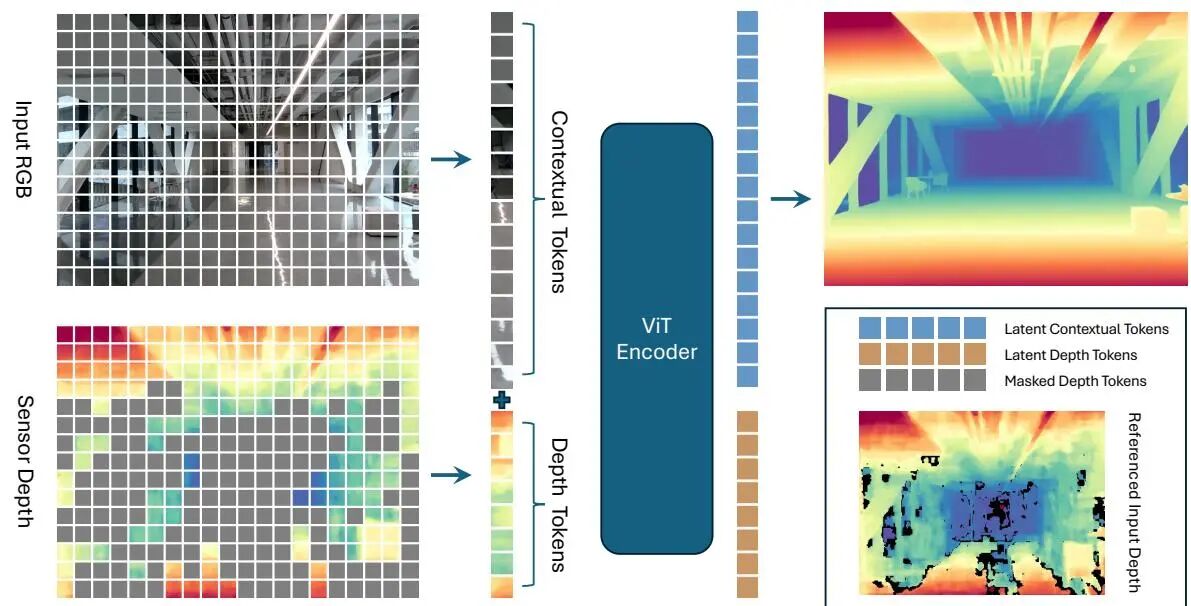

LingBot-Depth 研发团队介绍称,他们研发了“掩码深度建模”(Masked Depth Modeling,MDM)技术。虽然训练过程中使用海量 RGB–深度图像对,但刻意遮挡其中一部分深度区域,让模型仅根据 RGB 图像去预测缺失的深度值。随着训练进行,模型逐渐学会建立“外观—几何”之间的对应关系,也就是从“物体看起来像什么”推断“它大概有多远”。

![]()

LingBot-Depth 模型、代码、技术报告已全部开源:

Website:https://technology.robbyant.com/lingbot-depth

Model:https://huggingface.co/robbyant/lingbot-depth

Code:https://github.com/Robbyant/lingbot-depthTech

Report:https://github.com/Robbyant/lingbot-depth/blob/main/tech-report.pdf