阿里通义大模型团队正式开源发布 Qwen3-VL-Embedding 和 Qwen3-VL-Reranker 模型系列,这两个模型基于 Qwen3-VL 构建,专为多模态信息检索与跨模态理解设计,为图文、视频等混合内容的理解与检索提供统一、高效的解决方案。

![]()

两个模型系列均能在统一框架内处理文本、图像、可视化文档(图表、代码、UI组件......)、视频等多种模态输入。在图文检索、视频-文本匹配、视觉问答(VQA),多模态内容聚类等多样化任务中,均达到了业界领先水平。

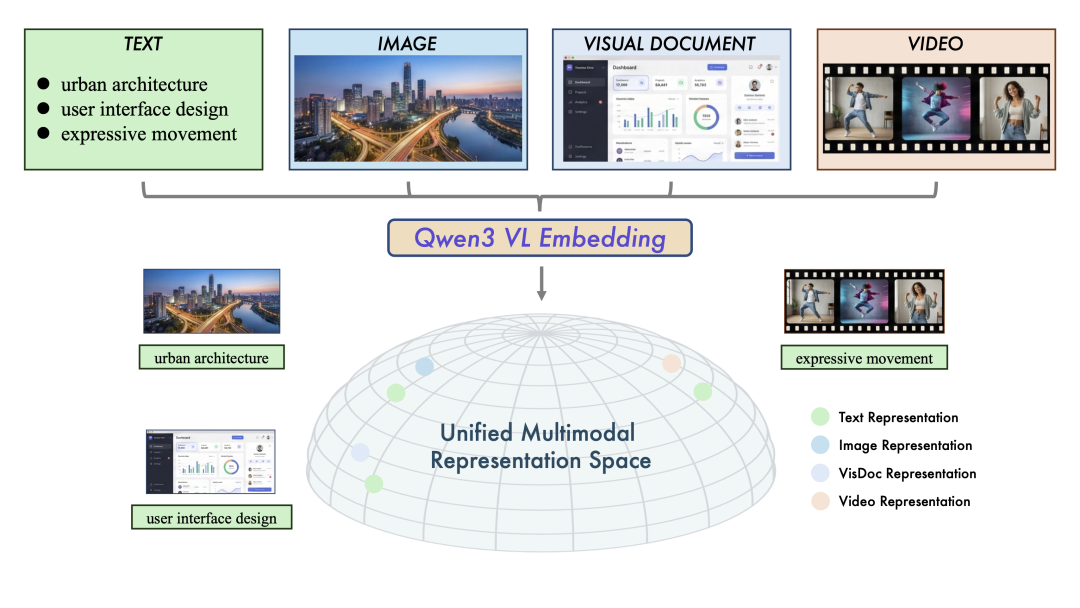

Qwen3-VL-Embedding 充分利用 Qwen3-VL 基础模型的优势,能够生成语义丰富的向量表示,将视觉与文本信息映射到同一语义空间中,从而实现高效的跨模态相似度计算与检索。

![]()

图1:统一多模态表示空间示意图。Qwen3-VL-Embedding模型系列将多源数据(文本、图像、视觉文档和视频)映射到共同的高维语义空间。

作为 Embedding 模型的补充,Qwen3-VL-Reranker 接收任意模态组合的查询与文档对(eg:图文查询匹配图文文档),输出精确的相关性分数。在实际应用中,二者常协同工作:Embedding 负责快速召回,Reranker 负责精细化重排序,构成“两阶段检索流程”,显著提升最终结果精度。

该系列继承了 Qwen3-VL 的多语言能力,支持超过 30 种语言,适合全球化部署。模型提供灵活的向量维度选择、任务指令定制,以及量化后仍保持的优秀性能,便于开发者集成到现有系统中。

![]()

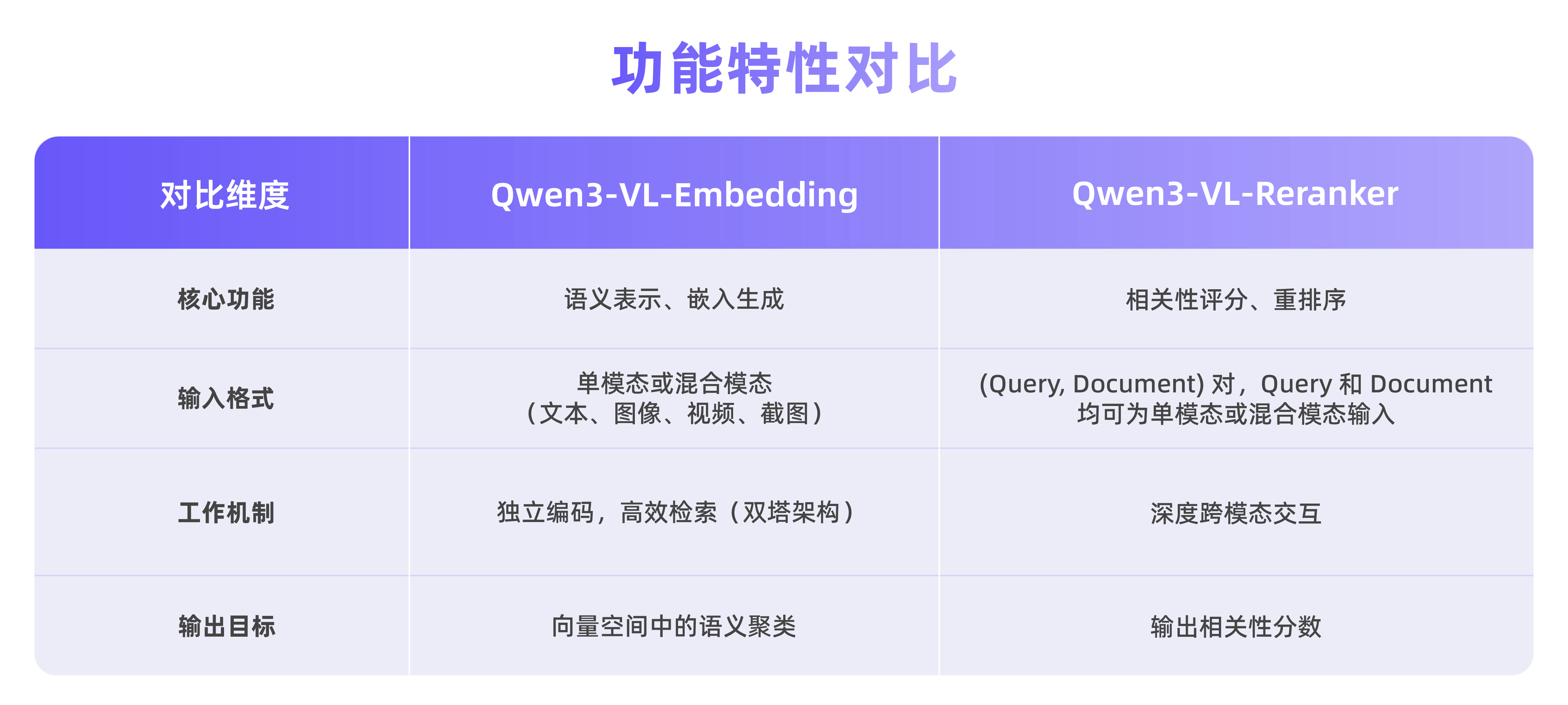

Qwen3-VL-Embedding 和 Qwen3-VL-Reranker 采用了不同的架构设计,分别针对检索流程的不同阶段进行优化。

![]()

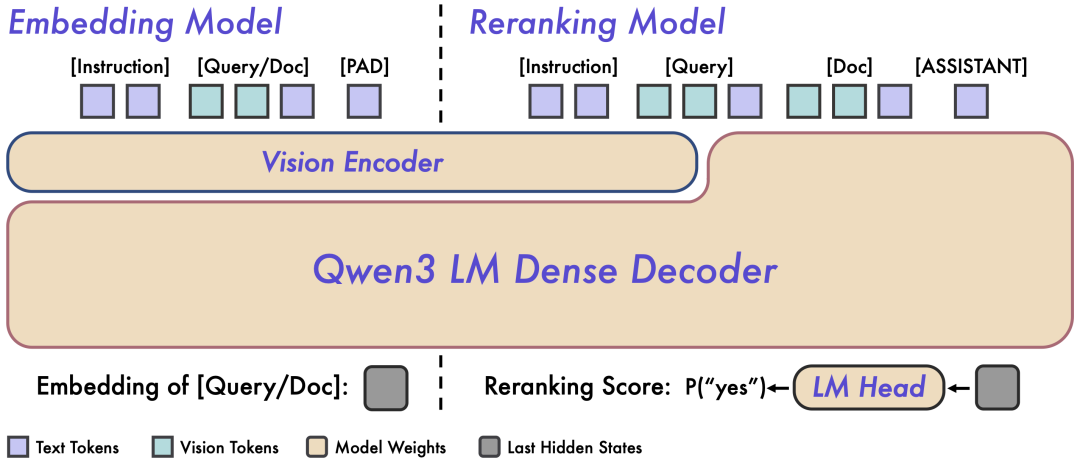

图 2:Qwen3-VL-Embedding 和 Qwen3-VL-Reranker 架构概览。左侧为 Embedding 模型的双塔独立编码架构,右侧为 Reranker 模型的单塔交叉注意力架构。

Qwen3-VL-Embedding 采用双塔架构,可以高效地将不同模态的内容独立编码为统一的向量表示,特别适合处理海量数据的并行计算。

Embedding 模型接收单模态或混合模态输入,并将其映射为高维语义向量。我们提取基座模型最后一层中对应 [EOS] token 的隐藏状态向量,作为输入的最终语义表示。这种方法确保了大规模检索所需的高效独立编码能力。

Qwen3-VL-Reranker 采用单塔架构,通过内部的交叉注意力机制,深度分析查询与文档之间的语义关联,从而输出精确的相关性分数。

在实际工作中,Reranking 模型接收输入对 (Query, Document) 并进行联合编码。它利用基座模型内的交叉注意力机制,实现 Query 和 Document 之间更深层、更细粒度的跨模态交互和信息融合。模型最终通过预测两个特殊 token(yes 和 no)的生成概率来表达输入对的相关性分数。

GitHub 仓库:

https://github.com/QwenLM/Qwen3-VL-Embedding

魔搭 ModelScope:

https://modelscope.cn/collections/Qwen/Qwen3-VL-Embedding

https://modelscope.cn/collections/Qwen/Qwen3-VL-Reranker