近日,生数科技与清华大学 TSAIL 实验室联合发布并开源视频生成加速框架:TurboDiffusion。

开源地址:https://github.com/thu-ml/TurboDiffusion

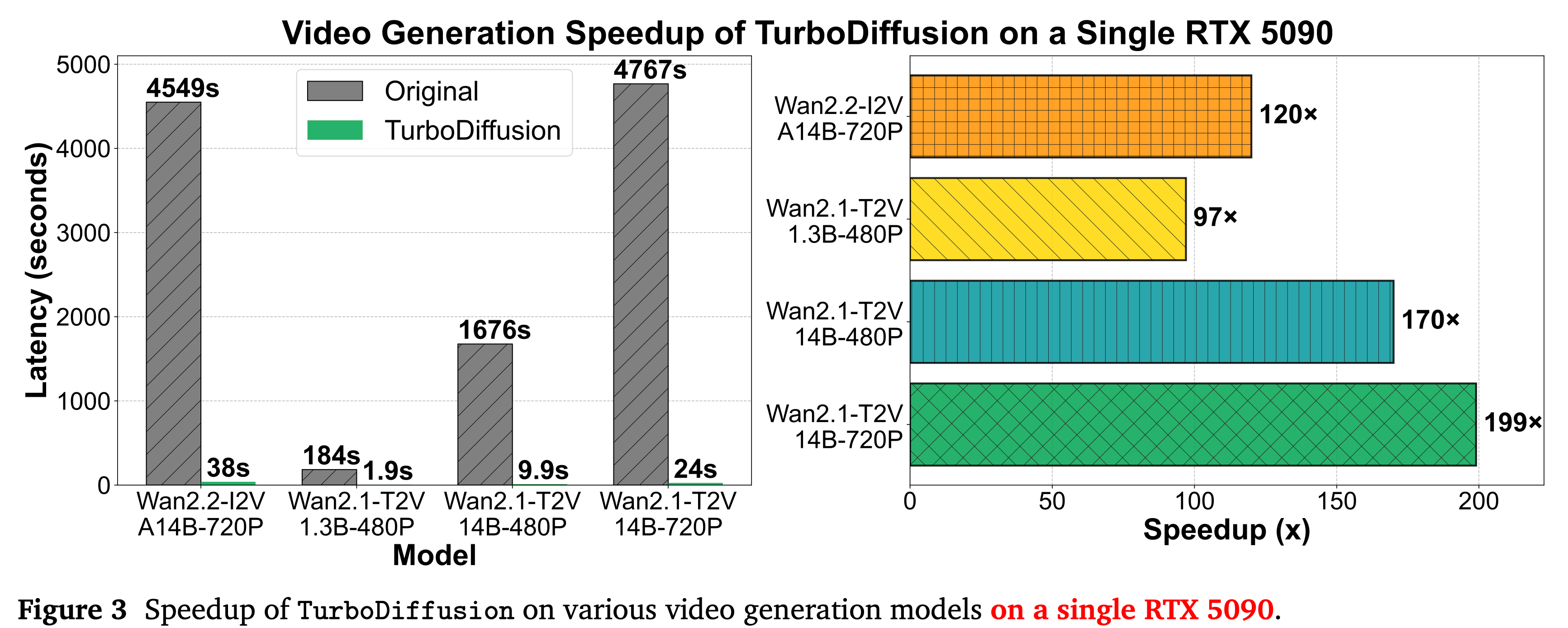

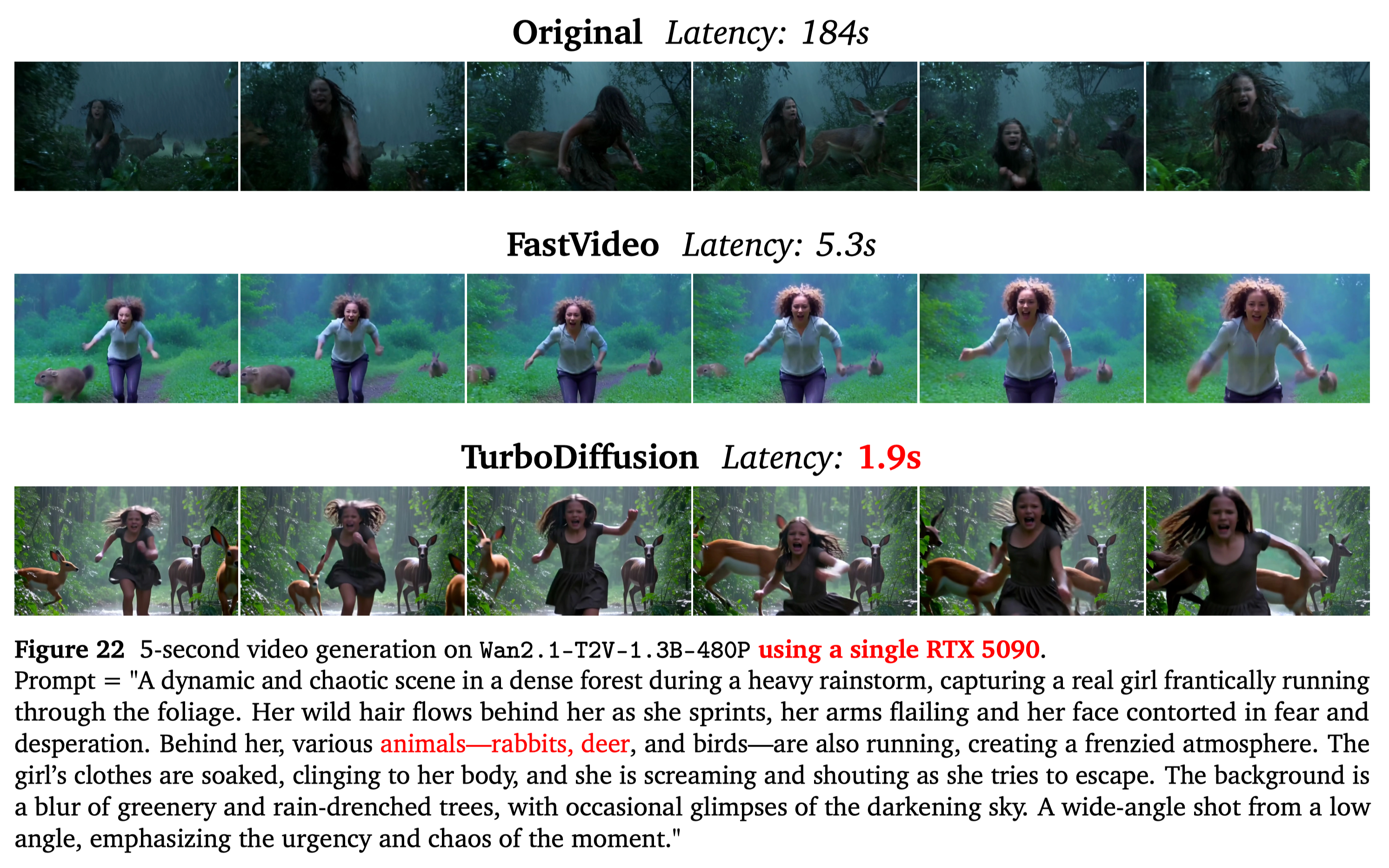

据介绍,在几乎不影响生成质量的前提下,该框架可实现最高达200倍的视频生成推理加速。TurboDiffusion的核心技术优势精准击中了视频生成领域的一个关键转折点。此前,视频扩散模型虽然具备强大的创造能力,但始终受限于计算复杂度高、效率受限的状态。

![]()

![]()

不同于单点优化方案,TurboDiffusion 通过多项关键技术的协同配合,从模型计算方式、注意力机制以及推理流程等多个层面,对视频生成进行整体提速。

TurboDiffusion 并非单一优化,而是通过多项前沿加速技术的系统化组合:

-

低比特注意力加速 采用 SageAttention 将注意力的计算执行在低比特的 Tensor Core 上,以无损且数倍地加速注意力计算。

-

稀疏-线性注意力加速 采用可训练的稀疏注意力 Sparse-Linear Attention (SLA) 进行注意力的稀疏加速,最高可在 SageAttention 的基础上进一步实现 17-20 倍的注意力稀疏加速。

-

采样步数蒸馏加速 通过目前最先进的蒸馏方法 rCM,让模型仅用 3-4 步即可完成高质量的视频生成。

-

线性层加速 将模型的线性层中的参数以及激活都进行8 比特的128x128的块粒度量化,即通过 W8A8 不仅加速模型的线性层计算,也大幅减少了模型的显存占用。

TurboDiffusion的发布,在保持高质量输出的前提下大幅压缩生成速度,首次让高质量视频生成逼近实时交互的可行区间,被视为视频大模型发展的 “DeepSeek Moment”,推动行业从“技术探索期”加速迈向“规模化与商业化落地阶段”,也标志着 AI 视频创作正式迈入“实时生成”时代。

参考链接:

TurboDiffusion:https://github.com/thu-ml/TurboDiffusion

SageAttention:https://github.com/thu-ml/SageAttention

Sparse-Linear Attention:https://github.com/thu-ml/

SLArCM:https://github.com/NVlabs/rcm