MiniMax M2.1 已正式发布,官方公告写道:

在 M2.1 中,我们致力于提升真实世界复杂任务中的表现:重点聚焦于更多编程语言和办公场景的可用性,并在这个领域做到最好的水平。

MiniMax M2.1 具体模型亮点如下:

-

卓越多编程语言能力:在 M2.1 中,我们系统性提升了 Rust / Java / Golang / C++ / Kotlin / Objective-C / TypeScript / JavaScript 等语言的能力,多语言任务整体表现达到业内领先水平,覆盖从底层系统到应用层开发的完整链路。

-

WebDev 与 AppDev:针对业界普遍存在的移动端开发短板,M2.1 显著加强了原生 Android / iOS 开发能力。 同时,我们系统性提升了模型在 Web 与 App 场景中的设计理解与美学表达能力,能够出色地构建复杂交互、3D 科学场景模拟与高质量可视化表达,推动 vibe coding 成为可持续、可交付的生产实践。

-

复合指令约束提升,办公场景变为可能:作为开源模型中率先系统性引入 Interleaved Thinking 的模型系列,M2.1 systematic problem-solving 能力再次升级。模型不仅关注代码执行是否正确,同时关注模型对“复合指令约束”的整合执行能力,在真实办公场景具备更高的可用性。

-

更简洁高效的回复:相比 M2,MiniMax M2.1 的模型回复以及思维链更加简洁,在实际编程与交互体验中,响应速度显著提升,Token 消耗明显下降,在 AI Coding 与 Agent 驱动的连续工作流中更加流畅和高效。

-

出色的 Agent / 工具脚手架泛化能力:M2.1 在各类编程工具与 Agent 框架中均有出色表现。在 Claude Code、Droid(Factory AI)、Cline、Kilo Code、Roo Code、BlackBox 等工具中展现一致且稳定的效果,并对 Skill.md、Claude.md / agent.md / cursorrule、Slash Command 等 Context Management 机制提供可靠支持。

-

高质量对话和写作:M2.1 不再只是“代码能力更强”,在日常对话、技术说明与写作场景中,也能提供更具细节与结构性的回答。

![]()

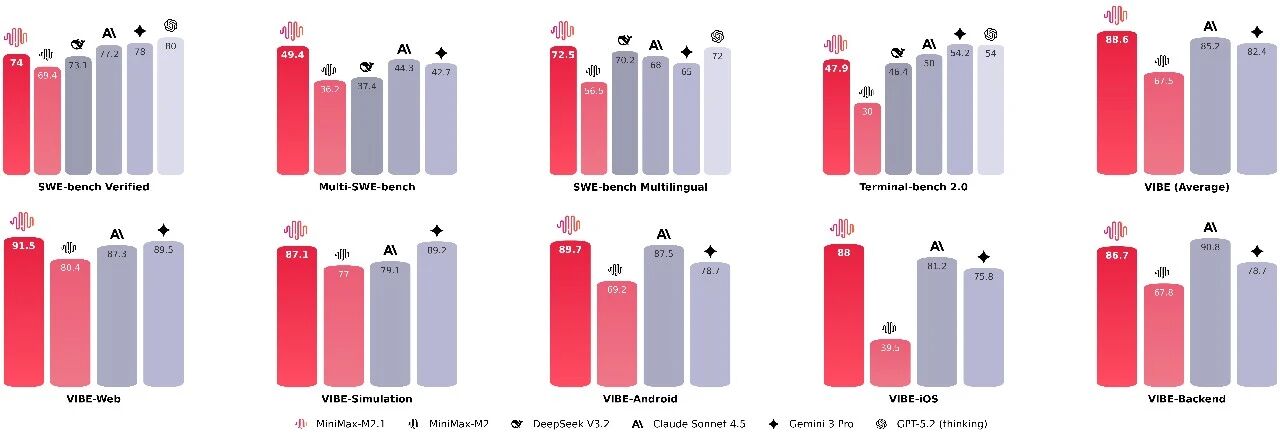

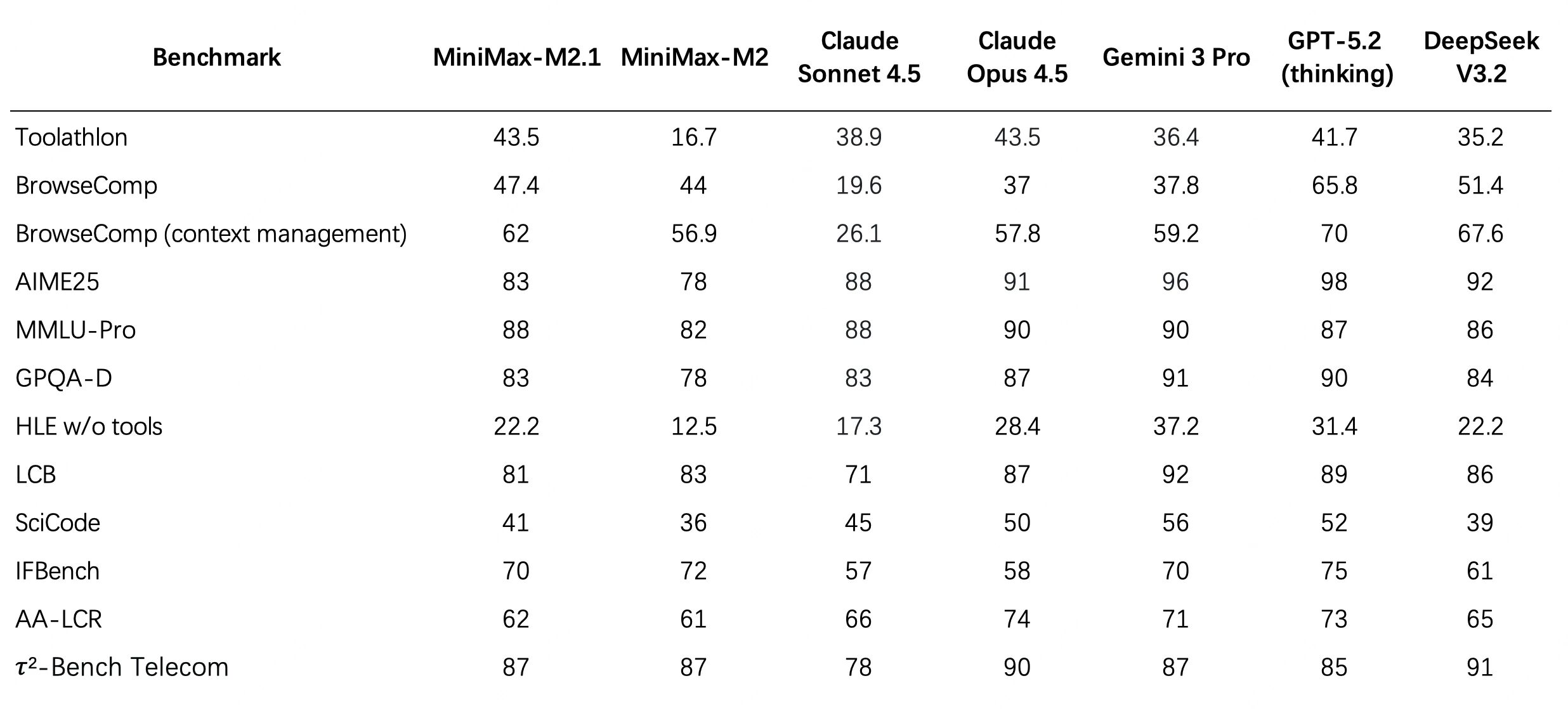

基准测试概览

在软件工程相关场景的核心榜单上,MiniMax M2.1 相比于 M2 有了显著的提升,尤其是在多语言场景上,超过 Claude Sonnet 4.5 和 Gemini 3 Pro,并接近 Claude Opus 4.5。

![]()

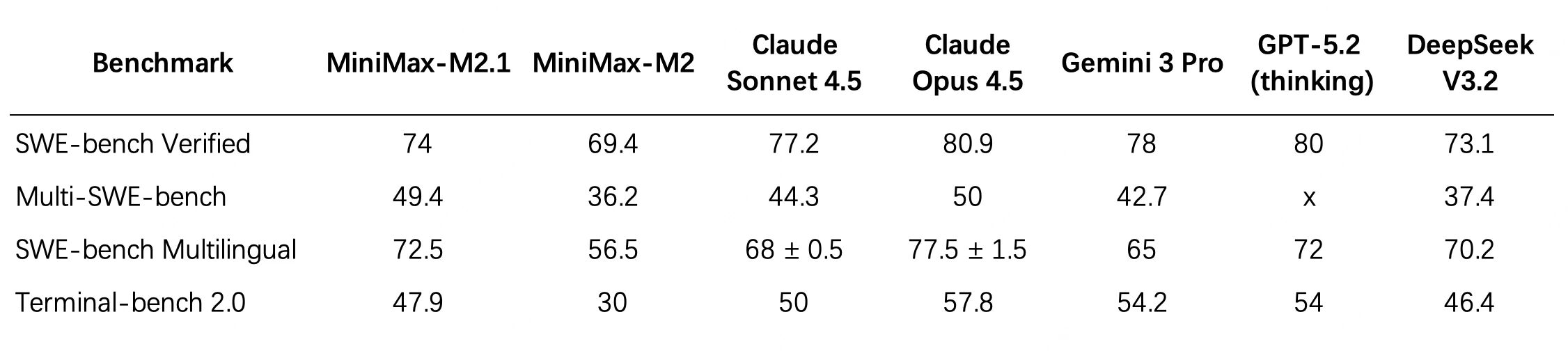

我们在不同 coding agent 框架上测试了 SWE-bench Verified,结果表明 MiniMax M2.1 具有良好的框架泛化性和稳定的表现。而在公开的测试用例生成、代码性能优化,以及自建的代码审阅(SWE-Review)、指令遵从(OctoCodingBench)等细分场景的榜单上,MiniMax M2.1 相比 M2 都表现出了全面的提升,持平或超过 Claude Sonnet 4.5。

![]()

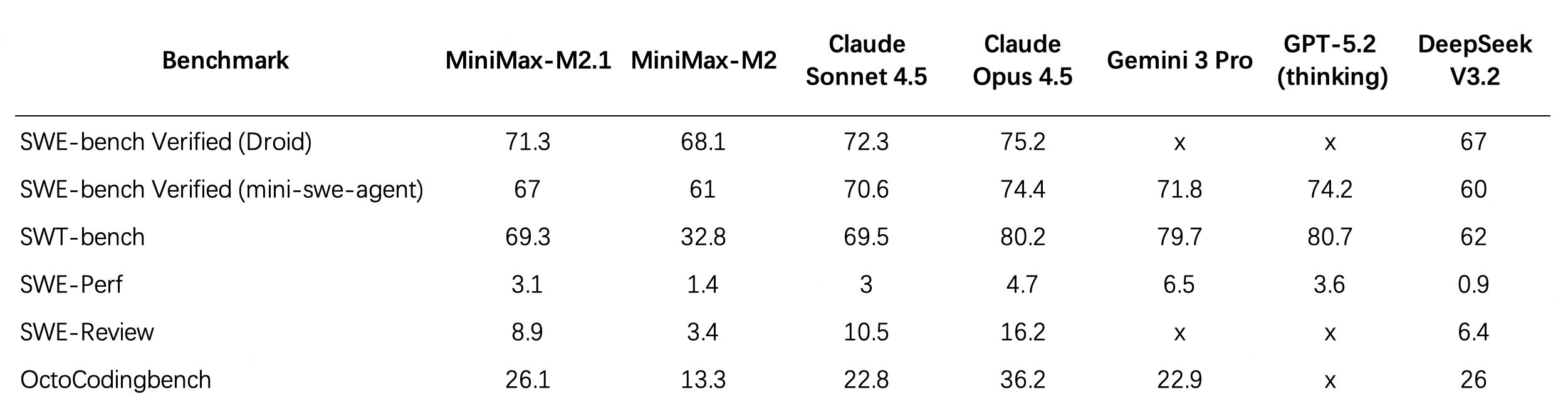

为了衡量模型“从零到一”构建完整、可运行应用程序的全栈能力,我们构建并开源了全新基准 VIBE (Visual & Interactive Benchmark for Execution in Application Development),涵盖了 Web、仿真 (Simulation)、Android、iOS 及后端 (Backend) 五大核心子集。不同于传统基准,通过创新的 Agent-as-a-Verifier (AaaV) 范式,VIBE 能够自动评估生成的 Application 在真实运行环境中的交互逻辑与视觉美感。这个评测集稍后将在 Github 上开源。

VIBE:https://huggingface.co/datasets/MiniMaxAI/VIBE

MiniMax-M2.1 在 VIBE 综合榜单中表现卓越,以平均 88.6 分的成绩展现了接近 Claude Opus 4.5 的全栈构建能力,并在几乎所有子集上都显著优于 Claude Sonnet 4.5。

![]()

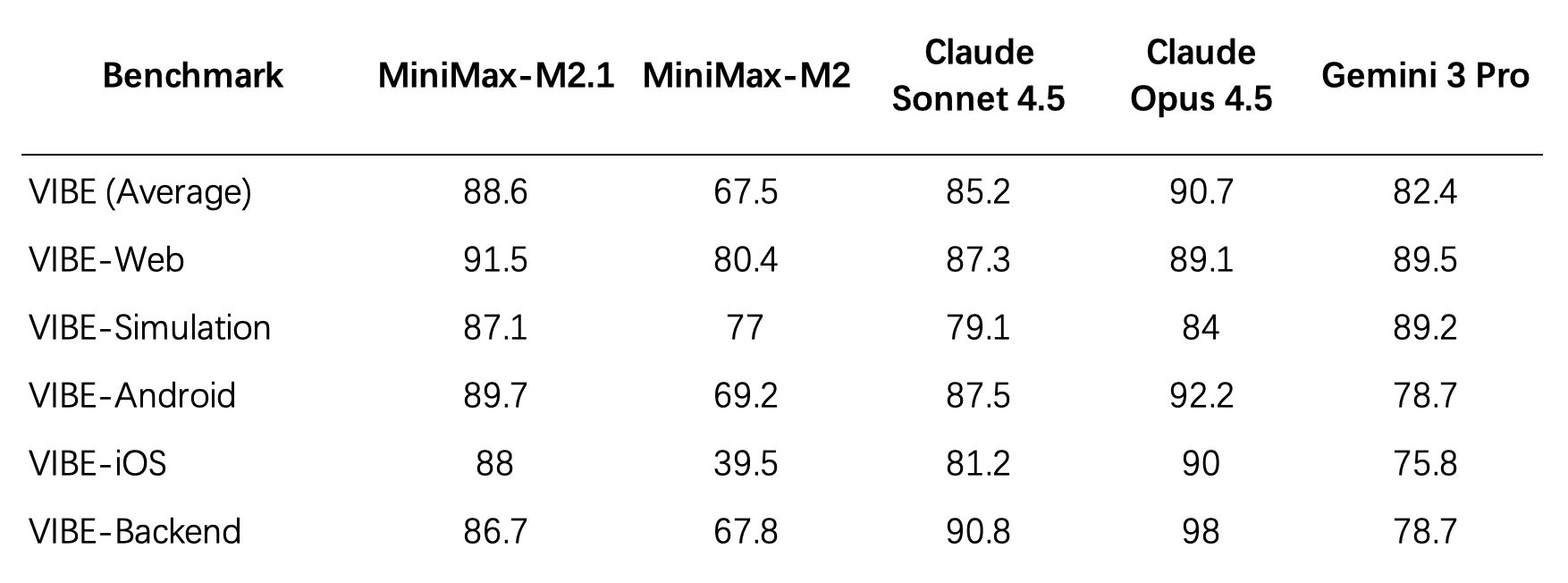

在办公场景、长程工具调用和综合智能指数上,MiniMax M2.1 相比 M2 也表现出稳步提升,体现了模型解决更多真实世界复杂任务的能力。

![]()

如何使用

MiniMax M2.1 API 已在开放平台上线:https://platform.minimaxi.com/docs/guides/text-generation

基于 MiniMax M2.1 的通用 Agent 产品 MiniMax Agent 现已全面开放使用:https://agent.minimaxi.com/

开源以及本地部署使用:https://huggingface.co/MiniMaxAI/MiniMax-M2.1 (为了保证 M2.1 的使用精度,我们在与多个部署平台对齐测试,并在几天后全面开源权重)

![]()