腾讯混元世界模型1.5(Tencent HY WorldPlay)已正式发布,公告写道:

它是易于创建的:

只需输入文字描述或者图片即可创建专属的互动世界。

它是沉浸式实时交互的:

通过键盘、鼠标或手柄,即可实时控制虚拟相机的移动和转向,让你可以像玩游戏一样自由探索AI生成的世界。

它也是直接可用的:

在腾讯混元3D官网可申请使用(https://3d.hunyuan.tencent.com/sceneTo3D?tab=worldplay)。

它还是开源的:

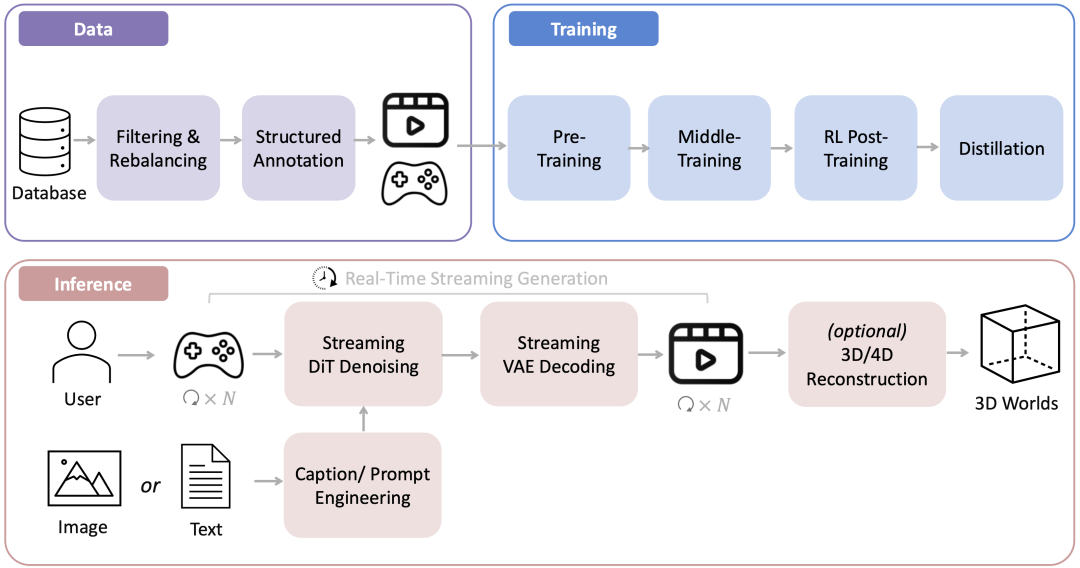

混元世界模型1.5(WorldPlay)首次开源了业界最系统、最全面的实时世界模型框架,涵盖数据、训练、流式推理部署等全链路、全环节,并提出了重构记忆力、长上下文蒸馏、基于3D的自回归扩散模型强化学习等算法模块。

![]()

混元世界模型1.5具备三大核心能力:

- 实时的交互生成:通过原创的Context Forcing蒸馏方案以及流式推理优化,模型可以按照24 FPS的速度生成720P的高清视频;

- 长范围的3D一致性:通过重构记忆机制(Reconstituted Memory),模型支持分钟级内容的几何一致性生成,可用于构建高质量的3D空间模拟器;

- 多样化的交互体验:混元世界模型可广泛适用于不同风格的游戏或者现实场景,以及第一和第三人称视角,也支持实时文本触发事件和视频续写等功能。

技术上,混元世界模型1.5首次开源了业界最系统、最全面的实时世界模型训练体系,涵盖数据、训练、推理部署等全链路、全环节。混元团队在技术报告中公开了模型预训练、持续训练、自回归视频模型强化学习、带记忆力的模型蒸馏的训练细节,并详述模型在控制(control space),记忆(reconstituted memory),蒸馏(context forcing),强化学习后训练几大模块上的思考与原创设计。

![]()

混元世界模型1.5的核心是一个叫做WorldPlay的自回归扩散模型,它采用Next-Frames-Prediction的视觉自回归任务进行训练,实现了长范围几何一致性的实时交互式世界建模,破解了业界满足实时性与几何一致性的难题。

该模型依托三大核心创新:双分支动作表征实现精准控制、上下文记忆重构机制保持几何一致性、上下文对齐蒸馏技术增强长视频生成的视觉质量和几何一致性。除此之外,该工作也构建了一套新颖的基于3D奖励的强化学习后训练框架来进一步增强生成视频的视觉质量和几何一致性。

数据方面,混元团队构建的自动化3D场景渲染流程,可以获得大量高质量的真实世界渲染数据,进一步激发核心算法的潜力。混元世界模型1.5可支持 24帧 / 秒的长时流式生成,一致性与泛化能力适用于多样化场景。

在线体验网站:https://3d.hunyuan.tencent.com/sceneTo3D?tab=worldplay

Github链接:https://github.com/Tencent-Hunyuan/HY-WorldPlay

Hugging Face链接:https://huggingface.co/tencent/HY-WorldPlay

项目主页:https://3d-models.hunyuan.tencent.com/world/