智谱AI正式开源GLM-4.6V系列多模态大模型,包含高性能版GLM-4.6V(106B-A12B)与轻量免费版GLM-4.6V-Flash(9B)。该系列实现“图像即参数,结果即上下文”的原生多模态工具调用能力,支持128K视觉上下文,可处理约150页文档或1小时视频。

![]()

- GLM-4.6V(106B-A12B):面向云端与高性能集群场景的基础版;

- GLM-4.6V-Flash(9B):面向本地部署与低延迟应用的轻量版。

作为 GLM 系列在多模态方向上的一次重要迭代,GLM-4.6V 将训练时上下文窗口提升到 128k tokens,在视觉理解精度上达到同参数规模 SOTA,并首次在模型架构中将 Function Call(工具调用)能力原生融入视觉模型,打通从「视觉感知」到「可执行行动(Action)」的链路,为真实业务场景中的多模态 Agent 提供统一的技术底座。

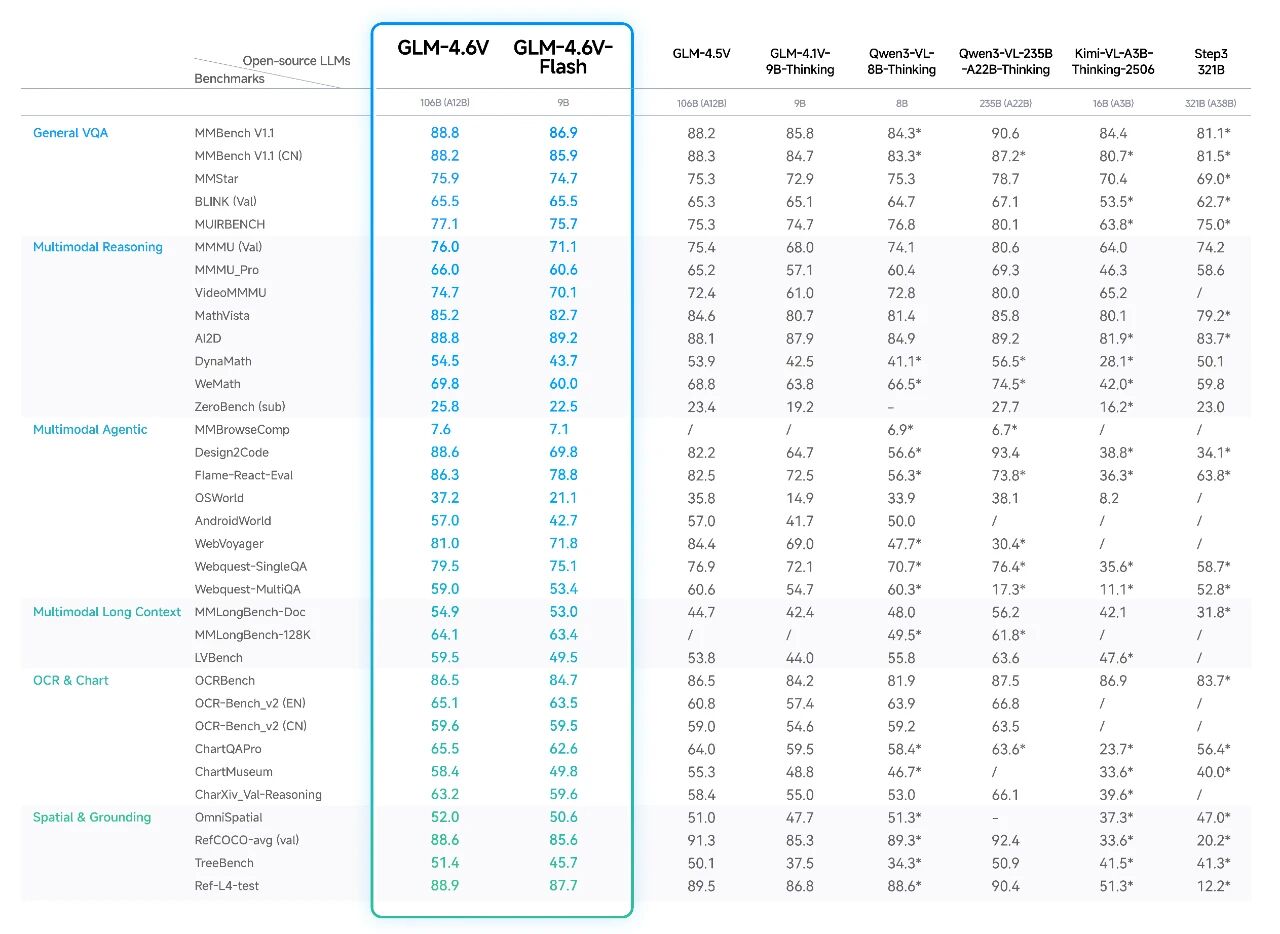

模型在30余项多模态基准评测中达同规模SOTA水平,API价格较上一代降低50%。典型应用涵盖智能图文生成、视觉导购Agent、前端代码复刻及长视频理解。模型权重与代码已在GitHub、Hugging Face及魔搭社区同步开放。

![]()

![]()

开源与部署

为了让更多开发者和研究者快速上手,智谱同步开放了模型权重、推理代码与在线调用能力。

开源资源

GLM-4.6V 的模型权重、推理代码与示例工程:

- GitHub:https://github.com/zai-org/GLM-V

- Hugging Face:https://huggingface.co/collections/zai-org/glm-46v

- 魔搭社区:https://modelscope.cn/collections/GLM-46V-37fabc27818446

已支持的推理框架包括 SGLang、vLLM、transformers、xLLM Ascend NPU,开发者可以在 GPU 与多种国产 NPU 环境下按需部署 GLM-4.6V 与 GLM-4.6V-Flash。

开放平台与在线调用

除了本地部署,智谱也提供云端托管推理与 API,方便直接接入业务:

- 开放平台:https://docs.bigmodel.cn/cn/guide/models/vlm/glm-4.6v

- Coding Plan 视觉理解 MCP:https://docs.bigmodel.cn/cn/coding-plan/mcp/vision-mcp-server

在线体验入口:

- z.ai:选择 GLM-4.6V 模型,即刻体验多模态理解与工具调用能力;

- 智谱清言 APP / 网页版:上传图片或视频,开启「推理模式」,体验多模态推理与长上下文能力。

技术 blog:z.ai/blog/glm-4.6v