中国 AI 独角兽公司稀宇科技上周发布并开源其新一代文本大模型 MiniMax-M2:

- 顶级代码能力:专为端到端开发工作流打造,在 Claude Code、Cursor、Cline、Kilo Code、Droid 等多种应用中表现卓越

- 强大 Agentic 表现:出色规划并稳定执行复杂长链条工具调用任务,协同调用 Shell、Browser、Python 代码执行器和各种 MCP 工具

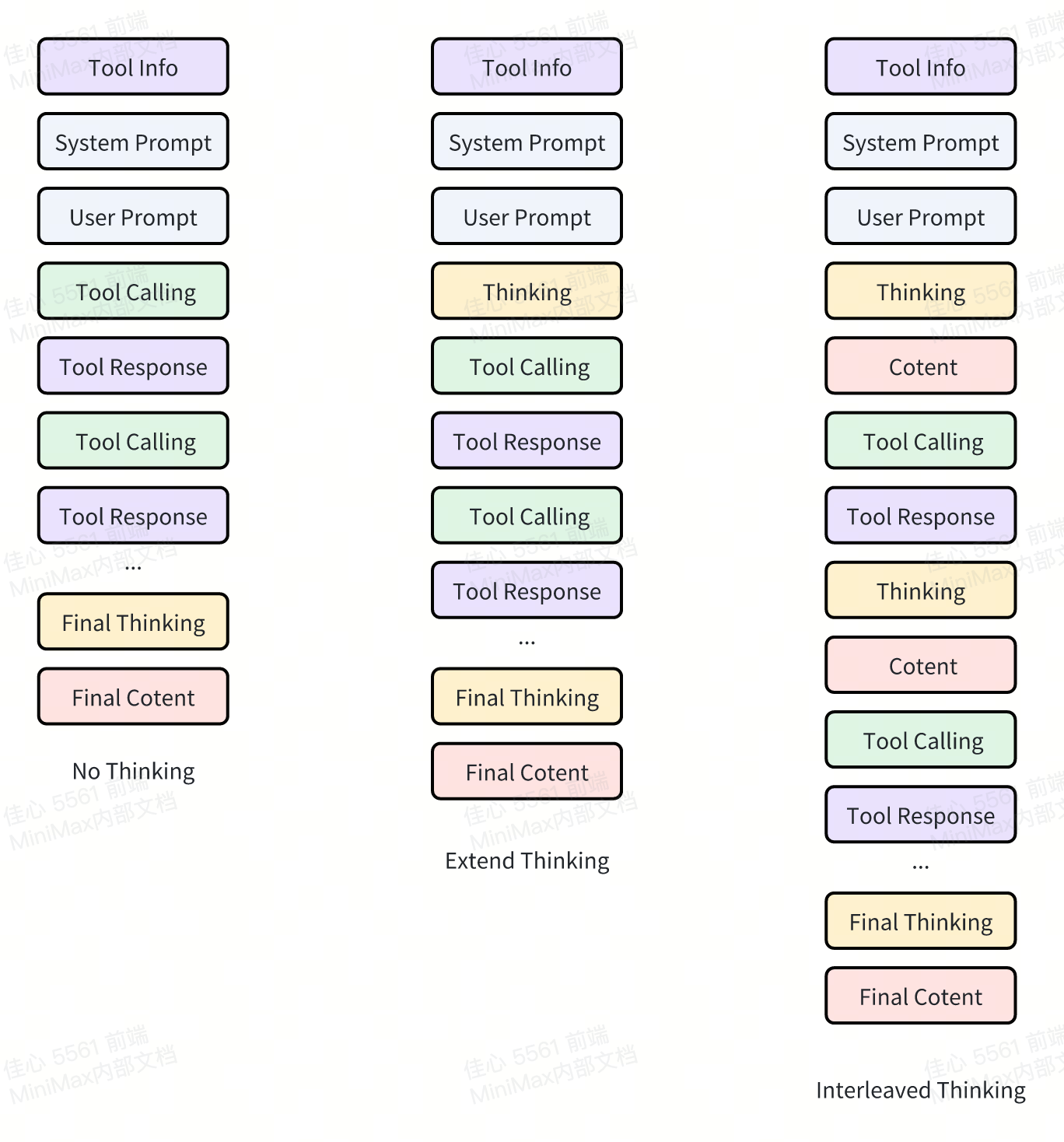

其团队表示,在 M2 研发的早期阶段,他们就发现了 Interleaved Thinking(交错思维链)在 Agent 和 Coding 应用中的重要性。

除 Anthropic Claude 外,目前大多数模型还未完全支持 Interleaved Thinking,它仍是业内的非共识。从用户反馈中我们也注意到,Interleaved Thinking 在实际应用中有时并未被正确使用。

为什么 Interleaved Thinking 重要,以及如何在不同 API 接口中有效地使用 Interleaved Thinking 以获得最佳效果?

下文是 MiniMax 对“Interleaved Thinking”的内部思考。

为什么 Interleaved Thinking 如此重要?

Interleaved Thinking 对 Agent 至关重要:它指在显式推理(reasoning)与工具调用(tool use)之间交替进行,并把推理结果持续带入后续步骤。这一过程能显著提升在长程任务中的规划能力、自我修正能力与可靠性。

在实践中,它将冗长、重度依赖工具的任务转化为稳定的 “计划→行动→反思” 循环,减少状态漂移与重复性错误,同时确保每一步行动都基于最新证据(evidence)。Interleaved Thinking 同时提升了可调试性:通过推理过程的快照让故障变得可解释与可恢复,并通过复用假设、约束与部分结论(而不是重新推导每个步骤)从而提高样本效率。

为获得最佳效果,与其在一开始完成所有思考,不如将思考与工具反馈交错进行,保持思维链的连贯性,使其在多轮交互中不断累积。

![]()

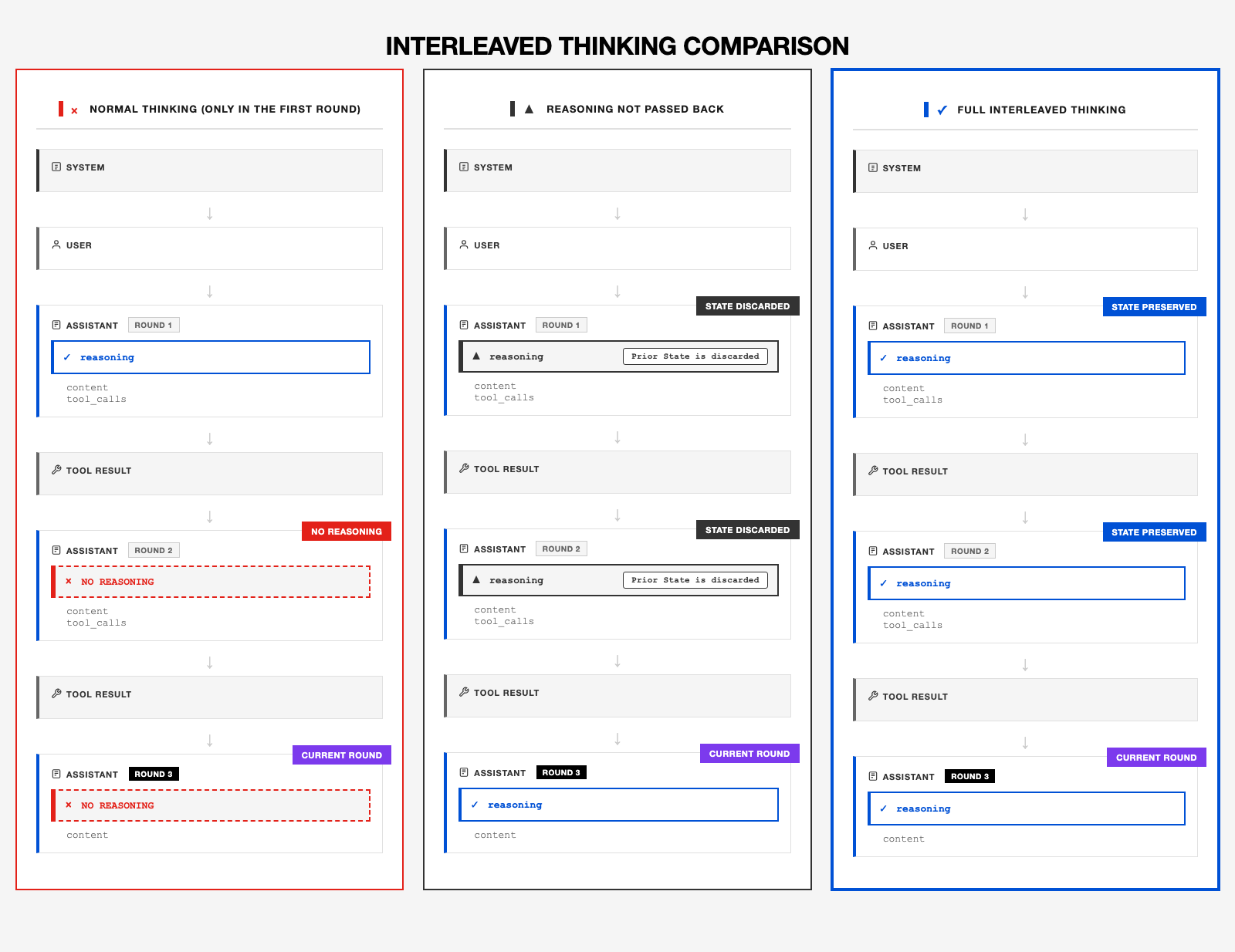

从社区开发者反馈中,我们发现部分失败案例源于没有正确使用 Interleaved thinking,即未能在多轮会话之间保留之前每一轮的思考状态。问题的原因之一是,社区广泛使用的 OpenAI Chat Completion API 并不支持返回推理内容,并在后续请求中再次传递。

Anthropic API 虽然原生支持该能力,但社区对 Claude 之外的模型支持得较少,并且许多应用在其 Anthropic API 的实现中仍然没有回传之前的思考过程。这种情况导致 Interleaved Thinking 并没有得到良好的支持。而为了完全释放 M2 的全部能力,在多轮交互中保留思考过程至关重要。

在 MiniMax M2 中,只有保留并把上一轮的推理反馈到后续轮次,Interleaved CoT 才能发挥最大效果。模型会在工具调用之间进行推理,将计划、假设、约束与中间结论持续向后传递—— 正是这种可持续、可累积的推理状态让 M2 模型稳定可靠。一旦丢弃了之前的推理状态,模型的累积理解能力会下降,状态偏离会增加,自我修正能力会减弱,规划能力也会退化,尤其在长程(long-horizon)工具调用和 “运行–修复” 循环中更为明显。

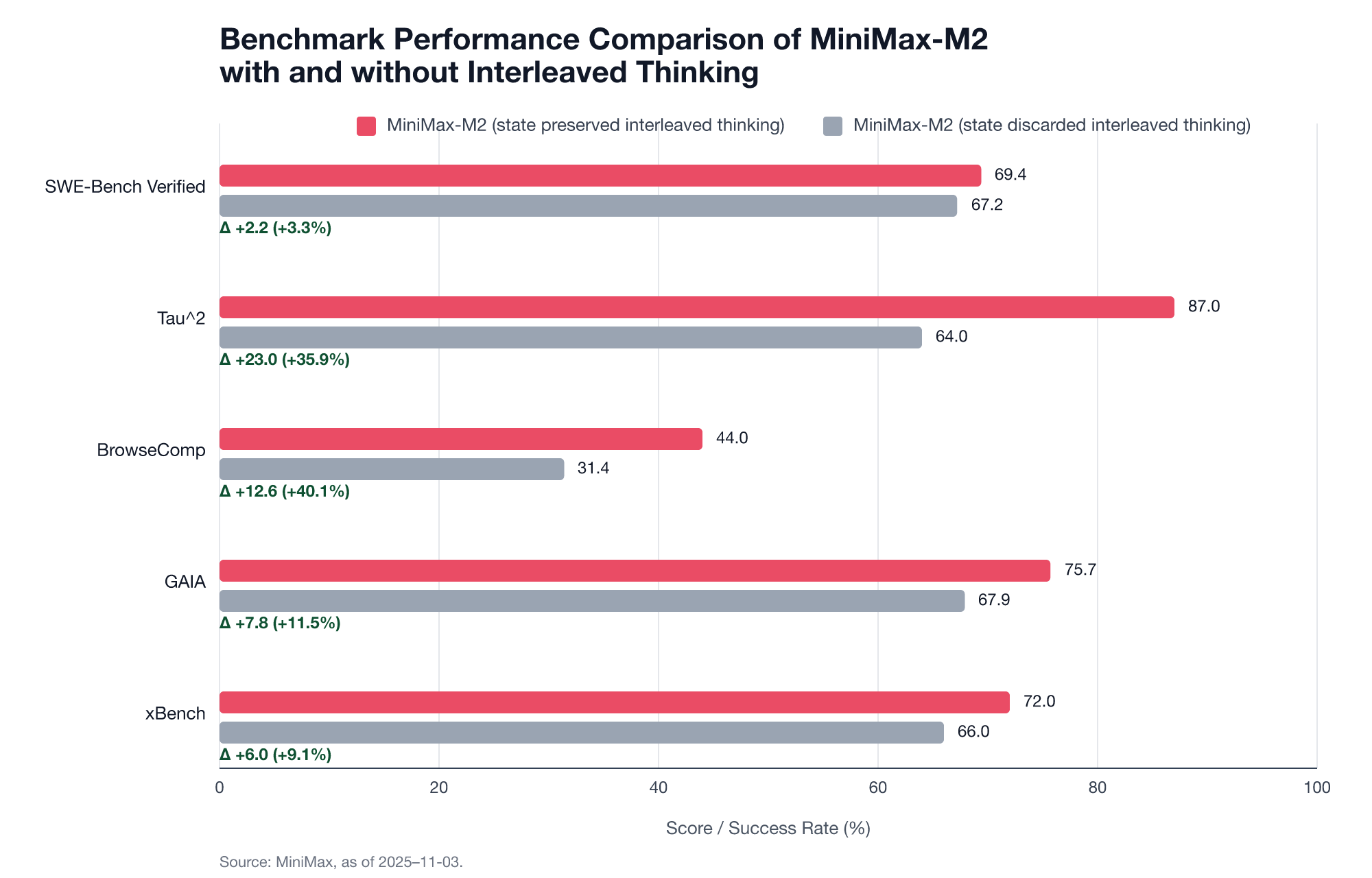

多项基准测试表明,保留之前多轮交互的思维状态更能提高性能:

- SWE‑Bench Verified:69.4 vs. 67.2 (Δ=+2.2; +3.3%)

- Tau^2:87 vs. 64 (Δ=+23; +35.9%)

- BrowseComp:44.0 vs. 31.4 (Δ=+12.6; +40.1%)

- GAIA:75.7 vs. 67.9 (Δ=+7.8; +11.5%)

- xBench:72.0 vs. 66.0 (Δ=+6.0; +9.1%)

![]()

保持 Interleaved Thinking 状态完整至关重要 —— 模型的可靠性不仅在于它当前的想法,更在于它能否回顾和修正之前的想法。Interleaved Thinking 把这一过程机制化:计划 → 行动 → 反思,且状态始终保留,让反思得以累积,让修正在多轮交互中传递。

![]()

图解 Interleaved Thinking

详情查看:

https://mp.weixin.qq.com/s/az9OvwEKJ_vYifqlfw6rWA

https://huggingface.co/blog/MiniMax-AI/aligning-to-what