PyTorch 发布分布式编程框架 Monarch:让分布式 AI 训练像单机一样简单

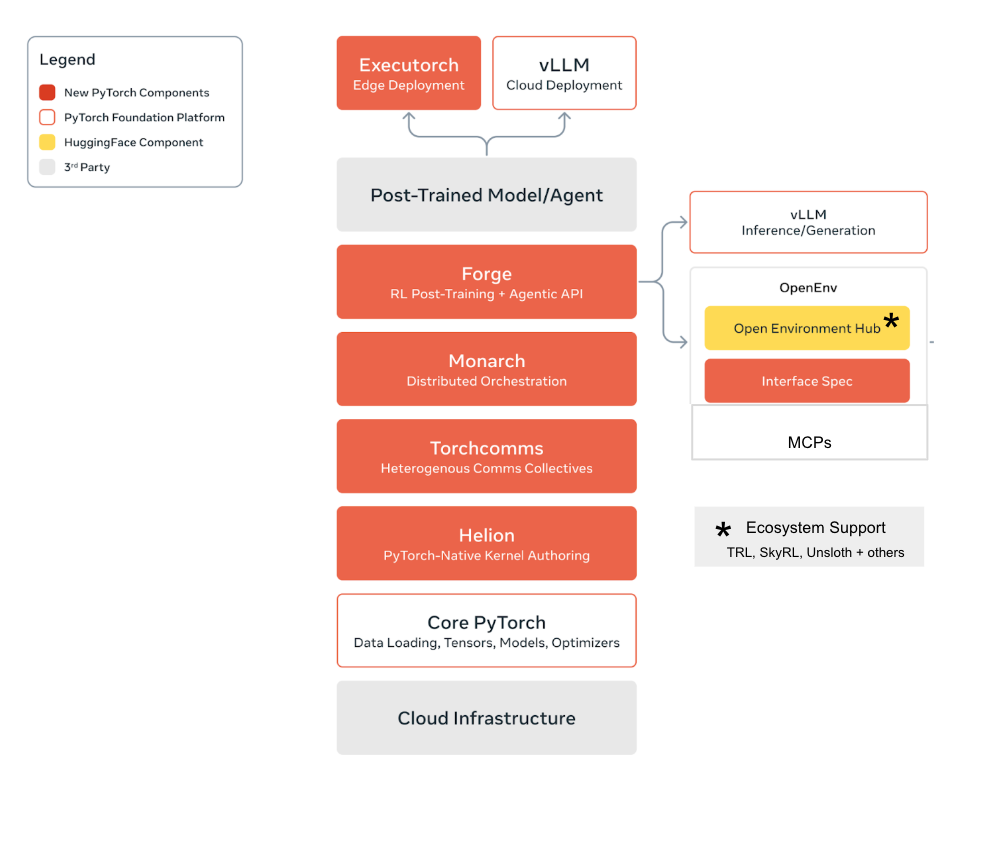

PyTorch 团队发布了全新分布式编程框架 Monarch,旨在彻底简化大规模机器学习任务的开发与部署。Monarch 采用“单控制器(single-controller)模型”,允许开发者用一份普通的 Python 脚本,就能控制跨越上千张 GPU 的集群训练流程。 在传统多控制器架构中,开发者需要手动管理同步、故障恢复、跨节点通信等复杂细节,而 Monarch 将这些过程完全自动化。它将集群资源抽象为“可编程数组 (meshes)”,用户可以像操作张量一样操控整片 GPU 网格,实现代码的高度可扩展性。 Monarch 的核心特性包括: 进程与 Actor 网格 (Process / Actor Mesh):以数组形式组织分布式进程与任务,支持切片与并行操作。 快速故障恢复:在大规模训练中自动处理主机或进程中断,可在数分钟内恢复运行。 本地式分布式张量:无缝集成 PyTorch,让分布式张量操作像本地张量一样自然。 交互式调试支持:开发者可直接在 Jupyter Notebook 上操控和调试分布式集群。 在实际应用中,Monarch 已用于强化学习和大模型预训练任务。例如,Py...