AI 研究机构 Radical Numerics 发布了 RND1-Base,这是迄今为止最大规模的开源扩散语言模型,参数规模达到30B,其中活跃参数为3B,采用稀疏专家混合架构。该模型不仅在基准测试中表现出色,还开源了完整权重、训练配方和推理代码,旨在加速扩散语言模型领域的后训练与推理研究。

RND1-Base基于Qwen3-30BA3B的自回归基础模型,通过简单的连续预训练实现了向扩散范式的无缝转型。转换过程采用双向掩码机制和特定于层的学习率以保留原有知识,并使用高达8M标记的大批量训练确保稳定性,最终在500B标记上完成预训练。这一高效方案避免了从零开始训练带来的资源浪费,体现了Radical Numerics在模型重用方面的创新思路。

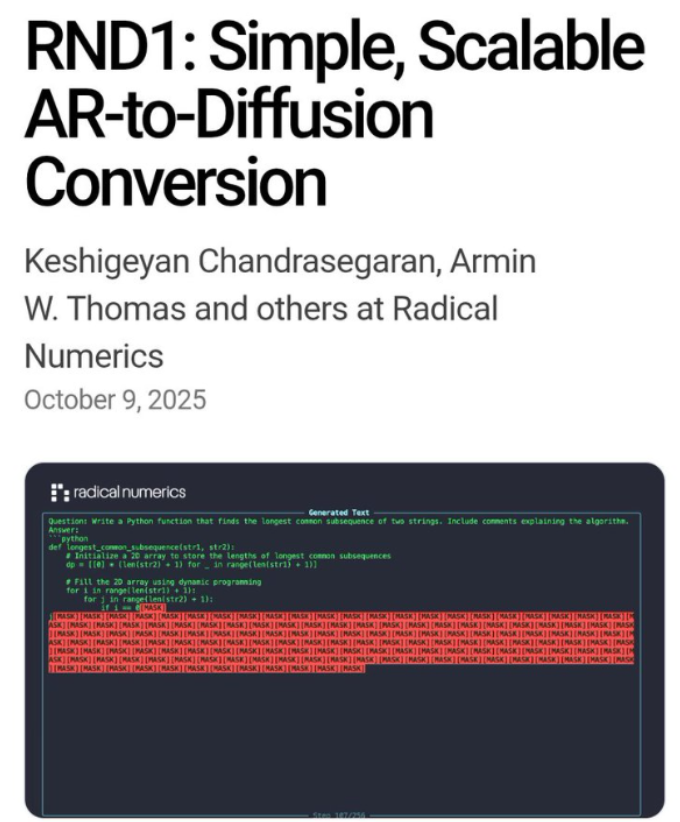

与传统自回归语言模型逐个生成token的顺序模式不同,RND1将文本生成视作类似图像去噪的过程,从噪声中并行精炼整个序列,支持双向注意力机制。这不仅提升了生成的灵活性和可控性,还显著降低了推理延迟,特别适合复杂推理和代码生成任务。

![]()

在通用基准测试中,RND1-Base展现出强劲实力,超越了Dream-7B和LLaDA-8B等开源扩散语言模型前辈。具体成绩包括MMLU多任务语言理解57.2%、GSM8K数学推理72.1%、MBPP代码生成51.3%。这些指标覆盖推理、STEM和编程领域,证明该模型在保持自回归基础优势的同时,实现了扩散架构的性能提升。

RND1的稀疏专家混合设计在30B总参数中仅激活3B参数,优化了计算效率,适合大规模部署。该模型尚未进行后训练,贪婪采样时可能偶尔出现重复,但开源代码已集成FlashInfer和SGLang后端,支持快速推理迭代。

Radical Numerics将自身定位为下一代AI实验室,专注于构建递归自我改进引擎。RND1正是这一愿景的产物,通过自动化AI研究平台,让模型参与优化下一代AI。该团队由来自DeepMind、Meta、Liquid和斯坦福等顶尖机构的研究员与工程师组成,目标是让AI自主设计AI,推动科学与工业发现加速。

开源RND1的目的在于激发社区探索扩散语言模型的推理优化和后训练潜力。当前,扩散模型在语言领域的应用正从实验阶段转向实用阶段,特别是在并行生成长序列任务方面展现出优势。业内预计,此举将刺激更多自回归模型向扩散模型转换的实验,填补开源生态在高效生成模型方面的空白。