在今年的ICML上,快手联合上海交通大学提出了一种支持图文交错生成的统一模型——Orthus,目前已开源。该模型基于自回归Transformer架构,能够从文生图、图到文等不同任务学习有价值信号。

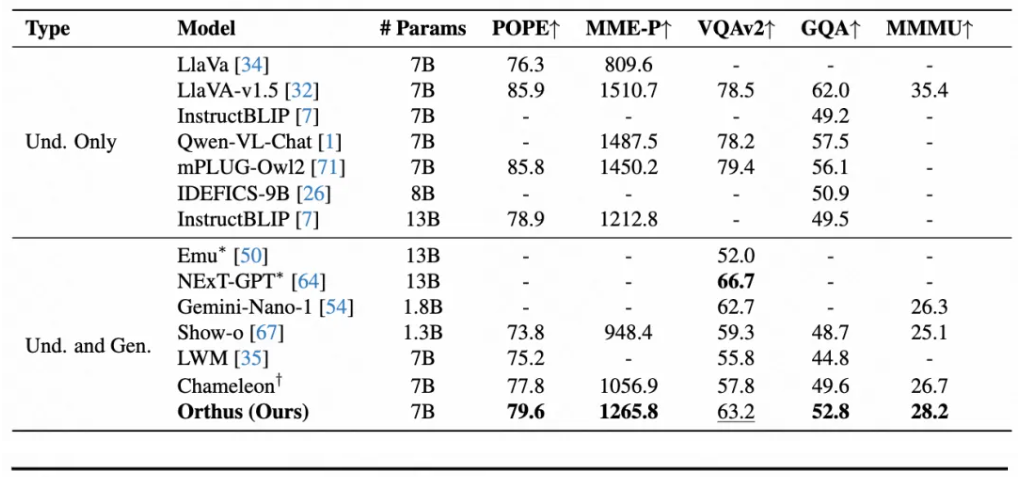

根据介绍,仅使用极少的计算资源,Orthus便在多个图像理解指标上超越了现有混合理解生成模型Chameleon和Show-o,并在文生图生成的GenEval指标上优于专用扩散模型SDXL。此外,Orthus还展现出强大的图文交错数据建模能力,在图像编辑和网页生成任务中展现出巨大潜力。

Orthus具有以下核心特性:

- 自回归Transformer主干;

- 处理离散的文本token和连续的图像feature;

- 基于线性层定义的language head和diffusion MLP定义的image head来分别生成文和图;

- 足够计算高效。

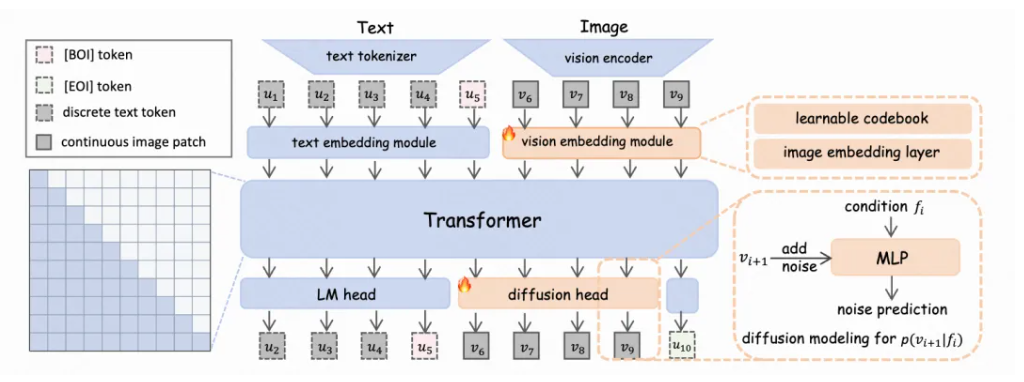

如下图所示,项目团队利用上述两个heads,将图片细节的扩散建模从Transformer主干中解耦。该设计使得主干网络能够专注于刻画文本与图像特征表示之间的关联,而将图像细节信号的恢复任务交由更专业的diffusion head完成。这样解耦既缓解了图像离散化表示带来的信息损失,又避免了端到端扩散建模与自回归机制之间的分歧。本质上,Orthus可以看作何恺明在图像生成领域的工作 MAR 向多模态领域上的拓展。

![]()

具体实现上,Orthus 由以下组件构成:一个文本分词器、一个视觉自编码器、两个特定模态的嵌入模块、一个Transformer 主干网络和两个特定模态的输出头。

给定文本和图像,Orthus 会将离散的文本token(由文本分词器生成)和连续的图像特征(由视觉自编码器提供)嵌入到统一的表示空间中。在该空间内,自回归Transformer 主干负责建模模态内部(如文本-文本)及跨模态(文本-图像)之间的相互依赖关系。

在主干之上,Orthus 使用两个模态特定的头部来分别生成文本和图像:一个是常规的语言建模线性头,用于预测离散的文本token;另一个是扩散MLP头,用来生成连续的图像特征。在推理阶段,Orthus根据特殊标记的指示,自回归地预测下一个文本token或图像feature。

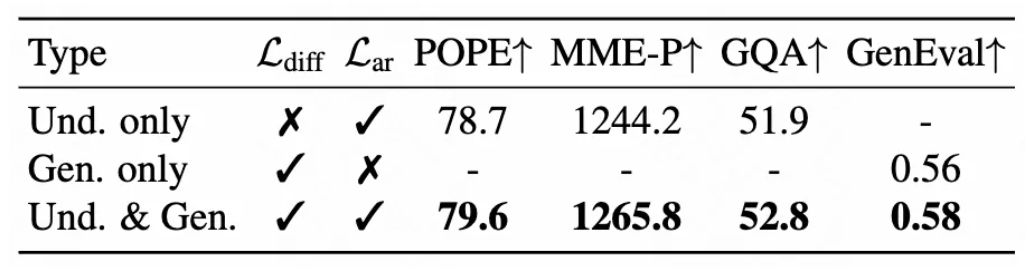

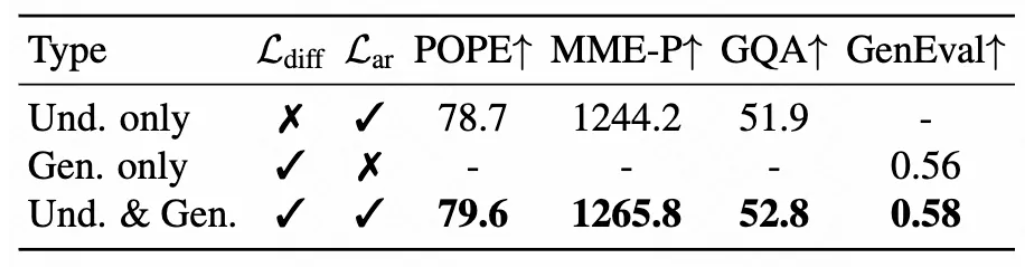

实验结果表明,得益于 Orthus 对图像的连续表示及扩散建模方法的优势,Orthus相较在同样的数据设定下微调的Chameleon表现更佳。

![]()

![]()

![]()

更多详情可查看官方公告。