深度学习(DeepLearning)尤其是卷积神经网络(CNN)作为近几年来模式识别中的研究重点,受到人们越来越多的关注,相关的参考文献也是层出不穷,连续几年都占据了CVPR的半壁江山,但是万变不离其宗,那些在深度学习发展过程中起到至关重要的推动作用的经典文献依然值得回味,这里依据时间线索,对CNN发展过程中出现的一些经典文献稍作总结,方便大家在研究CNN时追本溯源,在汲取最新成果的同时不忘经典。

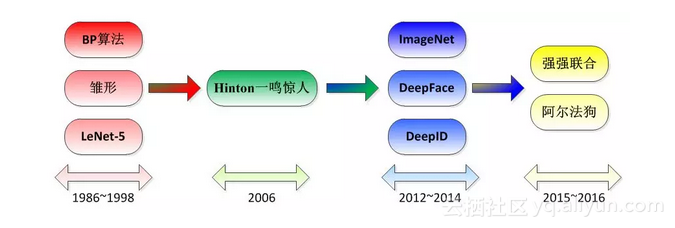

首先这里给出CNN在发展过程中的一些具有里程碑意义的事件和文献:

![image image]()

对于CNN最早可以追溯到1986年BP算法的提出,然后1989年LeCun将其用到多层神经网络中,直到1998年LeCun提出LeNet-5模型,神经网络的雏形完成。在接下来近十年的时间里,卷积神经网络的相关研究趋于停滞,原因有两个:一是研究人员意识到多层神经网络在进行BP训练时的计算量极其之大,当时的硬件计算能力完全不可能实现;二是包括SVM在内的浅层机器学习算法也渐渐开始暂露头脚。2006年,Hinton终于一鸣惊人,在《科学》上发表文章,CNN再度觉醒,并取得长足发展。2012年,ImageNet大赛上CNN夺冠,2014年,谷歌研发出20层的VGG模型。同年,DeepFace、DeepID模型横空出世,直接将LFW数据库上的人脸识别、人脸认证的正确率刷到99.75%,几乎超越人类。2015年深度学习领域的三巨头LeCun、Bengio 、Hinton联手在Nature上发表综述对DeepLearning进行科普。2016年3月阿尔法狗打败李世石,2016年4月我在写这篇博文。

一、1986年~1998年

这段时间里是CNN的雏形阶段,主要包括BP算法的提出、BP算法在多层神经网络模型中的应用、LeNet-5模型的正式定型。

1.1 BP算法的提出

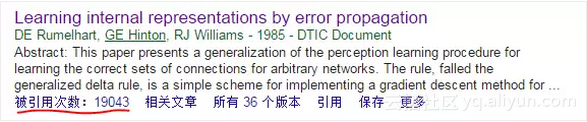

BP算法是在1986年由Rumelhart在《Learning Internal Representations by Error Propagation》一文中提出,如果你的论文中提到了BP算法,那这篇文章似乎是非引用不可的,它目前的引用量是19043次:

![image image]()

1.2 基于BP算法的CNN雏形

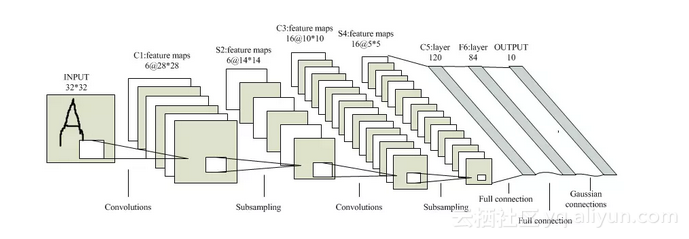

在BP算法提出3年之后,嗅觉敏锐的LeCun选择将BP算法用于训练多层卷积神经网络来识别手写数字,这可以说是CNN的雏形,具体参见文章《Backpropagation applied to handwritten zip code recognition》,这是卷积神经网络这一概念提出的最早文献,目前应用量为1594次:

![image image]()

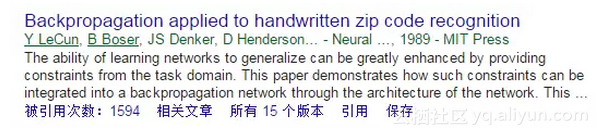

1.3 LeNet-5模型的最终定型

所有研究CNN的都必然知道LeNet-5模型,这是第一个正式的卷积神经网络模型:

![image image]()

但你知道它是在什么时候被正式提出来的吗?在1998年,作者还是LeCun,文章《Gradient-based learning applied to document recognition》,引用量4832次:

![image image]()

至此,LeNet-5模型的提出标志着CNN的正式成型,不幸的是接下来这个技术就被打入冷宫,原因如上文所说,它不仅吃设备,而且好的替代品还很多。

二、2006年

这一年可以说是DeepLearning觉醒的一年,标志就是Hinton在Science发文,指出“多隐层神经网络具有更为优异的特征学习能力,并且其在训练上的复杂度可以通过逐层初始化来有效缓解”。这篇惊世骇俗之作名为《Reducing the dimensionality of data with neural networks》,目前引用量3210次:

![image image]()

至此,在GPU加速的硬件条件下,在大数据识别的应用背景下,DeepLearning、CNN再次起飞。

三、2012年~2014年

这段时间卷积神经网络的相关研究已经进行的如火如荼,学术文献呈井喷式层出不穷,具有代表性的我认为有两个:2012年的ImageNet大赛和2014年的DeepFace、DeepID模型。

3.1 ImageNet竞赛上CNN的一鸣惊人

可以说,2012年CNN在ImageNet竞赛中的表现直接奠定了它的重要地位,两个第一,正确率超出第二近10%,确实让人大跌眼镜。在文献《Imagenet classification with deep convolutional neural networks》详细介绍了相关的结构模型以及比赛结果,这篇文献的作者是Hinton,目前引用量4412次:

![image image]()

3.2 DeepFace、DeepID

在2012年CNN一炮打响之后,其应用领域再也不只局限于手写数字识别以及声音识别了,人脸识别成为其重要的应用领域之一。在这期间DeepFace和DeepID作为两个相对成功的高性能人脸识别与认证模型,成为CNN在人脸识别领域中的标志性研究成果。DeepFace由Taigman等人提出,发表在2014年的CVPR上,具体信息参见文章《DeepFace: Closing the Gap to Human-Level Performance in Face Verification》,目前引用量548:

![image image]()

至于DeepID,这是由香港中文大学汤晓鸥教授的研究团队提出,于2014年连发三箭,箭箭都正中靶心,分别是《Deep Learning Face Representation from Predicting 10,000 Classes》、《Deep learning face representation by joint identification-verification》、《Deeply learned face representations are sparse, selective, and robust》 目前引用量都在100~200次之间。需要强调的一点是作者在第三篇文章中对卷积神经网络的内部结构进行了分析,试图从理论上诠释CNN的强大特征提取能力,这是学者第一次试图去探索CNN的本质属性,史无前例。

四、2015年~至今

卷积神经网络自从2006年再度走进人们的视线,发展到现在已经快有十个年头。2015年深度学习领域的三巨头LeCun、Bengio 、Hinton在Nature上发表一篇综述,系统的总结了深度学习的发展前世今生,文章写得通俗易懂,全文几乎都没有什么公式,是一篇科普性较强的文章,个人觉得研究深度学习的人员都应该去读一读,题目也很简洁,就叫《Deep Learning》,2015年发表,目前引用量已达321次:

![image image]()

然后在2016年,CNN再次给人们一个惊喜:谷歌研发的基于深度神经网络和搜索树的智能机器人“阿尔法狗”在围棋上击败了人类,更惊喜的是谷歌在Nature专门发表了一篇文章来解释这个阿尔法狗,估计很多人都不知道,文章名字叫做《Mastering the game of Go with deep neural networks and tree search》,由于刚刚发表,引用次数仅为29次:

![image image]()

以上就是我自己对CNN的发展过程中一些标志性的经典文献的一个小小总结,同时也是CNN发展历程中的一个缩影,其中很多文献都是在撰写论文过程中必然要引用到的,希望对大家有所帮助。

五、注意事项

4.1 文献提供

以上所提到的文献在IEEE、谷歌等网站上均可以下载得到,当然实在找不到的话可以联系我,我会及时提供相关文献。

4.2 《Notes on Convolutional Neural Networks》

这篇文献在谷歌上可以查到,具体如下:

![image image]()

遗憾的是笔者到现在也不知道这篇文章到底发表在那个期刊或者会议上,因此不方便在撰写论文的过程中对其进行引用,不过这篇文章的质量确实相当高,对卷积神经网络的前向/反向传播原理都介绍得十分清楚,公式也非常规范,不失为一篇在卷积神经网络入门阶段的好文章,推荐大家阅读。

4.3 引用量均来自于谷歌学术

上文中所提到的相关论文的引用次数均来源于谷歌学术所提供的数据,若有纰漏请大家多多包涵。

4.4 文献阅读笔记

上文提到的这几篇文献堪称卷积神经网络研究领域的经典文献,引用次数都非常高。当然我也不是一开始就能如此抓到重点的去找到这些经典的东西,这都是在阅读了一定数量的文献,有了一定的区分能力之后才能做出的总结,至于自己在文献调研中所走过的弯路就不再多说,这里将我研究生阶段调研过的文献情况奉上以供大家参考:文献阅读笔记。

4.5 卷积神经网络与深度学习的概念

在这篇博文中我一会儿说卷积神经网络模型,一会儿说深度学习模型,但需要强调的是这两个概念并不是等价的,深度学习的概念要更为宽泛一些。经典的深度学习理论可分为卷积神经网络、深度置信网络以及自动编码器,卷积神经网络可以说是目前深度学习体系中研究最多、应用最为成功的一个模型,因此这个概念还是要区分清楚的。

原文发布时间为:2018-07-01

本文来自云栖社区合作伙伴“机器学习算法与Python学习”,了解相关信息可以关注“机器学习算法与Python学习”。