![]()

就在您认为大数据不可能再变大时,它还在不断变大。 无论其实际大小,大数据正在显示价值。 各个地方的组织都有各种形态与大小的大数据。 这些组织意识到其重要性、机遇以及给予关注的迫切需要。 很显然,无论忽略与否,大数据都会不断发展。

已掌控大数据(在明了其价值前储存的多结构混乱数据)的组织正在提升组织效率、提高收益,并发展新的业务模式。 他们是怎样做到的? 这些机构成功的方法可以总结为七条建议。

1、以短期考虑促进长期考虑

担心能否跟上大数据的潮流的人,不止您一个。 一切都瞬息万变,因此无从知道今年或明年哪些工具、平台或方法是最好的。

放宽心。 这种快速演变的形势可以为您服务。

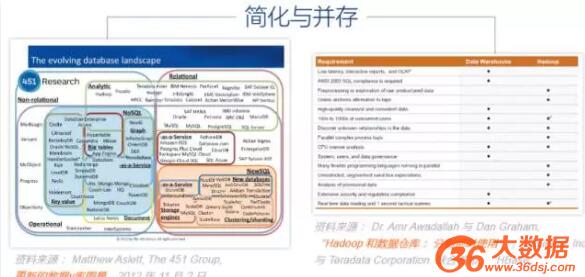

每年,供应商都在大数据使用方面不断提高。 关系与在线交易系统(OLTP)会越来越高效、越来越智能,无论是在内部还是云中运行。 技术的发展将会缓和 Hadoop 及数据仓库之间的关系。 而且,始终会有产品上市,更精准地满足您的具体需求。

因此,敬请宽心。对采纳新产品保持开放心态,只要这些产品能提供足够价值,就能名正言顺地融入您的现有环境。 保持能够直连多种格式的商业智能平台。 您现已准备好应对市场变化。

2、看清错误选择

贵机构需要什么,Hadoop 还是数据仓库?别说,这还真是个有陷阱的问题。 不光是 Hadoop 与数据仓库能够很好地协同工作,机构实际上还能从两者的协作获益。 数据仓库用来压缩重要结构化数据再适合不过,还能把数据存储在商业智能工具和仪表板能够轻松找到的地方。 但其弱势是,分析过程与某些类型的转换较弱且慢。

这一点正好由 Hadoop 补充。 此外,尽管 Hadoop 在交互式查询与数据管理方面较为弱势,但其善于快速容纳原始、未结构化的复杂数据。 这两者合而构成共生关系。 例如,想象一下高层管理用来预测下一年库存需求的数据。 数据集可能很大,几乎没有时间给数据建模、重新结构化,也没有时间以其他方式预处理好数据,供数据仓库使用。

高层管理人员用完以后,可能仅一周时间,就会丢弃。 这就是 Hadoop 该出来发挥作用,细化数据并把样本发送到数据仓库的时候。 “大数据并不是数据仓库的替代品,” Third Nature CEO Mark Madsen 在其“大数据的真实含义”一文中写道, “也不是单独维护的孤岛。 大数据是新 IT 环境的一部分。”

不要在选择 Hadoop 还是数据仓库这个问题上不知所从。 您可以,也应该使用两者。

![]()

3、浓缩大数据,使之一目了然

结构出色、考虑周全的可视化平台让其他系统都黯然失色。这是电子表格无法带来的。

— 富国银行达纳·朱伯

大数据可视化之后,浓缩到一目了然的程度。Aberdeen Group 的一份报告发现:“在使用可视化发现工具的机构中,48% 的商业智能用户,无需 IT人员的帮助,即可找到需要的信息。” 如果没有可视化发现工具,这个比例降到了 23%。

此外,根据这份研究,使用可视化数据发现的经理较之没有可视化数据的经理找到及时信息的可能性,要高出 28%。

或许,最为重要的是,在涉及到大数据的情况下,报告发现可视化还能促进与大数据的互动。 较之其他经理,使用可视化数据的经理与数据广泛互动的可能性要高出一倍多(33%比 15%)。 另外,这些经理还更有可能即兴提问,往往是受到前一刻洞见启发的问题。 以可视化的方式探索数据,使得数据生动呈现,让大脑能够瞬间理解。 富国银行战略规划副总裁达纳·朱伯称:“会有一些萌生的想法,这是电子表格无法带来的。”

![]()

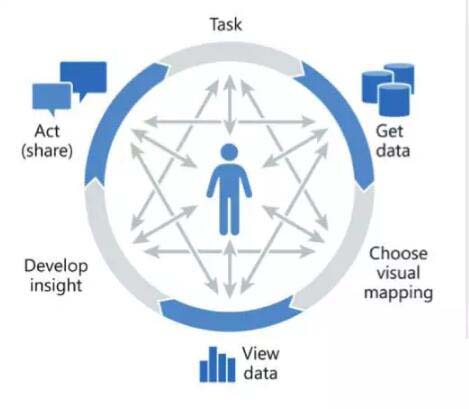

资料来源: Jock D. Mackinlay, PhD, “How to See and Understand big data,” 2007 年

借助可视化分析,您还可以随时做两件事:

- 改变正在查看的数据,因为不同的问题往往需要不同的数据。

- 改变查看数据的方式,因为每种视角都可以回答不同问题。

利用这些简易步骤,您就进入了名为“可视化分析循环”的状态:获取数据、查看数据、提问并回答问题,然后周而复始。 每一次,您的问询都会随洞见深化。

您可以向下搜索、向上搜索,或者横向搜索。 您可以把新数据添加进来。 随着可视化加速并扩展您的思维,您会创建一个接一个的视图。

准备就绪后,就可以分享。 同时提出并回答自己的问题,加速整个团队的洞见、行动和业务成果。

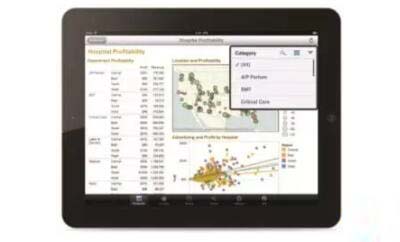

![]()

在台式机、iPad 或 Android 平板电脑上查看实时网络仪表板并进行交互

4、赋予用户以深刻洞见

您是否认识迷上了洞见的人? 没有什么能阻止这些人。 他们不断提出新问题并创造新价值,直到完成一切,心满意足,或者直到需要填写 IT 申请。

有了大数据,对洞见就入迷更深了。 然后就是热情澎湃地投入。 现在,除了自助式数据分析外,根本没时间忙别的。

“与其他组织相比,拥有大数据的组织拥有主要由商业部门而非 IT 组驱动的 BI 项目的几率要高出 70%多,” Aberdeen Group 最近发布的“转向大数据还是破产倒闭? 最大化分析和大数据的价值”中表示。

有了大数据,商业用户无需再忍受 IT 部门老旧、缓慢的方法,这种方法发布数据的方式就像一章一章地展开一本书。

在《大数据的价值》(The Value of big data)中,Third Nature 研究分析师马克·马德森写道:“不光是商业智能发布模式已老旧,商业智能模式期望信息在其中使用的环境也同样过时。” 这就好像借着旧时灯光或烛光读书 – 也就是以前所谓的“刻苦钻研”。 马德森继续写道:“大数据就像电气照明,把之前幽暗的角落都照亮了。 它提供的不仅有更明亮的光线,还有随需随取的能力。 无需耗费数月等待数据完好清理并可供使用,现在可以利用大数据技术察觉并发现数据中的价值。 如果数据有价值,可以通过更严格的流程发送,供数据仓库使用。”

不要再强迫用户“刻苦钻研”, 而要给他们赋予能力。

![]()

资料来源: Tableau Software

5、把小数据组合成更大的数据

细看之下,大数据的的构成无非是:许许多多的小数据集。 每个数据集本身可能提供价值。 综合起来,则能够提供大价值。

举例而言,在消费品行业,只有混合了消费者信心数据与购买数据后,高层管理才能全面理解消费行为。

联合利华分析总监瑞西·库马称:“通过会员卡,能够获得丰富的数据。 很有必要把所有这些数据混合起来,理解消费者为什么要进入商店购物。” 联合利华可借此预测流行产品和新趋势。

很有必要把所有这些数据混合起来,理解消费者为什么要进入商店购物。”– 联合利华瑞西·库马

价值的大头归属于混合了关系、半结构化与原始数据的机构 –尽可能降低了前期成本,而又无需让商业用户受技术的困扰。 这就可以了,也足够好了。

无论数据是在电子表格、数据库、数据仓库、类似 Hadoop 的开放式源文件系统中,还是以上都有,您都需要能够灵活快速地连接到数据并进行整合。

不管您的大数据有多大或者多小,您都可以借此想到就提出并回答问题。

6、确保大数据免遭大麻烦

大数据像沙盒一样有趣。 您可以进去,建立并塑造东西,甚至捡起沙子,放到最好朋友的裤子里。 对吗? 对,但需要在成人监视下。

这些数据有价值的部分原因是,它们与现实人物相关。 政府就要求,每个人都要注意对这些数据的用法,更不说道德操守了。

目前,80 多个国家有数据隐私法。 欧盟规定了七个“安全港隐私原则”,用以保护欧盟公民的个人数据。 在新加坡,个人数据保护法于 2013 年 1 月生效。 在美国,《萨班斯·奥克斯利法案》让所有上市公司均须公开通告,而《健康保险隐私及责任法案》(HIPAA)则设立了医疗隐私的国家标准。

因此,潜入大数据的海洋之前,务必严肃看待遵守治理与隐私标准的需要。 贵机构是否为需要遵守 HIPAA 的医疗机构? 还是在世界某些地区运营? 抑或,您是否意识到,对大数据的关键元素采取预防措施,才是明智的?

那么,如果贵机构必须合规,一种显而易见的解决方案就是主数据管理,这样可以收紧整个机构的数据使用。 如果您有主数据管理,那么一切解决。 但是,就定义和商业规则达成一致,对大多数牵涉者都是缓慢而痛苦的过程。

或许确实痛苦,但有实效。Forrester 咨询公司在报告《大数据需要灵活的信息和整合治理》中建议,不要为了灵活和快速出结果略过治理。大数据结果需要治理。

Forrester 建议不要遵循“单一的一套标准、政策和做法”,他们发现这样会“会扼杀可从大数据投资与洞见达成的价值。”

反之,报告建议采取治理,从而将分析能力与目标匹配、顾及数据的来源和类型的情况下建立治理“区”,并在正式实施规则前进行试验。

7、开始着手

最后一条建议可能最重要: 尽管放手去做。 只需行动起来,按前面的六个步骤去做。

大数据即使还没有进门,也已在门口。 现在就争取成果。

现在,我能够紧随业务速度,在商务会议中当场对一些事务做出回答, 以前,每个问题都要来回讨论一两天。 现在我可以拿着我的笔记本电脑坐在会议中,基于几乎飞速处理的 2 千万行数据回答问题。

——巴克莱银行 彼得·吉尔克斯

一旦您有东西要展示,其他人就会注意,因为没有什么能像结果这样获得关注。 接着就产生良性循环,把结果快速散播到整个机构中。

最终,会有一名高管产生兴趣,于是您立下大功。

本文作者:Tableau

来源:51CTO