Hive 基本环境部署

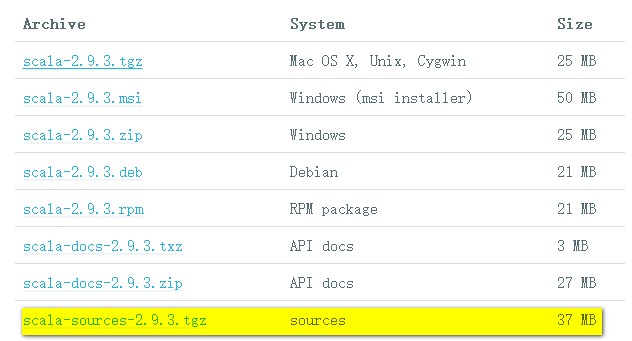

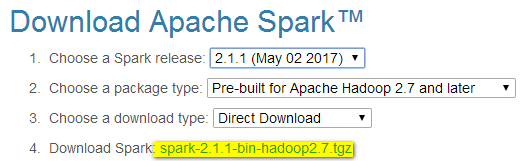

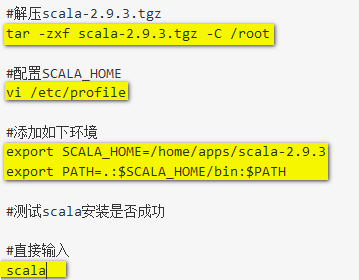

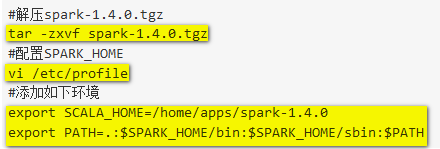

一、Hive 运行模式 与Hadoop类似,Hive也有 3 种运行模式: 1. 内嵌模式 将元数据保存在本地内嵌的 Derby数据库中,这是使用hive最简单的方式。但是这种方式缺点也比较明显,因为一个内嵌的 Derby 数据库每次只能访问一个数据文件,这也就意味着它不支持多会话连接。 2. 本地模式 这种模式是将元数据保存在本地独立的数据库中(一般是MySQL),这用就可以支持多会话和多用户连接了。 3. 远程模式 此模式应用于 Hive 客户端较多的情况。把mysql数据库独立出来,将元数据保存在远端独立的 MySQL 服务中,避免了在每个客户端都安装 MySQL 服务从而造成冗余浪费的情况。 二、下载安装 Hive http://hive.apache.org/downloads.html 三、配置系统环境变量 修改 /etc/profile 文件,使用sudo vim /etc/profile来修改: #Hiveenvironment exportHIVE_HOME=/usr/local/hadoop/hive exportPATH=$HIVE_HOME/bin:$HIVE_...