美团 LongCat 团队正式发布当前高度贴近真实生活场景、面向复杂问题的大模型智能体评测基准——VitaBench(Versatile Interactive Tasks Benchmark)。

据介绍,VitaBench 以外卖点餐、餐厅就餐、旅游出行三大高频真实生活场景为典型载体,构建了包含 66 个工具的交互式评测环境,并进行了跨场景的综合任务设计。例如,在旅游规划任务中,要求智能体通过思考、调用工具和用户交互,完整执行从买好票到订好餐厅的终端状态。

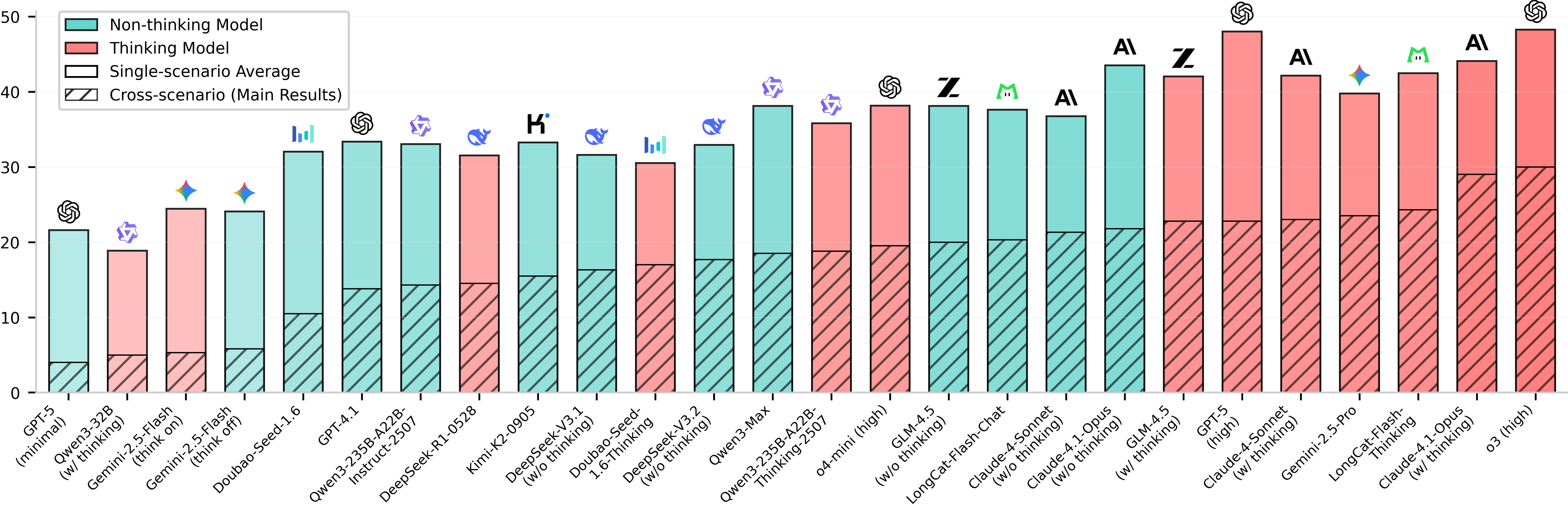

我们首次基于深度推理、工具使用与用户交互三大维度对智能体任务进行了量化拆解,以可控地构建复杂问题。我们发现,即便是当前领先的推理模型,在主榜(复杂跨场景任务)中的成功率也仅有 30%,揭示了现有智能体与复杂真实生活场景应用需求之间的显著差距。VitaBench 现已全面开源,旨在为推进智能体在真实生活场景中的研发与应用提供重要基础设施。

![]()

随着大语言模型在复杂推理与工具调用能力上的快速进步,基于LLM的智能体在真实生活场景中的应用日益广泛。然而,现有的智能体评测基准与现真实生活场景的应用需求之间依然存在显著差距,主要体现在以下几个方面:

-

工具生态简单化:早期的工具调用基准主要评估单次 API 调用的准确率(如:函数选择、参数填充),忽视了真实工具间的复杂依赖关系与组合调用需求;

-

信息密度不足:大多数相关基准仅关注单一类型信息,未能反映真实应用场景中多源信息(时空信息、常识信息、多场景服务数据、用户画像、用户历史交易数据等)的综合处理需求;

-

模型探索性受限:现有基准为了模拟真实生活场景,通常会将领域知识组装成冗长的 Policy 文档要求模型遵循,但是这种做法会限制模型在复杂环境中探索解空间的自主性。同时,这种模式下,除了进行深度思考、有效环境交互的能力外,模型的长文本指令遵循能力也对执行结果有很大影响;

-

交互动态性缺失:用户作为环境的重要组成部分,大多数交互式 Agent 基准当前没有充分考虑到用户交互行为的多样性、用户需求的模糊性、多轮对话中的意图转移等真实复杂度;

通过对美团生活服务场景的深入分析,LongCat 团队指出:真实世界的任务复杂性,源于三大维度的交织——

- 推理复杂性:需整合多源信息、自主推理规划任务完成路径;

- 工具复杂性:需在高度互联的工具图中理解领域特征,精确调用目标工具;

- 交互复杂性:需在多轮对话中主动澄清、追踪意图、适应多样化的用户行为并给予反馈。

为系统衡量这三重挑战下的模型表现,团队构建了VitaBench,一个依托“生活服务”场景、高度仿真的综合性Agent评测基准。

VitaBench 的评测榜单未来将长期维护更新,欢迎持续关注:

项目主页:https://vitabench.github.io

论文链接:https://arxiv.org/abs/2509.26490

代码仓库:https://github.com/meituan-longcat/vitabench

数据集:https://huggingface.co/datasets/meituan-longcat/VitaBench

排行榜:https://vitabench.github.io/[#Leaderboard](javascript:;)