高效MoE架构重塑边缘AILiquid AI推出的LFM2-8B-A1B是其LFM2系列的首个混合专家(Mixture-of-Experts, MoE)模型,总参数规模达8.3B,但每token仅激活约1.5B参数。这种稀疏激活机制在保持高表示能力的同时,大幅降低计算负载,使其适用于资源受限的设备端场景。不同于传统云端MoE模型,该设计针对实时交互优化,挑战了“小规模MoE不高效”的行业认知。

模型基于LFM2混合骨干架构,包括18个门控短卷积块和6个分组查询注意力(GQA)块。除前两层保持稠密以确保稳定性外,其余层均集成稀疏MoE前馈网络。每层配备32个专家,仅激活top-4专家,并采用归一化sigmoid路由器结合自适应偏置,实现负载均衡。支持32K上下文长度,兼容英文、阿拉伯文、中文、法文、德文、日文、韩文和西班牙文等多语言。

训练与性能:12T令牌铸就3-4B级能力LFM2-8B-A1B通过约12T令牌的预训练实现,包括55%英文、25%多语言和20%代码数据分布。随后采用Liquid Preference Alignment(长度归一化DPO/APO-Zero融合)进行后训练,使用混合BF16/FP8精度,提升训练效率3倍以上。

![]()

在基准测试中,该模型展现出超越同规模竞争者的实力:

- 知识与指令跟随:MMLU-Pro得分37.4(较LFM2-2.6B提升11.5),IFEval77.6,Multi-IF58.2。

- 数学能力:GSM8K84.4,GSMPlus64.8,MATH50074.2。

- 多语言处理:MGSM72.4,MMMLU55.3。

- 编码与写作:HumanEval+69.5,LiveCodeBench v621.0,EQ-Bench44.2。

整体而言,其输出质量媲美3-4B稠密模型,在多轮对话、创意写作、RAG检索增强生成和工具调用等任务中表现出色。部署与集成:5倍加速,适配主流框架LFM2-8B-A1B在CPU和GPU上的推理速度显著领先。

在AMD Ryzen AI9HX370和三星Galaxy S24Ultra等设备上,使用int4量化与int8动态激活的自定义XNNPACK MoE内核,其解码吞吐量比Qwen3-1.7B、IBM Granite4.0等快达5倍。GPU端集成vLLM,支持FlashInfer和CUDA-graph编译,实现单请求与在线批处理的高效运行。

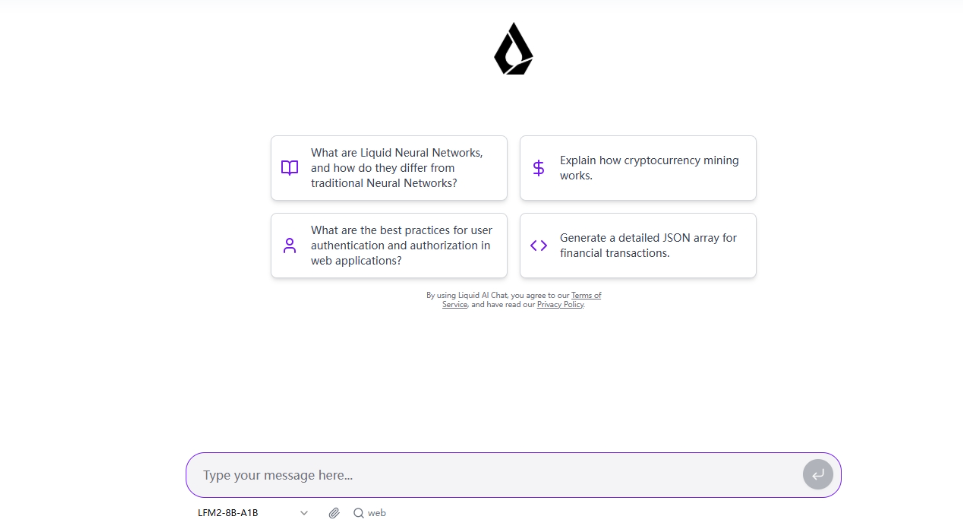

量化变体已优化至高配手机/平板/笔记本:Q4_0约4.7GB,F16约16.7GB。支持框架包括llama.cpp(需b6709+版本支持lfm2moe)、ExecuTorch(移动/嵌入式CPU)和vLLM(GPU)。此外,提供Hugging Face上的GGUF量化文件及Colab微调笔记本,便于开发者快速上手。模型已在Liquid Playground上线测试。