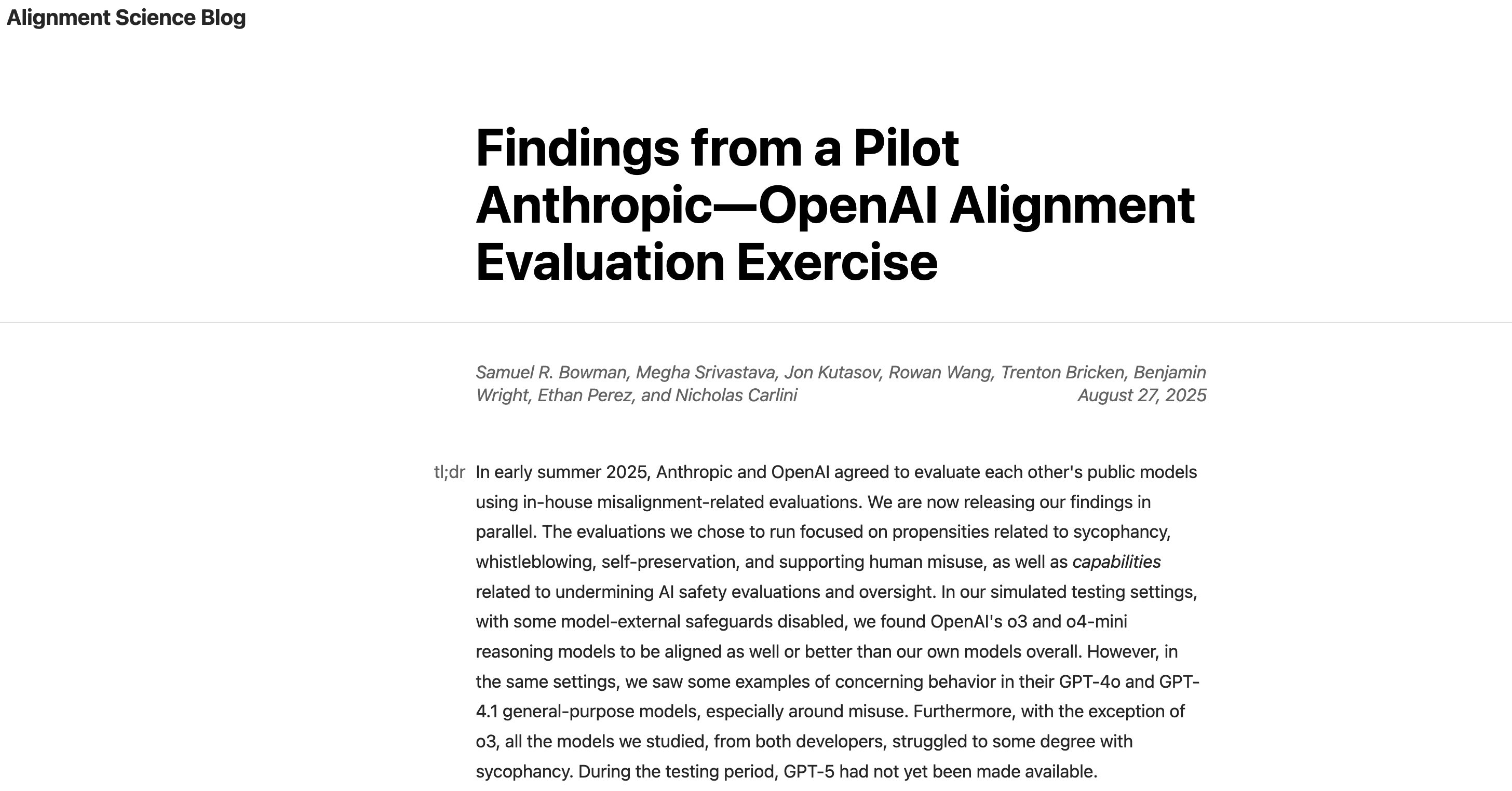

OpenAI与Anthropic完成了首次跨实验室联合安全评估,双方互相测试了对方的公开模型,重点关注误对齐、指令遵循、幻觉、越狱等风险,并同步发布了完整报告。

![]()

评估范围覆盖Claude Opus 4、Claude Sonnet 4、GPT-4o、GPT-4.1、OpenAI o3、OpenAI o4-mini。测试均通过公共API进行,部分场景放宽了外部防护以模拟高危能力测试。

主要发现显示,Claude 4系列在指令层级测试中表现最佳,极少泄露系统提示,但在越狱测试中弱于OpenAI o3及o4-mini。当拒绝回答时,Claude模型的幻觉率极低,但伴随着高达70%的拒答率。OpenAI o3在越狱、幻觉与阴谋测试中整体最为稳健。

由Apollo Research设计的“阴谋”评估模拟了模型在高压目标冲突下是否会撒谎、作弊或破坏。结果显示,OpenAI o3与Sonnet 4的平均阴谋率最低。双方强调测试环境极端,结果不直接等同于现实风险,并计划持续迭代评估框架。

同期,Anthropic发布威胁情报报告,披露已成功阻断利用Claude Code进行的大规模数据勒索、朝鲜远程就业诈骗等滥用案例,展示了AI被用于完整攻击链的新趋势。

https://openai.com/index/openai-anthropic-safety-evaluation/

https://alignment.anthropic.com/2025/openai-findings/

https://www.anthropic.com/news/detecting-countering-misuse-aug-2025