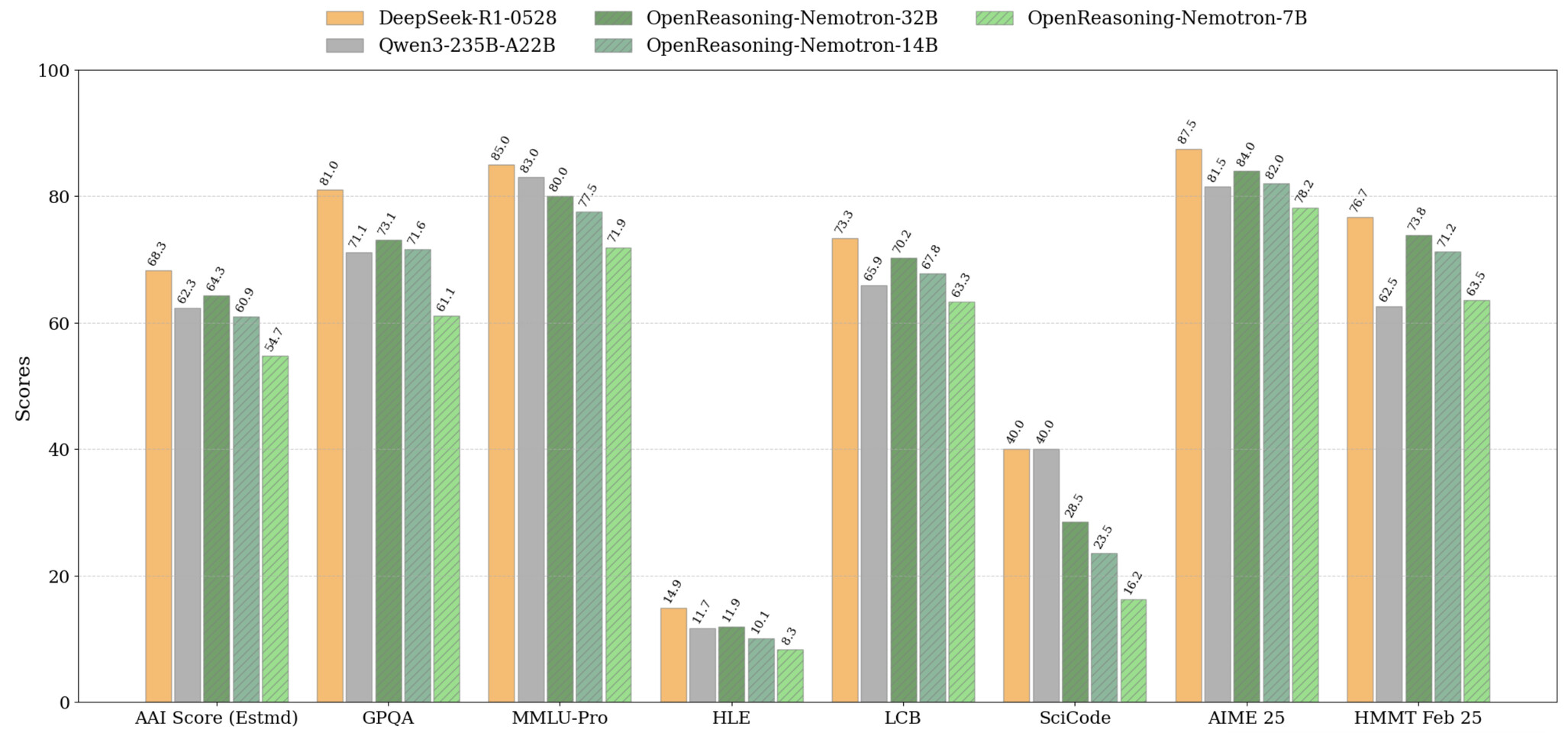

NVIDIA 发布了 OpenReasoning-Nemotron,这是由四个精简的推理模型组成的集合,参数分别为 15 亿、70 亿、140 亿和 320 亿,均源自拥有 671 亿参数的 DeepSeek R1 0528。通过将庞大的“老师”模型压缩成四个基于 Qwen-2.5 的“学生”模型,NVIDIA 使得即使在标准游戏设备上也能进行高级推理实验,而无需担心高昂的 GPU 费用和云使用量。

这些模型在数学、科学和代码等多个推理基准测试中,均在其各自的规模级别上达到了业界领先水平。

![]()

https://huggingface.co/blog/nvidia/openreasoning-nemotron

https://nvidia.github.io/NeMo-Skills/releases/openreasoning/

https://huggingface.co/collections/nvidia/openreasoning-nemotron-687730dae0170059860f1f01

关键不在于复杂的技巧,而在于原始数据。NVIDIA 使用 NeMo Skills 流水线生成了 500 万个数学、科学和代码解决方案,然后通过纯粹的监督学习对每个解决方案进行微调。目前,320 亿参数的模型在 AIME24 上获得了 89.2 分,在 HMMT 二月竞赛中获得了 73.8 分,而即使是 15 亿参数的版本也取得了 55.5 分和 31.5 分的稳定成绩。

NVIDIA 设想将这些模型打造为强大的研究工具包。所有四个检查点均可在 Hugging Face 上下载,为探索强化学习驱动的推理或针对特定任务定制模型奠定坚实的基础。使用 GenSelect 模式(每个问题进行多次迭代),可以生成多个并行生成并选出最佳答案,从而使 32B 模型的性能达到卓越水平,在多个数学和编码基准测试中堪比甚至超越 OpenAI 的 o3-high 性能。

![]()

由于 NVIDIA 仅使用监督微调训练这些模型,而未使用强化学习,因此社区拥有清晰、先进的未来强化学习实验起点。对于游戏玩家和家庭爱好者来说,如果您拥有更强大的游戏 GPU,我们将获得一个完全本地化的模型,该模型可以非常接近最先进的水平。