在Rust高性能编程圈,大家常常热议Tokio异步框架、SIMD向量化指令、锁分离等“硬核”优化手段。然而,一个常被忽视的底层“神器”——内存分配器(Allocator),却能以极小的改动,带来颠覆性的性能飞跃!

或许你还不知道,仅仅替换掉Rust程序默认的内存分配器,你的程序在高并发、大数据量场景下,吞吐量可以暴涨数倍,延迟更是可能减半! 这并非天方夜谭,而是经过严格实测的数据证明:

权威基准测试数据揭秘:

- 微软mimalloc官方报告:在Linux多线程严苛环境下,mimalloc相比glibc malloc平均性能提升高达5.3倍,同时内存占用(RSS)显著减少约50%。这意味着同样的资源下,你的服务能处理更多请求,成本更低!

- jemalloc官方论文:在4核服务器的真实负载测试中,默认的glibc malloc吞吐量仅为jemalloc的15%。对于追求极致并发的服务器应用,性能差距可见一斑!

本文将带你一起揭开内存分配器的神秘面纱,深度剖析其性能差距的根源,并手把手教你如何“一行代码”实现性能飞跃!

1. 🤔 内存分配器:你程序的“隐形大管家”

简单说,就是你程序堆内存的管理者。当你写下 Vec::with_capacity(100) 时,它就出手了。

Rust 默认的“管家”是系统自带的,比如 Linux 的 glibc malloc。它很通用,但在高并发下,就会变成性能的噩梦。

❌ 传统分配器的痛点:全局锁

在高并发下,所有线程都去抢同一把锁来申请内存,就像春运时所有人都挤一个售票窗口。

代码段

+-------------------------------------------+

| 传统分配器 (glibc malloc) |

| 一把全局大锁 🔒 管所有 |

+-------------------------------------------+

^ ^ ^ ^

| | | |

[线程1] [线程2] [线程3] [线程4]

(等待...) (等待...) (拿到锁!) (等待...)

结果就是:大量线程阻塞,CPU 在忙着线程切换而不是干活,性能直线下降!

✅ 现代分配器的破局:线程本地缓存

jemalloc 和 mimalloc 等现代分配器给每个线程都发了一个“VIP快速通道”。

代码段

+------------------+ +------------------+ +------------------+

| 线程1 本地缓存 | | 线程2 本地缓存 | | 线程3 本地缓存 |

| (无锁,飞速分配) | | (无锁,飞速分配) | | (无锁, 飞速分配) |

+------------------+ +------------------+ +------------------+

| | |

+------------------+------------------+

|

v

+----------------------------+

| 全局资源池 (低频访问) |

+----------------------------+

绝大多数内存操作都在自己的“小金库”里飞速完成,完全不用加锁!只有本地不够用了,才偶尔去全局池申请一下。

2. 🚀 为什么“换个管家”就能快几倍?核心原理拆解!

2.1 告别“全局锁地狱” 🔒

这是性能提升最核心的原因。现代分配器通过线程本地化,让多核 CPU 的每个核心都能火力全开,而不是把时间浪费在互相等待上。这完美释放了 Rust、Go 这类并发语言的全部潜力。

2.2 巧解“内存碎片” 🧩

频繁申请、释放内存,会把完整的内存搞得千疮百孔。

代码段

内存现状: | 已用 | 空闲(1格) | 已用 | 空闲(2格) | 已用 |

+------+-----------+------+-----------+------+

新请求: 我需要一块连续的3格内存...

结果: 内存总空闲 > 3,但因不连续,分配失败! -> 内存碎片化

现代分配器通过分桶 (Binning) 策略解决此问题。它们把内存按固定大小(如8字节、16字节、32字节)预先分好类。

代码段

+---------------------------------------------------------+

| 现代分配器的内存池 (Size Classes) |

+---------------------------------------------------------+

| [ 8字节池: [ ][ ][ ]... ] [ 16字节池: [ ][ ]... ] [ ... ] |

+---------------------------------------------------------+

同大小的请求在同个池子里复用,完美避开碎片,还因为数据更紧凑,大大提升了 CPU 缓存命中率!

2.3 优化“大内存”操作,减少 syscall 昂贵调用

对于几MB的大块内存,传统分配器每次都可能要向操作系统申请(mmap),这是一次昂贵的内核态切换。现代分配器则会一次性申请一大片内存(Arena),然后在用户空间自己管理,避免了频繁的系统调用开销。

3. 🔧 Rust 开发者专属:一行代码,完成替换!

在 Rust 里操作,简单到不可思议。我们以 mimalloc 为例:

- 添加依赖 到

Cargo.toml:

[dependencies]

# 微软出品的高性能分配器

mimalloc = "0.1"

- 声明全局分配器 在

main.rs 或任何一个 .rs 文件顶部:

#[global_allocator]

static GLOBAL: mimalloc::MiMalloc = mimalloc::MiMalloc;

fn main() {

// 你的代码一行都不用改!

}

搞定!编译运行,你的程序已经换上了性能猛兽!

⚠️ 注意:一个程序只能有一个全局分配器。如果要自己写条件编译来适配 Linux, macOS, Windows... 那也太麻烦了!下面给大家准备好了终极方案。

4. ✨ 终极方案:auto-allocator,告别“条件编译地狱”!

auto-allocator 是一个智能Rust库,自动检测你的编译目标,为每个平台选择最优内存分配器。无论是高并发服务器、移动端应用、WebAssembly前端,还是嵌入式设备,只需一行代码,你的Rust程序性能即可飙升!

🌟 全平台智能适配:

- Linux/Windows/macOS:启用高性能

mimalloc,吞吐量最高提升6倍!

- iOS:采用苹果官方优化的

libmalloc,性能与稳定性兼得。

- Android:切换到移动端优化的

scudo,兼顾安全与效率。

- WebAssembly (WASM):使用默认分配器,确保浏览器兼容性与Web标准合规。

- 嵌入式 (no_std):选择

embedded-alloc,适配资源受限的物联网设备。

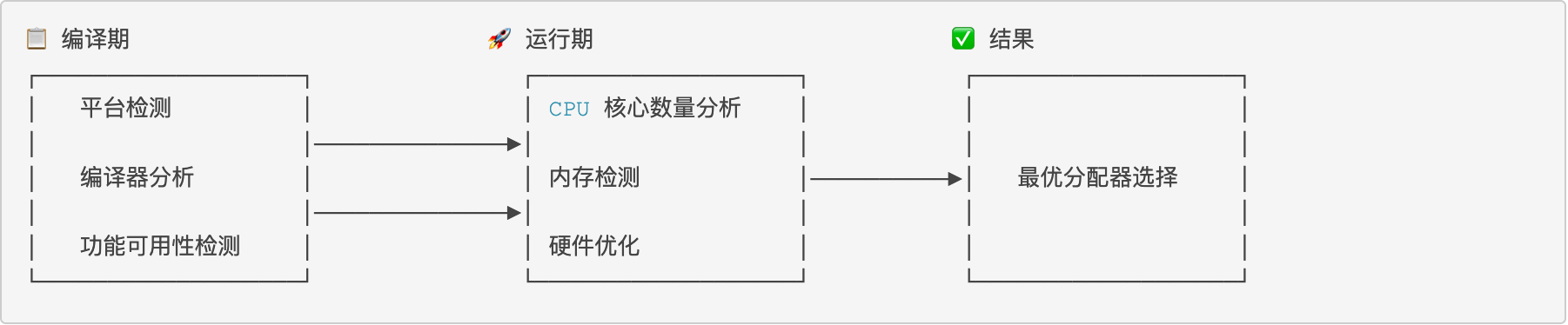

🔬 工作原理

Auto-Allocator 使用智能的两阶段优化: ![]()

🎯 90% 的决策在编译期完成,确保零运行时开销。

⚡ 仅在高性能平台上才需要运行期 CPU 检测。

使用方法:

- 添加依赖:

[dependencies]

# 引入智能分配器库,星号表示使用最新版

auto-allocator = "*"

- 在

main.rs 中引入:

// 只需在 main.rs 或 lib.rs 顶部引入即可,别的什么都不用干!

use auto_allocator;

fn main() {

// (可选) 验证一下它到底选了啥

let info = auto_allocator::get_allocator_info();

println!("当前使用的分配器: {:?},选择原因: {}", info.allocator_type, info.reason);

// --- 你的业务代码,享受自动优化带来的性能红利! ---

let data: Vec<i32> = (0..1_000_000).collect();

println!("创建了 {} 个元素的Vec,性能已在后台自动优化!", data.len());

}

一行 use 语句,一劳永逸!

想更安全?它也支持!

[dependencies]

# 开启 secure 特性,增加内存保护页等安全功能

auto-allocator = { version = "*", features = ["secure"] }

5. 总结:是时候给你的项目来一次“免费”的性能升级了!

回顾一下,通过替换内存分配器,你将获得:

- 🚀 更高的吞吐量:用同样的服务器,扛住翻倍的流量。

- 💰 更低的延迟与成本:服务响应更快,内存占用更少,直接节省成本。

- 🧩 更稳健的服务:告别内存碎片,提升长期运行的稳定性。

对于追求极致性能的你来说,这绝对是投入产出比最高的优化之一。

👇 现在就去试试吧!给你的 Cargo.toml 加上 auto-allocator,亲手见证性能奇迹!

https://github.com/YeautyYE/auto-allocator