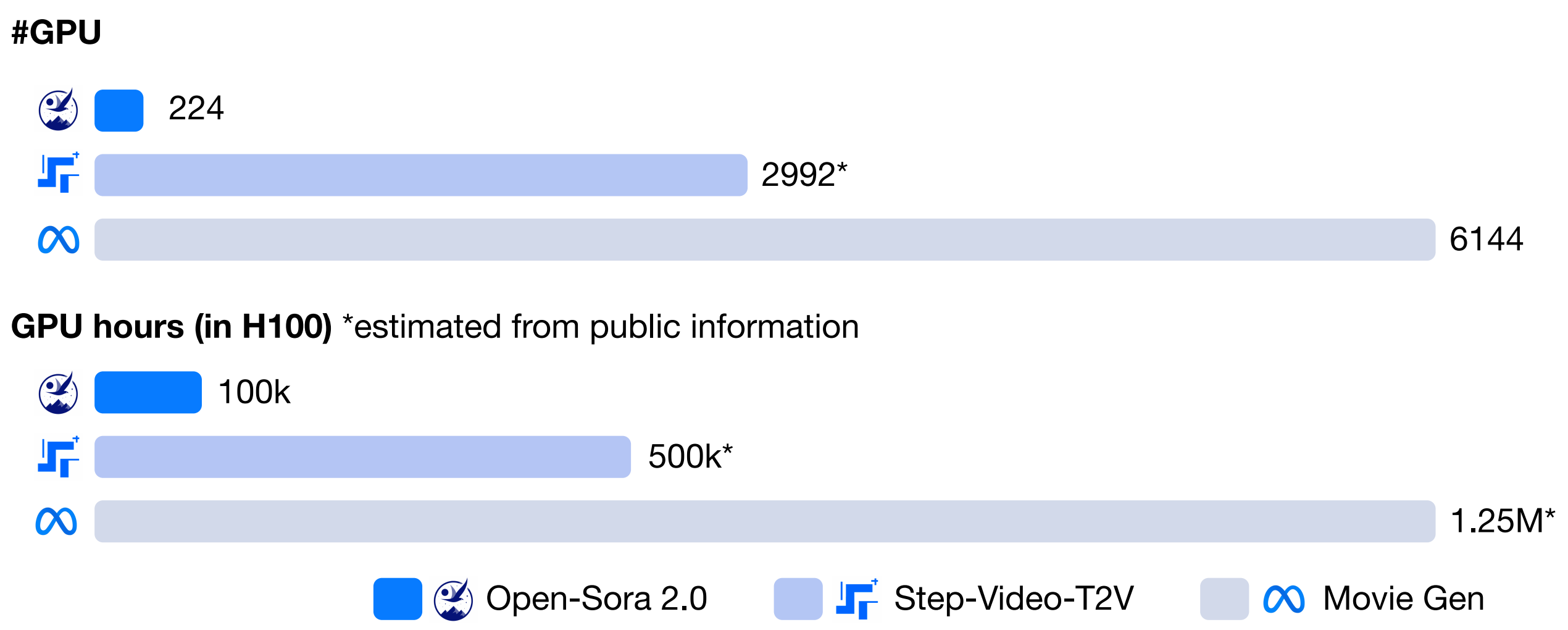

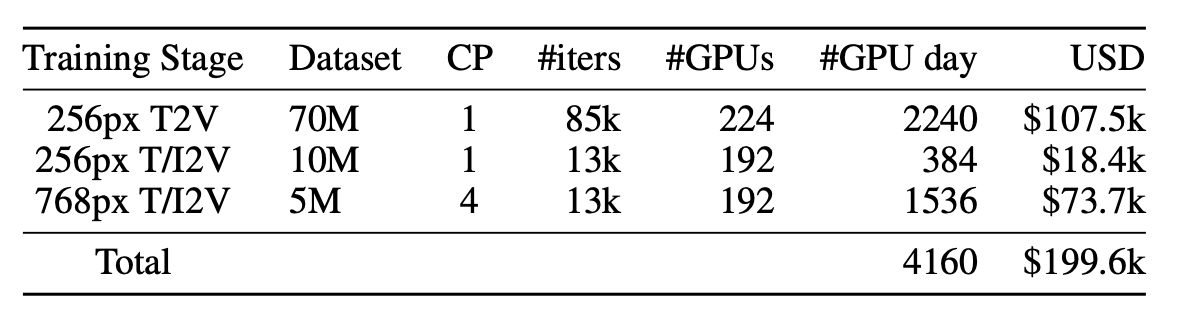

潞晨科技正式推出 Open-Sora 2.0 ------ 一款全新开源的 SOTA 视频生成模型,仅 20 万美元(224 张 GPU)成功训练商业级 11B 参数视频生成大模型。开发高性能的视频生成模型通常耗资高昂:Meta 的视频模型训练需要 6000 多张 GPU 卡片,投入数百万美元。

在多项关键指标上,它与动辄百万美元训练成本的模型分庭抗礼,全面提升视频生成的可及性与可拓展性。

![]()

今天,视频生成领域迎来开源革命!Open-Sora 2.0------全新开源的 SOTA(State-of-the-Art) 视频生成模型正式发布。

仅用 20 万美元(224 张 GPU) 成功训练出商业级 11B 参数视频生成大模型,性能直追 HunyuanVideo 和 30B 参数的 Step-Video。权威评测 VBench 及用户偏好测试均证实其卓越表现,在多项关键指标上媲美动辄数百万美元训练成本的闭源模型。

此次发布全面开源模型权重、推理代码及分布式训练全流程,让高质量视频生成真正触手可及,进一步提升视频生成的可及性与可拓展性。

![]()

GitHub 地址:github.com/hpcaitech/Open-Sora

1. 体验与指标双在线

1.1 震撼视觉:Open-Sora 2.0 Demo 先行

🎥 观看宣传片,体验 Open-Sora 2.0 的强大生成能力

![]()

🎥 动作幅度可控:可根据需求设定运动幅度,以更好地展现人物或场景的细腻动作。

![]()

🎥 画质与流畅度:提供 720p 高分辨率和 24 FPS 流畅视频,让最终视频拥有稳定帧率与细节表现。

![]()

🎥 丰富场景切换:从乡村景色到自然风光场景,Open-Sora 2.0 生成的画面细节与过渡平滑度都有出色的表现。

![]()

1.2 11B 参数规模媲美主流闭源大模型

媲美 HunyuanVideo 和 30B Step-Video:

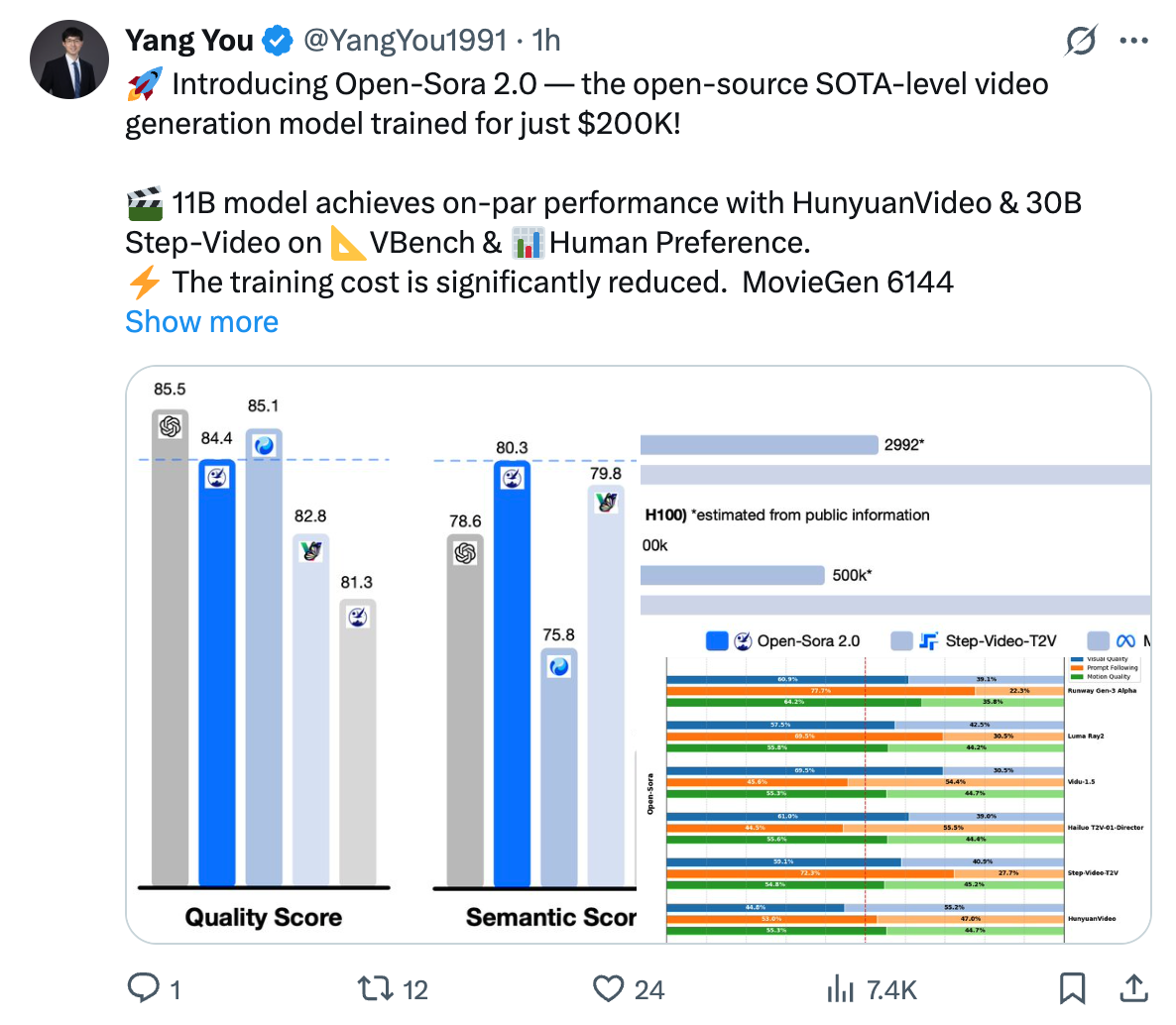

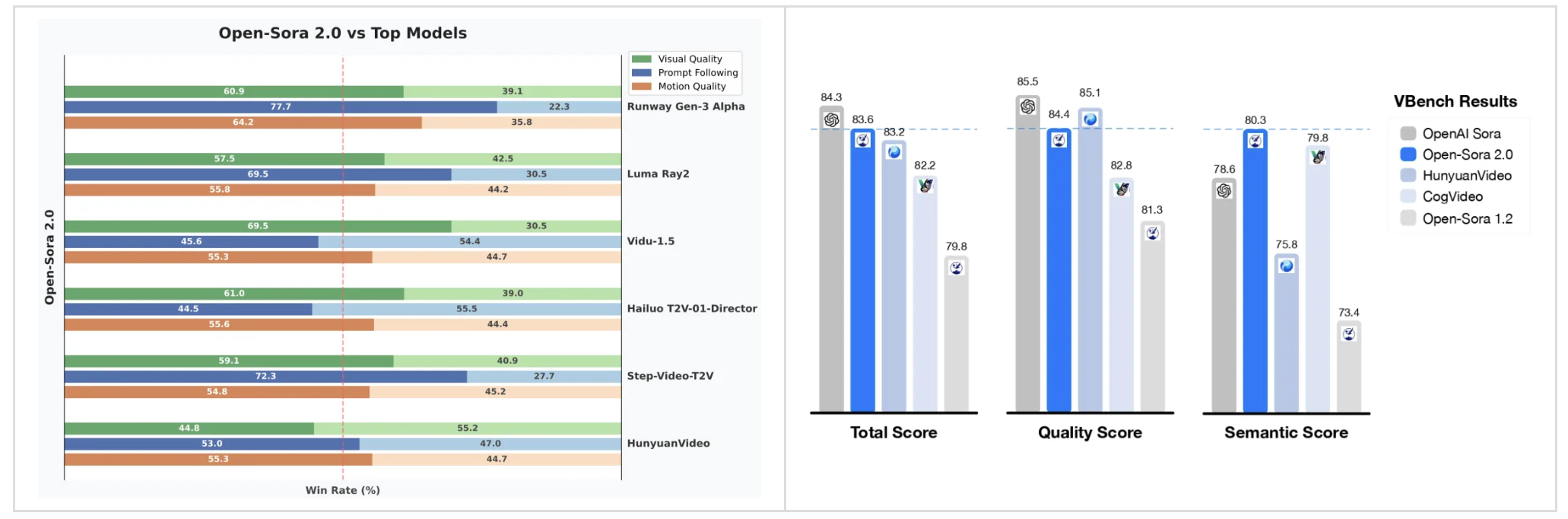

Open-Sora 2.0 采用 11B 参数规模 ,训练后在 VBench 和人工偏好(Human Preference) 评测上都取得与用高昂成本开发的主流闭源大模型同等水平。

用户偏好评测:

在视觉表现、文本一致性和动作表现三个评估维度上,Open Sora 在至少两个指标上超越了开源 SOTA HunyuanVideo,以及商业模型 Runway Gen-3 Alpha 等,以小成本获取了好性能。

![]()

VBench 指标表现强势:

根据视频生成权威榜单 VBench 的评测结果,Open-Sora 模型的性能进步显著。从 Open-Sora 1.2 升级到 2.0 版本后,与行业领先的 OpenAI Sora 闭源模型之间的性能差距大幅缩小,从之前的 4.52% 缩减至仅 0.69%,几乎实现了性能的全面追平。

此外,Open-Sora 2.0 在 VBench 评测中取得的分数已超过腾讯的 HunyuanVideo,以更低的成本实现了更高的性能,为开源视频生成技术树立了全新标杆!

2. 实现突破:低成本训练与高效能优化

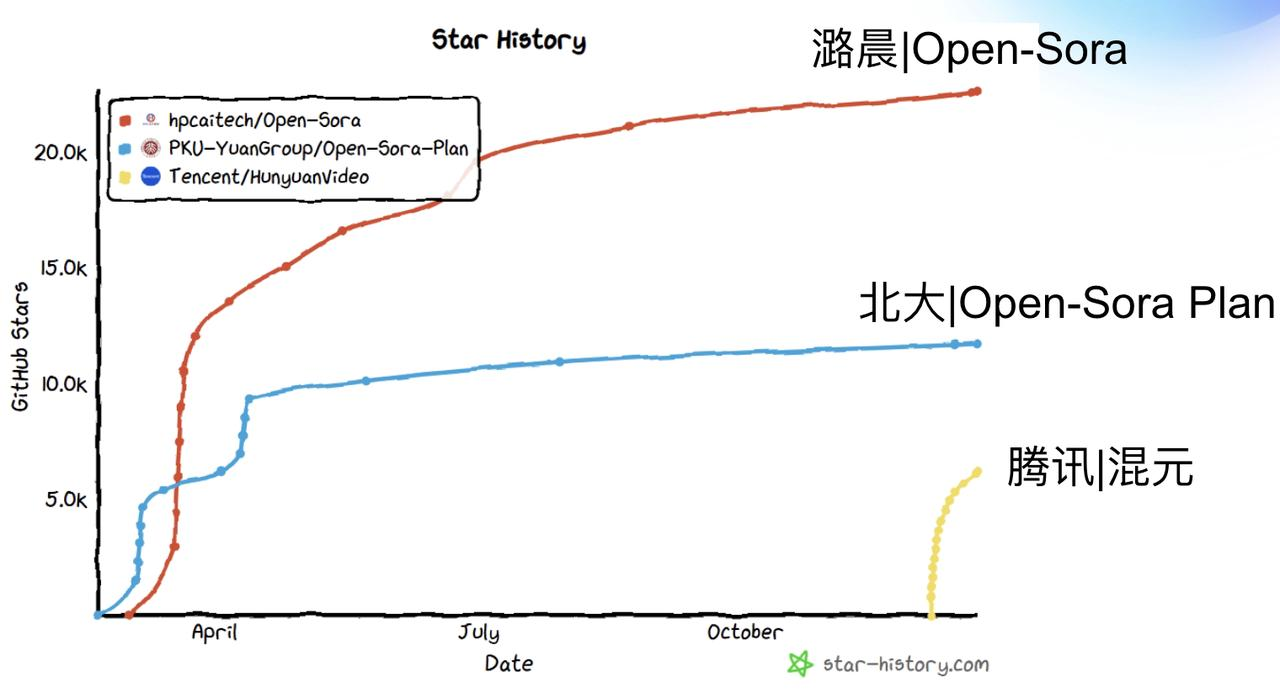

Open Sora自开源以来,凭借其在视频生成领域的高效与优质表现,吸引了众多开发者的关注与参与。然而,随着项目的深入推进,也面临着高质量视频生成成本居高不下的问题。

为解决这些挑战,Open Sora团队展开了一系列卓有成效的技术探索,显著降低了模型训练成本。根据估算,市面上 10B 以上的开源视频模型,动辄需要上百万美元的单次训练成本,而 Open Sora 2.0 将该成本降低了 5-10 倍。

![]()

作为开源视频生成领域的领导者,Open-Sora 不仅继续开源了模型代码和权重,更开源了全流程训练代码,成功打造了强大的开源生态圈。

据第三方技术平台统计,Open-Sora 的学术论文引用量半年内获得近百引用,在全球开源影响力排名中稳居首位,领先所有开源的 I2V/T2V 视频生成项目,成为全球影响力最大的开源视频生成项目之一。

![]()

2.1 模型架构

Open-Sora 2.0 延续 Open-Sora 1.2 的设计思路,继续采用 3D 自编码器 和 Flow Matching 训练框架 ,并通过多桶训练机制,实现对不同视频长度和分辨率的同时训练。

在模型架构上,引入 3D 全注意力机制 ,进一步提升视频生成质量。同时,采用最新的 MMDiT 架构 ,更精准地捕捉文本信息与视频内容的关系 ,并将模型规模从 1B 扩展至 11B 。此外,借助 开源图生视频模型 FLUX 进行初始化,大幅降低训练成本,实现更高效的视频生成优化。

2.2 高效训练方法和并行方案全开源

为了追求极致的成本优化,Open-Sora 2.0 从四个方面着手削减训练开销。

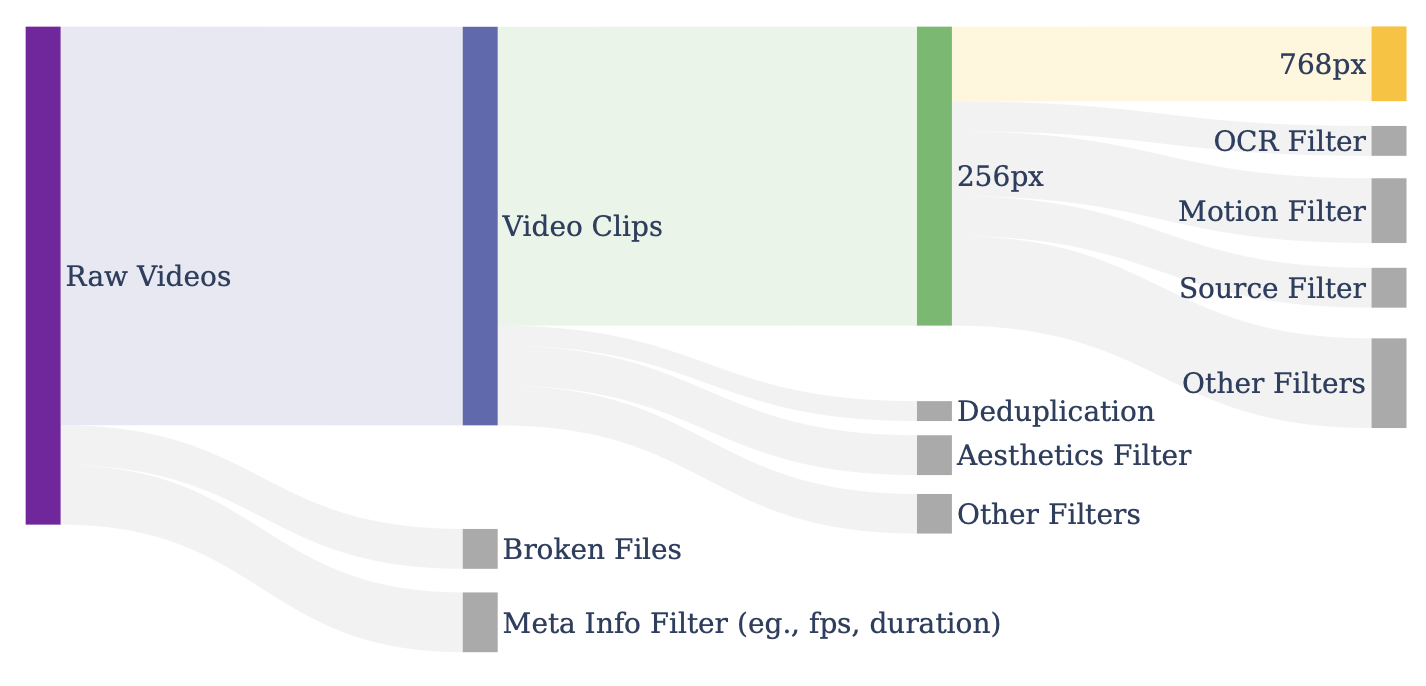

首先,通过严格的数据筛选 ,确保高质量数据输入,从源头提升模型训练效率。采用多阶段、多层次的筛选机制,结合多种过滤器,有效提升视频质量,为模型提供更精准、可靠的训练数据。

![]()

其次,高分辨率训练的成本远超低分辨率,达到相同数据量时,计算开销可能高达 40 倍 。以 256px、5 秒 的视频为例,其 tokens 数量约 8 千 ,而 768px 的视频 tokens 数量接近 8 万 ,相差 10 倍 ,再加上注意力机制的平方级计算复杂度,高分辨率训练的代价极其昂贵。

因此,Open-Sora 优先将算力投入到低分辨率训练,以高效学习运动信息,在降低成本的同时确保模型能够捕捉关键的动态特征。

![]()

与此同时,Open-Sora 优先训练图生视频任务 ,以加速模型收敛。相比直接训练高分辨率视频,图生视频模型在提升分辨率时具备更快的收敛速度 ,从而进一步降低训练成本。在推理阶段,除了直接进行文本生视频(T2V) ,还可以结合开源图像模型 ,通过文本生图再生视频(T2I2V),以获得更精细的视觉效果。

最后,Open-Sora 采用高效的并行训练方案 ,结合 ColossalAI 和系统级优化,大幅提升计算资源利用率,实现更高效的视频生成训练。为了最大化训练效率,我们引入了一系列关键技术,包括:

-

高效的序列并行和 ZeroDP,优化大规模模型的分布式计算效率。

-

细粒度控制的 Gradient Checkpointing,在降低显存占用的同时保持计算效率。

-

训练自动恢复机制,确保 99% 以上的有效训练时间,减少计算资源浪费。

-

高效数据加载与内存管理,优化 I/O,防止训练阻塞,加速训练流程。

-

高效异步模型保存,减少模型存储对训练流程的干扰,提高 GPU 利用率。

-

算子优化,针对关键计算模块进行深度优化,加速训练过程。

这些优化措施协同作用,使 Open-Sora 2.0 在高性能与低成本之间取得最佳平衡,大大降低了高质量视频生成模型的训练。

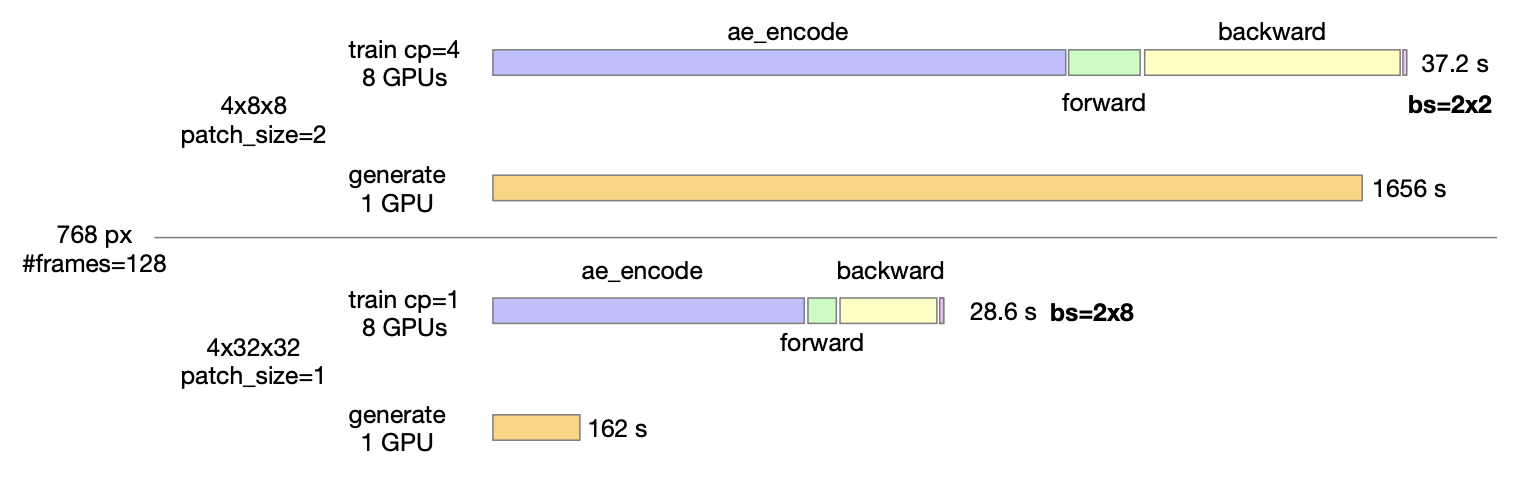

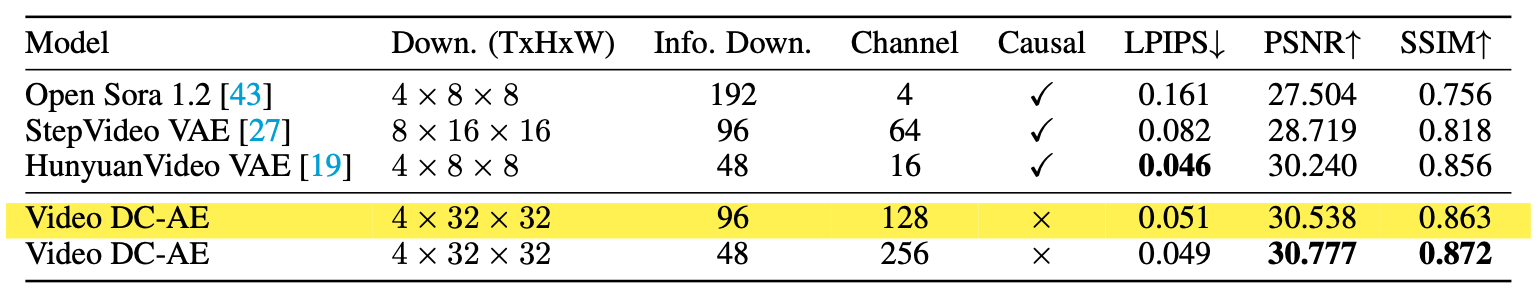

2.3 高压缩比 AE 带来更高速度

在训练完成后,Open-Sora 面向未来,进一步探索高压缩比视频自编码器 的应用,以大幅降低推理成本。目前,大多数视频模型仍采用 4×8×8 的自编码器,导致 单卡生成 768px、5 秒视频耗时近 30 分钟 。为解决这一瓶颈,Open-Sora 训练了一款高压缩比(4×32×32)的视频自编码器,将推理时间缩短至单卡 3 分钟以内 ,推理速度提升 10 倍。

![]()

要实现高压缩比编码器,需要解决两个核心挑战:如何训练高压缩但仍具备优秀重建效果的自编码器 ,以及如何利用该编码器训练视频生成模型。

针对前者,Open-Sora 团队在视频升降采样模块中引入残差连接 ,成功训练出一款重建质量媲美当前开源 SoTA 视频压缩模型 ,且具备更高压缩比的 VAE,自此奠定了高效推理的基础。

![]()

高压缩自编码器在训练视频生成模型时面临更高的数据需求和收敛难度 ,通常需要更多训练数据 才能达到理想效果。为解决这一问题,Open-Sora 提出了基于蒸馏的优化策略 ,以提升 AE(自编码器)特征空间的表达能力 ,并利用已经训练好的高质量模型作为初始化,减少训练所需的数据量和时间。

此外,Open-Sora 还重点训练图生视频任务 ,利用图像特征引导视频生成,进一步提升高压缩自编码器的收敛速度,使其在更短时间内达到一定生成效果。

Open-Sora 认为,高压缩比视频自编码器将成为未来降低视频生成成本的关键方向 。目前的初步实验结果已展现出显著的推理加速效果,希望能进一步激发社区对这一技术的关注与探索,共同推动高效、低成本的视频生成发展。

3. 加入 Open-Sora 2.0,共同推动 AI 视频革命

🎬 今天,Open-Sora 2.0 正式开源!

💡 欢迎加入 Open-Sora 社区,探索 AI 视频的未来!

Open-Sora 2.0,未来已来 。让我们用更少的资源、更开放的生态,创造属于下一代的数字影像世界! 🎬✨