2024 年 2 月 29 日,经过密集的精心训练与严格的测试验证,RWKV 开源基金会宣布其划时代的 RWKV-6-Finch 3B 模型正式向全球开源。

本次开源的 RWKV-6-Finch 3B 模型,为 RWKV 第六代架构中的 3B 参数级大型语言模型。与前代 RWKV-5 相比较,RWKV-6 不仅在多语言处理能力上实现了革命性的飞跃,其在角色扮演等领域的表现也格外出色,显著超越以往所有模型。

![]()

图:RWKV-6-Finch 3B 扮演一位炼金术士

迭代后的 RWKV-6 已在效果、计算效率、能耗上领先于 Transformer 同参数模型,彰显了其领先技术的卓越成就。

我们将继续在 World-2.1(1.4T)上训练 RWKV-6 模型,以提高性能。更加强大的 RWKV-6.1 版本将于两个月后面世,期待与大家共同见证。

评测数据

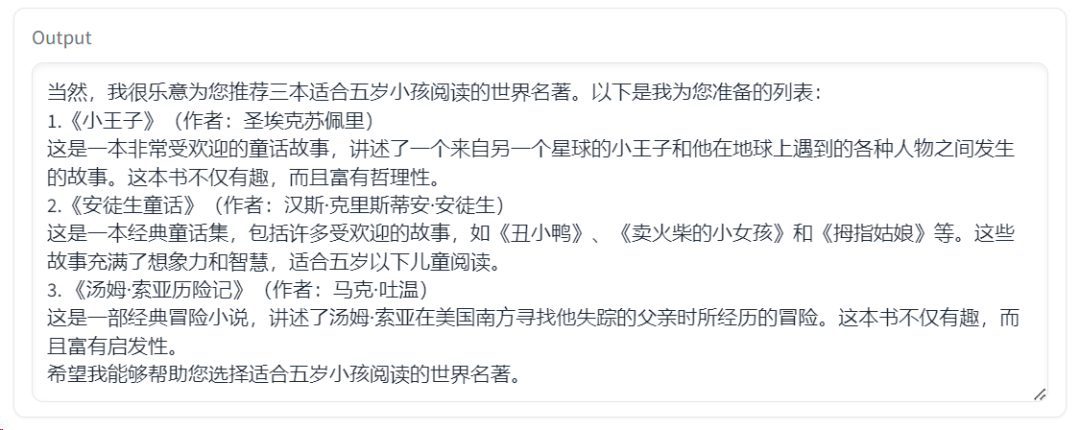

本次评测涵盖了 14 款接近 3B 参数规模的开源大语言模型,其中不乏 RWKV 系列中的前代佳作,如 RWKV-4 和 RWKV-5。

其中,英语的性能测试将通过 12 个独立的基准测试来衡量大模型在常识推理和世界知识等英语内容上的表现。而多语言能力的评估中,则采用了 xLAMBDA、xStoryCloze、 xWinograd 和 xCopa 四种基准测试,深度探索了评估模型在多语言环境中的逻辑推理、故事理解、歧义解决和因果推理能力。

![]()

图:14 款 3B 参数模型基准测试结果

测试结果印证了 RWKV-6-Finch 3B 在英语和多语言测试中的卓越表现,相较于同规模的 RWKV-v5 模型,展现了显著的进步。

在多语言能力的评估中,RWKV-6-Finch 3B 以 58.9% 的高分领跑,不仅超越了其他参评模型,甚至略胜于 Mistral 7B 的 58.2% 。

模型试玩 & 下载

在线 Demo:https://huggingface.co/spaces/BlinkDL/RWKV-Gradio-1

下载地址:https://huggingface.co/BlinkDL/rwkv-6-world/blob/main/RWKV-x060-World-3B-v2-20240228-ctx4096.pth

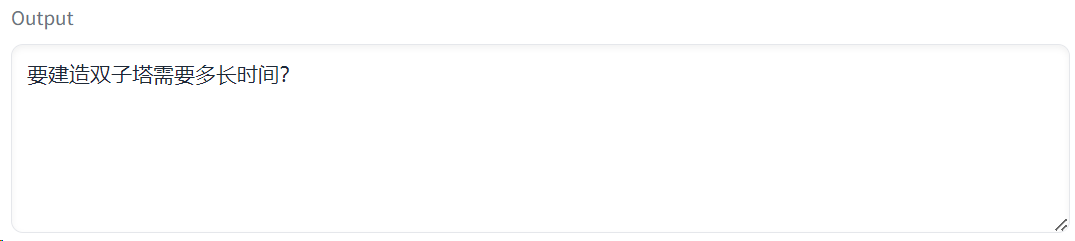

💡由于 Hugging Face 的在线 Demo 是续写模式,如果你在 RWKV-Gradio-1 中体验 RWKV-6 Finch 3B 模型,我们建议您按以下两种格式输入提示词(prompts) :

User: hi

Assistant: Hi. I am your assistant and I will provide expert full response in full details. Please feel free to ask any question and I will always answer it.

User: (你的问题,比如“请为我推荐三本适合五岁小孩阅读的世界名著” )

Assistant:

运行效果:

![]()

2

Instruction: (你希望模型进行什么操作,比如“请将下列瑞典语翻译成中文”)

Input:(你希望模型处理哪些内容,比如“hur l?ng tid tog det att bygga twin towers”)

Response:

运行效果:

![]()

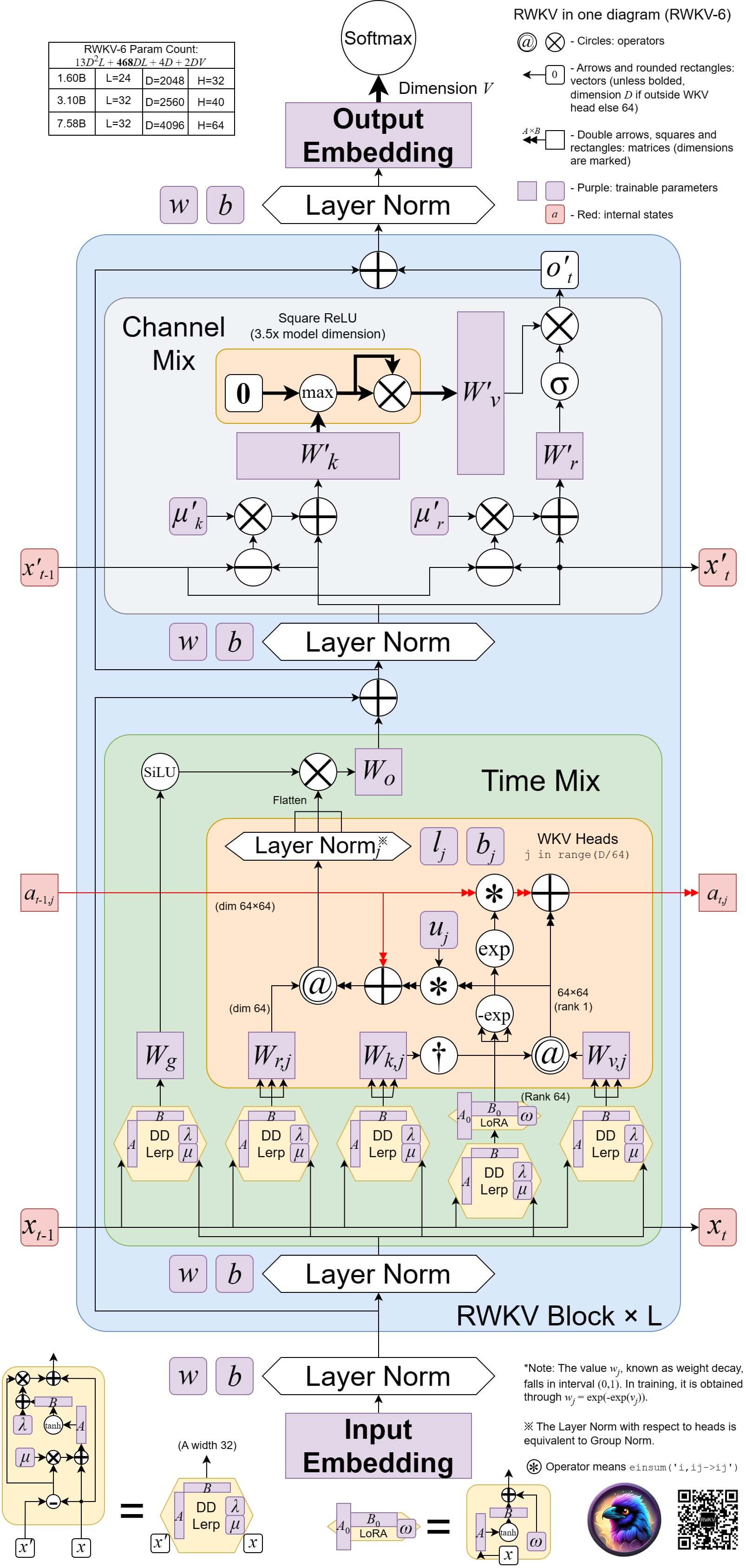

RWKV 模型介绍

RWKV 是一种创新的深度学习网络架构,它将 Transformer 与 RNN 各自的优点相结合,同时实现高度并行化训练与高效推理,时间复杂度为线性复杂度,在长序列推理场景下具有优于 Transformer 的性能潜力。

我们的最新版本是 RWKV V6 ,架构图如下:

![]()

图:RWKV V6 架构

相对 Transformer 架构,RWKV 架构的推理成本降低 2~10 倍,训练成本降低 2~3 倍。

RWKV 模型最初由彭博设计,主要算力由 Stability AI 和 AI Eleuther 等机构捐赠。如今,RWKV 已捐赠给 Linux Foundation AI&Data 作为孵化项目。