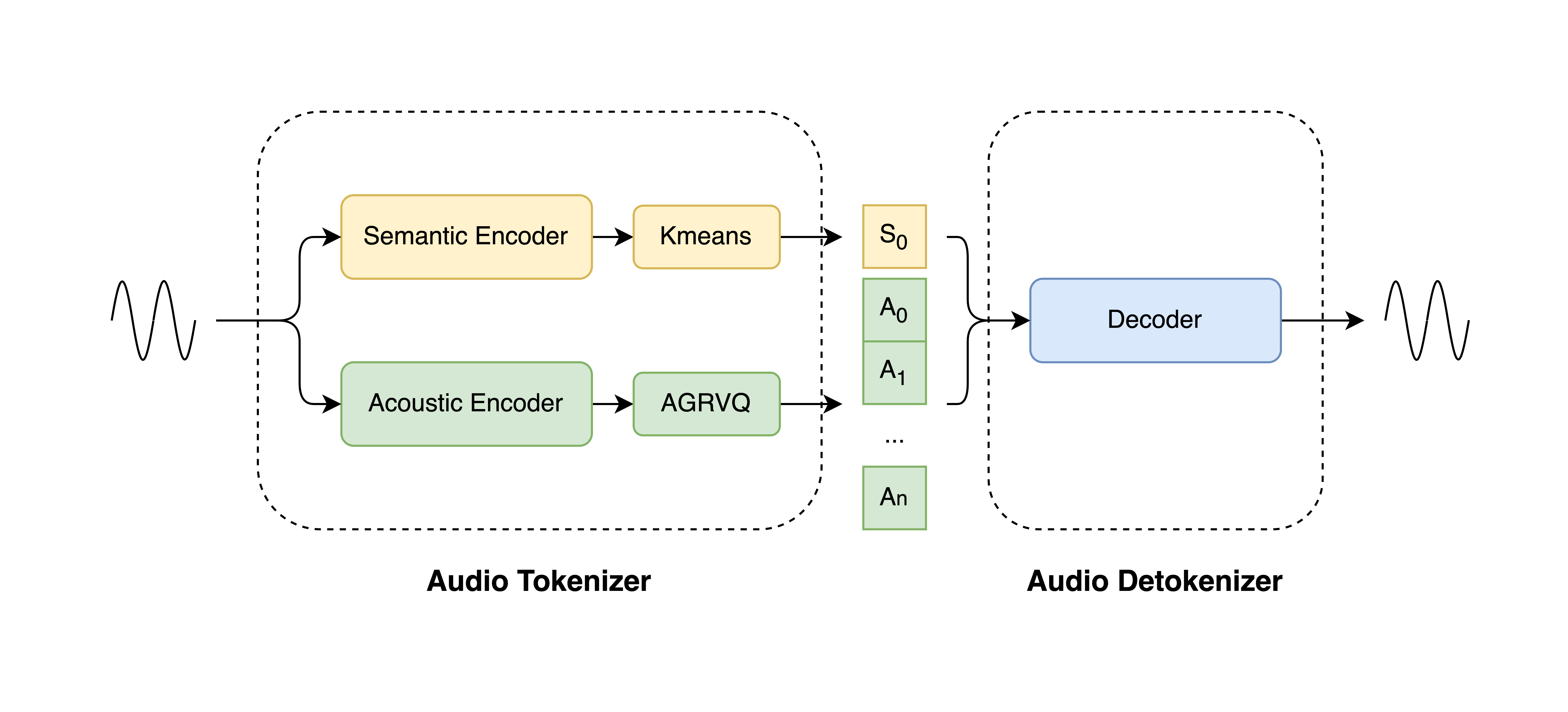

美团 LongCat 团队正式开源专用语音编解码方案 LongCat-Audio-Codec。它提供了一套一站式的 Token 生成器(Tokenizer)与 Token 还原器(DeTokenizer)工具链,其核心功能是将原始音频信号映射为语义与声学并行的 token 序列,实现高效离散化,再通过解码模块重构高质量音频,为 Speech LLM 提供从信号输入到输出的全链路音频处理支持。

开源平台:

Github:https://github.com/meituan-longcat/LongCat-Audio-Codec

Hugging Face:https://huggingface.co/meituan-longcat/LongCat-Audio-Codec

![]()

LongCat-Audio-Codec 模型架构图如下:

![]()

据介绍,LongCat-Audio-Codec 核心竞争力源于三大创新设计:

设计一:语义 - 声学双 Token 并行提取机制:兼顾理解与生成

为解决语义空间干扰声学空间导致的重构质量不佳的问题,LongCat-Audio-Codec 采用 “级联训练 - 并行推理” 的创新设计:

同时,该方案支持声学码本的动态配置,可以在保证语义能力一致的情况下,根据下游任务调整码本层数。如下游任务是少音色场景,则可以选择单个声学码本来减少 Speech LLM 的学习压力;如果下游任务是多音色场景,则可以选择全部声学码本来提供丰富的说话人支持。

设计二:低延迟流式解码器:兼顾实时与质量

低延时流式处理能力是 Speech LLM 实时交互场景(如车载语音助手、实时翻译)的核心需求,其关键指标为端到端延迟(End-to-End Latency)。传统解码架构没有专为流式场景设计,易导致实时交互延迟高(如实时翻译卡半秒),LongCat-Audio-Codec 通过低延迟流式解码器解决这一问题。其解码器采用帧级增量处理模式,通过控制对未来语音 Token 的依赖,将解码延迟控制在百毫秒级。该架构显著提升了 Speech LLM 的交互实时性,满足工业级实时响应标准。

设计三:超低比特率高保真与集成超分辨率设计:兼顾压缩效率与音质

为解决 “低比特率音质劣化”和“超分辨率需额外模型” 问题,LongCat-Audio-Codec 采用协同优化设计:

-

超低比特率:比特率是衡量音频压缩效率的核心指标, 依托模型优化与三阶段训练机制,通过降低信息量,从而在保证 Speech LLM 能够从海量数据中学习到语音的本质同时,降低 Speech LLM 的训练难度,也为 Speech LLM 的规模化落地提供了支撑。

-

集成超分辨率:LongCat-Audio-Codec 将超分辨率思想嵌入解码器,通过神经网络对重建音频进行频域补全。该集成设计不仅进一步提高了核心内容的压缩率,更通过提升输出音频的采样率,增强了语音的自然度与细节表现力。

通过创新的架构设计与训练策略,LongCat-Audio-Codec 在语义建模、声学重建、流式合成三大维度实现突破。