2025 年 9 月 22 日, RWKV7-G1a 1.5B 推理模型(Reasoning Model)正式开源发布。

RWKV7-G1a 1.5B 从 RWKV7-G1 1.5B 继续训练 1T 高质量数据,显著提升模型能力,且加入新的推理风格,可设置推理长度。

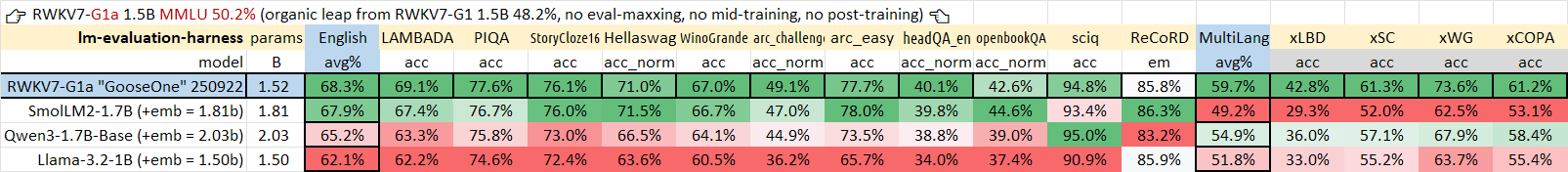

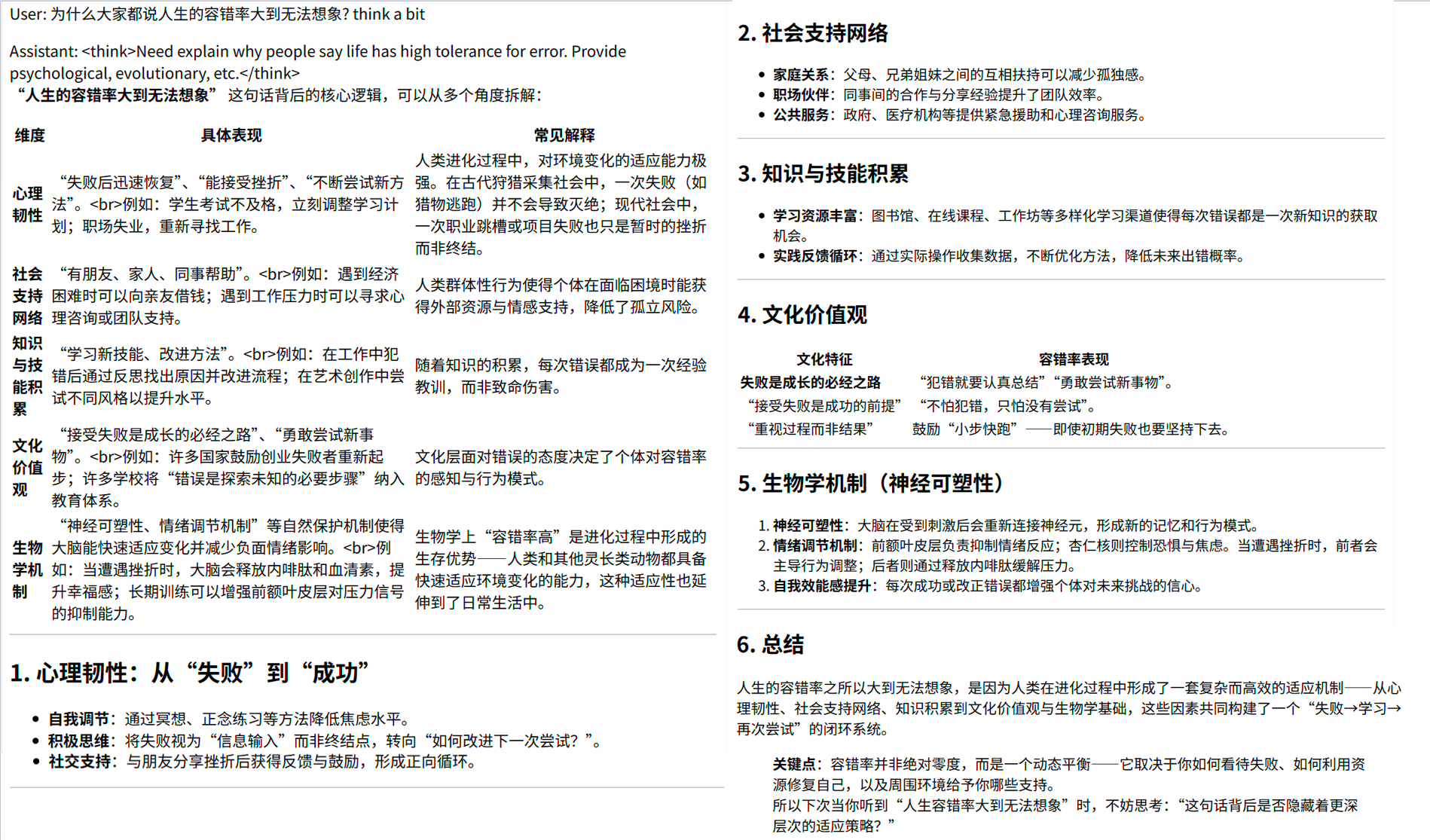

模型客观指标评测

英语和多语言能力

RWKV7-G1a 1.5B 的基础英语和多语言能力均强于同规模的开源模型:

![eval]()

RWKV7-G1a 1.5B 的 MMLU 为 50.2%(RWKV7-G1 1.5B 为 48.2%)。注意这是没有使用任何 mid-training 和 post-training 的真实基底模型成绩。

我们正在训练 RWKV7-G0 13.3B,在训练 63% 时 MMLU 已达 71.4%。预计十月发布。

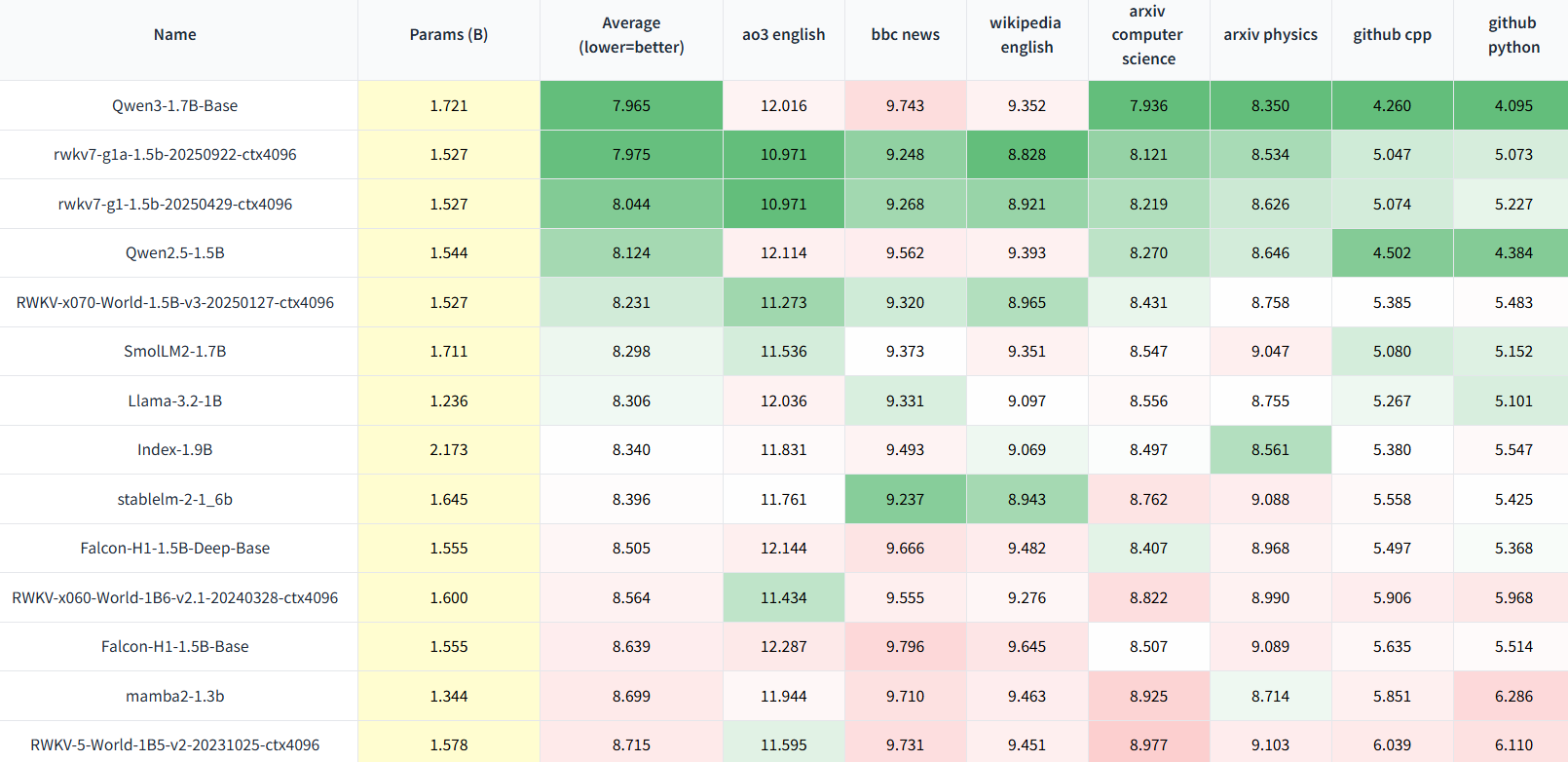

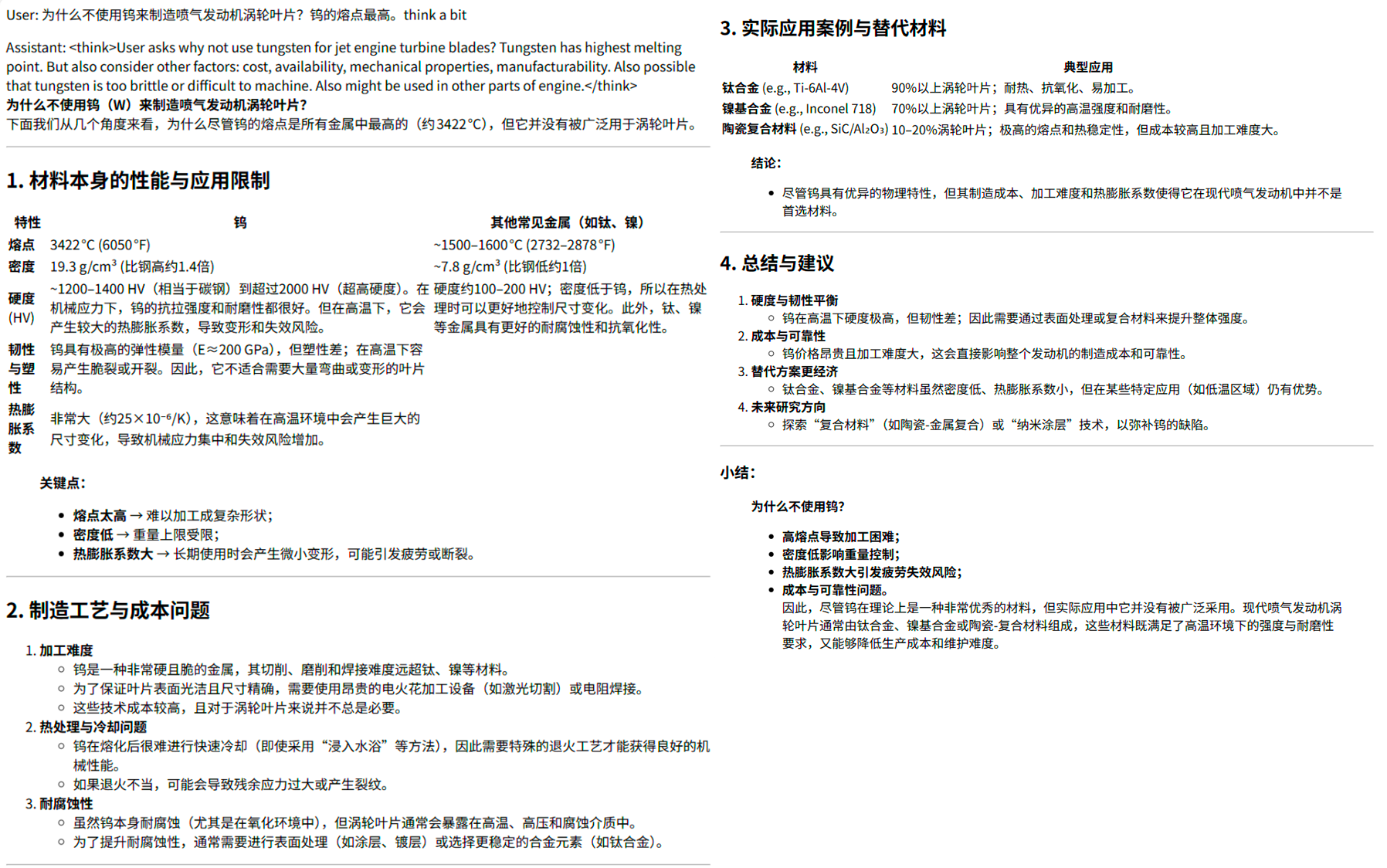

无法作弊的评测

Uncheatable Eval 是"无法作弊的评测",它使用最新的论文/新闻/代码/小说等实时数据,测试压缩率("压缩即智能"),评估基底语言模型的真实语言建模能力和泛化能力。

RWKV7-G1a 1.5B 的 Uncheatable Eval 显著提升,已非常接近 1.7B 参数的 Qwen3-1.7B-Base。

![Uncheatable Eval]()

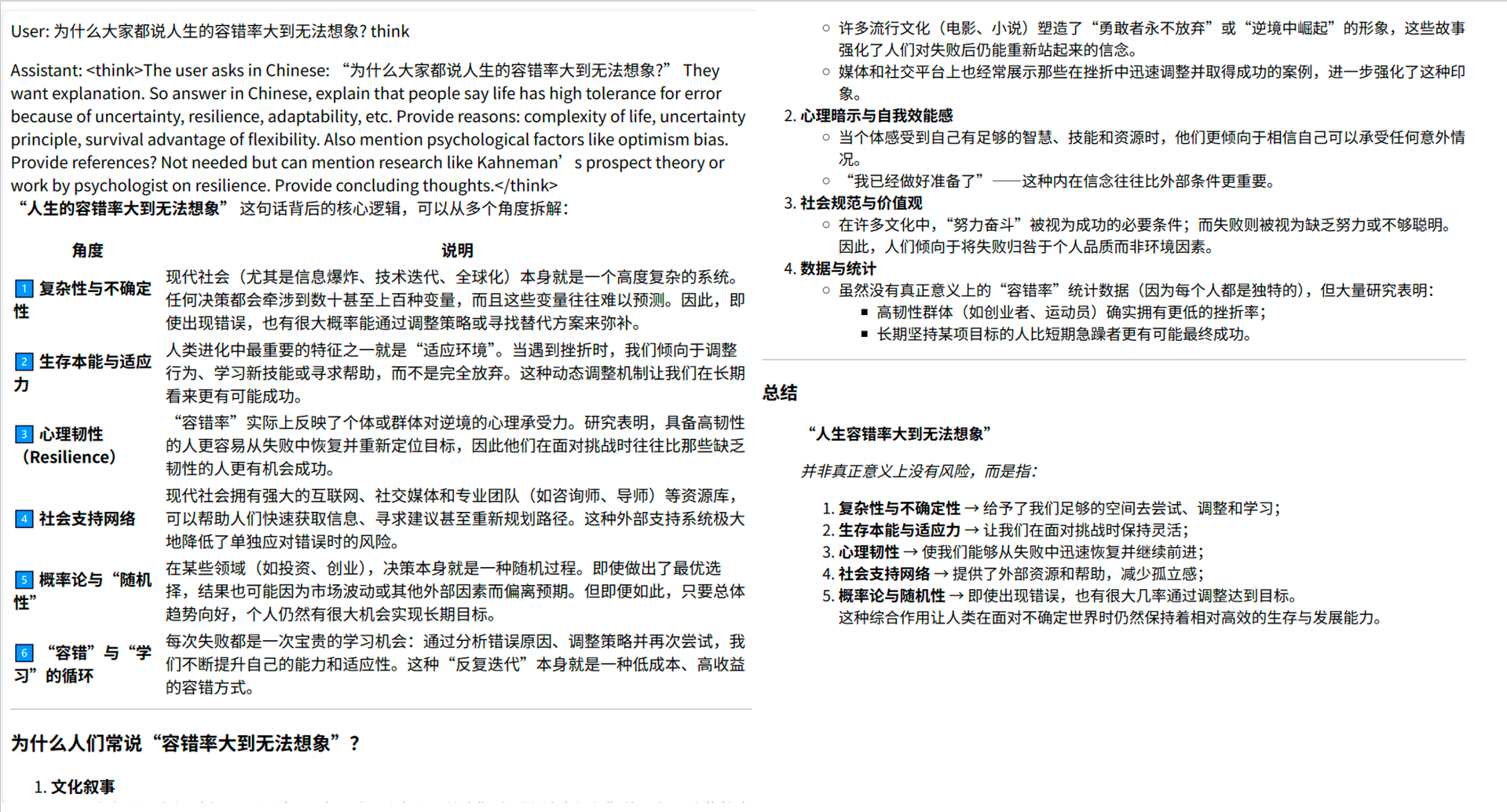

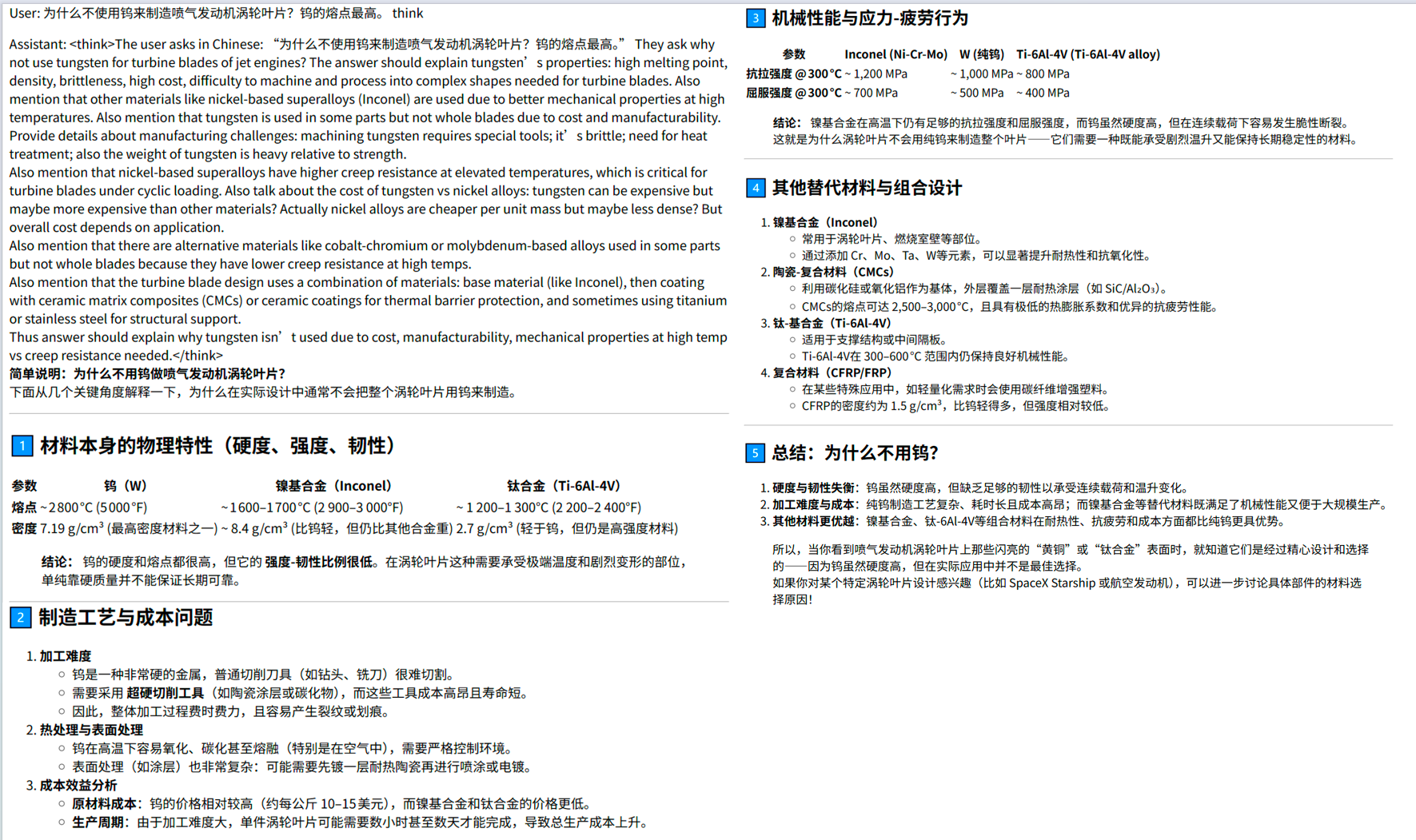

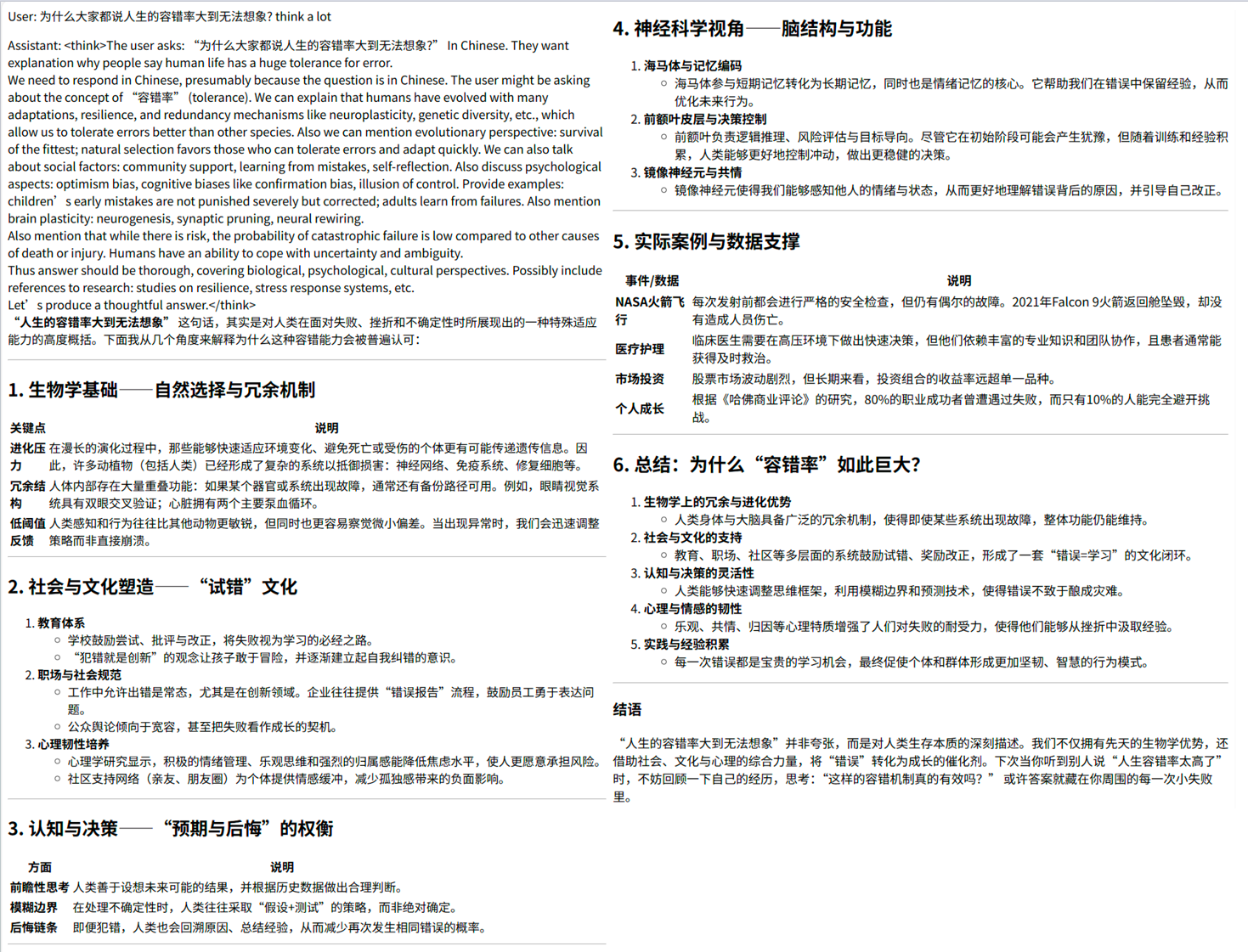

多种推理风格

RWKV7-G1a 1.5B 加入了一种新推理风格,通过在问题后加入【 think】引导。

新推理风格

新推理风格的提示词格式:

User: USER_PROMPT think

Assistant: <think

注意在 USER_PROMPT 后的【 think】和前文之间必须有恰好一个空格。如果不添加【 think】,模型会以默认推理风格进行思考。

下面是 RWKV7-G1a 1.5B 使用新推理风格的效果,注意此时它会使用英语思考:

-

非技术问题 ![]()

-

技术问题 ![]()

新推理风格,短思考

通过【 think a bit】可缩短新推理风格的思考长度。提示词格式:

User: USER_PROMPT think a bit

Assistant: <think

-

非技术问题 ![]()

-

技术问题 ![]()

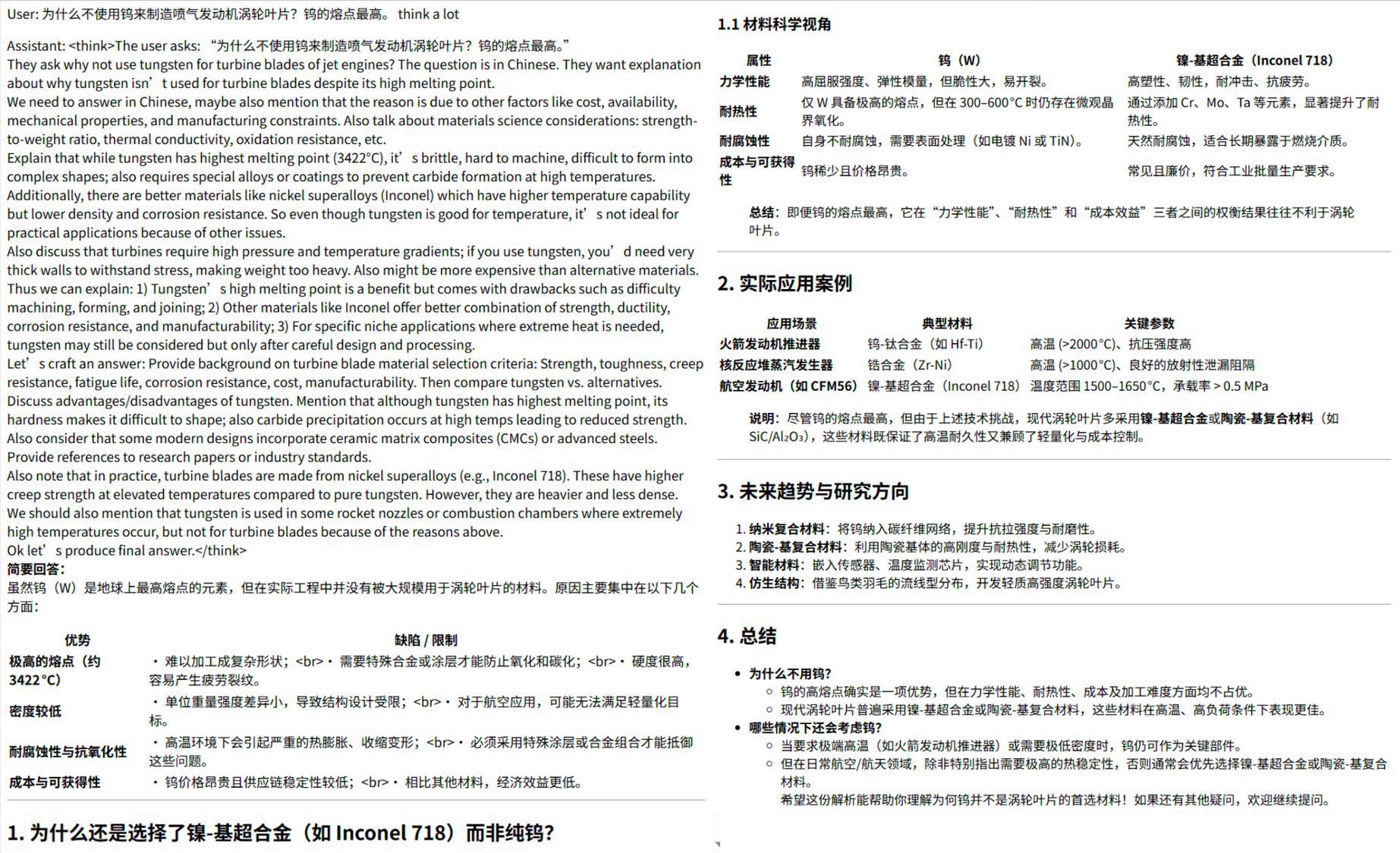

新推理风格,长思考

通过【 think a lot】可增加新推理风格的思考长度。提示词格式:

User: USER_PROMPT think a lot

Assistant: <think

-

非技术问题 ![]()

-

技术问题 ![]()

这里的新推理风格和长度控制,仅适用于 2025 年 9 月 22 日及之后发布的 RWKV7-G 系列模型(从 RWKV7-G1a 1.5B 开始)。我们会陆续升级各个尺寸的模型。例如,几天后发布 RWKV7-G1a 2.9B。

"假"思考模式

最后,对于所有 RWKV7-G 系列模型,通过在提示中加入空 think 标签,可以模拟一个"已完成思考"的上下文,引导模型生成有结构和逻辑的回复。

提示词格式:

User: USER_PROMPT

Assistant: <think>

</think

-

非技术问题 ![]()

-

技术问题 ![]()

解码参数推荐

RWKV 的运行工具均支持调整模型的解码参数,您可以调整解码参数适应不同任务的特点。

下面是推荐的解码参数:

| 模式 |

Temp |

Top-p |

Presence Penalty |

Frequency Penalty |

Penalty Decay |

主要特点与适用场景 |

| 默认 |

1.0 |

0.3 |

0.5 |

0.5 |

0.996 |

默认的推荐解码参数 |

| 综合 |

1.0 |

0.3 |

2 |

0.2 |

0.99 |

另一种推荐解码参数 |

| 创意 |

0.6 |

0.6 ~ 0.8 |

2 |

0.2 |

0.99 |

思维发散,想象力强 |

| 保守 |

0.3 |

0.3 |

0 |

0 |

0.99 |

适合数学和机械任务 |

| 固定 |

0.2 |

0 |

0 |

0 |

0.99 |

最保守的输出 |

如果你对这些解码参数的含义不熟悉,可以参考 RWKV 官网关于解码参数的文档:RWKV 的解码参数

模型下载

下载 RWKV7-G1a 1.5B 模型:

如何使用 RWKV 模型

可以使用 RWKV Runner、Ai00、RWKV pip 等推理工具本地部署 RWKV 模型。

此外,RWKV 模型也适配了 llama.cpp、ollama 等热门的模型推理工具。

由于 RWKV7-G1a 1.5B 是新模型,目前建议使用 RWKV Runner 以保证得到正确结果。

可以在 RWKV 官网 - 模型推理教程中查看上述推理工具的使用教程。

加入 RWKV 社区

欢迎大家加入 RWKV 社区,可以从 RWKV 中文官网了解 RWKV 模型,也可以加入 RWKV 论坛、QQ 频道和 QQ 群聊,一起探讨 RWKV 模型。

欢迎大家基于 RWKV-7 进行创业、科研,我们也会为基于 RWKV 的项目提供技术支持。

如果您的团队正在基于 RWKV 创业或开展研究,请联系我们!(在"RWKV元始智能"微信公众号留言您的联系方式,或发送邮件到"contact@rwkvos.com"。)