在人工智能迈向「智算融合」的新时代,大模型凭借其强大的认知与推理能力,正逐步重塑千行百业的智能化图景。然而,大模型推理环节的高算力消耗、高延迟与高能耗问题,成为其规模化落地的关键掣肘。破解这一瓶颈,既需构建高效能、低时延的算力基础设施,也依赖从芯片到应用的全产业链协同创新。

与此同时,在全球化技术博弈与数字化转型的双重驱动下,中国AI产业也正在经历一场从硬件底座到软件生态的"全栈重构"。许多厂商纷纷转入以昇腾(Ascend)计算平台为基础的生态之中。昇腾作为国产AI算力的核心引擎,通过软硬件协同优化与异构计算架构创新,为大模型推理提供了高效能、低时延的部署方案。

随着昇腾在企业中的采用率持续攀升,加之基于其底层基础设施的大模型应用生态日趋完善,OSCHINA邀请某国企人工智能技术负责人,公众号“数学建模岛”主理人熊文韬一起聊了聊关于国产算力替代的真实挑战和基于昇腾的大模型推理优化的几个路径,以期为国产AI技术栈的构建提供可复用的经验样本。

国产化替代并非简单的设备更换,还需生态加持

国产化适配是国企数字化转型中的核心命题。熊文韬介绍,早期项目多采用英伟达GPU架构,但随着昇腾等产品的性能突破,他们逐步构建起基于国产硬件的算力底座,完成在硬件层面临算力基础设施的替代工作。

以昇腾为例,其产业生态正全方位助力企业的国产化替代工作。昇腾计算产业是基于昇腾系列(HUAWEI Ascend)处理器和基础软件构建的全栈 AI计算基础设施、行业应用及服务,包括昇腾系列处理器、系列硬件、CANN(Compute Architecture for Neural Networks,异构计算架构)、AI计算框架、应用使能、开发工具链、管理运维工具、行业应用及服务等全产业链。

实际上,在许多项目的迁移过程中,国产化替代并非简单设备更换,而是涉及编译链、算子库、分布式通信协议的全栈重构工程。相当于技术选型路径已发生结构性转变:自DPC国产大模型体系发布后,全面转向其技术生态。比如以昇腾平台为例,需重构CUDA算子库为CANN架构,同时开发适配MindSpore的分布式训练方案,最终形成从硬件到框架的完整国产化技术栈。

昇腾的技术开源生态目前相对完整,熊文韬认为,用户可以直接咨询华为的昇腾技术专家进行实际问题的解析,这对开发者来说非常便利。

此外,针对 AI 场景,国产深度学习框架的技术演进路径已形成独特优势。以昇腾生态中的MindSpore为例,可以原生支持昇腾产品的自动微分优化器,通过图算融合技术实现训练效率提升。在国产化政策驱动下,该框架凭借全场景,如端边云的适配能力,正加速向智能制造、智慧城市等领域渗透。

而在构建 AI 应用的过程中,华为技术生态的协同效应同样尤为关键——昇腾AI处理器与MindSpore框架的深度耦合,如CANN异构计算架构,配合DeepSeek大模型的垂直行业解决方案,正在构建从底层硬件到上层应用的完整技术栈。这种端到端自主可控体系,在金融、政务等敏感领域展现出不可替代的部署价值,预计未来三年将覆盖80%以上的关键行业智能化改造项目。

基于稳定的算力设备,加之国内的大模型技术研究也已走在行业前列,便可构建完整的、自主可控的AI软件生态。

效能跃升与场景适配——昇腾平台的大模型推理优化路径

对于大模型的推理优化,熊文韬认为,这是大家普遍面临的问题,无论是昇腾还是其他产品,在处理大模型推理时都会遇到挑战。在不同性能的芯片上,通过框架和算子的优化,可以深入调整生态,实现差异化优化。总体上,这些优化在功能和问题处理上是大同小异的。

当下,企业应用大模型场景多集中在智能客服与交互、数据分析与决策、智能制造优化三大方面。从场景出发来看,基于昇腾算力支持,企业可以实现大模型驱动的智能问答、语义理解,提升客服响应效率与用户体验;在金融、零售等领域,依托昇腾 AI 算力,大模型完成数据挖掘、趋势预测,辅助企业精准决策;此外,制造业借助昇腾平台,通过大模型实现生产流程模拟、质量缺陷检测,推动自动化与智能化升级。

从大模型依赖的软件与硬件来看,首先硬件支撑方面,使用昇腾系列产品,可以提供高算力、高能效比,满足大模型训练与推理的算力需求。软件生态方面,如CANN 异构计算架构,可以优化模型编译、算子调度,提升大模型在昇腾硬件上的执行效率。结合 MindIE 框架,MindIE Service 针对通用模型的推理服务化场景,实现开放、可扩展的推理服务化平台架构,支持对接业界主流推理框架接口,满足大语言模型的高性能推理需求。

熊文韬还总结了影响大模型推理的四大因素:

(1)算力性能:产品的算力规模直接影响大模型推理速度,需通过硬件协同优化释放算力潜力。

(2)算法与框架优化:模型结构设计、MindIE框架的图算融合技术,决定推理过程的效率。

(3)数据质量与预处理:高质量标注数据、高效数据预处理流程,保障大模型推理结果的准确性。

(4)软硬件协同性:比如昇腾 CANN 工具链与硬件的深度适配,可以确保大模型推理时的资源调度与性能释放。

基于此,熊文韬从技术的角度提出了几个大模型推理优化方法理论:量化,即通过降低模型权重和计算精度,例如将浮点数FP32转换为FP16或INT8格式,大幅减少内存占用和计算负担;模型剪枝,去除模型中冗余或贡献较小的神经元连接,分为结构化剪枝和非结构化剪枝;知识蒸馏,大模型蒸馏的核心思想是通过让较小的学生模型模仿较大的教师模型的行为,从而在保留模型性能的前提下,降低计算资源的消耗。

当然,作为业界的基础设施平台和一站式开发者平台,昇腾在大模型推理优化方面也有不少研究。

比如,近期昇腾宣布推出大EP(专家并行)推理解决方案,它通过优化负载均衡、提升并发能力、创新的autoPD分离部署及通信优化等技术,实现了更高性能、更低时延的AI推理。在降低DeepSeek应用门槛的同时,也大幅缩短行业客户迈向大模型应用的周期,可以说真正让大模型应用融入千行万业驶入了“快车道”。

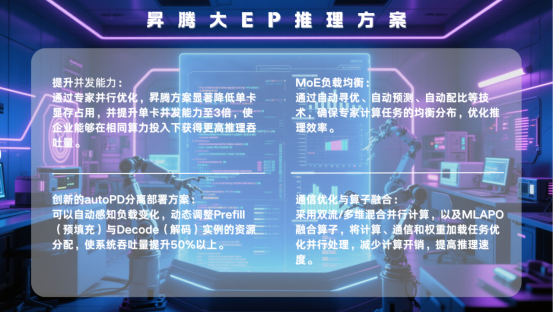

具体而言,昇腾大EP推理方案有四大优势。

一是提升并发能力。通过专家并行优化,昇腾方案显著降低单卡显存占用,并提升单卡并发能力至3倍,使企业能够在相同算力投入下获得更高推理吞吐量。

二是MoE负载均衡。通过自动寻优、自动预测、自动配比等技术,确保专家计算任务的均衡分布,优化推理效率。

三是创新的autoPD分离部署方案。可以自动感知负载变化,动态调整Prefill(预填充)与Decode(解码)实例的资源分配,使系统吞吐量提升50%以上。

四是通信优化与算子融合。采用双流/多维混合并行计算,以及MLAPO融合算子,将计算、通信和权重加载任务优化并行处理,减少计算开销,提高推理速度。

![]()

这些技术突破,使昇腾大EP推理方案能够在保证高效推理的同时,大幅降低企业部署成本,为DeepSeek等大模型大规模应用提供更稳定、更经济的AI推理基础设施。

在全球化技术竞争与数字化转型的双重浪潮下,中国AI产业正以昇腾生态为支点,撬动从硬件底座到应用生态的全栈革新。通过技术迁移、框架优化与场景适配,国产算力不仅实现了从“可用”到“好用”的跨越,更在金融、制造、政务等关键领域构筑起自主可控的智能化防线。

未来,随着异构计算架构的持续优化、开源生态的深度共建以及产学研协同创新的深化,国产AI技术栈将突破更多“卡脖子”难题,在算力效能、场景泛化与生态兼容性上实现全面跃升。这场以昇腾为先锋的国产化替代浪潮,不仅是技术路径的重构,更是中国在全球AI竞赛中从“跟跑”到“并跑”的关键一跃——当算力底座与创新生态共振,中国AI产业的星辰大海,正在基础设施的坚实支撑下徐徐展开。