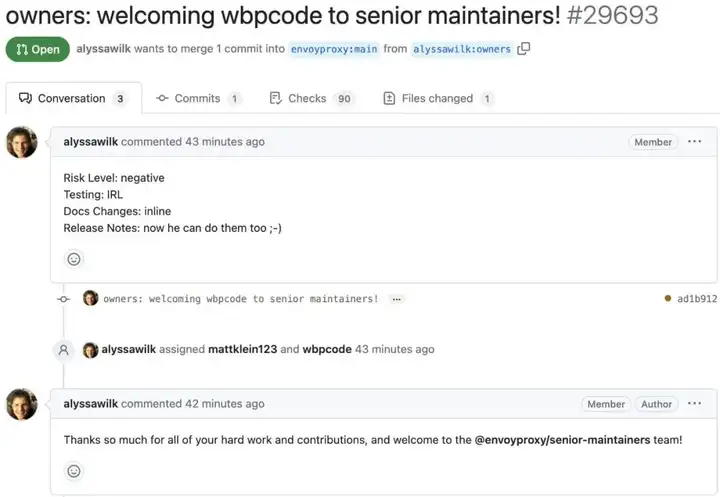

数智时代,开源软件因成为企业竞争力的核心支撑获得了空前的关注,但在降本增效风暴席卷全球的今天,坚持投入开源是一件艰难的事情,而网易数帆一直活跃于开源路上。近日,Envoy 社区宣布,正式接纳网易数帆云原生技术专家王佰平晋升为社区 senior maintainer。

Envoy 是 CNCF(云原生计算基金会) 老牌毕业项目之一,现已成为服务网格和 API 网关数据面的事实标准,被谷歌、亚马逊、微软、奈飞、Salesforce 等企业广泛采用,也用在网易数帆的金融级分布式底座当中。此次宣布,意味着王佰平将在这一项目核心代码和安全更新方面承担更大的责任,使得源自国内的云原生实践需求更易于融入社区路线图。

2022 年 4 月,王佰平成为 Envoy 社区 maintainer,打破了 Envoy 项目核心开发圈子缺乏国人的局面。同年 5月,Envoy 社区的新项目 Envoy Gateway 诞生,致力于让 Envoy 在 API 网关角色中“走向大众”,在整个云原生技术栈中发挥更为重要的作用,这与网易数帆云原生技术发展规划高度一致。截至目前,王佰平仍是 Envoy 社区唯一一名我国本土企业诞生的 maintainer,这也是云原生社区全球参与者对网易数帆在服务网格、网关相关技术领域的实力与贡献的高度认可。

此后,王佰平依托网易数帆在云原生服务网格、网关领域的研发,金融、能源等行业场景的实践,以及自主开源项目 Hango、Slime 的发展,不断回馈 Envoy 社区,致力于多协议治理支持、多协议可观察性、过滤器链性能与能力增强、负载均衡模块可扩展性等核心能力的演进,同时也不断推动 Envoy 项目本身代码质量提升,为社区发展做出贡献。

具体而言,其工作主要包括 generic proxy 框架支持,logging/formatter/tracing 模版化/多协议化重构,路由粒度过滤器链,负载均衡模块化重构,等等。不仅如此,在团队支持下,王佰平坚持“社区驱动”的开源理念,积极参与社区 issue 讨论、PR review,推动 Envoy 社区和项目健康发展,让这一技术具有更旺盛的生命力。对 Envoy 的选择与坚持,也是网易数帆研发投入以客户为中心的例证。Envoy Proxy 创始人 Matt Klein 曾经坦承,Envoy 由于使用 C++ 编写曾经遭受过很多嘲笑,然而他认为这恰恰是一个关注最终用户和市场实际需求而非屈服于炒作的例子,结果也证明了以客户和市场为中心是(开源软件)取得巨大成功的唯一途径。网易数帆为真实需求拥抱在云原生领域显得相对小众的 C++,也获得了社区和客户双重的认可。

人物小档案

王佰平,网易数帆云原生技术专家、资深架构师,Envoy Proxy senior maintainer,Hango/Slime maintainer ,轻舟 API 网关与轻舟服务网格数据面负责人,通晓网关、负载均衡、服务网格等分布式技术原理,熟悉 Envoy 和 Istio,对于 API 网关、服务网格落地具有丰富的经验。