阿里云推出大规模视觉语言模型Qwen-VL,并宣布直接开源。

开源地址

ModelScope魔搭社区:

HuggingFace:

GitHub:

技术论文地址:

Qwen-VL以通义千问70亿参数模型Qwen-7B为基座语言模型研发,支持图文输入,具备多模态信息理解能力。在主流的多模态任务评测和多模态聊天能力评测中,Qwen-VL取得了远超同等规模通用模型的表现。

Qwen-VL是支持中英文等多种语言的视觉语言(Vision Language,VL)模型,相较于此前的VL模型,Qwen-VL除了具备基本的图文识别、描述、问答及对话能力之外,还新增了视觉定位、图像中文字理解等能力。

![]()

用户可从魔搭社区直接下载模型,也可通过阿里云灵积平台访问调用Qwen-VL和Qwen-VL-Chat,阿里云为用户提供包括模型训练、推理、部署、精调等在内的全方位服务。

![]()

Qwen-VL可用于知识问答、图像标题生成、图像问答、文档问答、细粒度视觉定位等场景。

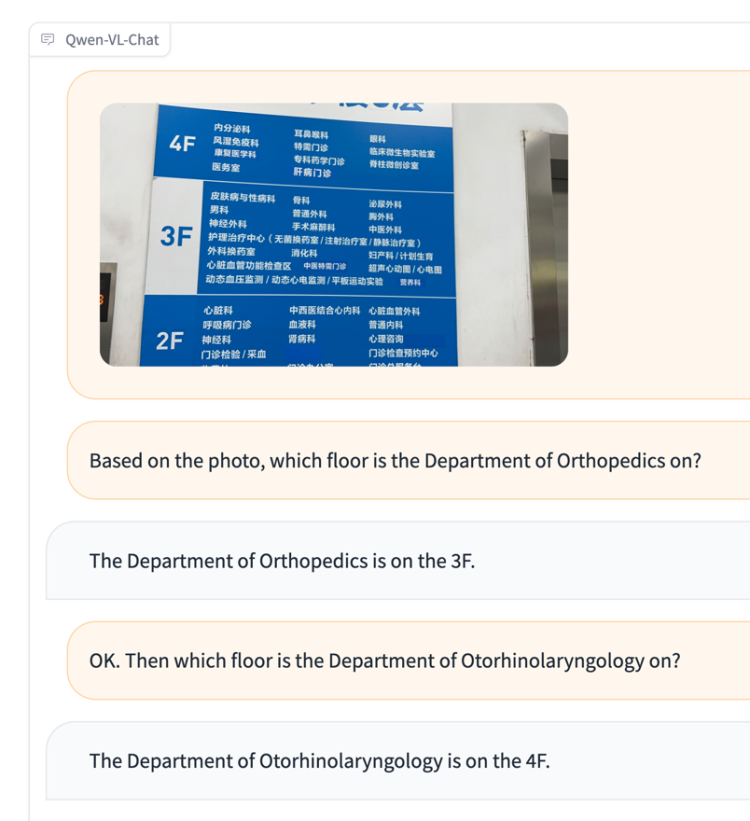

比如,一位不懂中文的外国游客到医院看病,不知怎么去往对应科室,他拍下楼层导览图问Qwen-VL“骨科在哪层”“耳鼻喉科去哪层”,Qwen-VL会根据图片信息给出文字回复,这是图像问答能力;再比如,输入一张上海外滩的照片,让Qwen-VL找出东方明珠,Qwen-VL能用检测框准确圈出对应建筑,这是视觉定位能力。

![]()

![]()

Qwen-VL是业界首个支持中文开放域定位的通用模型,开放域视觉定位能力决定了大模型“视力”的精准度,也即,能否在画面中精准地找出想找的事物,这对于VL模型在机器人操控等真实应用场景的落地至关重要。

Qwen-VL以Qwen-7B为基座语言模型,在模型架构上引入视觉编码器,使得模型支持视觉信号输入,并通过设计训练过程,让模型具备对视觉信号的细粒度感知和理解能力。Qwen-VL支持的图像输入分辨率为448,此前开源的LVLM模型通常仅支持224分辨率。在Qwen-VL 的基础上,通义千问团队使用对齐机制,打造了基于LLM的视觉AI助手Qwen-VL-Chat,可让开发者快速搭建具备多模态能力的对话应用。

在四大类多模态任务(Zero-shot Caption/VQA/DocVQA/Grounding)的标准英文测评中,Qwen-VL取得了同等尺寸开源LVLM的最好效果。

为了测试模型的多模态对话能力,通义千问团队构建了一套基于GPT-4打分机制的测试集“试金石”,对Qwen-VL-Chat及其他模型进行对比测试,Qwen-VL-Chat在中英文的对齐评测中均取得了开源LVLM最好结果。

8月初,阿里云开源通义千问70亿参数通用模型Qwen-7B和对话模型Qwen-7B-Chat,成为国内首个加入大模型开源行列的大型科技企业。