设计和实现

shape constraint IR的设计

使用IR来建模shape constraint并不是一个很容易的事情。我们需要设计一种方案既方便我们做shape constraint分析,同时又不会使得IR的后续变换变的很复杂。经过多次迭代之后,我们选择了type-based方案来构建shape constraint IR,基本思路如下段伪IR所示。

// original data-computation IR

func @main() {

...

%0 = any_dialect.any_operation(...) : tensor<?x?xf32, [@S0, @S1]>

...

}

disc_shape.SymbolicDim @S0 {

range list : [[...], [...], ...]

likely_values : [...]

...

symbolic_shape_graph: @shape_constraint_graph

}

disc_shape.SymbolicDim @S1 {

range list : [[...], [...], ...]

likely_values : [...]

...

symbolic_shape_graph: @shape_constraint_graph

}

// A separated function to store shape constraint predicates between different symbolic dimensions.

// Each symbolic dim is either bound to a `disc_shape.dim` op or `disc_shape.bind_dim`

func @shape_constraint_graph(...) {

%0 = disc_shape.dim() {ref: @S0} : index

%1 = disc_shape.dim() {ref: @S1} : index

disc_shape.tie_predicate_divisible(d0, d1) // d0 % d1 == 0

// other tie_* ops

// disc_shape.tie_predicate_eq(d0, d1) // d0 == d1

// disc_shape.tie_predicate_lt(d0, d1) // dim less than

// disc_shape.tie_predicate_mul_eq(d0, d1, d2, ...) // d0 = d1 * d2 * ...

// // d0 * d1 = s0 * s1

// disc_shape.tie_predicate_product_eq([d0, d1, ..], [s0, s1, ...])

// // d0 = affine.apply(d1, d2, ...) {affine_attr = ...}

// disc_shape.tie_predicate_affine_eq(d0, d1, d2, ...) {affine_attr = ...}

}

在这个方案中,每一个symbolic dimension size(也即在编译期间无法确定具体大小的dimension size)对应一个全局的disc_shape.SymbolicDimIR对象。该IR对象中存储了关于这个symbolic dimension size的分布相关的约束,同时也存储了对一个shape constraint function的引用。在上图中最下面的部分是一个shape constraint function的例子。在这个function中存储的是symbolic dimension dim之间的相关关系(结构化约束),每一种相关关系用一个op来抽象,比如说这个例子中说展示的整除等价关系便是由tie_predicate_divisibleop来描述。选择type-based方案主data计算图中并不会直接存储shape constraint信息。在上图中的最上面是一个主data计算图的例子。主data计算图中,每一个tensor对应的type中都包含一个attribute,这个attribuet中存储了这个tensor所对应的symblic dimension size的引用。

通过将描述shape constraint的IR和主data计算IR解耦开,一方面可以尽可能减少对已有pattern匹配的逻辑的干扰 (matmul+BiadAdd -> FusedMatmulBiasAdd这个pattern替换并不需要感知到shape constraint IR的存在),另外一方面,不同层级的data计算的IR,比如tensor level IR和buffer level IR,可以用同一套shape constraint的描述。从而可以缓解IR lowering过程中shape constraint信息的丢失问题。

基于shape constraint IR的优化pipeline

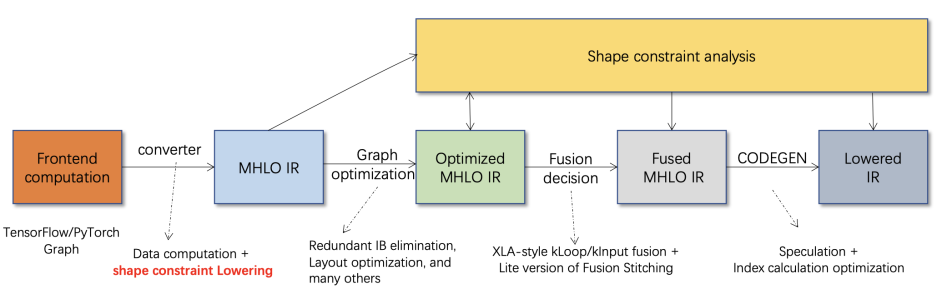

将shape constraint IR作为第一等公民引入IR中之后,我们进一步构建了以shape constraint 为中心的优化 pipeline(如下图所示)。通过对shape constraint的充分的挖掘,而非依赖于具体的shape的值来辅助完成各种优化,从而实现在动态shape语义下尽可能接近静态shape优化工具的性能。

下图中展示了目前BladeDISC中主要的几个优化的阶段。从最左边开始看起。第一步是将前端AI框架的计算图lower到MHLO的计算描述。这里值得注意的是除了普通的data计算的lowering,还包含shape constraint的lowering,从而避免在动态shape语义信息的丢失。到MHLO之后,我们首先会完成shape constraint的分析以及分析结果的IR化表示。分析得到的结果将可以指导我们完成计算图上的一些基本化简,比如冗余broadcast op的消除,layout调整等。优化完之后的计算图,我们会进一步对其中的访存密集型算子做融合优化,shape constraint将是决定那些算子可以融合的很重要的判断依据,通过更充分的挖掘shape constraint,我们可以找到更多融合的机会。最后在做代码生成的时候,我们发现在动态shape语义下index计算的开销更加容易成为瓶颈,尤其是当算子融合的数目比较多的时候,利用shape constraint我们可以大幅消除冗余的index计算。以上限制于篇幅并未一一展开进行介绍,感兴趣的同学可以通过这里了解更多的细节。

![image.png]()

初步测试

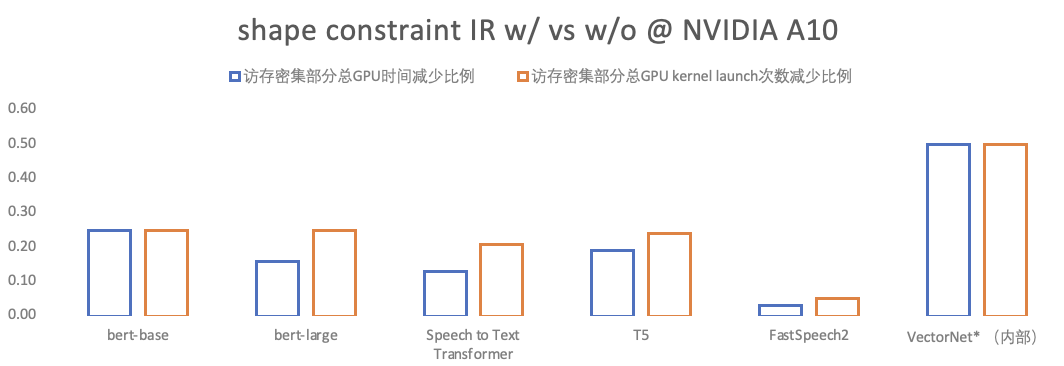

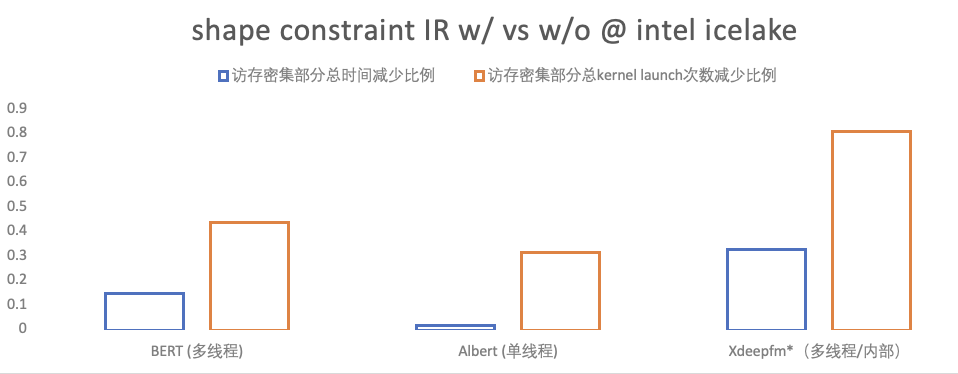

我们目前已经完成了shape constraint IR的第一阶段开发,也即shape constraint IR的引入以及pass pipeline的适配性改造。第一阶段的主要目标是搭建好整体的架子,还并未包含所有设计中优化的实现 (比如likely value的应用),我们将会在后续持续迭代完善shape constraint IR。在以上前提下,我们在一些比较典型的模型上完成初步的评测,下图展示的是部分的评测结果。由于目前shape constraint IR还未应用到计算密集型算子(GEMM/CONV等)的优化 ,故以下测评针对的是模型中访存密集型部分,主要从两个维度来衡量:

- 访存密集型部分kernel launch的次数,即衡量fusion的粒度,同等情况下次数越少,fusion的粒度越大;

- 访存密集型部分总消耗时间,即衡量生成的kernel的质量,同等情况下总时间越短,质量越高;

如下图中所示,在CPU和GPU上我们都观测到fusion粒度的明显改善以及访存密集型部分总消耗时间的减少。

![]()

![]()

合作讨论

以上是近期我们在shape constraint IR Part II的分享,更多相关信息欢迎加入BladeDISC用户群交流讨论。

欢迎大家加入 BladeDISC 用户群交流讨论,与我们一起共建。钉钉群号:44534789