北京市人民政府发布了关于2024年度北京市科学技术奖励的决定,对为科学技术进步、国际科技创新中心建设、首都经济社会发展作出创造性贡献的科技人员和组织给予奖励。

![]()

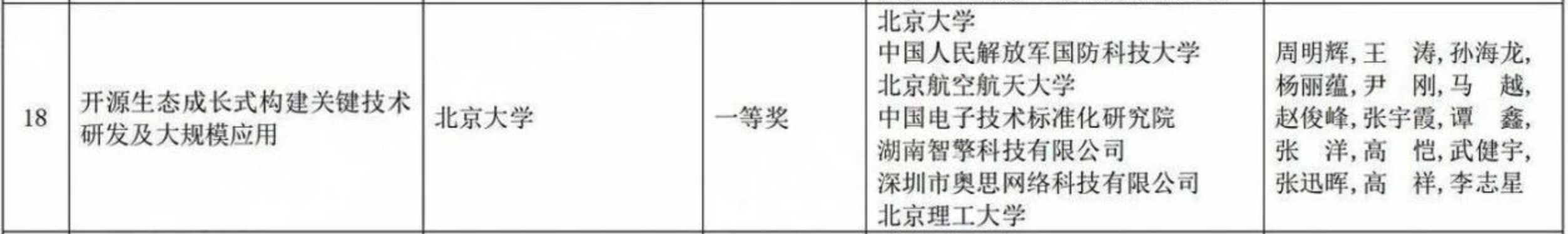

北京奥思研工智能科技有限公司(原深圳市奥思网络科技有限公司)作为参与单位,与北京大学、中国人民解放军国防科技大学、北京航空航天大学、中国电子技术标准化研究院、湖南智擎科技有限公司、北京理工大学携手合作完成的《开源生态成长式构建关键技术研发及大规模应用》项目获得了“科学技术进步奖”。

科学技术进步奖旨在奖励完成和应用推广创新性科技成果,为推动科技进步和经济社会发展作出突出贡献的个人和组织。这一荣誉不仅是对项目本身的高度认可,更是对参与单位科研实力和创新能力的有力证明。

![]()

开源中国・Gitee 作为北京奥思研工智能科技有限公司自主研发的 AI DevSecOps 研发效能平台,已汇聚 1350 万开发者,托管了 3600 万个代码仓库,服务了 36 万家企业级用户,以强劲的技术能力成为开源生态的基础设施,本次获奖实至荣归。

关于我们

开源中国

开源中国(OSCHINA)成立于 2008 年,是国内最具影响力的开源与 AI 技术社区之一。

目前有超过 1100 万专业开发者入驻,社区以技术交流和 AI 创新实践为核心,持续为开发者提供精准、高质量的技术资讯,丰富且完善的开源项目资源、专业化的 AI 创作平台,以及高效活跃的互动交流环境,形成了一个充满活力与创造力的开发者生态圈。

官网:https://www.oschina.net

Gitee

Gitee 是开源中国运营的企业级 DevOps 研发管理平台,已经成为全球第二大的开发者平台,其中包含了代码管理、代码质量管理、持续交付、软件发布平台和项目协作管理等产品,并且支持公有云服务及私有化部署。

目前,Gitee 已经有超过 1350 万名开发者,累计托管超过 3600 万个代码仓库,是中国境内规模最大的代码托管平台。同时,旗下企业级 DevOps 研发效能管理平台 Gitee 企业版已服务超过 36 万家企业。

官网:https://gitee.com

模力方舟(Gitee AI)

模力方舟(Gitee AI)是开源中国于 2023 年推出的一站式大模型服务平台,致力于做中国本土化的 AI 社区。

模力方舟(Gitee AI)旨在理解和解决 AI 落地和应用问题,满足中国用户和企业的需求。它提供开源模型、数据集和应用落地场景,提供地域化的服务,重视用户数据的隐私保护和数据安全,针对中国市场和用户需求,与本土的 AI 生态系统进行深度融合。

官网:https://ai.gitee.com