近年来,政府将数据要素纳入了经济发展的重要指示性文件当中,希望利用数据驱动。《全国数据资源调查报告(2023年)》显示,2024年以来不少地方纷纷成立"数据集团",加快盘活数据资产。作为数字经济时代的首要生产要素,数据将有望成为政府和企业财务报表以及财政收入的重要支持。

一、数据资产定义

数据资产是指企业拥有或控制的、预期会给企业带来可持续经济利益、以数据为主要内容和服务的可辨认形态。

"企业拥有或控制的",就是企业必须拥有数据资产的完整权利,即所谓的"三权":数据资源持有权、数据加工使用权、数据产品经营权。"预期会给企业带来可持续经济利益",这些利益可以进一步细分为内部价值和外部收益,内部价值指的是企业自身生产、销售并使用数据资产所产生的价值;而外部价值则是指企业生产、销售数据资产给其他使用者所产生的收益。"以数据为主要内容和服务的可辨认形态"意味着只有当数据以产品的形式存在,并且能够被明确识别和计量时,它才能被正式确认为数据资产,数据产品不仅是数据资产化过程中的产物,也是衡量和确认数据资产价值的重要标准。

二、数据资产管理

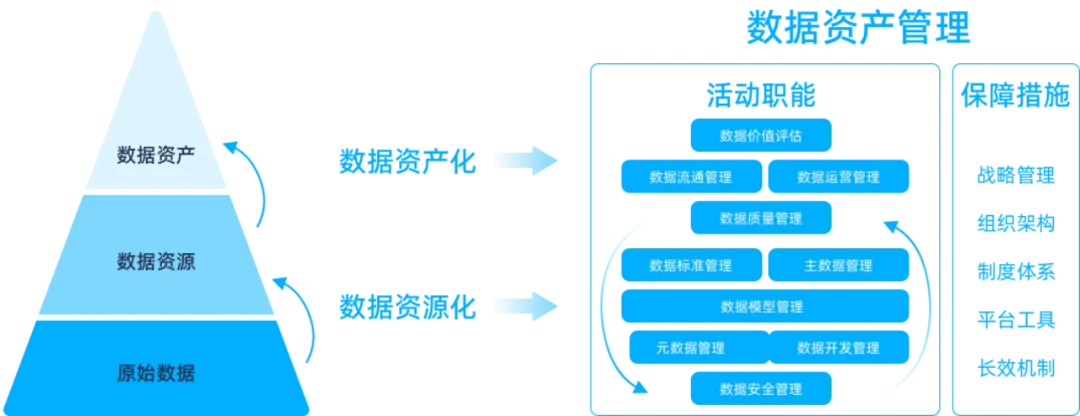

中国信通院《数据资产管理实践白皮书6.0》:数据资产管理是指对数据资产进行规划、控制和供给的一组活动职能。数据资产管理须充分融合政策、管理、业务、技术和服务,确保数据资产保值增值。

数据资产的管理和利用是数据资产的重要环节,它决定了数据资产的价值能否得到充分的发挥和提升。通过数据资产管理,企业可以更好地理解和利用数据,将其转化为企业的战略资产,进而推动业务创新和价值提升。

数据资产管理包含数据资源化、数据资产化两个环节,将原始数据转变为数据资源、数据资产,逐步提高数据的价值密度,为数据要素化奠定基础。 ![file]()

数据资源化的核心在于将数据从原始状态转化为有价值的资源,是数据资产化的必要前提。涉及到从原始数据的采集、存储到后期的加工处理,包括数据模型管理、数据标准管理、数据质量管理、主数据管理、数据安全管理、元数据管理、数据开发管理等活动职能。这一切工作的目的,是将杂乱无章的原始数据转化为可识别、可管理、可利用的资源,为数据的进一步加工和应用打下坚实基础。通过数据资源化,企业可以更加深入地了解用户需求、市场趋势和业务运营情况,为决策提供有力支持。

数据资产化是将数据资源转化为可量化、可交易的资产的过程,这一过程能够充分挖掘并释放数据资源的潜在价值。其核心目标在于扩大数据资产的应用范围,明确数据资产的成本与效益,并在数据供应方与消费方之间构建一个良性反馈闭环。在此过程中,企业需对数据进行评估、定价和交易等关键操作,以实现数据的商业化和市场化。数据资产化涉及的主要活动包括数据资产的流通、运营、价值评估、建立交易规则以及监管机制的构建。

数据资产化不仅标志着数据从静态资源向动态资产的转变,也意味着数据内容和形式的全面升级。通过这一过程,数据不再仅仅是一个静态的存在,而是变成了可以衡量、交易并带来收益的有形资产。 ![file]()

三、数据资产管理助力数据资产入表

数据资产不同于原始数据,它代表着经济社会数字化转型中的一种新型资产类别,被认为是数字时代中极为关键的资产形式。通过有序推进数据资产化并强化其全生命周期的管理,可以更有效地激发数据资产的内在价值。

继数据资产入表会计新规正式落地之后,数据资产管理领域也再度迎来国家级重磅文件。1月11日,财政部公开发布《关于加强数据资产管理的指导意见》,肯定了数据资源可具有资产属性,是数据要素市场发展的重要里程碑。作为报表意义上的"资产",企业数据的市场价值与业务贡献将在财务报表中得以"显性化"。

数据资产入表是数据资产价值化的闭环之举,将企业数据资产以会计科目和货币化形式呈现,将推动企业数据资源向数据资产转变,形成规范的数据资产开发、运营和管理体系,提升企业数据治理能级。

这是一个巨大蓝海,而数据资产管理正是数据资产入表的前提。数据作为新型生产要素,具有其它四类生产要素不具备的价值特性,因此开展数据资产入表要夯实机制、基础。

企业要在数据资产管理上下功夫,尽快建立起有效的数据资产管理体系,打下数据资源入表的管理基础,建立数据登记确权、评估计价和资产入表的政策"闭环",激活万亿数据资产,是开启这一蓝海的金钥匙。 ![file]()

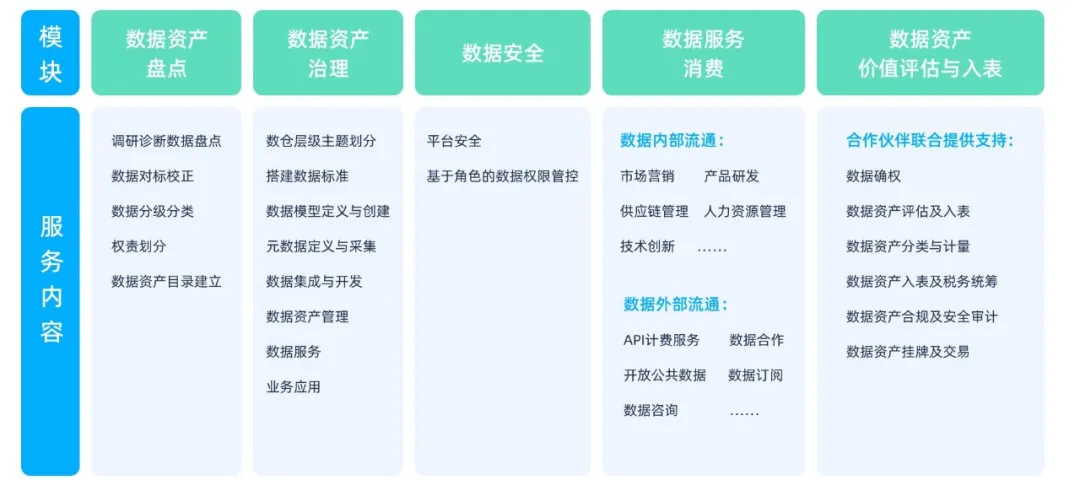

针对资产入表,我们提供以下支持: ![file]()

想要了解完整数据资产管理内容?点此即刻获取白皮书!

《数据资产管理白皮书》下载地址:https://www.dtstack.com/resources/1073?src=szkyzg

《行业指标体系白皮书》下载地址:https://www.dtstack.com/resources/1057?src=szkyzg

《数据治理行业实践白皮书》下载地址:https://www.dtstack.com/resources/1001?src=szkyzg

想了解或咨询更多有关大数据产品、行业解决方案、客户案例的朋友,浏览袋鼠云官网:https://www.dtstack.com/?src=szkyzg