9月20日,上海人工智能实验室(上海AI实验室)与商汤科技联合香港中文大学和复旦大学正式推出书生·浦语大模型(InternLM)200亿参数版本InternLM-20B,并在阿里云魔搭社区(ModelScope)开源首发。同时,书生·浦语面向大模型研发与应用的全链条工具链全线升级,与InternLM-20B一同继续全面开放,向企业和开发者提供免费商用授权。

根据介绍,中量级参数的InternLM-20B大模型性能先进且应用便捷,以不足三分之一的参数量,达到了当前被视为开源模型标杆的Llama2-70B的能力水平。

代码库链接:https://github.com/InternLM/InternLM

魔搭社区链接:https://modelscope.cn/organization/Shanghai_AI_Laboratory

![]()

相比于国内社区之前陆续开源的7B和13B规格的模型,20B量级模型具备更为强大的综合能力,在复杂推理和反思能力上尤为突出,因此可为实际应用带来更有力的性能支持;同时,20B量级模型可在单卡上进行推理,经过低比特量化后,可运行在单块消费级GPU上,因而在实际应用中更为便捷。

InternLM-20B是基于2.3T token预训练语料从头训练的中量级语言大模型。相较于InternLM-7B,训练语料经过了更高水平的多层次清洗,补充了高知识密度和用于强化理解及推理能力的训练数据。因此,在考验语言模型技术水平的理解能力、推理能力、数学能力、编程能力等方面,InternLM-20B都有显著提升。

相比于此前的开源模型,InternLM-20B的能力优势主要体现在:

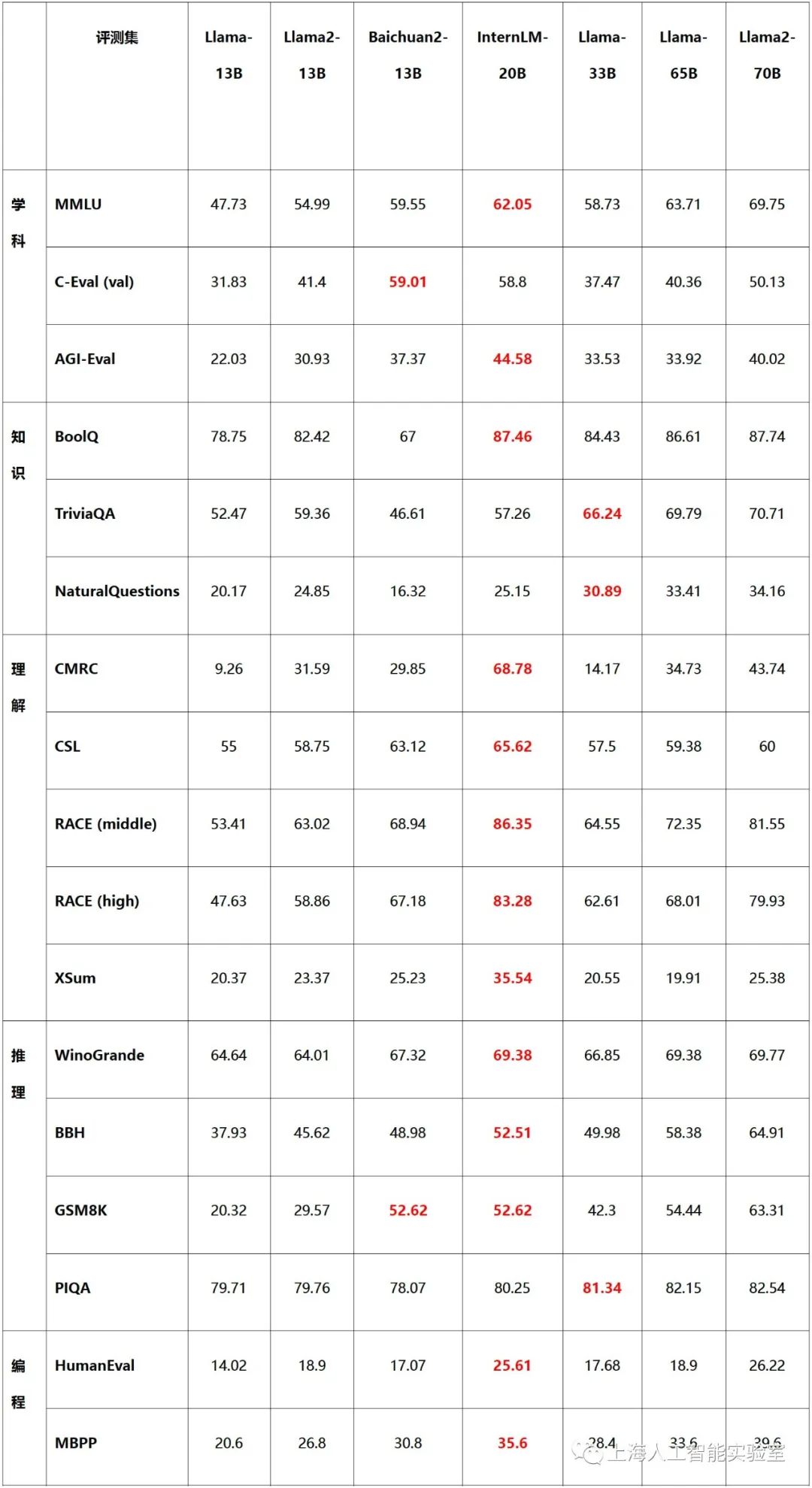

- 优异的综合性能。InternLM-20B 具备优异的综合性能,不仅全面领先相近量级的开源模型(包括Llama-33B、Llama2-13B以及国内主流的7B、13B开源模型),并且以不足三分之一的参数量,测评成绩达到了Llama2-70B的水平。

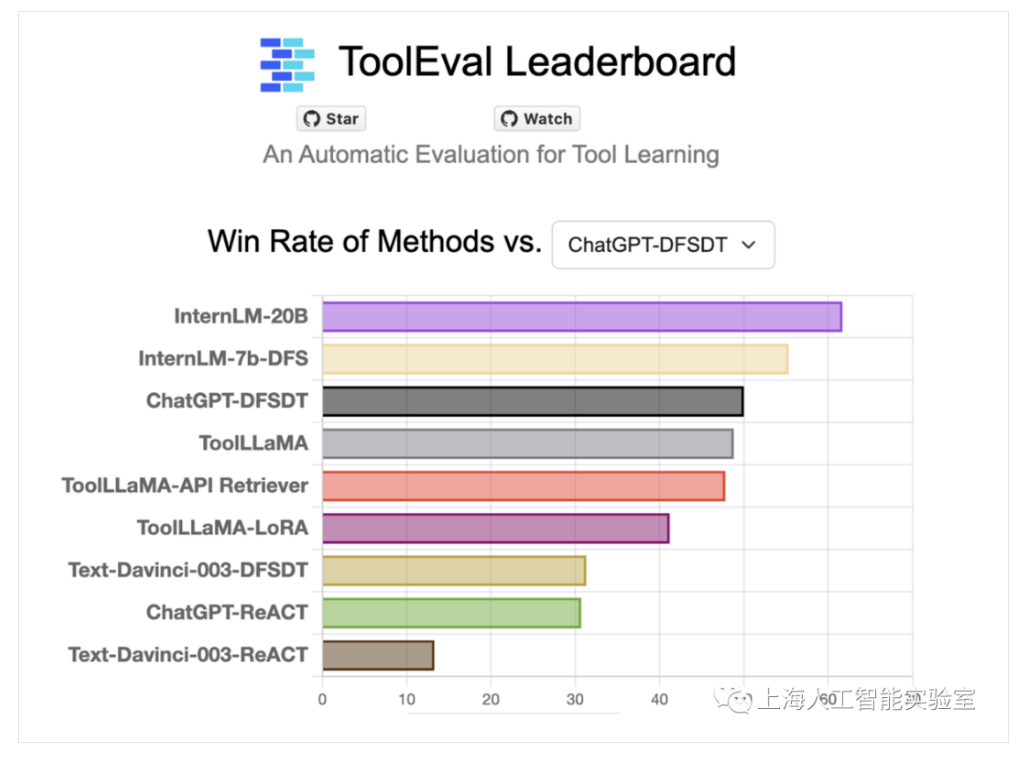

- 强大的工具调用能力。InternLM-20B拓展了模型的能力边界,实现了大模型与现实场景的有效连接。InternLM-20B支持数十类插件,上万个API功能,在ToolBench评测集上获得了最佳结果,在与ChatGPT的竞赛中,胜率达到63.5%。InternLM-20B还具备代码解释和反思修正能力,为智能体(Agent)的构建提供了良好的技术基础。

- 更长的语境。通过多阶段训练拓展,InternLM-20B支持16K语境长度,从而更有效地支撑长文理解、长文生成和超长对话。 更安全的价值对齐。相比于之前版本,InternLM-20B在价值对齐上更加安全可靠。在研发训练的过程中,研究团队通过基于SFT(监督微调)和RLHF(基于人类反馈的强化学习方式)两阶段价值对齐,以及专家红队的对抗训练,大幅提高其安全性。当用户带着偏见提问时,模型能够给出正面引导。

- 全线升级的开源工具、数据体系。书生·浦语开源工具链全线升级,形成了更为完善的工具体系,其中包括预训练框架InternLM-Train、低成本微调框架XTuner、部署推理框架 LMDeploy、评测框架OpenCompass 以及面向场景应用的智能体框架Lagent。书生·浦语工具链将和开源数据平台OpenDataLab构成强大的开源工具及数据体系,共同为学术界和产业界提供全链条的研发与应用支持。

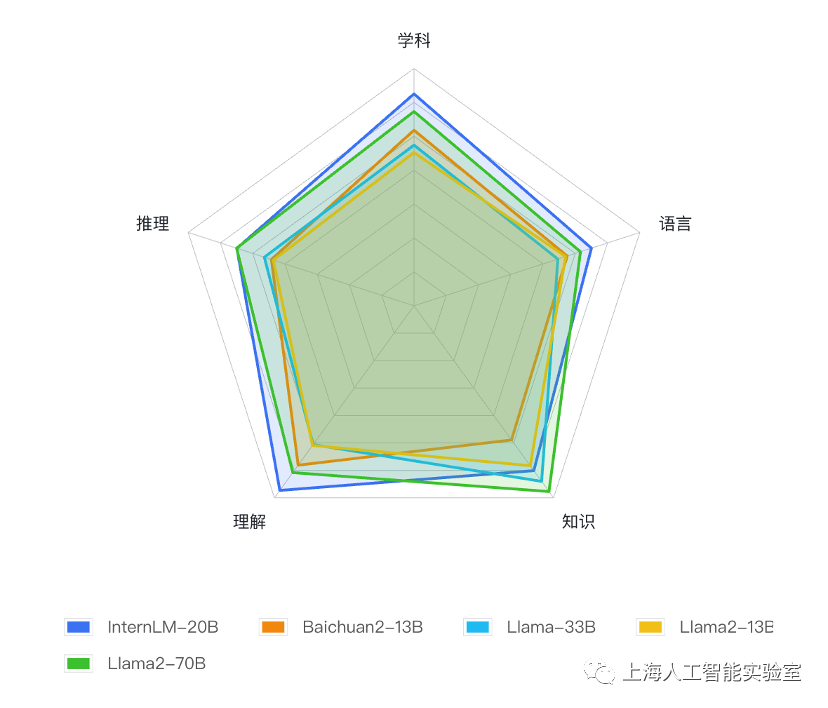

基于OpenCompass大模型评测平台,研究人员在涵盖语言、知识、理解、推理和学科能力等五大维度的50个主流评测集上,对InternLM-20B及相近量级的开源模型进行了全面测试比较。评测结果显示,InternLM-20B在全维度上领先于开源13B量级模型,平均成绩不仅明显超越Llama-33B,甚至优于被称为开源模型的标杆Llama2-70B。

![]()

![]()

![]()

在清华大学等机构联合发布的大模型工具调用评测集ToolBench 中,InternLM-20B和 ChatGPT 相比,达到了63.5%的胜率,在该榜单上取得了最优结果,表现出强大的工具调用能力。

![]()