![]()

每一周,我们的同事都会向社区的成员们发布一些关于 Hugging Face 相关的更新,包括我们的产品和平台更新、社区活动、学习资源和内容更新、开源库和模型更新等,我们将其称之为「Hugging News」。

产品更新

🤗Space 应用支持使用模版了

只需点击几下,即可轻松构建、部署和共享你最喜爱的开源项目,Hugging Face Spaces 已经支持使用 Docker 构建,现在它又增加了模版的支持。

我们的第一个 Space 模版是和 Argilla 合作完成,你可以在 Space SDK 中选择 Docker,然后就可以选择 Argilla 模版了。

![]()

Argilla 是一个开源的、以数据为中心的 NLP 平台,可以用于数据标注、机器学习运维和反馈循环,刚刚获得一轮 160 万美元的投资,查看 Argilla 官网了解更多: https://www.argilla.io/

🤗Hub 上的搜索功能更强了

本月初上线的 Hugging Face Hub 的全文搜索功能现已支持实时反馈查询结果、暗色模式以及可分享的搜索链接等,帮助用户更快速在 Hub 上找到所需要的内容,仅上线一周,就有超过 7.5 万次搜索!快来试试看吧: https://hf.co/search

一个新的 GitHub Action 发布,将你的代码仓库同步到 🤗Hub

![]()

那废话,不多说;那同步,来一波! https://github.com/marketplace/actions/sync-with-hugging-face-hub

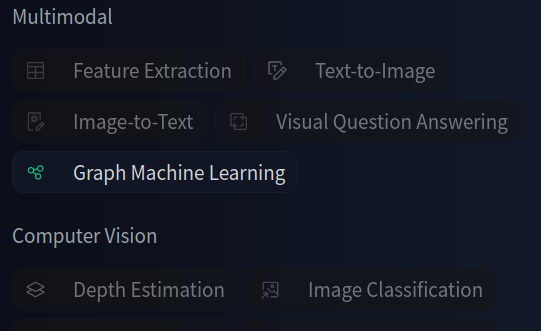

🤗Hub 分类新增图机器学习

![]()

如果你对图机器学习还不熟悉的话,我们之前发过一篇关于 图机器学习相关的文章 可以了解一下,🤗Hub 的分类新增了图机器学习的分类,可以去看看相关的数据集和模型找找灵感啦 https://bit.ly/HFGraphML

开源库更新

PEFT 开源!低成本高效微调模型不是梦

![]()

🤗 PEFT (Parameter-Efficient Fine-Tuning) 是 Hugging Face 开发的一个库,旨在用更少的可训练参数对大型语言模型进行微调,从而显着节省成本和时间。关于 PEFT,我们也有一篇博客介绍,会在之后的微信推文中发布。

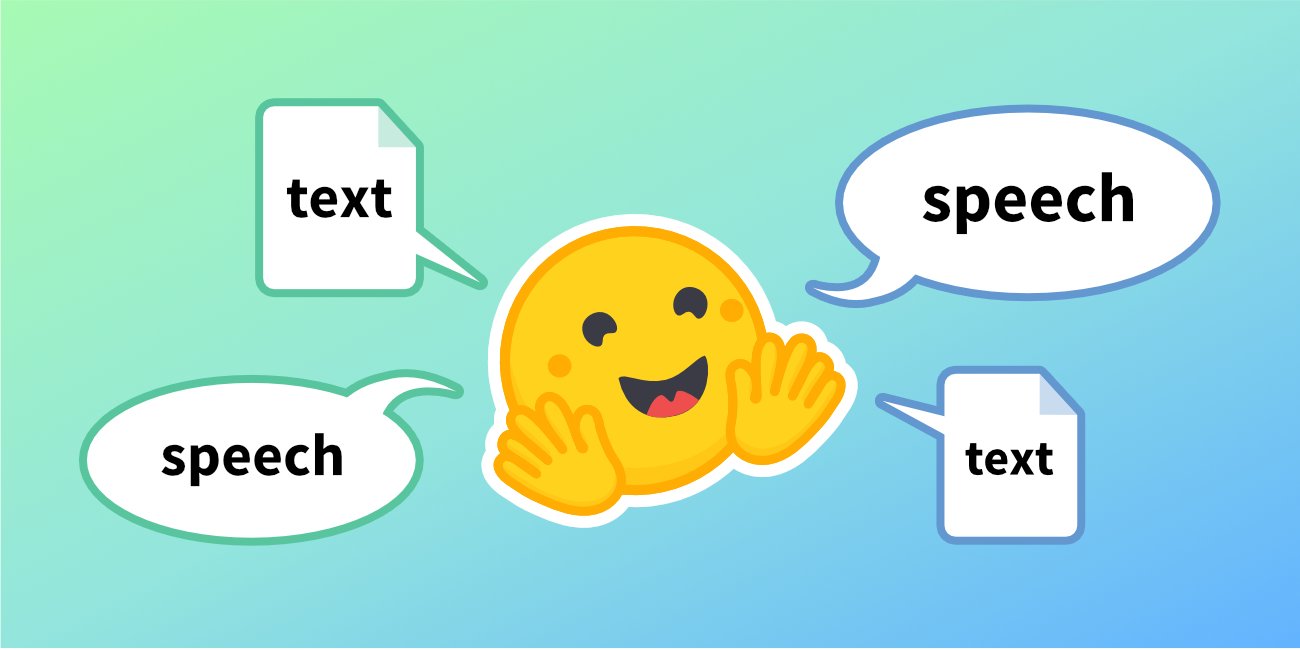

🤗Transformers 增加了第一个文本转语音模型

![]()

SpeechT5 是我们添加到 🤗 Transformers 的第一个文本转语音模型,我们计划在不久的将来添加更多的 TTS 模型。

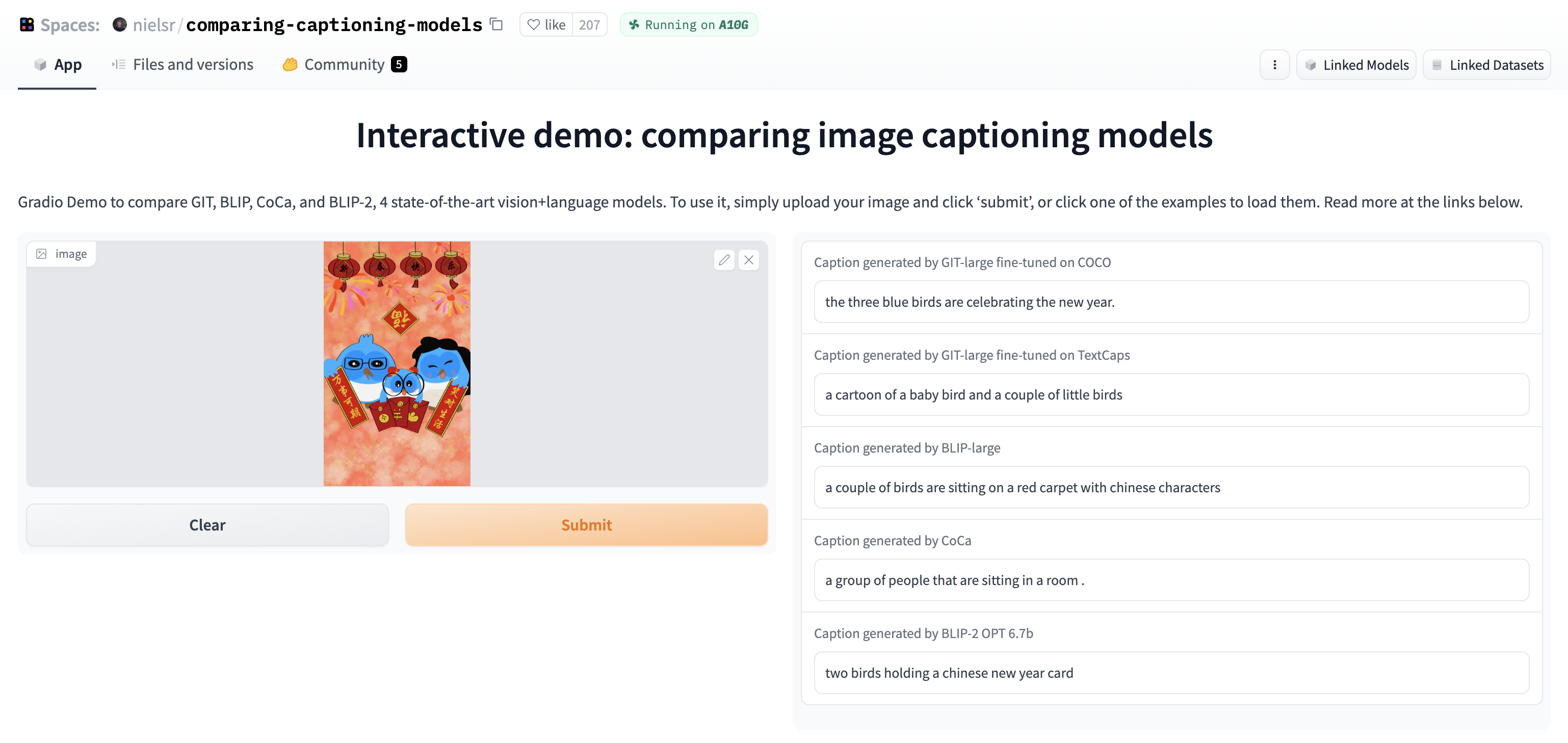

「看图说话」模型合集

![]()

在这个 Space 应用中,Hugging Face 的机器学习工程师 Niels 向大家对比了几种不同的图生文模型: GIT、BLIP、CoCa 和 BLIP-2,你可以上传一个图片来查看每个模型根据图片生成的图片文字描述结果,小编用了一个红包封面图片让几个模型说说看是啥内容,你觉得哪个更准呢?

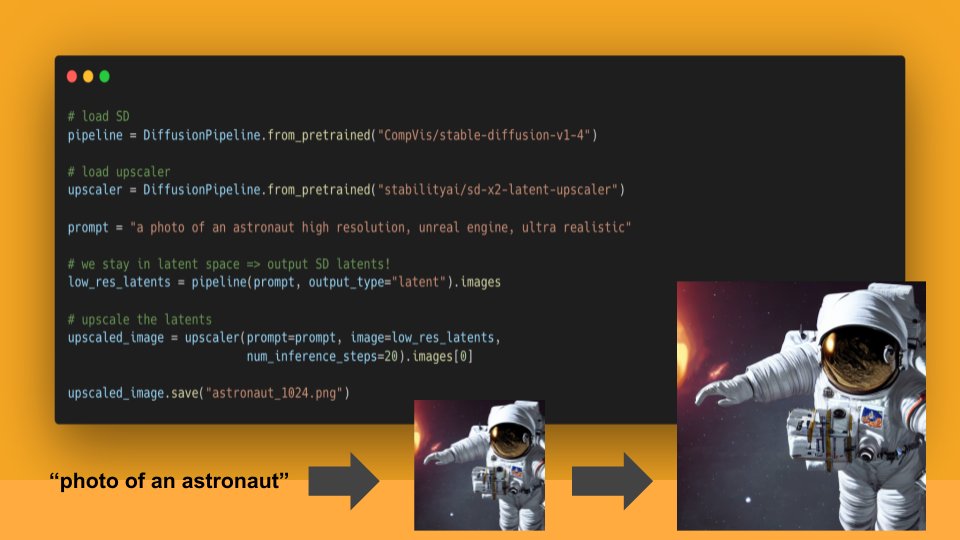

在 🤗 Diffusers 库中使用 Latent Upscaler 生成更高分辨率的图片

![]()

Stable Diffusion Latent Upscaler 模型由 Katherine Crowson 与 Stability AI 合作构建。它可以在任何 StableDiffusionUpscalePipeline checkpoint 之上使用,以将其输出图像分辨率提高 2 倍。

查看模型卡片: https://hf.co/stabilityai/sd-x2-latent-upscaler

查看文档: https://hf.co/docs/diffusers/api/pipelines/stable_diffusion/latent_upscale

查看 Space 应用: https://hf.co/spaces/huggingface-projects/stable-diffusion-latent-upscaler

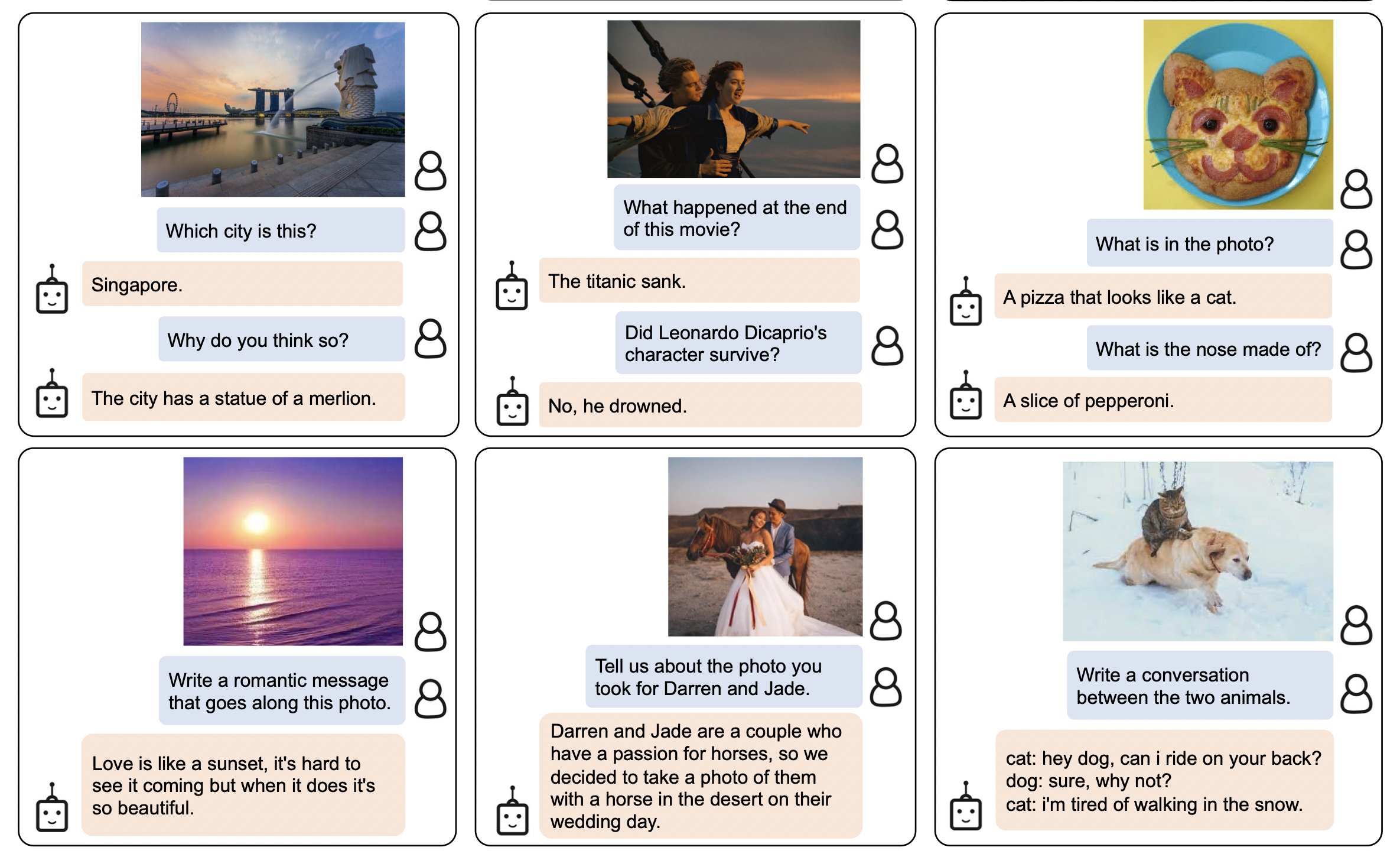

你可以在 🤗 Transformers 中使用 BLIP-2 啦!

![]()

上周我们介绍了一个能够教会 ChatGPT 看图的、由 Salesforce Research 开源的大语言模型 BLIP-2,大家开源在上面的聊天截图里看看它的强大之处。

现在你已经可以在 🤗 Transformers 中使用它了,详见文档: https://hf.co/docs/transformers/main/en/model_doc/blip-2

没有试过的朋友们,可以在 Space 应用中试试看: https://hf.co/spaces/Salesforce/BLIP2

学习资源 & 内容更新

LAION.ai 团队制作了一个 CoCa (Contrastive Captioners) 的 Space 应用,快来试试看: https://hf.co/spaces/laion/CoCa

本月初微软发布的 BioGPT-Large 已经发布到 Hugging Face Hub 上啦,欢迎使用: https://hf.co/microsoft/BioGPT-Large

在生成文本时,大语言模型会输出每个词在其生成的文本序列中出现的概率分布,这些概率分布反映了模型在生成每个词时的置信度。如果它在「一本正经的胡说八道」,那么它生成的文本中每个词的概率分布可能与正确答案的概率分布有较大的差异。

你可以用这个 Space 应用通过为语言模型的输出文字进行着色,例如,对于某个给定的单词,如果其概率很低,那么可以使用红色高亮显示该单词。这样,用户可以更加直观地了解模型输出的每个单词的置信度和概率分布,从而更好地识别可能存在的错误。 https://hf.co/spaces/joaogante/color-coded-text-generation

<hr>

以上就是上周的 Hugging News!