作者介绍

魏彬,普翔科技 CTO,开源软件爱好者,中国第一位 Elastic 认证工程师,《Elastic日报》和 《ElasticTalk》社区项目发起人,被 elastic 中国公司授予 2019 年度合作伙伴架构师特别贡献奖。对 Elasticsearch、Kibana、Beats、Logstash、Grafana 等开源软件有丰富的实践经验,为零售、金融、保险、证券、科技等众多行业的客户提供过咨询和培训服务,帮助客户在实际业务中找准开源软件的定位,实现从 0 到 1 的落地、从 1 到 N 的拓展,产生实际的业务价值。

在 Elasticsearch 中处理字符串类型的数据时,如果我们想把整个字符串作为一个完整的 term 存储,我们通常会将其类型 type 设定为 keyword。但有时这种设定又会给我们带来麻烦,比如同一个数据再写入时由于没有做好清洗,导致大小写不一致,比如 apple、Apple两个实际都是 apple,但当我们去搜索 apple 时却无法返回 Apple 的文档。要解决这个问题,就需要 Normalizer 出场了。废话不多说,直接上手看!

一、上手

我们先来重现一下开篇的问题。

PUT test_normalizer

{

"mappings": {

"doc":{

"properties": {

"type":{

"type":"keyword"

}

}

}

}

}

PUT test_normalizer/doc/1

{

"type":"apple"

}

PUT test_normalizer/doc/2

{

"type":"Apple"

}

# 查询一

GET test_normalizer/_search

{

"query": {

"match":{

"type":"apple"

}

}

}

# 查询二

GET test_normalizer/_search

{

"query": {

"match":{

"type":"aPple"

}

}

}

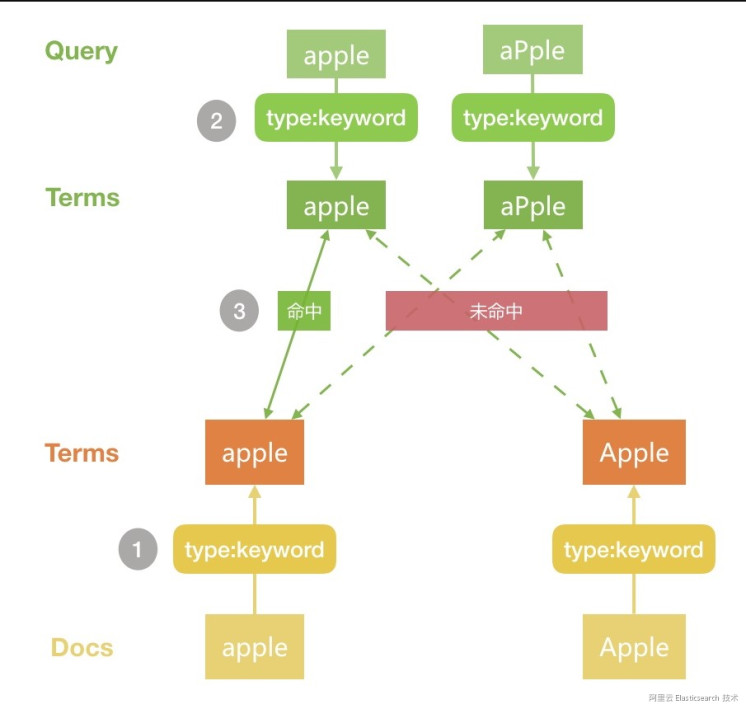

大家执行后会发现 查询一返回了文档1,而 查询二没有文档返回,原因如下图所示:

![image.png image.png]()

1、Docs写入 Elasticsearch时由于 type 是 keyword,分词结果为原始字符串

2、查询 Query 时分词默认是采用和字段写时相同的配置,因此这里也是 keyword,因此分词结果也是原始字符

3、两边的分词进行匹对,便得出了我们上面的结果

二、Normalizer

Normalizer 是 keyword 的一个属性,可以对 keyword 生成的单一 Term 再做进一步的处理,比如 lowercase,即做小写变换。使用方法和自定义分词器有些类似,需要自定义,如下所示:

DELETE test_normalizer

# 自定义 normalizer

PUT test_normalizer

{

"settings": {

"analysis": {

"normalizer": {

"lowercase": {

"type": "custom",

"filter": [

"lowercase"

]

}

}

}

},

"mappings": {

"doc": {

"properties": {

"type": {

"type": "keyword"

},

"type_normalizer": {

"type": "keyword",

"normalizer": "lowercase"

}

}

}

}

}

PUT test_normalizer/doc/1

{

"type": "apple",

"type_normalizer": "apple"

}

PUT test_normalizer/doc/2

{

"type": "Apple",

"type_normalizer": "Apple"

}

# 查询三

GET test_normalizer/_search

{

"query": {

"term":{

"type":"aPple"

}

}

}

# 查询四

GET test_normalizer/_search

{

"query": {

"term":{

"type_normalizer":"aPple"

}

}

}

我们第一步是自定义了名为 lowercase 的 normalizer,其中 filter 类似自定义分词器中的 filter ,但是可用的种类很少,详情大家可以查看官方文档。然后通过 normalizer属性设定到字段 type_normalizer 中,然后插入相同的 2 条文档。执行发现,查询三无结果返回,查询四返回 2 条文档。

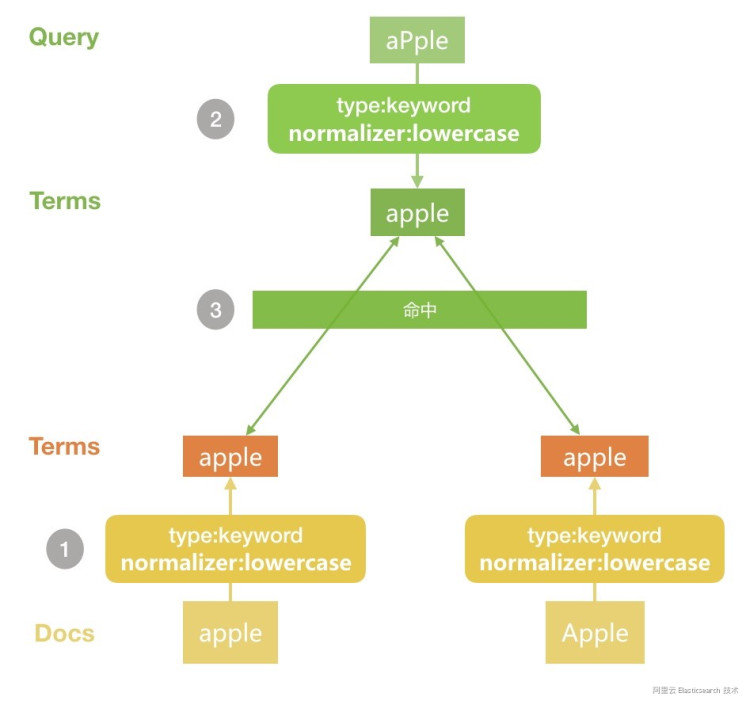

问题解决了!我们来看下是如何解决的

![image.png image.png]()

1、文档写入时由于加入了 normalizer,所有的 term 都会被做小写处理

2、查询时搜索词同样采用有 normalizer 的配置,因此处理后的 term 也是小写的

3、两边分词匹对,就得到了我们上面的结果

三、总结

本文通过一个实例来给大家讲解了 Normalizer 的实际使用场景,希望对大家有所帮助!

声明:本文由原文《听说你还没掌握 Normalizer 的使用方法?》作者“魏彬”授权转载,对未经许可擅自使用者,保留追究其法律责任的权利。

![image.png image.png]()

【阿里云Elastic Stack】100%兼容开源ES,独有9大能力,提供免费X-pack服务(单节点价值$6000)

相关活动

更多折扣活动,请访问阿里云 Elasticsearch 官网

阿里云 Elasticsearch 商业通用版,1核2G ,SSD 20G首月免费

阿里云 Logstash 2核4G首月免费

![image.png image.png]()

![image.png image.png]()