基于Hadoop大数据分析应用场景与实战

为了满足日益增长的业务变化,京东的京麦团队在京东大数据平台的基础上,采用了Hadoop等热门的开源大数据计算引擎,打造了一款为京东运营和产品提供决策性的数据类产品-北斗平台。

一、Hadoop的应用业务分析

大数据是不能用传统的计算技术处理的大型数据集的集合。它不是一个单一的技术或工具,而是涉及的业务和技术的许多领域。

目前主流的三大分布式计算系统分别为:Hadoop、Spark和Strom:

Hadoop当前大数据管理标准之一,运用在当前很多商业应用系统。可以轻松地集成结构化、半结构化甚至非结构化数据集。

Spark采用了内存计算。从多迭代批处理出发,允许将数据载入内存作反复查询,此外还融合数据仓库,流处理和图形计算等多种计算范式。Spark构建在HDFS上,能与Hadoop很好的结合。它的RDD是一个很大的特点。

Storm用于处理高速、大型数据流的分布式实时计算系统。为Hadoop添加了可靠的实时数据处理功能

Hadoop是使用Java编写,允许分布在集群,使用简单的编程模型的计算机大型数据集处理的Apache的开源框架。 Hadoop框架应用工程提供跨计算机集群的分布式存储和计算的环境。 Hadoop是专为从单一服务器到上千台机器扩展,每个机器都可以提供本地计算和存储。

Hadoop适用于海量数据、离线数据和负责数据,应用场景如下:

场景1:数据分析,如京东海量日志分析,京东商品推荐,京东用户行为分析

场景2:离线计算,(异构计算+分布式计算)天文计算

场景3:海量数据存储,如京东的存储集群

基于京麦业务三个实用场景

京麦用户分析

京麦流量分析

京麦订单分析

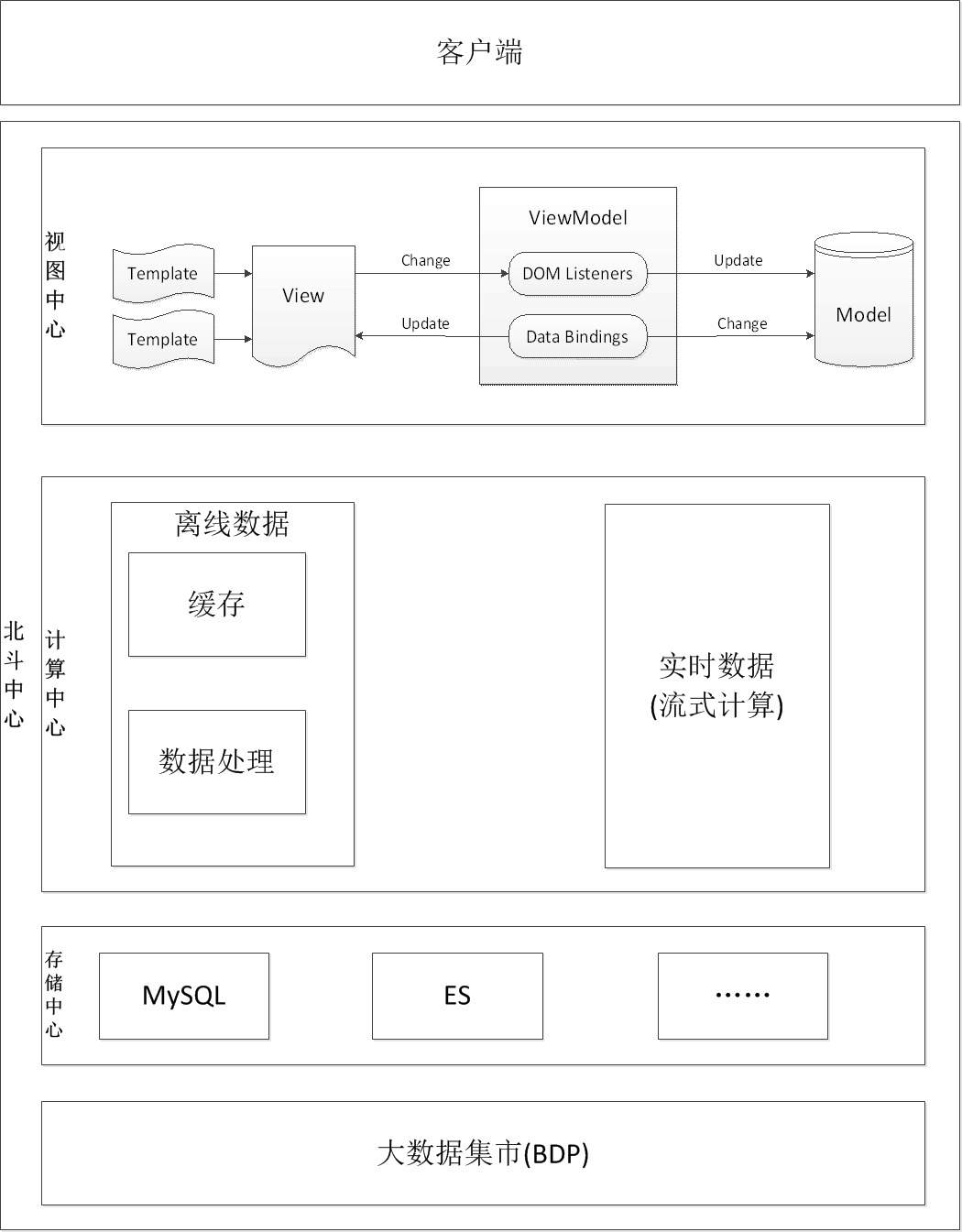

都属于离线数据,决定采用Hadoop作为京麦数据类产品的数据计算引擎,后续会根据业务的发展,会增加Storm等流式计算的计算引擎,下图是京麦的北斗系统架构图:

(图一)京东北斗系统

二、浅谈Hadoop的基本原理

Hadoop分布式处理框架核心设计

HDFS :(Hadoop Distributed File System)分布式文件系统

MapReduce: 是一种计算模型及软件架构

2.1 HDFS

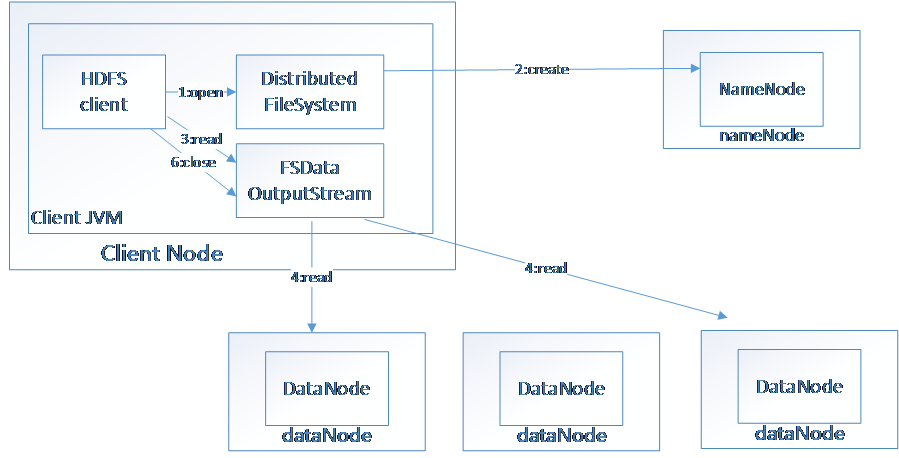

HDFS(Hadoop File System),是Hadoop的分布式文件存储系统。

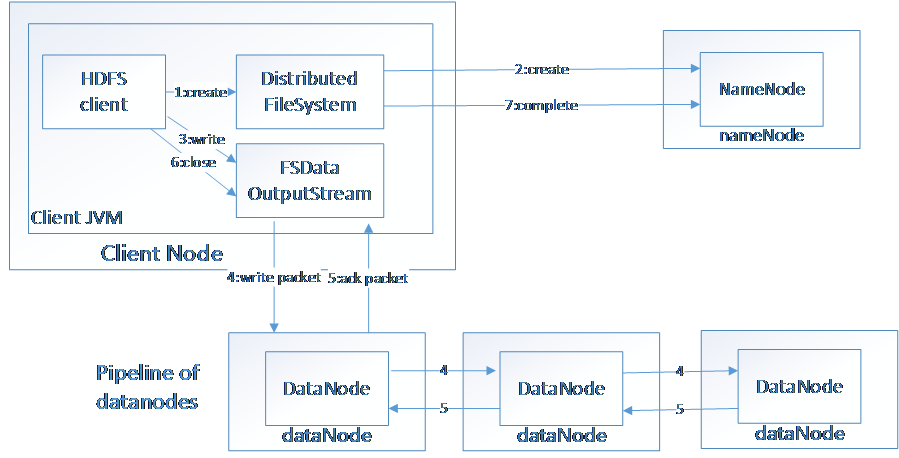

将大文件分解为多个Block,每个Block保存多个副本。提供容错机制,副本丢失或者宕机时自动恢复。默认每个Block保存3个副本,64M为1个Block。将Block按照key-value映射到内存当中。

(图二)数据写入HDFS

(图三)HDFS读取数据

2.2 MapReduce

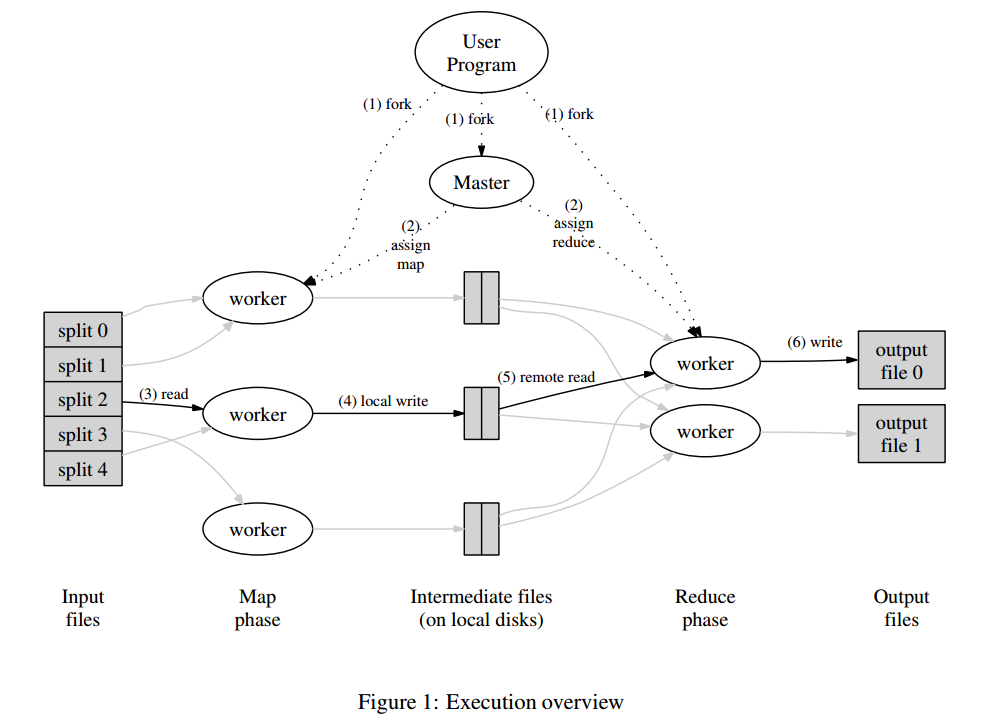

MapReduce是一个编程模型,封装了并行计算、容错、数据分布、负载均衡等细节问题。MapReduce实现最开始是映射map,将操作映射到集合中的每个文档,然后按照产生的键进行分组,并将产生的键值组成列表放到对应的键中。化简(reduce)则是把列表中的值化简成一个单值,这个值被返回,然后再次进行键分组,直到每个键的列表只有一个值为止。这样做的好处是可以在任务被分解后,可以通过大量机器进行并行计算,减少整个操作的时间。但如果你要我再通俗点介绍,那么,说白了,Mapreduce的原理就是一个分治算法。

算法:

MapReduce计划分三个阶段执行,即映射阶段,shuffle阶段,并减少阶段。

映射阶段:映射或映射器的工作是处理输入数据。一般输入数据是在文件或目录的形式,并且被存储在Hadoop的文件系统(HDFS)。输入文件被传递到由线映射器功能线路。映射器处理该数据,并创建数据的若干小块。

减少阶段:这个阶段是:Shuffle阶段和Reduce阶段的组合。减速器的工作是处理该来自映射器中的数据。处理之后,它产生一组新的输出,这将被存储在HDFS。

(图四)MapReduce

2.3 HIVE

hive是基于Hadoop的一个数据仓库工具,可以将结构化的数据文件映射为一张数据库表,并提供完整的sql查询功能,可以将sql语句转换为MapReduce任务进行运行,这套SQL 简称HQL。使不熟悉mapreduce 的用户很方便的利用SQL 语言查询,汇总,分析数据。而mapreduce开发人员可以把己写的mapper 和reducer 作为插件来支持Hive 做更复杂的数据分析。

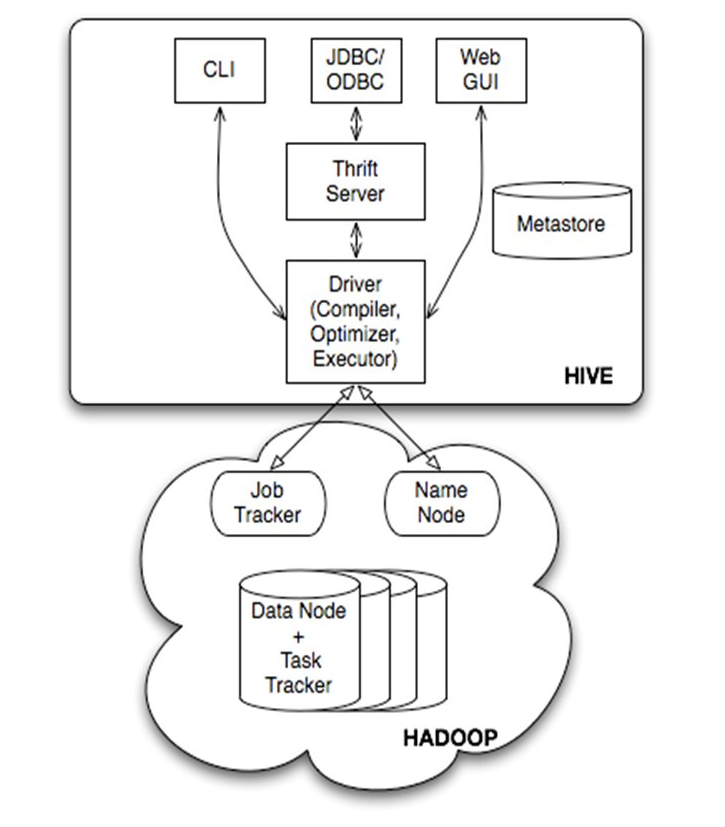

(图五)HIVE体系架构图

由上图可知,hadoop和mapreduce是hive架构的根基。Hive架构包括如下组件:CLI(command line interface)、JDBC/ODBC、Thrift Server、WEB GUI、metastore和Driver(Complier、Optimizer和Executor)。

三、Hadoop走过来的那些坑

进行HIVE操作的时候,HQL写的不当,容易造成数据倾斜,大致分为这么几类:空值数据倾斜、不同数据类型关联产生数据倾斜和Join的数据偏斜。只有理解了Hadoop的原理,熟练使用HQL,就会避免数据倾斜,提高查询效率。

本文转载自 linkedkeeper.com (文/王雷)

关注公众号

关注公众号 低调大师中文资讯倾力打造互联网数据资讯、行业资源、电子商务、移动互联网、网络营销平台。

持续更新报道IT业界、互联网、市场资讯、驱动更新,是最及时权威的产业资讯及硬件资讯报道平台。

转载内容版权归作者及来源网站所有,本站原创内容转载请注明来源。

- 上一篇

SpringBoot之集成Spring AOP

在开始之前,我们先把需要的jar包添加到工程里。新增Maven依赖如下: <dependency> <groupId>org.springframework.boot</groupId> <artifactId>spring-boot-starter-aop</artifactId> </dependency> 接下来,我们进入正题。这里的涉及的通知类型有:前置通知、后置最终通知、后置返回通知、后置异常通知、环绕通知,下面我们就具体的来看一下怎么在SpringBoot中添加这些通知。 首先我们先创建一个Aspect切面类: @Component @Aspect publicclassWebControllerAop{ } 指定切点: //匹配com.zkn.learnspringboot.web.controller包及其子包下的所有类的所有方法 @Pointcut("execution(*com.zkn.learnspringboot.web.controller..*.*(..))") publicvoidex...

- 下一篇

从无到有构建大型电商微服务架构(第一阶段)

本课程将手把手带大家从无到有实现一个真实的大型电商微服务项目,该项目是基于真实的知名互联网企业项目讲解,本课程将分为3个阶段: 第一阶段:会实现电商系统的大部分功能,包括:用户管理,订单管理,商品管理,支付功能,后台管理系统,单点登录,购物车,搜索功能,个人中心等等。 第二阶段:进一步完善系统,深入讲解和优化系统,包括:系统性能优化,分布式事务处理,高并发,高可用,缓存,数据库优化,消息队列的数据完整性、一致性,缓存数据的一致性,大事务的性能优化等等。 第三阶段:引入大数据分析,加入防爬虫功能,采用多语言构建我们的微服务,比如:Python,Go语言等。 该项目按照企业的任务分工模式进行讲解,完全还原企业的开发场景,让大家体验到正式的企业开发流程。每个阶段都是一个进阶,同时每个阶段的代码都是具有极高的商业价值的,大家可以根据自己公司的业务,修改下即可以复用。 课程详情:https://www.roncoo.com/course/view/71d3cec0ab0f48da91bfd7e2cd00ffe0

相关文章

文章评论

共有0条评论来说两句吧...

文章二维码

点击排行

推荐阅读

最新文章

- SpringBoot2全家桶,快速入门学习开发网站教程

- Docker安装Oracle12C,快速搭建Oracle学习环境

- SpringBoot2整合MyBatis,连接MySql数据库做增删改查操作

- Eclipse初始化配置,告别卡顿、闪退、编译时间过长

- MySQL8.0.19开启GTID主从同步CentOS8

- CentOS8,CentOS7,CentOS6编译安装Redis5.0.7

- CentOS7编译安装Cmake3.16.3,解决mysql等软件编译问题

- Springboot2将连接池hikari替换为druid,体验最强大的数据库连接池

- 设置Eclipse缩进为4个空格,增强代码规范

- CentOS7,CentOS8安装Elasticsearch6.8.6

微信收款码

微信收款码 支付宝收款码

支付宝收款码