hadoop入门学习教程--DKHadoop完整安装步骤

使用hadoop版本是DKH标准三节点发行版,DKHadoop版本的易用性比较好,环境部署要简单的多,参考此篇安装前请先下载DKHadoop版本,网盘链接:https://pan.baidu.com/s/1-427Sh6lTLrLAPh6KMOYVg 提取码:vg2w

第一部分:准备工作

1、 大数据平台所需配置:

(1) 系统:CentOS 6.5 64位(需默认安装Desktop)

(2) CPU :intel E3及以上。

(3) 内存:建议最小8G,用图计算建议32G,推荐128G。

(4) 硬盘:256G以上,推荐使用固态硬盘。

(5) 系统分区要求: 如无特殊需求,除swap分区外,可将剩余空间全部分配到/(根)分区

(6) 网络要求:如无特殊情况,尽量可以接入外网。

(7) 至少三台服务器(三台服务器名字任意起,密码须一致)。

(8)安装使用root用户作为默认用户

2、 远程上传和远程连接工具:

(1) 若直接使用个人PC开启的虚拟机作为服务器的基础,直接拷贝到虚拟机下即可。

(2) 若是使用机房服务器作平台搭建的服务器,如若不能直接接触到服务器,则需要使用远程工具连接并发送安装包

第二部分:服务器操作系统配置

1.修改权限

步骤:在准备工作中拷贝安装包DKHPlantform.zip到主节点/root/目录后,解压并修改文件权限(文件所有者可读可写可执行,与文件所有者属于一个用户组的其他用户可读可执行,其他用户组可读可执行)。

命令:

cd /root/

unzip DKHPlantform.zip

chmod -R 755 DKHPlantform

- 搭建hadoop集群设置SSH免密登录

步骤:

修改主机名 vi /etc/sysconfig/network reboot

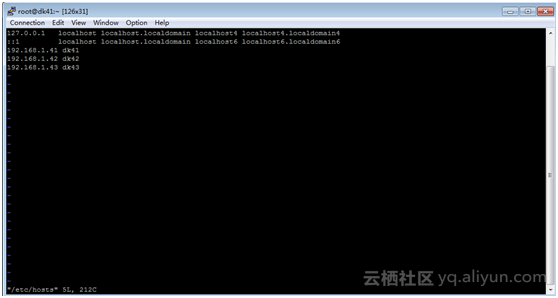

(1)修改本机hosts文件,写入对应关系

命令:

vi /etc/hosts

通过按键盘上的insert或是I键进入编辑模式,编辑完成后按一下Esc键然后按一下按Shift+:键,输入wq 后回车就可以保存。输入q!后回车则是放弃保存并退出.

进入编辑模式后,按照规则写入主机与ip的对应关系(主机名称dk41是自己命名的,如下图)例:

192.168.1.41 dk41

192.168.1.42 dk42

192.168.1.43 dk43

![image image]()

编辑完后,保存退出。把对应关系拷到其他两台机器上。

命令:

scp -r /etc/hosts 192.168.1.42:/etc

scp -r /etc/hosts 192.168.1.43:/etc

(2)执行集群之间免密前的准备工作

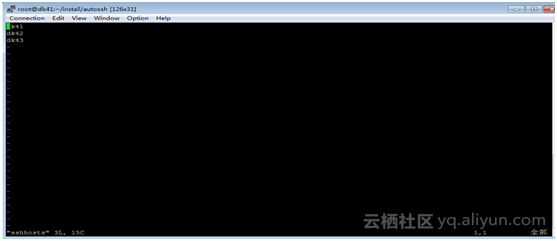

a)执行sshpass.sh的脚本的时候会去读sshhosts和sshslaves这两个文件,

修改文件sshhosts,输入全部机器的主机名,每行一个主机名(如下图)

命令:

vi /root/DKHPlantform/autossh/sshhosts

通过按键盘上的insert或是I键进入编辑模式,编辑完成后按一下Esc键然后按一下按Shift+:键,输入wq,后回车就可以保存。输入q!后回车则是放弃保存并退出.

![image image]()

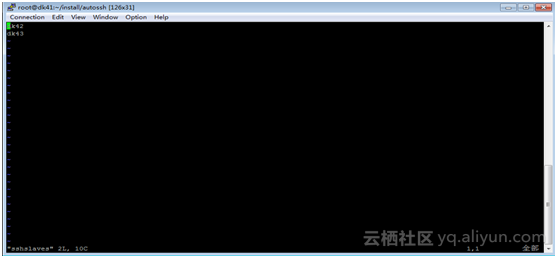

修改文件sshslaves,写入除主机名之外的所有机器名(如下图)

命令:

vi /root/DKHPlantform/autossh/sshslaves

通过按键盘上的insert或是I键进入编辑模式,编辑完成后按一下Esc键然后按一下按Shift+:键,输入wq,后回车就可以保存。输入q!后回车则是放弃保存并退出.

![image image]()

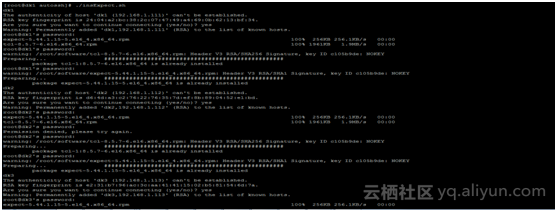

b)执行insExpect.sh,系统会装两个rpm包,在执行sshpass.sh的过程中无需再输密码和yes,脚本自动继续执行。

命令:

cd /root/DKHPlantform/autossh

./insExpect.sh

按照提示多次输入yes和密码(如下图)

![image image]()

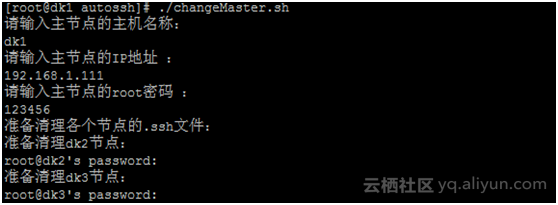

c)执行changeMaster.sh脚本为了清空/root/.ssh目录下的所有文件(在/root/DKHPlantform/autossh目录下),避免在执行sshpass.sh脚本时产生的新密钥时与旧的密钥发生冲突。

命令:

./changeMaster.sh

按照提示输入(如下图)

![image image]()

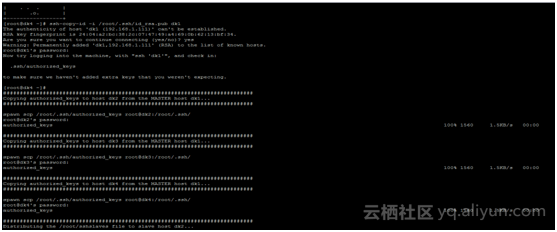

(3)执行集群免密(SSH)

a)执行SSH:

命令:

cd /root/

./sshpass.sh 密码

123456为集群密码,根据自己实际情况输入。

![image image]()

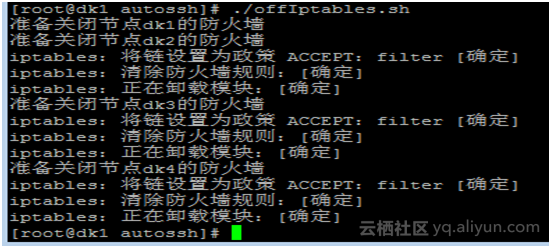

b)防止访问服务器时某些服务被拦截,需关闭防火墙。

命令:

cd /root/DKHPlantform/autossh

./offIptables.sh

![image image]()

3.安装双机热备份的MySQL

目的:存放Hive的元数据

步骤:

(1)从主节点分发mysql安装目录到第二节点

命令:

scp -r /root/DKHPlantform/mysqlInst/ 192.168.1.42:/root/

(2)主节点执行:

命令:

cd /root/DKHPlantform/mysqlInst/

./mysql.sh 1

ssh前往第二台机器(从节点)并执行:

命令:

cd /root/mysqlInst/

./mysql.sh 2

(3)执行成功之后执行热备份(两台机器上都要执行,两个ip互换,41上写42,42上写41,密码是Mysql的密码为:123456。平台内已经设定好,请勿修改):

命令:

source /etc/profile

./sync.sh 192.168.1.xxx(另一台mysql地址) root 123456

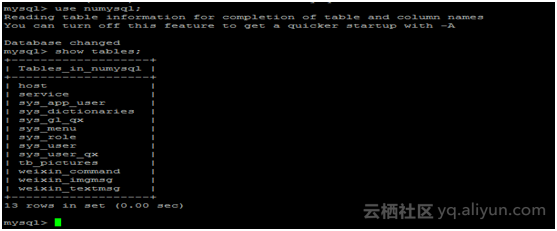

4.创建数据库

步骤:

(1)导入MySQL数据表,只在主节点执行:

命令:

mysql -uroot -p123456 < { 此处为sql文件,主目录下文件: dkh.sql}

如:mysql -uroot -p123456 /DKHPlantform/dkh.sql

(2)执行完后查看一下两台mysql的数据表是否存在,从节点查看执行:

命令:

mysql -uroot -p123456

show databases;

![image image]()

第三部分:DKH系统安装

(1)启动安装

步骤:执行以下命令。

命令:

cd /root/DKHPlantform/dkh-tomcat-7.0.56/bin/

./startup.sh

(2)登录

启动成功后浏览器键入主节点ip

登陆默认用户名和密码:

Username:admin

Password: 123456

后续根据提示安装

(3)组件安装路径

建议采用默认安装路径,即/opt/dkh/,注意千万不要放/root/,不然impala等组件的安装可能出现问题

第四部分:常见问题解决方法

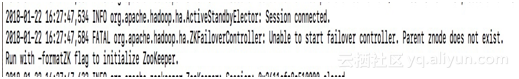

1、当hdfs的zkfc出现如下问题时,可尝试以下方法:

![image image]()

(1) 先格式化hadoopzk:hdfs zkfc -formatZK

(2) 启动zk,sbin下: ./hadoop-daemon.sh start zkfc

(3) 设定失败转移的namenode: hdfs haadmin -failover nn1 nn2

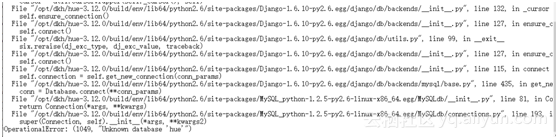

2、当hue页面打不开,显示如下内容时,说明没有创建hue数据库,可在主节点执行此文件,根据提示输入Y即可

![image image]()

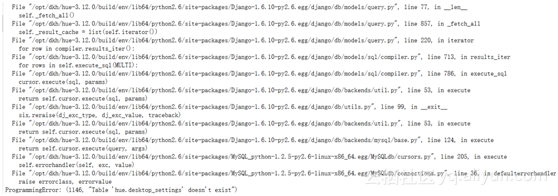

3、当hue页面打不开,显示如下内容时,可执行如下命令解决:

cd /opt/dkh/hue-3.12.0/build/env/bin

./hue syncdb 之后输入no

# ./hue migrate

![image image]()

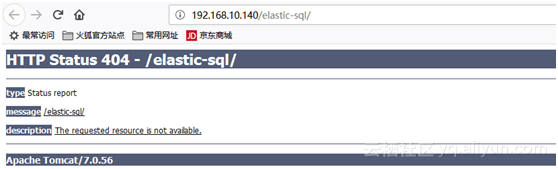

4、Essql页面打不开,显示如下内容时,可通过以下方式解决

(1) 主节点运行命令:source /etc/profile,后重启Tomcat(注意使用shutdown命令之后,若还存在相关进程,需手动kill掉)适用于环境变量不生效的情况,比如,Java的版本识别的是1.7,而不是1.8;hdfs相关命令不识别等。

(2) 重启Tomcat,注意使用shutdown命令之后,若还存在相关进程,需手动kill掉适用于启动了多个Tomcat进程的情况。

![image image]()