今天给大家带来的是开源实时日志分析 ELK , ELK 由 ElasticSearch 、 Logstash 和 Kiabana 三个开源工具组成。官方网站:https://www.elastic.co

其中的3个软件是:

Elasticsearch 是个开源分布式搜索引擎,它的特点有:分布式,零配置,自动发现,索引自动分片,索引副本机制, restful 风格接口,多数据源,自动搜索负载等。

Logstash 是一个完全开源的工具,他可以对你的日志进行收集、分析,并将其存储供以后使用(如,搜索)。

kibana 也是一个开源和免费的工具,他 Kibana 可以为 Logstash 和 ElasticSearch 提供的日志分析友好的 Web 界面,可以帮助您汇总、分析和搜索重要数据日志

| 系统 |

系统需要安装的软件 |

ip |

描述 |

| centos6.4 |

Elasticsearch/test5 |

192.168.48.133 |

搜索存储日志

|

| centos6.4 |

Elasticsearch/test4 |

192.168.48.131 |

搜索存储日志 |

| centos6.4 |

Logstash/nginx/test1 |

192.168.48.129 |

用来收集日志给上面 |

| centos6.4 |

kibana,nginx/test2 |

192.168.48.130 |

用来后端的展示 |

软件下载:链接:链接:http://share.weiyun.com/3b6c27e33cbf4d0acc0ccfa14877bd05 (密码:IWLe)

架构原理图:

![QQ截图20160703200536.png wKiom1d5AXqAuTzcAAEsUfMlZRg070.png]()

一、先安装elasticsearch集群,并测试通过再进行其他软件安装。

在test5,test4上安装分别安装elasticsearch-2.3.3.rpm 前提要安装java1.8 步骤如下:

yum remove java-1.7.0-openjdk

rpm -ivh jdk-8u91-linux-x64.rpm

yum localinstall elasticsearch-2.3.3.rpm

![1.png wKiom1d5AreQvRm2AABF-N1KQ7Y359.png-wh_50]()

![2.png wKioL1d5ArfjNsS5AABiC1OTYMI755.png-wh_50]()

配置elasticsearch 在目录/etc/elasticsearch目录下面 lasticsearch.yml elasticsearch.yml.bak logging.yml scripts

编辑lasticsearch.yml

修改如下配置

cluster.name: myelk #设置集群的名称,在一个集群里面都是这个名称,必须相同

node.name: test5 #设置每一个节点的名,每个节点的名称必须不一样。

path.data: /path/to/data #指定数据的存放位置,线上的机器这个要放到单一的大分区里面。

path.logs: /path/to/logs #日志的目录

bootstrap.mlockall: true #启动最优内存配置,启动就分配了足够的内存,性能会好很多,测试我就不启动了。

network.host: 0.0.0.0 #监听的ip地址,这个表示所有的地址。

http.port: 9200 #监听的端口号

discovery.zen.ping.unicast.hosts: ["192.168.48.133", "192.168.48.131"] #知道集群的ip有那些,没有集群就会出现就一台工作

![3.png wKioL1d5A1KAG-10AACEKG3IMQY803.png-wh_50]()

建立目录

mkdir -pv /pach/to/{data,logs}

chown elasticsearch.elasticsearch /path -R

启动服务器 service elasticsearch start 并查看监控端口启动

![4.png wKiom1d5A6KivnrWAAA-imePEc8427.png-wh_50]()

![5.png wKiom1d5BF3wvR0IAAA0TZwANOQ283.png-wh_50]()

![6.png wKioL1d5BF6CvmahAADLKcncZYw488.png-wh_50]()

访问9200端口查看服务

![7.png wKioL1d5BF6xjSytAAE3NoxMurI940.png-wh_50]()

![8.png wKiom1d5BF-z2kxHAAE1is1xaFU411.png-wh_50]()

两台的配置都一样就是上面的IP和note名称要配置不一样就行

安装插件 head和kopf 之后访问 ip:9200/_plugin/head 和ip:9200/_plugin/kopf (插件可以图形查看elasticsearch的状态和删除创建索引)

/usr/share/elasticsearch/bin/plugin install lmenezes/elasticsearch-kopf

/usr/share/elasticsearch/bin/plugin install mobz/elasticsearch-head

![9.png wKiom1d5BLyhs7XeAACCGXzXAZc574.png-wh_50]()

![10.png wKioL1d5BLyg4s26AAFrmeN1SbA352.png-wh_50]()

![11.png wKiom1d5BL3R6qRlAAFp6dknXNY058.png-wh_50]()

二、安装nginx和logstash软件

在test1上安装好nginx服务 就是收集它的日志呢

yum -y install zlib zlib-devel openssl openssl--devel pcre pcre-devel

./configure --prefix=/usr/local/nginx --with-pcre --with-openssl= --with-zlib=

make && make install

日志在/usr/local/nginx/logs/access.log

然后在test1上安装logstash-2.3.3-1.noarch.rpm

yum remove java-1.7.0-openjdk

rpm -ivh jdk-8u91-linux-x64.rpm

rpm -ivh logstash-2.3.3-1.noarch.rpm

/etc/init.d/logstash start #启动服务

/opt/logstash/bin/logstash -e "input {stdin{}} output{stdout{ codec=>"rubydebug"}}" #检测环境 执行这个命令检测环境正常否,启动完成后 直接输入东西就会出现

![12.png wKioL1d5BajS6S5tAABneX_m-M0291.png-wh_50]()

之后输入 /opt/logstash/bin/logstash -e 'input {stdin{}} output{ elasticsearch { hosts => ["192.168.48.131:9200"] index => "test"}}'

就是输入东西到48.131的elasticsearch上 会在/path/to/data/myelk/nodes/0/indices 生成你名称test索引文件目录 可以多输入几个到48.131的目录看看有没有文件有就证明正常。

![13.png wKioL1d5BjPwjLQRAAAddl9KTEQ287.png-wh_50]()

![14.png wKiom1d5BjORMNW-AAAVxKe_0EM466.png-wh_50]()

![15.png wKioL1d5BjSgTZ2VAAAV0iM9yI4897.png-wh_50]()

之后在/etc/logstash/conf.d 建立以.conf结尾的配置文件,我收集nginx就叫nginx.conf了内容如下;

###########################################################################################

input {

file {

type => "accesslog"

path => "/usr/local/nginx/logs/access.log" #日志的位置

start_position => "beginning" #日志收集文件,默认end

}

}

output {

if [type] == "accesslog" {

elasticsearch {

hosts => ["192.168.0.87"] ###elasticearch的地址

index => "nginx-access-%{+YYYY.MM.dd}" #生成的索引和刚才的test一样会在那里生成后面的是日期变量。

}

}

}

##########################################################################################

一定要仔细,之后运行/etc/init.d/logstash configtest检测配置是否正常。

![16.png wKioL1d5CDHzIFiBAAA-bzvYR80064.png-wh_50]()

![17.png wKiom1d5CDHySQSLAAAN5qgS2IU859.png-wh_50]()

查看进程是否启动

![18.png wKiom1d5CDGhHjOBAABabA53lQQ857.png-wh_50]()

之后在elasticearch查看有没有索引生成。多访问下nginx服务

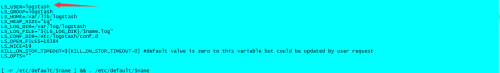

如果没有就修改这个文件

vi /etc/init.d/logstash

######################################################################################################

LS_USER=root ###把这里换成root或者把访问的日志加个权限可以让logstash可以读取它 重启服务就会生成索引了

LS_GROUP=root

LS_HOME=/var/lib/logstash

LS_HEAP_SIZE="1g"

LS_LOG_DIR=/var/log/logstash

LS_LOG_FILE="${LS_LOG_DIR}/$name.log"

LS_CONF_DIR=/etc/logstash/conf.d

LS_OPEN_FILES=16384

LS_NICE=19

KILL_ON_STOP_TIMEOUT=${KILL_ON_STOP_TIMEOUT-0} #default value is zero to this variable but could be updated by user request

LS_OPTS=""

#######################################################################################################

![19.png wKioL1d5CQigfEsqAAA7WwH9gJ4848.png-wh_50]()

看logstash的日志有下面的信息就成功了

![20.png wKioL1d5CQjhZoJqAAAMRQWxsjk426.png-wh_50]()

三、安装kibana软件

上面的都安装完成后在test2上面安装kibana

rpm -ivh kibana-4.5.1-1.x86_64.rpm

编辑配置文件在这里/opt/kibana/config/kibana.yml 就修改下面几项就行

#######################################################################################################

server.port: 5601 端口

server.host: "0.0.0.0" 监听

elasticsearch.url: "http://192.168.48.131:9200" elasticsearch地址

######################################################################################################

![21.png wKioL1d5CqvB80nIAAClAFJ33mQ577.png-wh_50]()

/etc/init.d/kibana start 启动服务

访问kibana http://ip:5601

![21.png wKiom1d5CtjDPlmsAAClAFJ33mQ778.png-wh_50]()

添加展示的索引,就是在上面定义的 nginx-access-2016.07.03

![22.png wKioL1d5CtjgxjrgAAGklcyZE0A421.png-wh_50]()

![23.png wKiom1d5CtmRVDaQAACpUUHChNY947.png-wh_50]()

![24.png wKioL1d5CtmQo1A4AAF25JZ5zhQ862.png-wh_50]()

四、其他的一些配置。

kibana是直接访问的比较不安全,我们需要用nginx访问代理,并设置权限用户名和密码访问

先在kibana服务器上安装nginx 不介绍了

在nginx里面配置

#################################################################################

server

{

listen 80;

server_name localhost;

auth_basic "Restricted Access";

auth_basic_user_file /usr/local/nginx/conf/htpasswd.users; #密码和用户

location / {

proxy_pass http://localhost:5601; #代理kibana的5601之后就可以直接80访问了

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header REMOTE-HOST $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

}

}

####################################################################################

创建密码和用户文件:htpasswd.users

需要安装httpd-tool包先安装它

htpasswd -bc /usr/local/nginx/conf/htpasswd.users admin paswdadmin #前面是用户后面是密码

##################################################################################

![26.png wKiom1d5DHbwMWcBAAAUEbMe2rI094.png-wh_50]()

之后通过访问需要密码和用户并且是80端口了

![25.png wKiom1d5DJfyqTP2AAGNj-enHvA081.png-wh_50]()

到这里就完成了,谢谢你的阅读。