大家好,我是陈哥,今天想和大家聊聊多巴胺的话题~

每当我们遇到新奇、刺激或愉悦的体验时,多巴胺水平会飙升,激发我们追求更多。但这种追求并不总是指向对我们有益的事物。我第一次了解到“多巴胺熔断”这个词,正好是半夜刷短视频的时候。

我自认为是一个相当自律的人,但还是会耗费大量的时间在刷短视频上面。正如尼尔·波兹曼的《娱乐至死》中写道:“人类悄无声息地成为娱乐的附庸,毫无怨言,甚至心甘情愿,其结果是,我们成了一个娱乐至死的物种。”

这件事情让我开始思考多巴胺对我的影响。

一、 算法时代的“甜蜜陷阱”

我们身处算法时代,各种产品和服务都在巧妙地利用我们的心理弱点,让我们陷入成瘾的困境。回忆一下,当我们准备开始一天的工作时,还是忍不住看手机去关注各类信息。

很多人以为这是自制力不足的结果,如果自制力强,会出现这种情况吗?前谷歌产品经理崔斯坦.哈里斯的一句实话点明了真相:“一个人的上瘾背后,是上千个人努力工作、想方设法让你上瘾。” 实际上,这背后是一个庞大的“成瘾产业链”。

斯坦福大学教授尼尔·艾亚尔在其关于成瘾的研究中,提到了经典的上瘾模型。

![]()

首先是“触发”阶段,那些手机上的消息通知、社交媒体的更新提示,就像一个个诱饵,吸引我们的注意力,促使我们采取行动。

接着是“行动”阶段,当我们点击进入内容后,会得到各种反馈和奖励,比如社交媒体的点赞、游戏中的装备升级等。而商家为了让我们更快地成瘾,还会采用不定期、不定量、不可预测的奖励方式,再结合对我们的精准了解,让我们在这个“陷阱”中越陷越深。

最后,当我们在这些产品中投入了大量的时间、精力和金钱后,就会形成一种难以割舍的依赖,进一步强化了成瘾的循环。

在这个时代,我们几乎每天都在与这些“甜蜜陷阱”作斗争,而且陷阱的形式多种多样,防不胜防。

二、 从多巴胺到内啡肽:追求更深层次的满足

什么是内啡肽?

与多巴胺不同,内啡肽通常是在我们经历挑战、克服困难或者完成长期目标之后才会释放。这种快乐不是瞬间的、表面的,而是深沉的、持久的。它是我们通过自身的努力和坚持所获得的回报,因此能够给我们是一种更加真实和满足的感觉。

当我们能够忍住眼前的诱惑,为了一个长远的目标而努力奋斗时,我们就更有可能获得内啡肽带来的快乐。有人为了职业发展而不断提升自己,这些都是通过自身努力来获取内啡肽的例子。这种通过长期付出所获得的满足感,远远超过了多巴胺带来的短暂欢愉。

![]()

三、 如何激发内啡肽,获得自我提升

在当前的经济环境下,我们面临着各种各样的挑战。因此,我们更应该激发内啡肽,实现自我提升,而不是简单地沉溺在多巴胺带来的短暂愉悦。

延迟满足就是激发内啡肽的关键因素。延迟满足并不是不满足,而是为了完成具有挑战的目标而放弃短暂、且意义不大的享乐。

通过锻炼身体、制定并努力达成目标、学习新技能、全神贯注地投入阅读或工作等方式,让自己不断产生成就感和动力,从而促进内啡肽的自然释放,形成正循环。这样的快乐能量会更持久、更健康的。

正如亚里士多德说:“在追求快乐上,和动物相比,人追求的快乐应该更高级和伟大。”

利用延迟满足来激发内啡肽,这是一件长期主义的事情。根据爱德华·戴奇和理查德·瑞安的自决理论:内在动机是行为改变的关键。我们只有有明确的目标,才能驱动自己持续行动,积累正向反馈,从而实现自我提升。

任何成就都需要渐进和持续的投入。刚开始时,这些努力可能比较微小,但随着它们不断积累,就会带来不一样的改正,正所谓“不积跬步无以至千里”。因此,我们不要想短暂的努力就能获得满意的效果,不要急于一时。

这让我想到了在“读书有什么意义”的问题下,看到有人这样回答:

读书,就像吃饭一样,吃过的都消化了,但是它变成了你的血和肉。读过的书,也许也会忘掉,但是它潜移默化地影响了你的思维方式和对世界的认知。

四、远离多巴胺不是受苦

我所提倡的远离多巴胺并不是受苦,而是为了更好地为自己赋能。我们真正的好状态,应该是在“内啡肽”的激励下,走出舒适区,获得成长、获得自由。

所以,当我们的事业、生活、健康有了更高的目标和规划,并为之宁愿放弃短暂的快乐,而不断努力时,这种快乐会让你在自我追求和成长中,持续获得成就带来的幸福感。

限时福利赠送

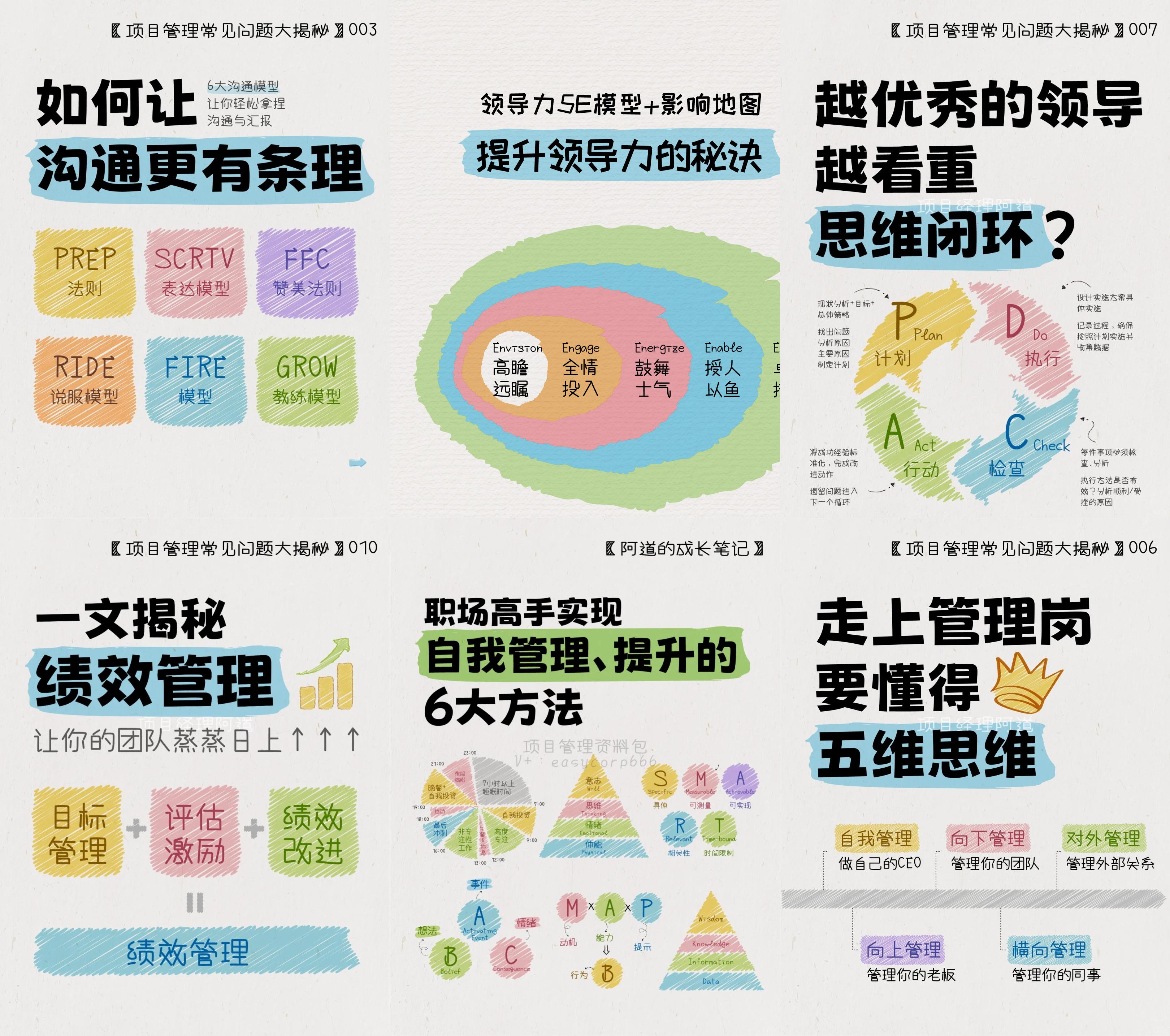

如果你目前正在陷入职场困境,想进一步提升自己的职场能力,我已经将提升职场能力的方法和技巧都整理成资料包,免费分享给大家。

![]()