大家好,我们整理了近期 RWKV 生态中新增的一些多模态工作,包含:RWKV-SAM(图像分割模型)、RWKV-CLIP(视觉语言表示学习)、point-RWKV(3D 点云学习框架)……

RWKV-SAM

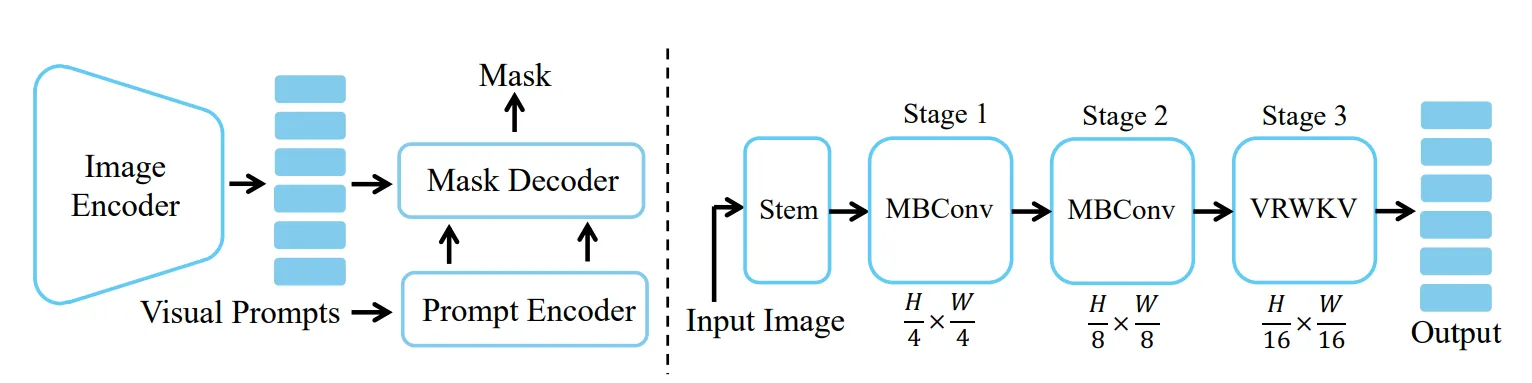

论文设计了基于 RWKV 的图像分段切割方法“RWKV-SAM”(Segment Anything Model)。

下图为 RWKV-SAM 架构:

![]()

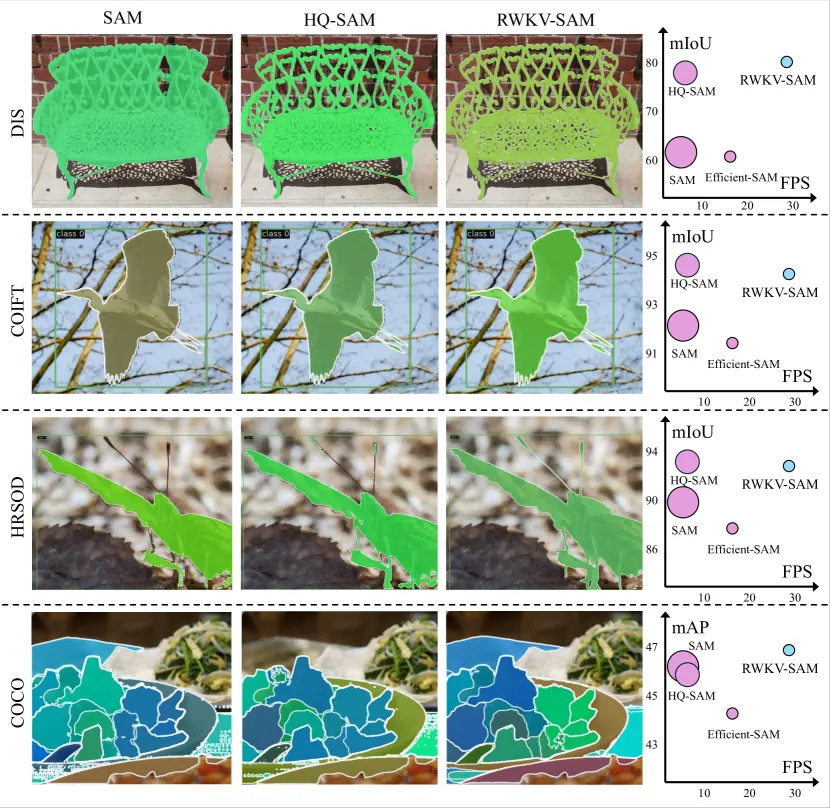

与 Transformer 模型相比,RWKV-SAM 实现了 2 倍以上的加速,且可以在各种数据集上实现更好的图像分割性能。

此外,RWKV-SAM 的分类和语义分割结果优于最新的视觉 Mamba 模型。

![]()

RWKV-CLIP

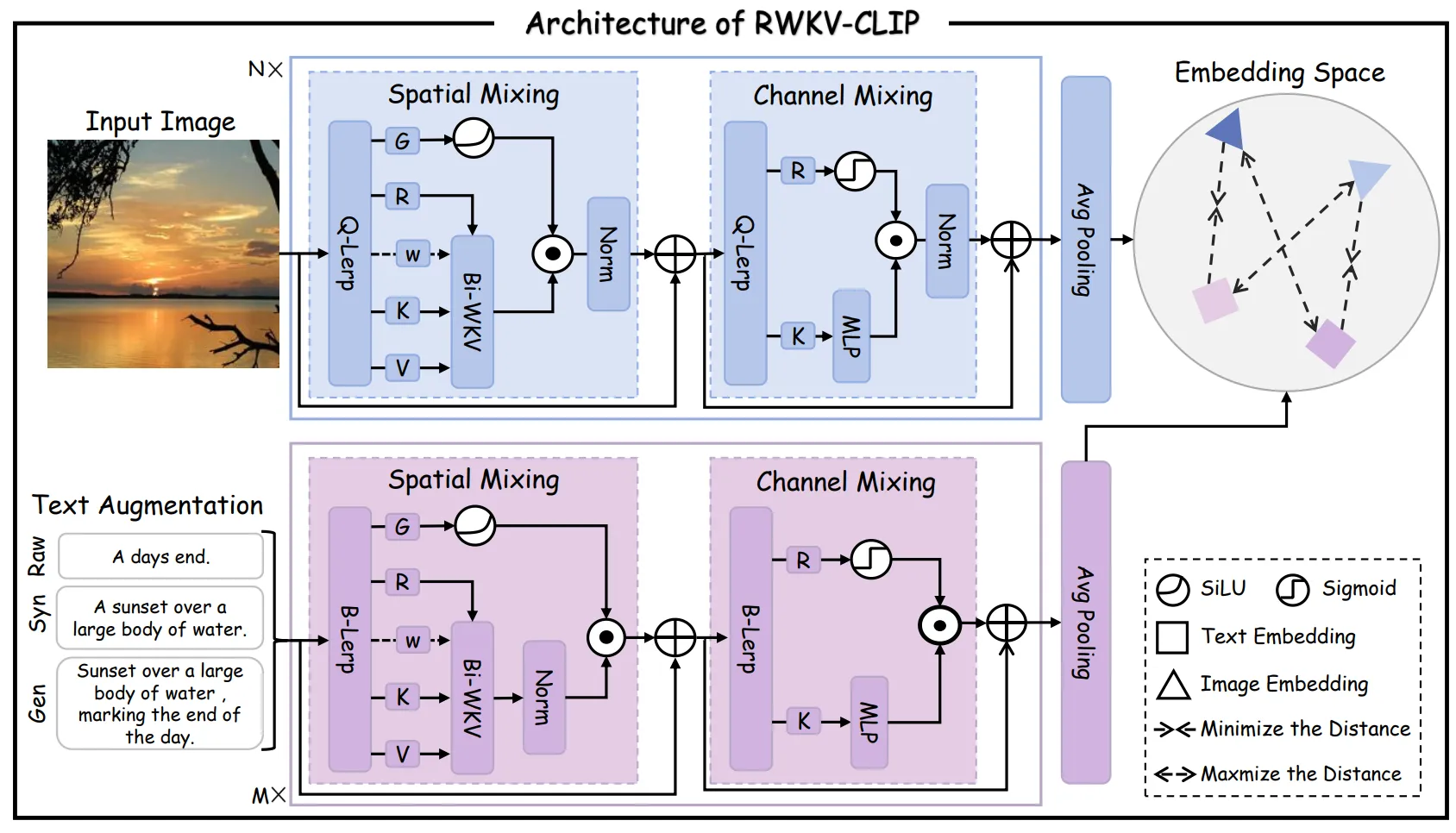

RWKV-CLIP (Contrastive Language-Image Pre-training)是一个 RWKV 驱动的视觉语言表示学习模型,该框架可以利用大型语言模型(LLMs)来合成和细化基于网络的文本、合成标题和检测标签的内容。

RWKV-CLIP 架构如图:

![]()

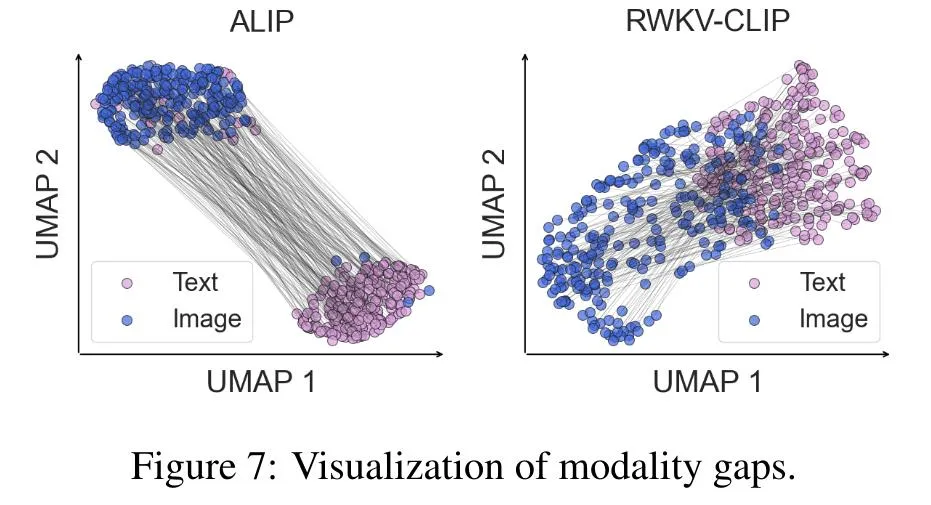

论文结果显示:与 ALIP 相比,RWKV-CLIP 在图像文本模态空间中表现出更近的距离,表明具有卓越的跨模态对齐性能。

![]()

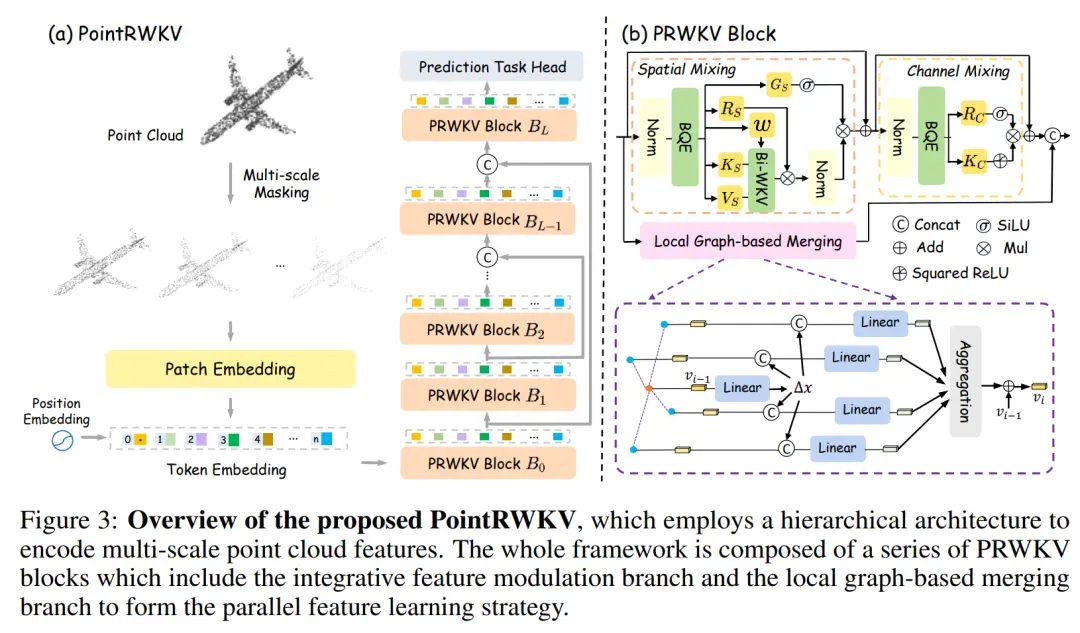

PointRWKV

PointRWKV 项目是一种基于 RWKV 的 3D 点云学习框架,在下游点云任务上性能优于基于 Transformer 和 Mamba 的同类工作,显著节省了约 46% 的 FLOPS。

下图为 PointRWKV 架构:

![]()

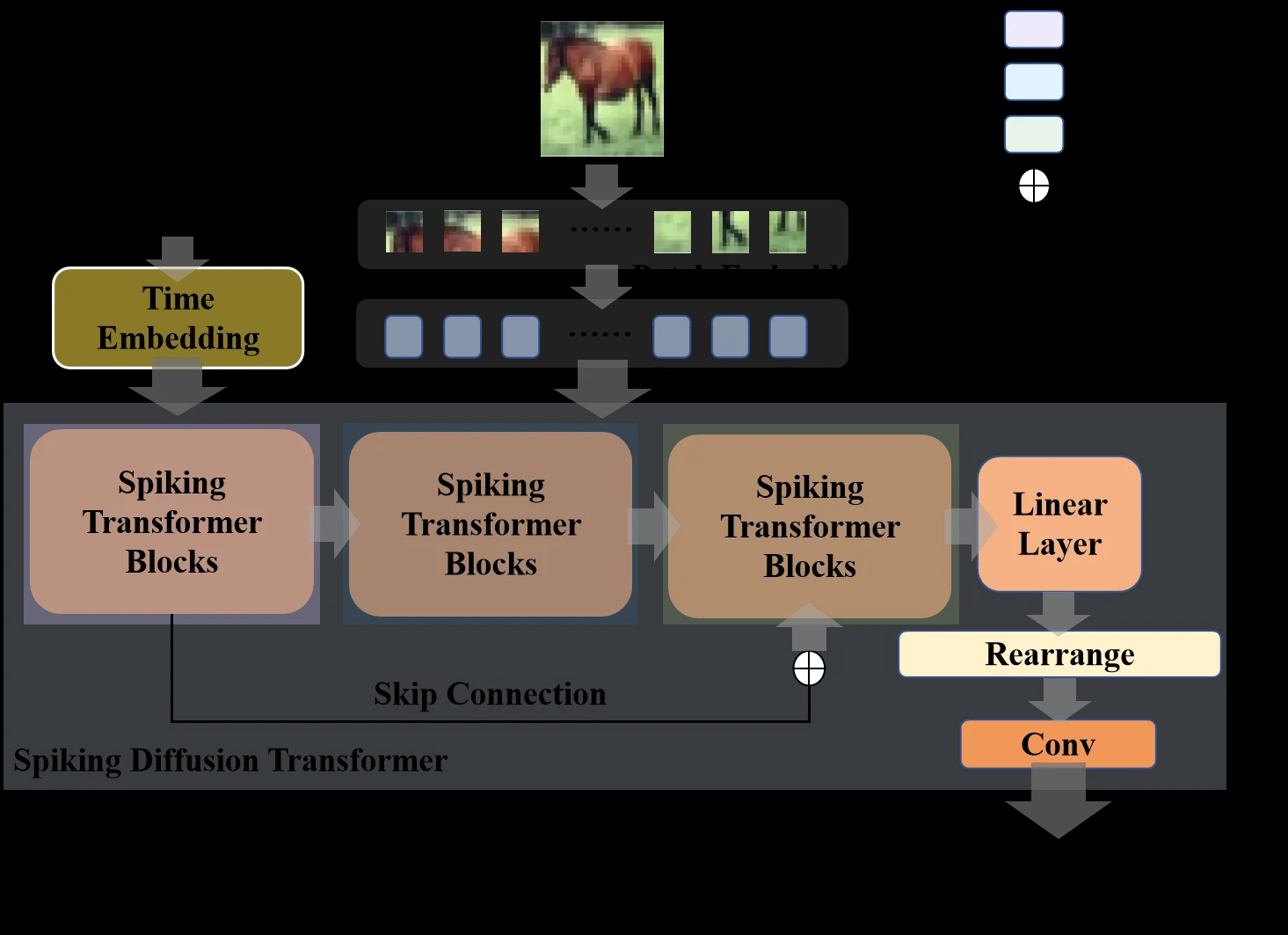

SDiT

论文提出了 Spiking Diffusion Transformer (SDiT - 基于 Transformer 的新型 SNN 扩散模型架构),但采用 RWKV 作为 Transformer 自注意力机制的替代。

通过将 RWKV 有效地与 SNN 集成,SDiT 方法提高了重建图像的质量。

![]()

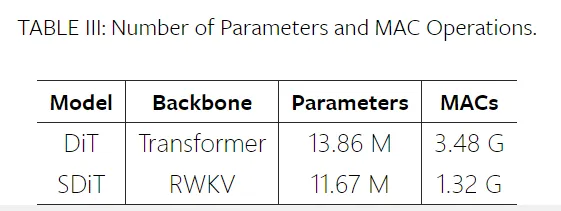

和基于 Transformer 的 ANN 实现 (DiT) 相比,基于 RWKV 的 SDiT 方法拥有更小的参数和更低的乘法累加 (MAC) ,充分展示了低功耗 SNN 的优势。

![]()

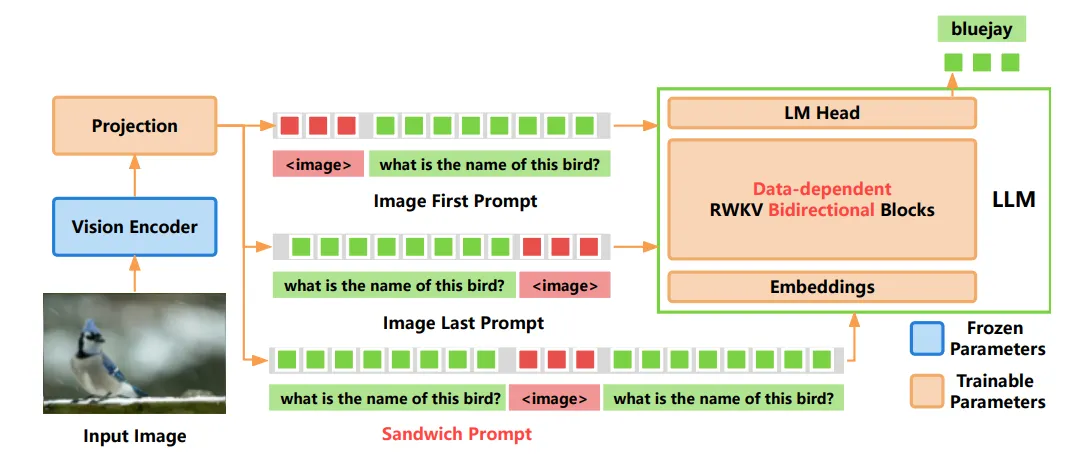

VisualRWKV-6

VisualRWKV 是 RWKV 语言模型的视觉增强版本,使 RWKV 模型能够处理各种视觉任务。

VisualRWKV-6 的架构设计是 Data-dependent Recurrence + Sandwich Prompt + Bidirectional Scanning 。

![]()

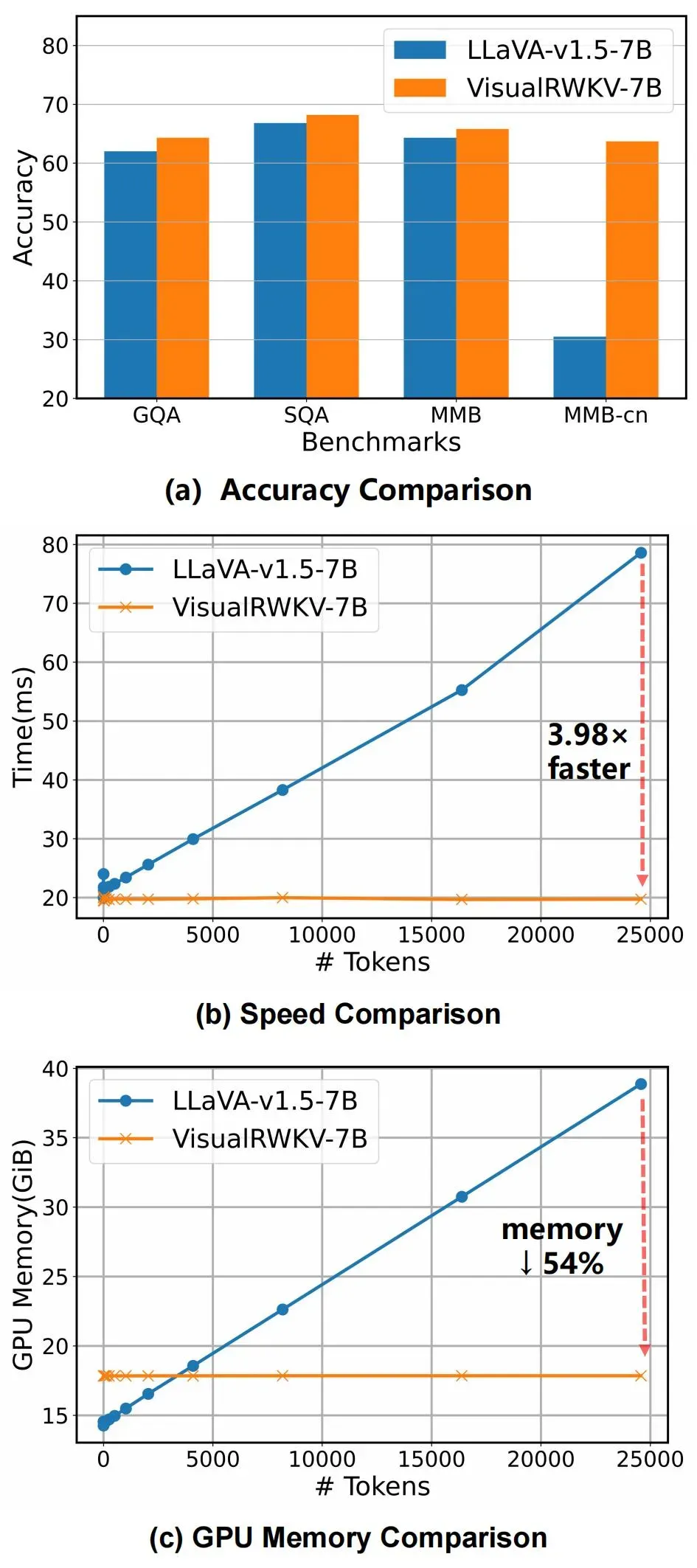

大量实验表明,与基于 Transformer 的模型(如 LLaVA-1.5)相比,VisualRWKV 在各种基准测试中实现了具有竞争力的性能。

![]()

以上是近期的 RWKV 多模态研究。更早之前的 RWKV 多模态工作,请参考我们的第一期统计:

欢迎大家使用 RWKV 进行创业、科研,我们也会为基于 RWKV 的项目提供技术支持。

如果您的团队正在基于 RWKV 创业或开展研究,请联系我们!(在“RWKV元始智能”微信公众号留言您的联系方式,或发送邮件到“contact@rwkvos.com”。)