众所周知,目前大模型的基准测试很容易受到各种因素的影响,比如在训练中偷跑测试集之类。

GitHub 开发者 Jellyfish042 则认为,用“实时的、新鲜的数据”去测试大模型,可能是一种更公平的模型测评解决方案。因此,他提出了一种名为 Uncheatable Eval(不可作弊的模型评测) 的新型模型评估测试。

Uncheatable Eval 会使用最新的 arXiv 论文和新闻文章等实时语料库,以此来评估语言模型的真实建模能力和泛化能力。

仓库地址:https://github.com/Jellyfish042/uncheatable_eval

最新测试结果

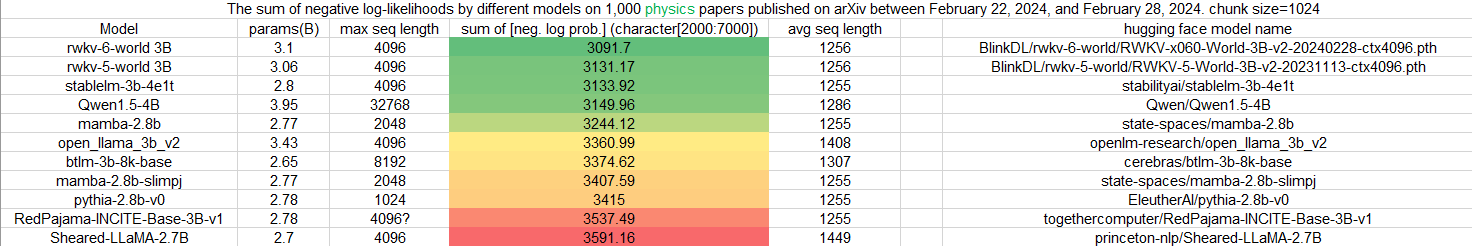

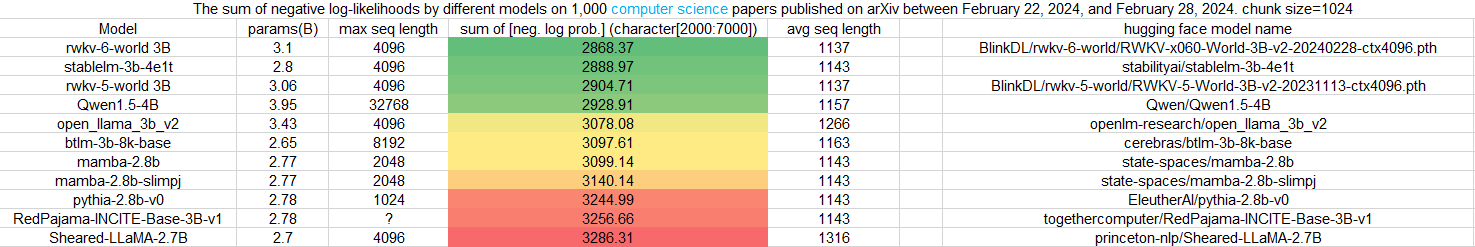

在最新一期针对 3B 参数规模模型的 Uncheatable Eval 基准测试中,我们很开心地看到:在最新的 arXiv 论文测评中(无论是物理还是计算机科学方向),RWKV 模型最新的第六代架构 “RWKV-6” 的表现都非常好,在基准测试中博得头筹。

前一代架构 “RWKV-5”亦不遑多让,名列前茅。

![]()

图:使用物理方向 arXiv 论文进行 Uncheatable Eval 测试

![]()

图:使用计算机科学方向 arXiv 论文进行 Uncheatable Eval 测试

![]()

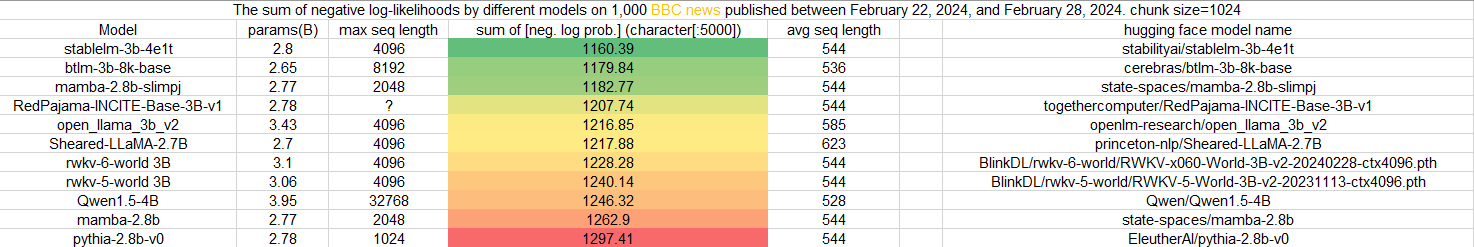

图:使用 BBC 新闻进行 Uncheatable Eval 测试

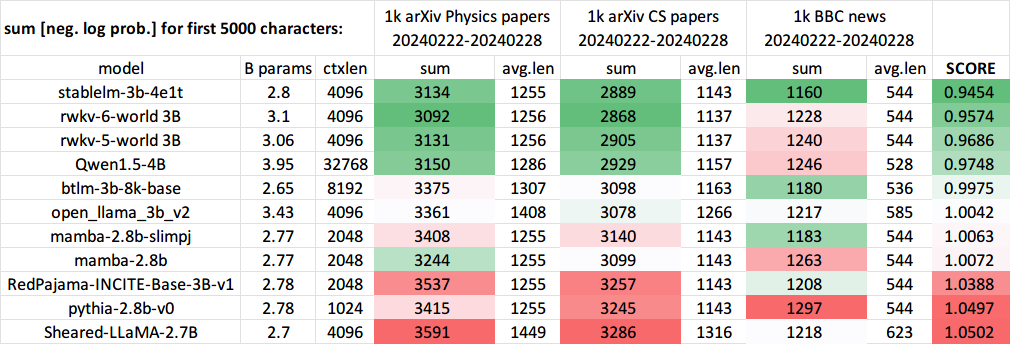

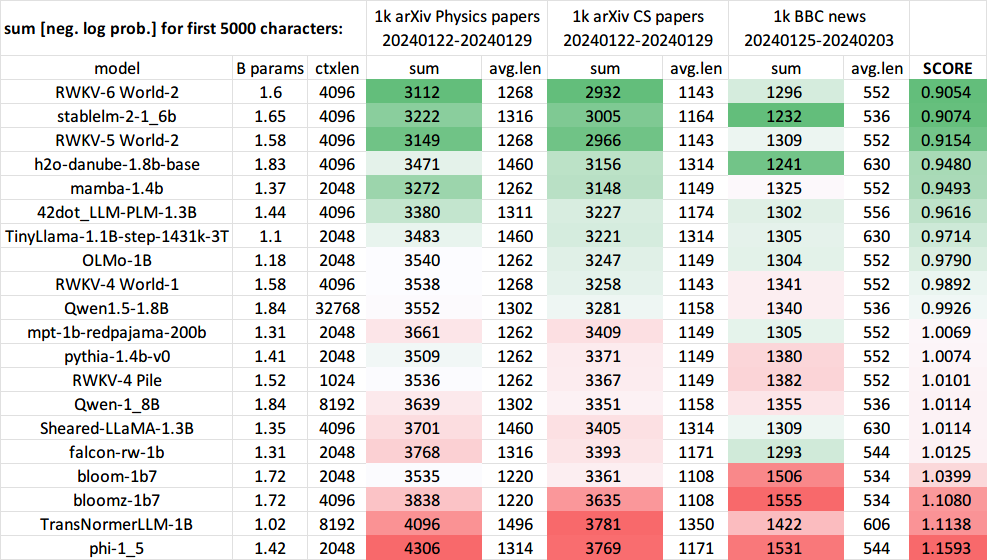

在 3B 参数模型的三项 Uncheatable Eval 测试中,RWKV-6 和 RWKV-5 的综合得分闯入三甲,综合得分第一为 stablelm-3b-4e1t。

![]()

图:3B 模型在 Uncheatable Eval 测试的综合得分

补充说明:相比 stablelm-3b-4e1t 炼的 4T 令牌的语料(1T 语料炼 4 遍),参与评测的 RWKV 模型只炼了 1.1 T 令牌的语料。

往期测试结果

下面是一些旧的测试结果,与最新的 Uncheatable Eval 代码相比,下图使用的测试方法略有不同。

1. 往期测试:(1.5B 参数模型)

![]()

图:使用物理方向 arXiv 论文进行 Uncheatable Eval 测试

![]()

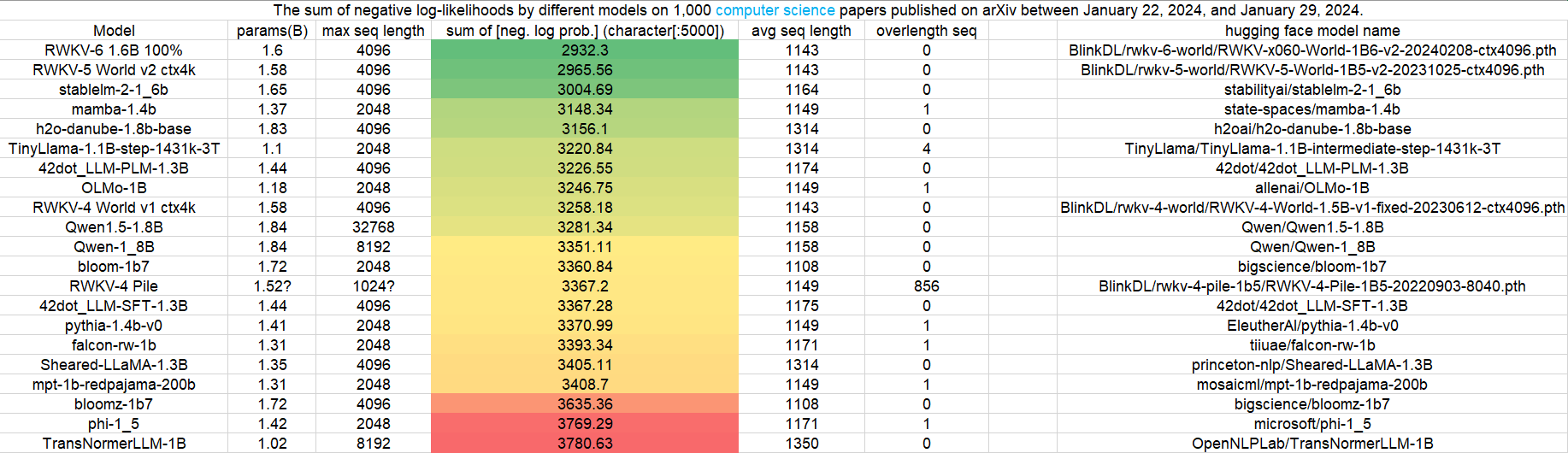

图:使用计算机科学方向 arXiv 论文进行 Uncheatable Eval 测试

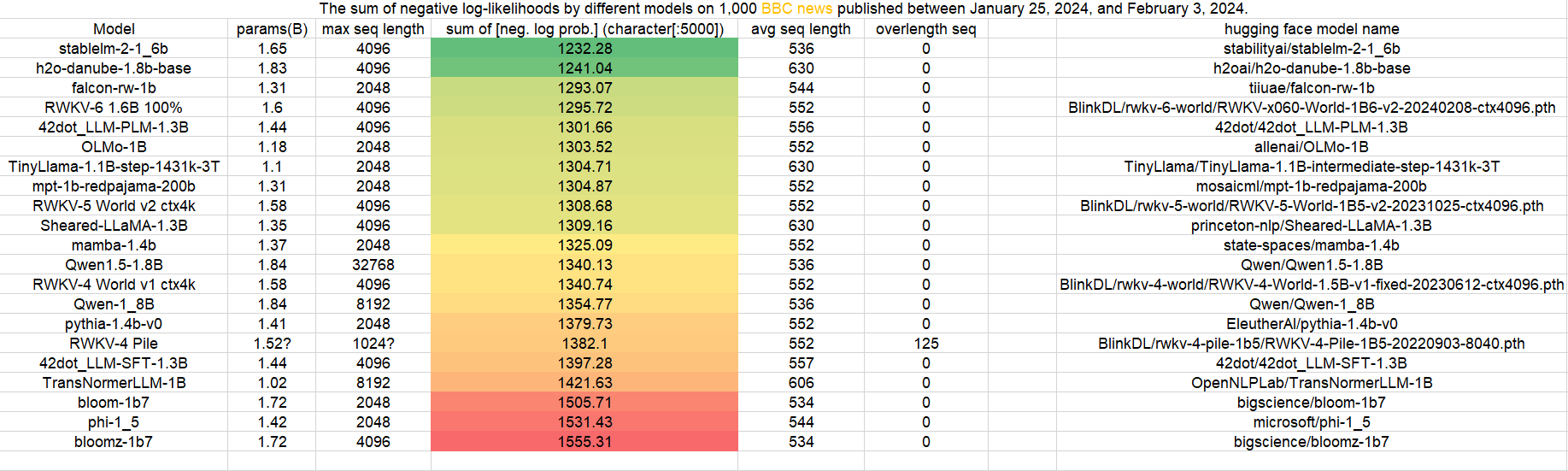

![]()

图:使用 BBC 新闻进行 Uncheatable Eval 测试

![]()

图:1.5B 模型在 Uncheatable Eval 测试的综合得分

在 1~2B 参数模型的 Uncheatable Eval 测试中,RWKV-6 1.6B 模型的综合得分排名第一。

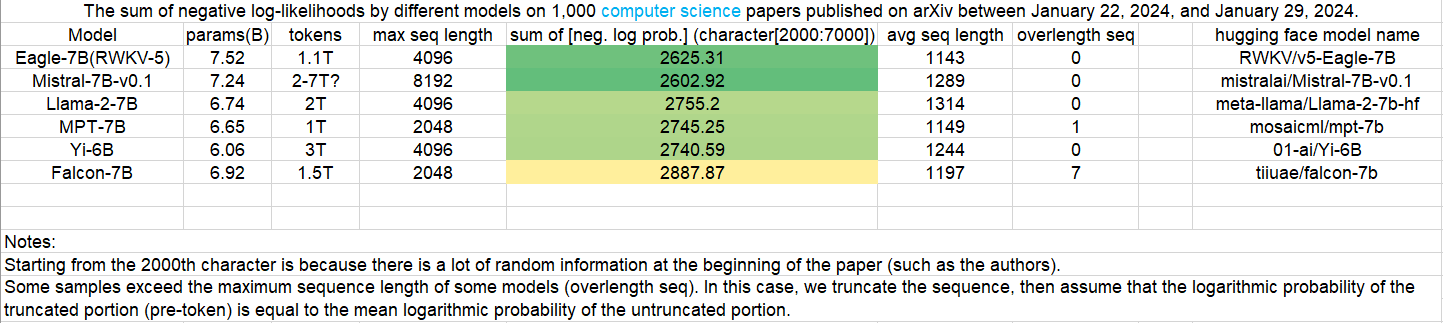

2.往期测试:(7B 模型)

![]()

图:使用计算机科学方向 arXiv 论文进行 Uncheatable Eval 测试

![]()

图:使用物理方向 arXiv 论文进行 Uncheatable Eval 测试

可以看到,在往期的测试结果中,无论是 1.5B 还是 7B 参数规模, RWKV 模型都保持着非常优秀的表现。

相关链接

Uncheatable Eval 仓库地址:https://github.com/Jellyfish042/uncheatable_eval

RWKV 模型介绍

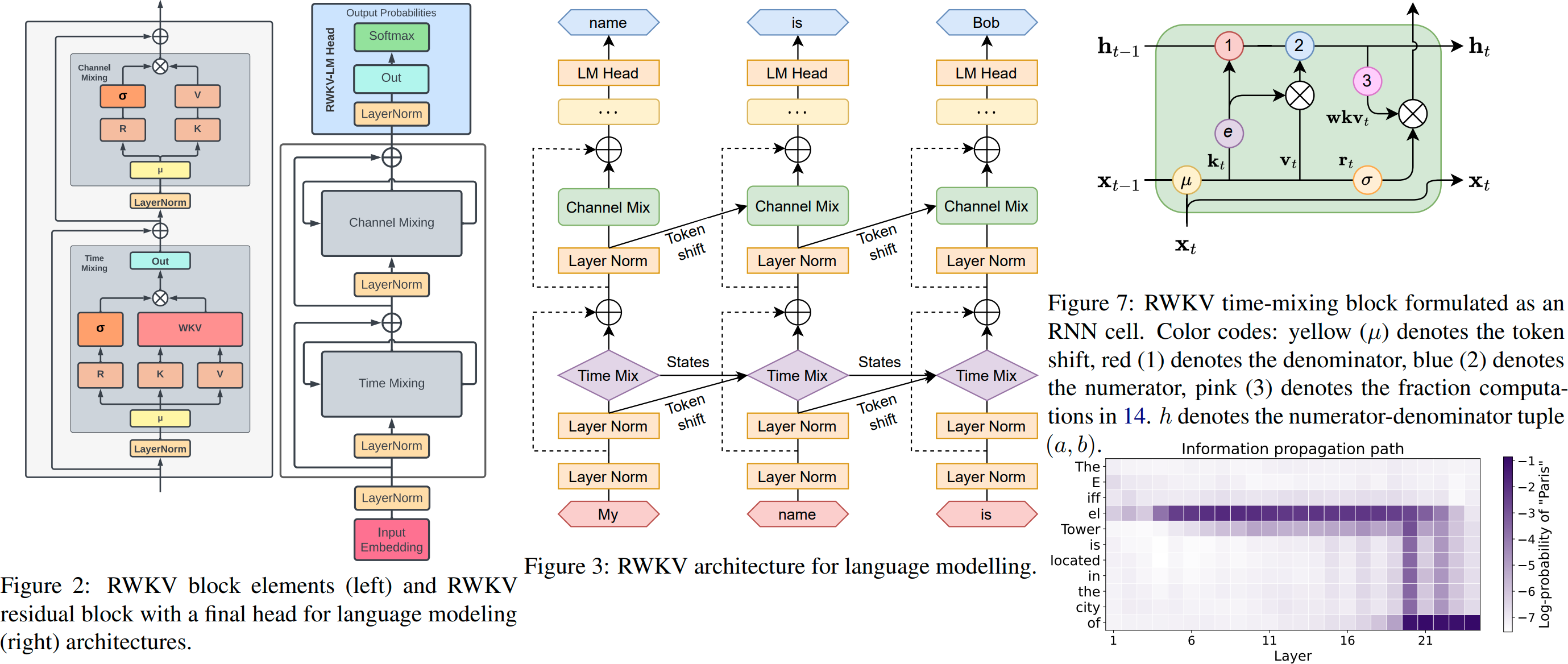

RWKV 是一种创新的深度学习网络架构,它将 Transformer 与 RNN 各自的优点相结合,同时实现高度并行化训练与高效推理,时间复杂度为线性复杂度,在长序列推理场景下具有优于 Transformer 的性能潜力。

![]()

图:RWKV 架构

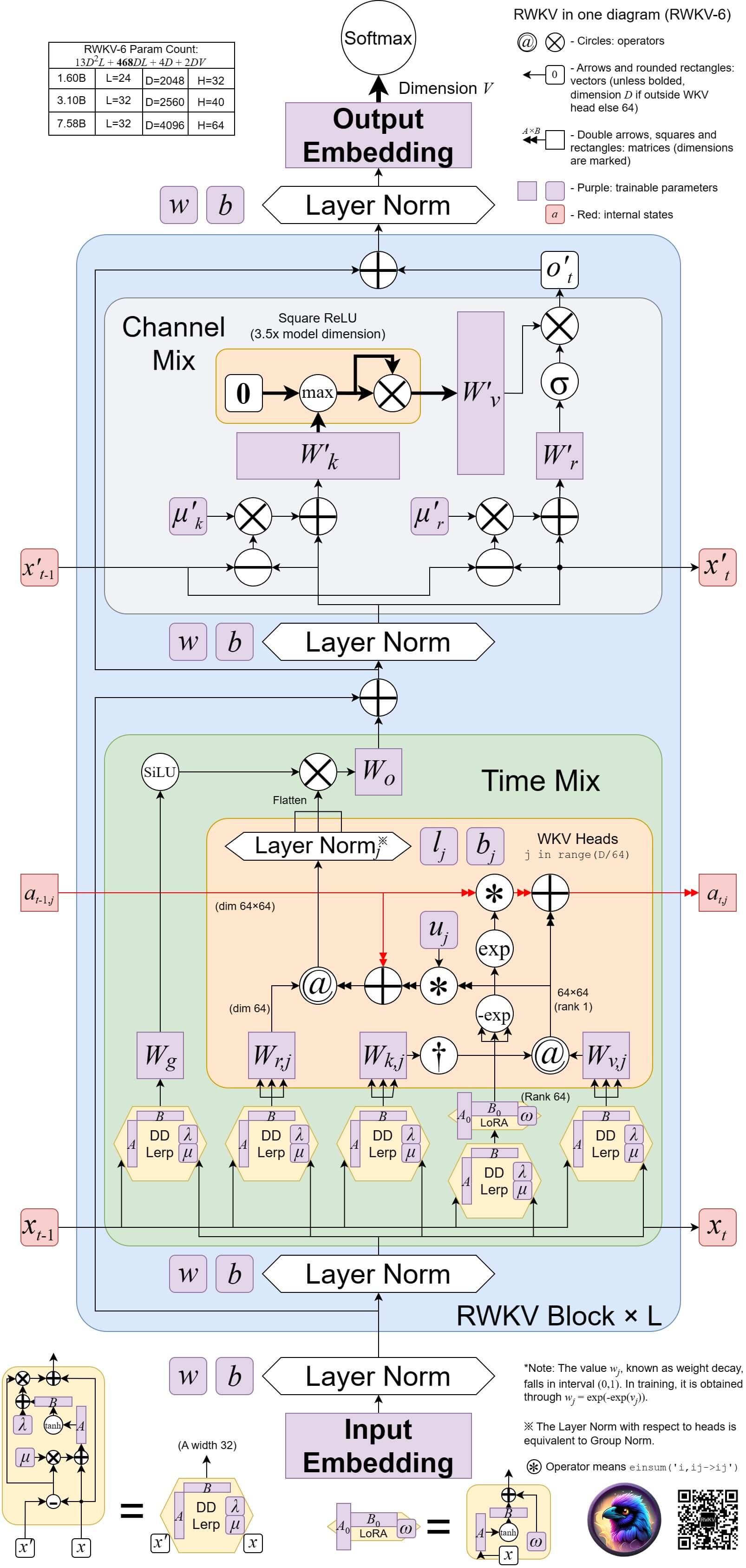

RWKV 模型的最新版本是 RWKV-6 ,架构图如下:

![]()

图:RWKV-6 架构

相对 Transformer 架构,RWKV 架构的推理成本降低 2~10 倍,训练成本降低 2~3 倍。

RWKV 模型最初由彭博设计,主要算力由 Stability AI 和 EleutherAI 等机构捐赠。如今,RWKV 已捐赠给 Linux Foundation AI&Data 作为孵化项目。

加入 RWKV 社区