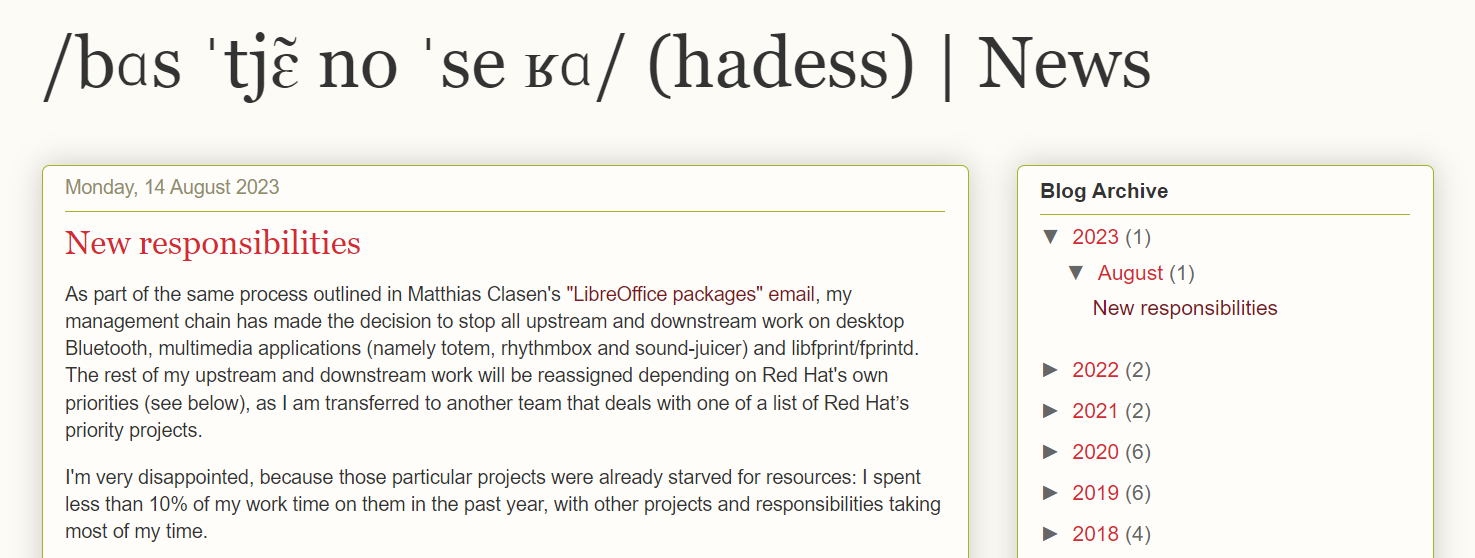

红帽高级开发人员 Bastien Nocera 新发布的一篇“New responsibilities”博文指出,该公司正在进一步整合在桌面 Linux 上的开发工作。

作为 Matthias Clasen 的"LibreOffice packages"电子邮件中概述的同一流程的一部分,我的管理链已决定停止桌面蓝牙、多媒体应用程序(即 totem、rhythmbox 和 sound-juicer)和 libfprint/fprintd 的所有上游和下游工作。我的其他上下游工作将根据红帽公司自己的优先事项重新分配(见下文),因为我将被调到另一个团队,处理红帽公司优先项目列表中的一个项目。

![]()

今年 6 月份,红帽宣布决定停止在 Red Hat Enterprise Linux (RHEL) 提供打包为 RPM 格式的 LibreOffice;调整后的工作重点将集中到改进 Wayland 显示服务器、支持 HDR、感色灵敏相关,以及改进 Fedora 和 RHEL 用户的工作站体验的一些工作。

在此之前,该公司还解雇了 Fedora 项目负责人 Ben Cotton。Nocera 虽然没有被解雇,但如今也被调离,“我非常失望,因为这些项目本来就资源匮乏:在过去的一年里,我花在这些项目上的时间不到我工作时间的 10%,其他项目和职责占用了我大部分时间。”

Nocera 的离开意味着一些项目的开发工作势必受到影响。以下这些 GNOME 项目在中期内都将没有 Maintainer、Reviewer 或者 Triager:

- gnome-bluetooth (包括 Settings panel 和 gnome-shell integration)

- totem, totem-pl-parser, gom

- libgnome-volume-control

- libgudev

- geocode-glib

- gvfs AFC backend

以及这些 freedesktop 项目将被存档,直至另行通知:

- power-profiles-daemon

- switcheroo-control

- iio-sensor-proxy

- low-memory-monitor

此后,Nocera 将无法审查 libfprint/fprintd、upower、grilo/grilo-plugins、gnome-desktop thumbnailer 沙箱补丁或任何与 XDG 规范相关的工作。内核工作、审查和维护,包括最近有关 SteelSeries headset 和 Logitech 设备内核驱动程序的工作、Flatpak Portal 支持的 USB revoke 或 core USB 的工作都将暂停,直至另行通知。

Nocera 称,他所有的 Fedora 软件包都在一个半月前变成了孤岛 (orphaned) 状态;RHEL 软件包大约在三周前被取消分配,之后又被重新分配,所以其无法找到新的维护者。

“如果你是将承担全部或部分 90% 未停止工作的同事,或者是依赖我的工作来进一步推进自己项目的社区成员,请与我联系,如果时间允许,我会尽力满足你的询问。如果上述情况有任何变化,我会尽量确保更新本帖,或创建一个新帖。”